Optimizaciones de software AMD para inferencia de IA

Compatibilidad del marco: AMD es compatible con los marcos de IA más populares, incluidos TensorFlow, PyTorch y ONNX Runtime, que abarcan diversos casos de uso, como la clasificación de imágenes y los motores de recomendación.

Código abierto y compatibilidad: Las optimizaciones están integradas en marcos populares que ofrecen una amplia compatibilidad y una facilidad ascendente de código abierto. Además, AMD está trabajando con Hugging Face para permitir que sus modelos de código abierto con ZenDNN.

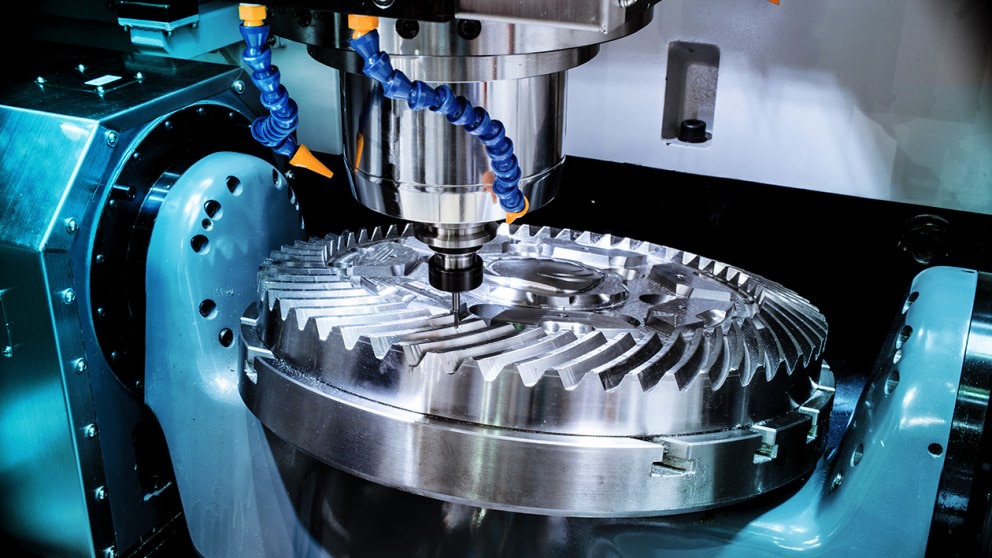

Complementos ZenDNN: Estos complementos aceleran las cargas de trabajo de inferencia de IA mediante la optimización de operadores, el aprovechamiento de los micronúcleos y la implementación de subprocesos múltiples eficientes en núcleos AMD EPYC.