Monétisez le contenu audiovisuel et optimisez les workflows multimédias

Selon une enquête de McKinsey, 39 % des entreprises ont déjà mis en œuvre une forme d'apprentissage automatique (ML) dans leur environnement. Bien que cette adoption soit encore relativement récente, la perspective d'une amélioration de l'efficacité, d'une prévision du comportement des clients et d'une veille stratégique pertinente en fait une technologie attrayante pour les marchés de la diffusion et de l'audiovisuel professionnel.

Les systèmes multimédias peuvent exploiter les capacités d'apprentissage automatique des plateformes AMD pour le traitement de l'intelligence artificielle (IA) en périphérie. Le traitement directement à la périphérie, sans connexion réseau, présente des avantages considérables en matière de performances à faible temps de latence et peut même être utile pour répondre aux nombreuses préoccupations concernant la confidentialité et le stockage des indicateurs d'identification dans le cloud. En intégrant ces capacités d'apprentissage automatique aux côtés des pipelines audio et vidéo de traitement aux plateformes adaptables d'AMD, les entreprises peuvent monétiser les analyses, accroître l'efficacité des workflows et améliorer la facilité d'utilisation. En fin de compte, ces fonctionnalités intégrées d'apprentissage automatique permettent aux entreprises de se démarquer et d'innover plus rapidement.

| Solution d'apprentissage automatique | Scénarios d'utilisation du secteur de la diffusion | Cas d'utilisation de l'audiovisuel professionnel |

|---|---|---|

| Détection d'objets vidéo |

Suivi d'un objet et création d'un cadre pour extraire une partie rognée de la vidéo d'origine | Contrôle des fonctions de prise de vues panoramiques, d'inclinaison et de zoom de la caméra pour la mise au point sur le présentateur ; qualité améliorée par rapport au recadrage et au zoom |

| Détection d'objets spécifiques, tels que des personnes, des animaux ou des voitures. La zone autour des objets identifiés est délimitée par un cadre et les coordonnées du cadre sont transmises à un encodeur pour l'encodage de la région d'intérêt (ROI). | ||

| Automatisation pour les événements sportifs diffusés en direct | ||

| Traitement du langage naturel |

Reconnaissance vocale pour les sous-titres et les légendes | Prise de notes automatisée pendant les conférences |

| Traduction de scripts ou régionalisation de films | Détection du stress dans la voix lors des interactions avec les bornes interactives | |

| Détection du sexe ou de l'âge |

Diffusion de panneaux publicitaires en fonction du sexe ou de l'âge | |

| Analyse de la qualité vidéo |

Détection des séquences complexes et optimisation des paramètres d'encodage | |

| Analyse des sentiments |

Pendant le tournage en direct, détection de l'humeur d'un acteur pour déterminer s'il a agi conformément aux attentes du réalisateur. Recherche d'acteurs présentant une humeur spécifique dans un clip vidéo. Pendant la post-production, utilisation de l'apprentissage automatique pour modifier légèrement l'expression faciale d'un acteur en fonction de l'intention créative/artistique |

Détection de l'humeur d'une personne qui utilise une borne interactive |

| Détection de gestes |

Utilisation de gestes pour éviter de toucher l'écran d'une borne ou d'un affichage interactif Contrôle collaboratif du fonctionnement de la caméra |

|

Fonctionnalités

Encodage de la région d'intérêt

Utilisation de l'apprentissage automatique pour optimiser la bande passante vidéo encodée afin de réduire les coûts

Les coûts de streaming et de stockage des fichiers vidéo volumineux et des contenus UHD peuvent facilement s'accumuler. L'encodage de la région d'intérêt (ROI) peut aider à résoudre ce problème en réduisant le débit binaire global du contenu, puis en appliquant la meilleure qualité vidéo aux zones naturellement attirées par l'œil, en particulier les visages et les personnes, tout en réduisant la qualité vidéo dans les zones moins importantes, telles que les arrière-plans.

Le ROI peut également être utilisé pour conserver les détails dans les zones les plus importantes des applications de salle de contrôle. Par exemple, si un incident se produit et est surveillé sur un grand mur vidéo, il est important que les détails puissent être discernés clairement lors de l'enquête de suivi, mais aussi qu'ils puissent être utilisés pour la formation afin de tirer des leçons des erreurs et d'améliorer les plans de mesures correctives. Il faut donc préserver une qualité de fichier élevée dans les zones de superposition de texte (par exemple, l'horodatage) à l'aide de coordonnées statiques pour l'encodage du ROI, et, pour les visages ou les personnes, à l'aide de coordonnées dynamiques et basées sur l'apprentissage automatique.

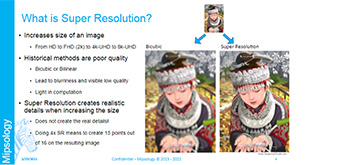

Traitement du langage naturel et LLM

Des modèles de langage qui peuvent être appliqués à de nombreux cas d'utilisation de l'industrie audiovisuelle

La reconnaissance vocale basée sur le traitement du langage naturel (NLP) et de grands modèles de langage (LLM) est déjà proposée au grand public sous la forme d'appareils intelligents (Alexa, Google) capables de répondre aux commandes et de présenter des informations et des contenus multimédias ou de contrôler divers équipements du domicile. Grâce à la technologie NLP et les LLM intégrés aux appareils audiovisuels, les mêmes fonctionnalités peuvent être appliquées à des contenus multimédias professionnels, ce qui simplifie les interfaces utilisateur, et accélère et facilite la configuration de l'équipement, tout en éliminant la nécessité d'une connexion au cloud et de services d'abonnement connexes pour effectuer les mêmes tâches. Grâce à Edge AI, vous pouvez intégrer efficacement une assistance technique à votre produit audiovisuel, avec la possibilité de répondre à des questions sur la configuration, d'examiner les pannes, de vérifier la configuration du réseau et d'effectuer une maintenance prédictive.

Signalétique intelligente

Présenter des publicités ciblées et monétiser les analyses des passants

La publicité ciblée est l'objectif ultime des spécialistes du marketing. En utilisant divers modèles d'apprentissage automatique pour analyser le public face à un écran numérique, il est possible de diffuser des publicités plus pertinentes et ciblées, basées sur des critères tels que l'âge et le sexe. Cela rend le fournisseur de solutions signalétiques plus attrayant pour les annonceurs, qui seront prêts à payer plus cher pour une meilleure présentation de leurs publicités. Cela génère également des données précieuses pour l'annonceur, notamment sur le degré d'intérêt des passants, ce qui peut contribuer à améliorer l'utilisation du service et fournir des commentaires monétisables aux fabricants qu'ils représentent. Les passants, quant à eux, voient des publicités pertinentes et plus personnalisées, ce qui améliore leur expérience d'achat globale. D'autres modèles d'apprentissage automatique peuvent être utilisés dans les bornes interactives, remplaçant les écrans tactiles par des contrôles plus hygiéniques basés sur des gestes pour afficher la publicité suivante ou, surtout, pour passer des commandes.

Recadrage et fenêtres dynamique

Création de plusieurs sorties dans des fenêtres déportées à partir d'une seule caméra haute résolution

Imaginez le streaming en direct d'une table ronde où les intervenants discutent du travail d'un artiste dans une université locale. S'agissant d'un événement à petit budget destiné à un public de niche, les coûts de production sont très faibles. En général, une seule caméra est utilisée pour capturer l'ensemble des intervenants avec quelques zooms et plans panoramiques. Grâce au suivi du visage basé sur l'apprentissage automatique, une caméra 4K statique peut capturer l'ensemble de la table ronde, mais aussi créer automatiquement des sorties HD dans des fenêtres déportées à une résolution plus basse, dédiées à chacun des intervenants pour les suivre tout au long de la conversation. Ainsi, à partir d'une seule caméra 4K, il est possible de basculer entre quatre prises de vues différentes pendant le streaming en direct : le grand angle et trois gros plans. Cela augmente l'intérêt visuel sans nécessiter la mise en place d'équipement supplémentaire. Le cadreur devient alors monteur vidéo et n'a plus qu'à sélectionner les images à diffuser.

Avec différents modèles de suivi basés sur l'apprentissage automatique, cette approche peut être adoptée dans des applications de diffusion professionnelles, telles que la couverture d'événements sportifs, ou dans des environnements de collaboration où plusieurs participants de visioconférence peuvent être suivis automatiquement.

MuseBox MakarenaLabs

Systèmes d'apprentissage automatique pour les applications de diffusion audiovisuelle en temps réel

Disponible auprès de MakarenaLabs, partenaire d'AMD, MuseBox est un système d'apprentissage automatique en temps réel conçu pour les applications de diffusion et d'audiovisuel professionnel. Il peut fonctionner avec le streaming en direct, les applications interactives ou en direct et des fichiers locaux, lorsqu'un grand nombre de fichiers doit être traité et que ces fichiers ne sont pas accessibles en dehors du réseau local pour des raisons juridiques. Il est basé sur un système multiprocesseur sur puce (MPSoC) Zynq UltraScale+ qui utilise des piles multimédias et d'apprentissage automatique ou sur des cartes accélératrices AMD Alveo pour l'élaboration sur site. MuseBox prend en charge l'analyse du visage et des personnes, la détection d'objets, l'analyse audio et bien plus encore !

MakarenaLabs possède une grande expérience dans le domaine de l'apprentissage automatique et propose une gamme de bibliothèques et de produits adaptés à divers cas d'utilisation du secteur audiovisuel. Le système Mooseka est utilisé pour l'analyse, la reconnaissance et l'extraction de caractéristiques audio. Il est utilisé dans l'analyseur de flux MRadio pour reconnaître le contenu musical à des fins d'application et de protection des droits d'auteur, de promotion radio et d'analyse marketing.

Ressources

Technologies