Blogs

Lisez les derniers articles de blog sur les accélérateurs AMD Instinct.

Propulser l'IA et les HPC à grande échelle

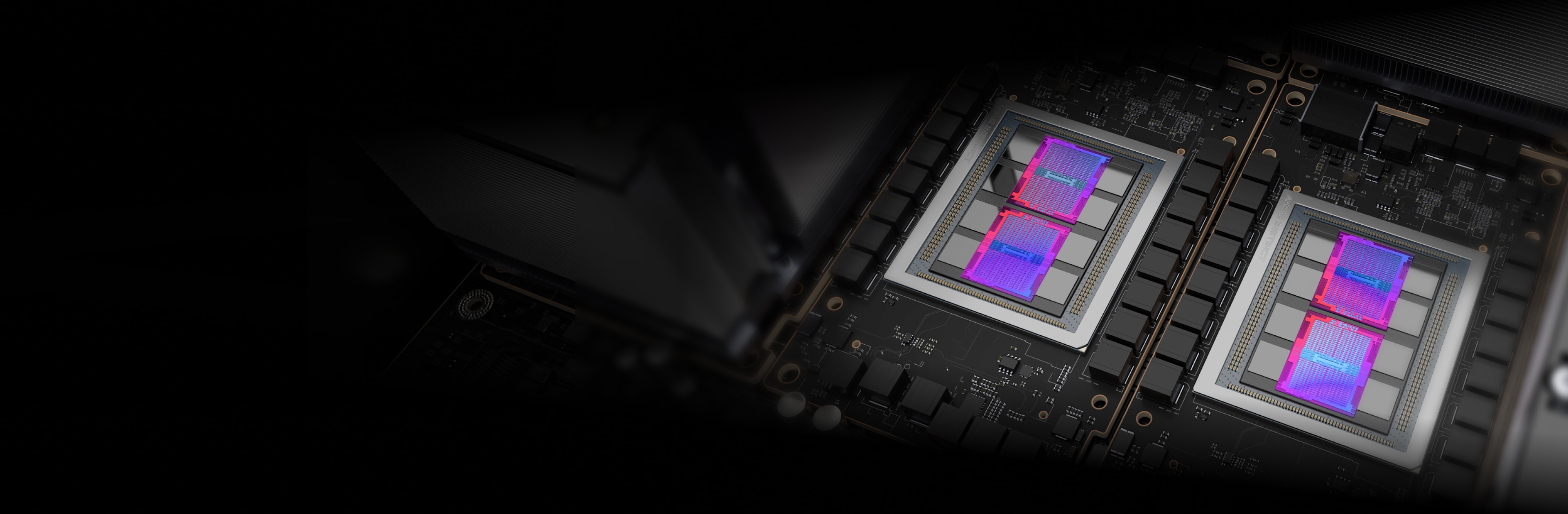

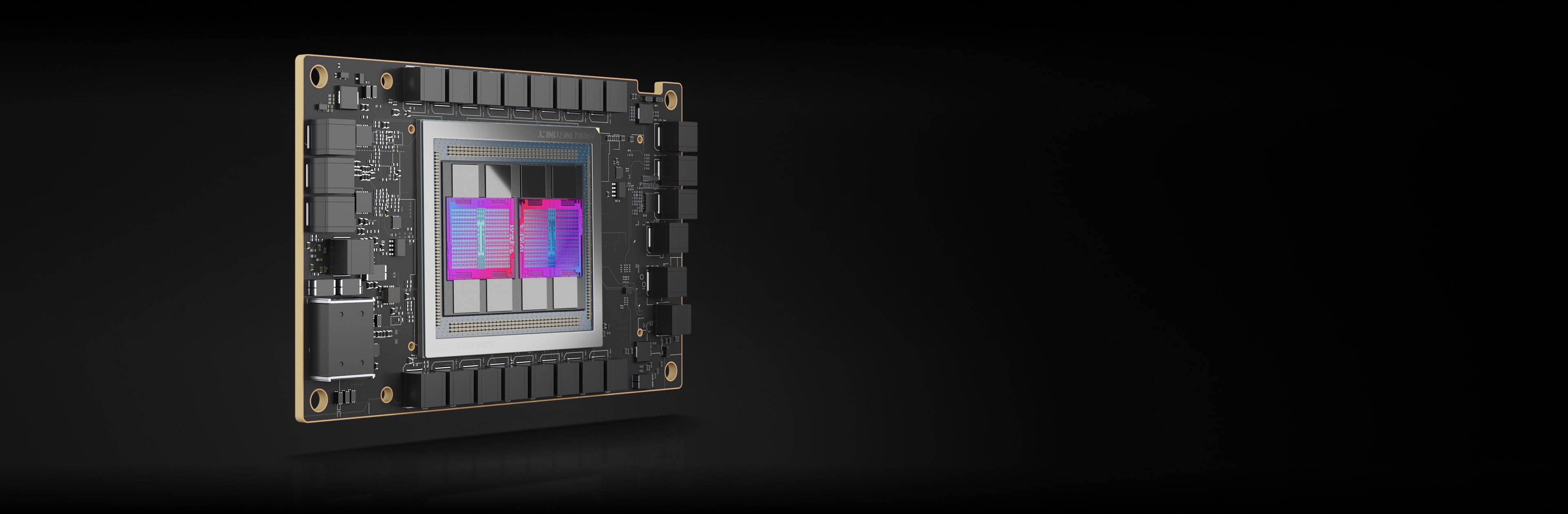

Les accélérateurs AMD Instinct sont basés sur l'architecture AMD CDNA™, qui offre les technologies Matrix Core et la compatibilité avec une large gamme de capacités de précision, des INT8 et FP8 hautement efficaces aux FP64 les plus exigeantes pour les HPC.

Les accélérateurs AMD Instinct MI250X propulsent certains des meilleurs supercalculateurs au monde.

220 unités de calcul GPU

128 Go de mémoire HBM2e

Bande passante mémoire de crête de 3,2 To/s

Bande passante totale de crête Infinity Fabric de 400 Go/s

Performances maximales de 383 TFLOPS en crête en demi-précision théorique (FP16) avec une capacité de mémoire et une bande passante jusqu'à 1,6 fois supérieure aux GPU concurrents pour les charges de travail d'IA les plus exigeantes2,3,4

MI250X

A100

Offre jusqu'à 4 fois plus d'avantages que les GPU concurrents, avec des performances théoriques en crête maximales allant jusqu'à 47,9 TFLOPS en FP64 et 95,7 TFLOPS en matrice FP642.

MI250X

A100

* Le format de données TF32 n'est pas conforme à la norme IEEE et n'est pas inclus dans cette comparaison.

Les accélérateurs AMD Instinct MI250 offrent des performances d'IA et de HPC exceptionnelles pour les cas d'utilisation impliquant des entreprises, des chercheurs et des universitaires.

208 unités de calcul GPU

128 Go de mémoire HBM2e

Bande passante mémoire de crête de 3,2 To/s

Bande passante de crête d'Infinity Fabric™ Link de 100 Go/s

HPCG 3.0 : le benchmark HPCG (High Performance Conjugate Gradients) est un indicateur de classement des systèmes HPC. Le HPCG est destiné à compléter le benchmark HPL (High Performance LINPACK) actuellement utilisé pour le classement TOP500 des systèmes informatiques5.

Mesure |

1xMI250 |

2xMI250 |

4xMI250 |

GFLOPS |

488,8 |

972,6 |

1927,7 |

HPL : Le HPL est une implémentation du benchmark High-Performance Linpack. Le code résout un système aléatoire d'équations linéaires et rapporte le temps et le taux d'exécution en virgule flottante à l'aide d'une formule standard pour le nombre d'opérations6.

Mesure |

1xMI250 |

2xMI250 |

4xMI250 |

TFLOPS |

40,45 |

80,666 |

161,97 |

Le HPL-AI (High Performance LINPACK for Accelerator Introspection) est un benchmark qui met en évidence la convergence des charges de travail d'IA et de HPC en résolvant un système d'équations linéaires à l'aide de nouveaux algorithmes de précision mixte7.

Mesure |

Module de test |

4xMI250 |

TFLOPS |

Mixte FP16/32/64 |

930,44 |

PyFR est une structure Python open source qui permet de résoudre les problèmes de type advection-diffusion sur les architectures de streaming à l'aide de l'approche de reconstruction de flux de Huynh. La structure est conçue pour résoudre divers systèmes de gouvernance sur des grilles mixtes non structurées contenant différents types d'éléments8.

Mesure |

Module de test |

1xMI250 |

Simulations/jour |

TGV |

41,73 |

OpenFOAM (Open-source Field Operation And Manipulation) est une boîte à outils C++ conçue pour le développement de solveurs numériques personnalisés et d'utilitaires de pré-/post-traitement pour la résolution des problèmes de mécanique des milieux continus, notamment la dynamique des fluides numérique (CFD)9.

Mesure |

Module de test |

1xMI250 |

2xMI250 |

4xMI250 |

Durée (s) |

HPC Motorbike (les valeurs les plus élevées ne sont pas les meilleures) |

662,3 |

364,26 |

209,84 |

Amber est une suite de programmes de simulation biomoléculaire. Son nom, Amber, désigne deux éléments distincts : un ensemble de champs de force mécaniques moléculaires pour la simulation de biomolécules d'une part et, d'autre part, un ensemble de programmes de simulation moléculaire qui inclut un code source et des démonstrations10.

Application |

Mesure |

Module de test |

Les valeurs les plus élevées sont les meilleures |

1xMI250 |

AMBER |

ns/jour |

Cellulose Production NPT 4fs |

Oui |

227,2 |

AMBER |

ns/jour |

Cellulose Production NVE 4fs |

Oui |

242,4 |

AMBER |

ns/jour |

FactorIX Production NPT 4fs |

Oui |

803,1 |

AMBER |

ns/jour |

FactorIX Production NVE 4fs |

Oui |

855,2 |

AMBER |

ns/jour |

JAC Production NPT 4fs |

Oui |

1794 |

AMBER |

ns/jour |

JAC Production NVE 4fs |

Oui |

1871 |

AMBER |

ns/jour |

STMV Production NPT 4fs |

Oui |

80,65 |

AMBER |

ns/jour |

STMV Production NVE 4fs |

Oui |

86,7 |

GROMACS est un package de dynamique moléculaire principalement conçu pour les simulations de protéines, de lipides et d'acides nucléiques. Il a été créé par le département de chimie biophysique de l'Université de Groningue et est désormais géré par des contributeurs issus d'universités et de centres de recherche du monde entier11.

Application |

Mesure |

Module de test |

Les valeurs les plus élevées sont les meilleures |

1xMI250 |

2xMI250 |

4xMI250 |

GROMACS |

ns/jour |

STMV |

Oui |

34,2 |

61,812 |

89,26 |

LAMMPS est un code de dynamique moléculaire classique axé sur la modélisation des matériaux. Il s'agit de l'acronyme de « Large-scale Atomic/Molecular Massively Parallel Simulator » (Simulateur atomique/moléculaire massivement parallèle à grande échelle). Le LAMMPS est particulièrement intéressant pour les matériaux solides (métaux, semi-conducteurs) et les matières molles (biomolécules, polymères), ainsi que les systèmes à gros grain ou mésoscopiques12.

Application |

Mesure |

Module de test |

Les valeurs les plus élevées sont les meilleures |

1xMI250 |

2xMI250 |

4xMI250 |

LAMMPS |

Atome-Temps pas/s |

LJ |

Oui |

6E+08 |

1E+09 |

2E+09 |

LAMMPS |

Atome-Temps pas/s |

ReaxFF |

Oui |

7E+06 |

1E+07 |

3E+07 |

LAMMPS |

Atome-Temps pas/s |

Tersoff |

Oui |

5E+08 |

1E+09 |

2E+09 |

NAMD est un package de dynamique moléculaire conçu pour simuler le mouvement des biomolécules au fil du temps. Il est adapté aux systèmes biomoléculaires de grande taille et a été utilisé pour simuler des systèmes avec plus de 1 milliard d'atomes, offrant une évolutivité exceptionnelle sur des milliers de cœurs de CPU et de GPU13.

Application |

Mesure |

Module de test |

Les valeurs les plus élevées sont les meilleures |

1xMI250 |

2xMI250 |

4xMI250 |

NAMD 3.0 |

ns/jour |

APOA1_NVE |

Oui |

221,4 |

443,61 |

879,43 |

NAMD 3.0 |

ns/jour |

STMV_NVE |

Oui |

19,87 |

39,545 |

77,132 |

Les accélérateurs AMD Instinct MI210 propulsent les charges de travail HPC et d'IA des entreprises, des chercheurs et des universitaires pour les solutions monoserveur et bien plus encore.

104 unités de calcul GPU

64 Go de mémoire HBM2e

Bande passante mémoire de crête de 1,6 To/s

Bande passante de crête d'Infinity Fabric™ Link de 100 Go/s

HPL : Le HPL est une implémentation du benchmark High-Performance Linpack. Le code résout un système aléatoire d'équations linéaires et rapporte le temps et le taux d'exécution en virgule flottante à l'aide d'une formule standard pour le nombre d'opérations14.

Mesure |

Les valeurs les plus élevées sont les meilleures |

1xMI210 |

2xMI210 |

4xMI210 | 8xMI210 |

TFLOPS |

Oui |

21,07 |

40,878 |

81,097 | 159,73 |

HPL-AI : Le HPL-AI (High Performance LINPACK for Accelerator Introspection) est un benchmark qui met en évidence la convergence des charges de travail d'IA et de HPC en résolvant un système d'équations linéaires à l'aide de nouveaux algorithmes de précision mixte15.

Mesure |

Module de test |

Les valeurs les plus élevées sont les meilleures |

4xMI210 |

8xMI210 |

TFLOPS |

Mixte FP16/32/64 |

Oui |

444,77 |

976,18 |

LAMMPS : LAMMPS est un code de dynamique moléculaire classique axé sur la modélisation des matériaux. Il s'agit de l'acronyme de « Large-scale Atomic/Molecular Massively Parallel Simulator » (Simulateur atomique/moléculaire massivement parallèle à grande échelle). Le LAMMPS est particulièrement intéressant pour les matériaux solides (métaux, semi-conducteurs) et les matières molles (biomolécules, polymères), ainsi que les systèmes à gros grain ou mésoscopiques16.

Mesure |

Module de test |

Les valeurs les plus élevées sont les meilleures |

4xMI210 | 8xMI210 |

Atome-Temps pas/s |

ReaxFF |

Oui |

1E+07 | 3E+07 |

Abonnez-vous pour recevoir les actualités et contenus les plus récents sur les centres de données et les serveurs.