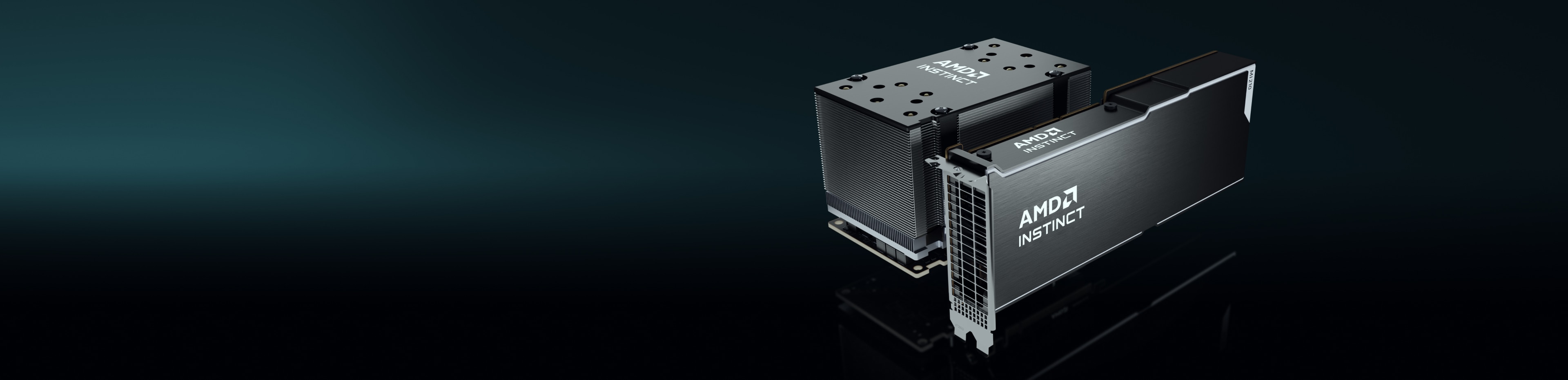

후드 밑

AMD Instinct 가속기는 AMD CDNA™ 아키텍처를 기반으로 구축되어 매트릭스 코어 기술과 고효율 INT8 및 FP8부터 가장 까다로운 HPC용 FP64에 이르기까지 다양한 정밀 기능에 대한 지원을 제공합니다.

AMD Instinct MI250X 가속기

AMD Instinct MI250X 가속기는 세계 최고의 슈퍼컴퓨터 중 일부를 구동합니다.

220개의 CU

GPU 컴퓨팅 유닛 220개

128GB

128GB HBM2e 메모리

3.2TB/s

3.2TB/s 최대 메모리 대역폭

400GB/s

400GB/s 최대 집계 Infinity Fabric

스펙 비교

가장 까다로운 AI 워크로드에 대해 경쟁사 GPU보다 최대 1.6배 더 큰 메모리 용량과 대역폭을 제공하는 최대 383TFLOPS의 이론상 최대 반정도(FP16) 성능2,3,4

MI250X

A100

최대 47.9TFLOPs FP64 및 최대 95.7TFLOPs FP64 매트릭스의 피크 이론상 성능을 제공하여 경쟁사 GPU에 비해 최대 4배의 우위를 제공합니다.2

MI250X

A100

*TF32 데이터 포맷은 IEEE 적합이 아니며 본 비교에 포함되지 않았습니다.

AMD Instinct MI250 가속기

AMD Instinct MI250 가속기는 엔터프라이즈, 연구 및 학술 관련 사용 사례를 위해 탁월한 HPC 및 AI 성능을 제공합니다.

208개의 CU

GPU 컴퓨팅 유닛 208개

128GB

128GB HBM2e 메모리

3.2TB/s

3.2TB/s 최대 메모리 대역폭

100GB/s

100GB/s 최대 Infinity Fabric™ 링크 대역폭

성능 벤치마크

HPCG 3.0: HPCG(High Performance Conjugate Gradients) 벤치마크는 HPC 시스템의 순위를 매기는 척도입니다. HPCG는 현재 TOP500 컴퓨팅 시스템의 순위를 매기는 데 사용되는 HPL(High Performance LINPACK) 벤치마크를 보완합니다.5

수치 |

1xMI250 |

2xMI250 |

4xMI250 |

GFLOPS |

488.8 |

972.6 |

1927.7 |

HPL: HPL은 고성능 Linpack 벤치마크 구현입니다. 이 코드는 균일 난수 선형연립방정식을 풀이하고 작업 수에 대한 표준 공식을 사용하여 시간 및 부동 소수점 실행률을 보고합니다.6

수치 |

1xMI250 |

2xMI250 |

4xMI250 |

TFLOPS |

40.45 |

80.666 |

161.97 |

HPL_AI, 즉 High Performance LINPACK for Accelerator Introspection은 새로운 혼합 정밀도 알고리즘을 사용하여 선형연립방정식을 풀이함으로써 HPC 및 AI 워크로드의 융합을 강조하는 벤치마크입니다.7

수치 |

테스트 모듈 |

4xMI250 |

TFLOPS |

혼합 FP16/32/64 |

930.44 |

PyFR은 Huynh의 플럭스 재구성 접근 방식을 사용하여 스트리밍 아키텍처에서 이류 확산 유형 문제를 풀이하기 위한 오픈소스 Python 기반 프레임워크입니다. 이 프레임워크는 다양한 요소 유형을 포함하는 혼합 비정형 그리드에서 광범위한 관리 시스템을 해결하도록 설계되었습니다.8

수치 |

테스트 모듈 |

1xMI250 |

시뮬레이션 수/일 |

TGV |

41.73 |

OpenFOAM("Open-source Field Operation And Manipulation")은 가장 대표적으로 CFD(전산 유체 역학)를 비롯한 연속체 역학 문제의 풀이를 위한 전처리/후처리 유틸리티와 맞춤형 수치 솔버 개발을 위한 C++ 도구 상자입니다.9

수치 |

테스트 모듈 |

1xMI250 |

2xMI250 |

4xMI250 |

시간(초) |

HPC Motorbike(크다고 좋은 것은 아님) |

662.3 |

364.26 |

209.84 |

Amber는 생체 분자 시뮬레이션 프로그램의 모음이며, 용어 "Amber"는 두 가지를 의미합니다. 첫째, 생체 분자의 시뮬레이션을 위한 분자 역학 역장 세트입니다. 둘째, 소스 코드와 데모가 포함된 분자 시뮬레이션 프로그램 패키지입니다.10

적용 |

수치 |

테스트 모듈 |

클수록 좋음 |

1xMI250 |

AMBER |

ns/일 |

Cellulose 프로덕션 NPT 4fs |

예 |

227.2 |

AMBER |

ns/일 |

Cellulose 프로덕션 NVE 4fs |

예 |

242.4 |

AMBER |

ns/일 |

FactorIX 프로덕션 NPT 4fs |

예 |

803.1 |

AMBER |

ns/일 |

FactorIX 프로덕션 NVE 4fs |

예 |

855.2 |

AMBER |

ns/일 |

JAC 프로덕션 NPT 4fs |

예 |

1794 |

AMBER |

ns/일 |

JAC 프로덕션 NVE 4fs |

예 |

1871 |

AMBER |

ns/일 |

STMV 프로덕션 NPT 4fs |

예 |

80.65 |

AMBER |

ns/일 |

STMV 프로덕션 NVE 4fs |

예 |

86.7 |

GROMACS는 주로 단백질, 지질 및 핵산의 시뮬레이션을 위해 설계된 분자 역학 패키지입니다. 이것은 원래 그로닝겐 대학교의 생물물리학 화학과에서 개발되었으며, 지금은 전 세계 대학과 연구 센터의 기여자들에 의해 유지됩니다.11

적용 |

수치 |

테스트 모듈 |

클수록 좋음 |

1xMI250 |

2xMI250 |

4xMI250 |

GROMACS |

ns/일 |

STMV |

예 |

34.2 |

61.812 |

89.26 |

LAMMPS는 재료 모델링에 중점을 둔 고전적인 분자 역학 코드입니다. LAMMPS는 Large-scale Atomic/Molecular Massively Parallel Simulator의 약어입니다. LAMMPS는 고체 물질(금속, 반도체)과 연질 물질(생체 분자, 고분자) 및 거친 입자 또는 메소스코픽 시스템에 대해 잠재력을 가지고 있습니다.12

적용 |

수치 |

테스트 모듈 |

클수록 좋음 |

1xMI250 |

2xMI250 |

4xMI250 |

LAMMPS |

Atom-Time Steps/초 |

LJ |

예 |

6E+08 |

1E+09 |

2E+09 |

LAMMPS |

Atom-Time Steps/초 |

ReaxFF |

예 |

7E+06 |

1E+07 |

3E+07 |

LAMMPS |

Atom-Time Steps/초 |

Tersoff |

예 |

5E+08 |

1E+09 |

2E+09 |

NAMD는 시간 경과에 따른 생체 분자의 움직임을 시뮬레이션하기 위해 설계된 분자 역학 패키지입니다. 대형 생체 분자 시스템에 적합하며 10억 개 이상의 원자를 가진 시스템을 시뮬레이션하는 데 사용되어 수천 개의 CPU 코어와 GPU에서 뛰어난 확장성을 제공합니다.13

적용 |

수치 |

테스트 모듈 |

클수록 좋음 |

1xMI250 |

2xMI250 |

4xMI250 |

NAMD 3.0 |

ns/일 |

APOA1_NVE |

예 |

221.4 |

443.61 |

879.43 |

NAMD 3.0 |

ns/일 |

STMV_NVE |

예 |

19.87 |

39.545 |

77.132 |

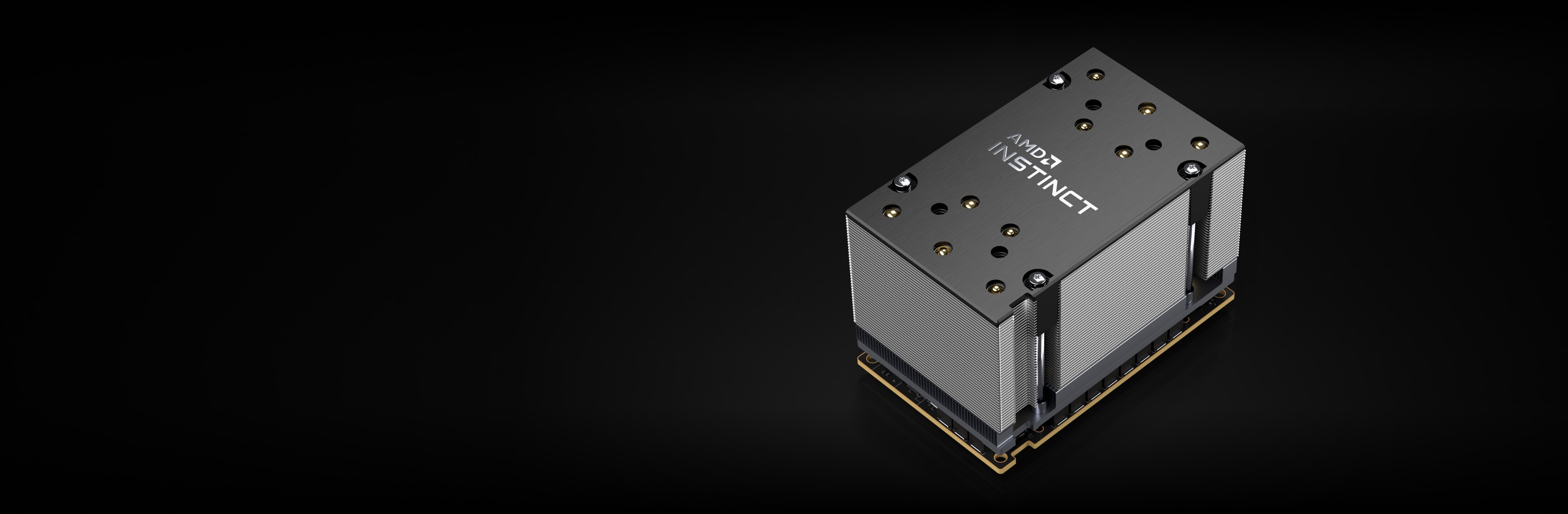

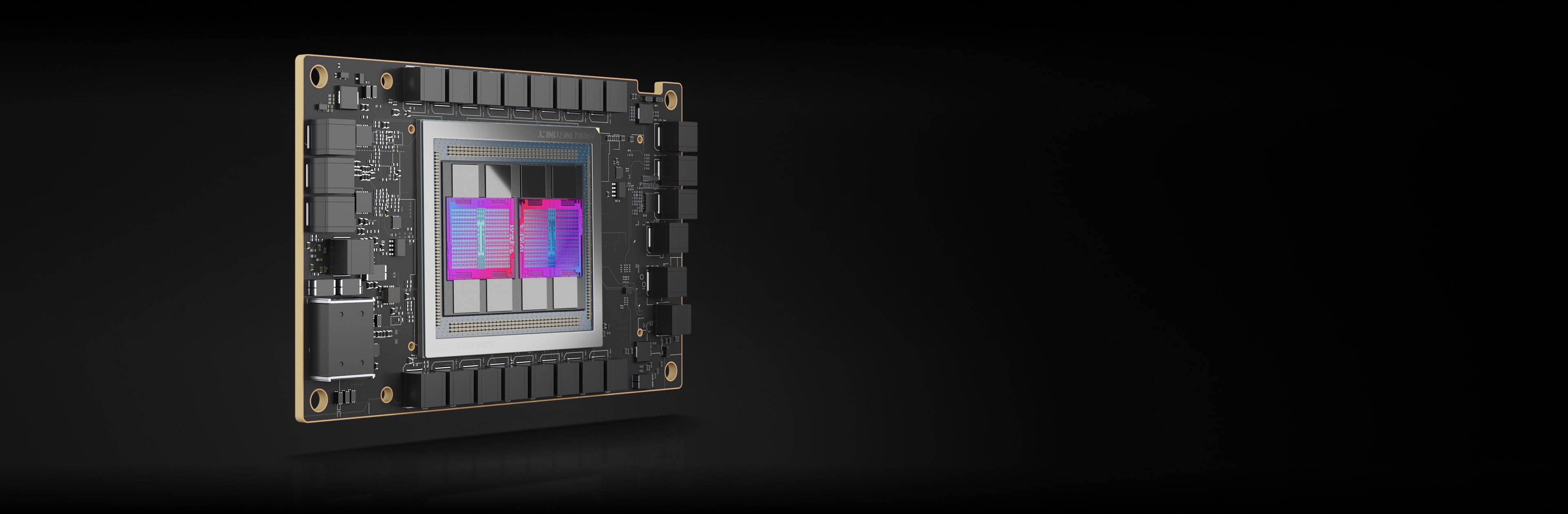

AMD Instinct MI210 가속기

AMD Instinct MI210 가속기는 단일 서버 솔루션 등을 위한 엔터프라이즈, 연구, 학술 HPC 및 AI 워크로드를 지원합니다.

104개의 CU

GPU 컴퓨팅 유닛 104개

64GB

64GB HBM2e 메모리

1.6TB/s

1.6TB/s 최대 메모리 대역폭

100GB/s

100GB/s 최대 Infinity Fabric™ 링크 대역폭

성능 벤치마크

HPL: HPL은 고성능 Linpack 벤치마크 구현입니다. 이 코드는 균일 난수 선형연립방정식을 풀이하고 작업 수에 대한 표준 공식을 사용하여 시간 및 부동 소수점 실행률을 보고합니다.14

수치 |

클수록 좋음 |

1xMI210 |

2xMI210 |

4xMI210 | 8xMI210 |

TFLOPS |

예 |

21.07 |

40.878 |

81.097 | 159.73 |

HPL-AI: HPL_AI, 즉 High Performance LINPACK for Accelerator Introspection은 새로운 혼합 정밀도 알고리즘을 사용하여 선형연립방정식을 풀이함으로써 HPC 및 AI 워크로드의 융합을 강조하는 벤치마크입니다.15

수치 |

테스트 모듈 |

클수록 좋음 |

4xMI210 |

8xMI210 |

TFLOPS |

혼합 FP16/32/64 |

예 |

444.77 |

976.18 |

LAMMPS: LAMMPS는 재료 모델링에 중점을 둔 고전적인 분자 역학 코드입니다. LAMMPS는 Large-scale Atomic/Molecular Massively Parallel Simulator의 약어입니다. LAMMPS는 고체 물질(금속, 반도체)과 연질 물질(생체 분자, 고분자) 및 거친 입자 또는 메소스코픽 시스템에 대해 잠재력을 가지고 있습니다.16

수치 |

테스트 모듈 |

클수록 좋음 |

4xMI210 | 8xMI210 |

Atom-Time Steps/초 |

ReaxFF |

예 |

1E+07 | 3E+07 |

새로운 정보를 놓치지 마세요

최신 데이터 센터 소식과 서버 관련 콘텐츠를 받으려면 등록하세요.

각주

- 상위 500개 목록, 2023년 6월

- 세계에서 가장 빠른 데이터 센터 GPU는 AMD Instinct™ MI250X입니다. 계산 결과는 AMD 퍼포먼스 랩에 의해 AMD Instinct™ MI250X(128GB HBM2e OAM 모듈) 가속기에서 1,700MHz 피크 부스트 엔진 클럭으로 2021년 9월 15일 수행되었으며 그 결과는 95.7TFLOPS 피크 이론상 배정도(FP64 매트릭스), 47.9TFLOPS 피크 이론상 배정도(FP64), 95.7TFLOPS 피크 이론상 단정도 매트릭스(FP32 매트릭스), 47.9TFLOPS 피크 이론상 단정도(FP32), 383.0TFLOPS 피크 이론상 반정도(FP16) 및 383.0TFLOPS 피크 이론상 Bfloat16 포맷 정도(BF16) 부동 소수점 성능이었습니다. 2020년 9월 18일 기준, AMD 퍼포먼스 랩에서 1,502MHz 최대 부스트 엔진 클럭으로 AMD Instinct™ MI100(32GB HBM2 PCIe® 카드) 가속기를 통해 측정된 성능 결과는 피크 이론상 배정밀도 연산(FP64) 11.54TFLOPS, 피크 이론상 단정밀도 매트릭스 연산(FP32) 46.1TFLOPS, 피크 이론상 단정밀도 연산(FP32) 23.1TFLOPS 피크 이론상 부동 소수점 성능(FP16) 184.6TFLOPS입니다. NVidia Ampere A100(80GB) GPU 가속기(1410MHz의 부스트 엔진 클럭)에 대한 발표된 결과에 따르면, 19.5TFLOPS 피크 배정도 텐서 코어(FP64 Tensor Core), 9.7TFLOPS 피크 배정도(FP64), 19.5TFLOPS 피크 단정도(FP32), 78TFLOPS 피크 반정도(FP16), 312TFLOPS 피크 반정도(FP16 Tensor Flow), 39TFLOPS 피크 Bfloat 16(BF16), 312TFLOPS 피크 Bfloat16 포맷 정도(BF16 Tensor Flow), 이론상 부동 소수점 성능이었습니다. TF32 데이터 포맷은 IEEE 적합이 아니며 본 비교에 포함되지 않았습니다. https://www.nvidia.com/content/dam/en-zz/Solutions/Data-Center/nvidia-ampere-architecture-whitepaper.pdf, 페이지 15, 표 1. MI200-01

- 2021년 9월 21일 기준, AMD 퍼포먼스 랩에서 AMD CDNA™ 2 6nm FinFet 공정 기술로 설계된 AMD Instinct™ MI250X 및 MI250(128GB HBM2e) OAM 가속기를 대상으로 1,600MHz 최대 메모리 클럭에서 계산한 결과 3.2768TFLOPS 피크 이론상 메모리 대역폭 성능을 기록했습니다. MI250/MI250X 메모리 버스 인터페이스는 4,096비트 x 2개 다이이고 메모리 데이터율은 3.20Gbps로 총 메모리 대역폭은 3.2768TB/s((3.20Gbps*(4,096비트*2))/8)입니다. NVidia Ampere A100(80GB) SXM GPU 가속기에서 발표된 가장 높은 결과는 2.039TB/s GPU 메모리 대역폭 성능을 나타냅니다. https://www.nvidia.com/content/dam/en-zz/Solutions/Data-Center/a100/pdf/nvidia-a100-datasheet-us-nvidia-1758950-r4-web.pdf MI200-07

- 2021년 9월 21일 기준, AMD 퍼포먼스 랩에서 AMD CDNA™ 2 6nm FinFet 공정 기술로 설계된 AMD Instinct™ MI250X 및 MI250 가속기(OAM)를 대상으로 1,600MHz 최대 메모리 클럭에서 계산한 결과 128GB HBMe 메모리 용량을 기록했습니다. NVidia Ampere A100(80GB) SXM 및 A100 가속기(PCIe®)에 대한 공개 사양은 80GB 메모리 용량을 나타냅니다. 결과 자료: https://www.nvidia.com/content/dam/en-zz/Solutions/Data-Center/a100/pdf/nvidia-a100-datasheet-us-nvidia-1758950-r4-web.pdf MI200-18

- 테스트는 2022년 11월 2일 AMD 퍼포먼스 랩에서 HPCG 3.0을 사용해 두 시스템을 비교하여 수행되었습니다. 2P EPYC™ 7763 기반 서버, SMT 비활성화, 1x, 2x, 4x AMD Instinct™ MI250(128GB HBM2e) 560W GPU, SBIOS M12, Ubuntu 20.04.4, Host ROCm 5.2.0 포함 vs. 2P AMD EPYC™ 7742 서버, 1x, 2x, 4x Nvidia Ampere A100 80GB SXM 400W GPU, SBIOS 0.34, Ubuntu 20.04.4, CUDA 11.6 포함. HPCG 3.0 컨테이너: nvcr.io/nvidia/hpc-benchmarks:21.4-hpcg 의 출처: https://catalog.ngc.nvidia.com/orgs/nvidia/containers/hpc-benchmarks. 서버 제조업체별 구성에 따라 다른 결과가 나올 수 있습니다. 최신 드라이버의 사용 여부 및 최적화에 따라 성능이 달라질 수 있습니다. MI200-70A.

- 테스트는 2022년 11월 14일 AMD 퍼포먼스 랩에서 HPL을 사용해 두 시스템을 비교하여 수행되었습니다. 2P EPYC™ 7763 기반 서버, SMT 비활성화, 1x, 2x, 4x AMD Instinct™ MI250(128GB HBM2e) 560W GPU, host ROCm 5.2.0, rocHPL6.0.0. AMD HPL 컨테이너(아직 Infinity Hub에서 사용할 수 없음). vs. 2P AMD EPYC™ 7742 서버, SMT 활성화, 1x, 2x, 4x Nvidia Ampere A100 80GB SXM 400W GPU, CUDA 11.6 및 드라이버 버전 510.47.03. HPL 컨테이너(nvcr.io/nvidia/hpc-benchmarks:21.4-hpl)의 출처: .https://catalog.ngc.nvidia.com/orgs/nvidia/containers/hpc-benchmarks. 서버 제조업체별 구성에 따라 다른 결과가 나올 수 있습니다. 최신 드라이버의 사용 여부 및 최적화에 따라 성능이 달라질 수 있습니다. MI200-69A.

- HPL-AI 비교는 2022년 11월 2일 기준, 호스트 ROCm 5.2.0을 실행하는 4x MI250 128MB HBM2e가 탑재된 2x EPYC 7763이 있는 서버, HPL-AI-AMD v1.0.0과 CUDA 11.6을 실행하는 4x A100 SXM 80GB HBM2e가 탑재된 2x EPYC 7742가 있는 서버 HPL-AI-NVIDIA v2.0.0, 컨테이너 nvcr.io/nvidia/hpc-benchmarks:21.4-hpl을 비교 사용하여 HPL-AI 벤치마크 성능(TFLOPS)을 측정한 AMD 내부 테스트에 기초했습니다. 서버 제조업체별 구성에 따라 다른 결과가 나올 수 있습니다. 최신 드라이버의 사용 여부 및 최적화에 따라 성능이 달라질 수 있습니다. MI200-81.

- 테스트는 2022년 11월 25일 기준, AMD 퍼포먼스 랩에서 PyFR TGV 및 NACA 0021을 사용해 다음 두 시스템을 비교하여 수행되었습니다. 2P EPYC™ 7763 기반 서버, SMT 비활성화, 1x AMD Instinct™ MI250(128GB HBM2e) 560W GPU, SBIOS M12, Ubuntu 20.04.4, Host ROCm 5.2.0 포함 vs. 2P AMD EPYC™ 7742 서버, SMT 활성화, 1x Nvidia Ampere A100 80GB SXM 400W GPU, SBIOS 0.34, Ubuntu 20.04.4, CUDA 11.6 포함. 서버 제조업체별 구성에 따라 다른 결과가 나올 수 있습니다. 최신 드라이버의 사용 여부 및 최적화에 따라 성능이 달라질 수 있습니다. MI200-82.

- 테스트는 AMD 퍼포먼스 랩에서 2023년 4월 14일에 AMD Infinity Fabric™ 기술이 활성화된 1x, 2x, 4x AMD Instinct™ MI250 GPU(128GB, 560W)가 탑재된 2P EPYC 7763 CPU 프로덕션 서버, ROCm™5.3.3, Ubuntu® 20.04.4와 NVLink 기술이 활성화된 1x, 2x, 4x Nvidia A100 80GB SXM GPU(400W)가 탑재된 2P EPYC 7742 CPU 프로덕션 서버, CUDA® 11.8, Ubuntu 20.04.4에서 OpenFOAM v2206을 사용하여 수행되었습니다. 서버 제조업체별 구성에 따라 다른 결과가 나올 수 있습니다. 최신 드라이버의 사용 여부 및 최적화에 따라 성능이 달라질 수 있습니다.

- 테스트는 2022년 8월 26일 기준 AMD 퍼포먼스 랩에서 다음을 사용하여 수행되었습니다. AMBER: Cellulose_production_NPT_4fs, Cellulose_production_NVE_4fs, FactorIX_production_NPT_4fs, FactorIX_production_NVE_4fs, STMV_production_NPT_4fs, STMV_production_NVE_4fs, JAC_production_NPT_4fs 및 JAC production_NVE_4fs. 두 시스템 비교: 2P EPYC™ 7763 기반 서버(1x A MD Instinct™ MI250(128GB HBM2e) 560W GPU 포함), ROCm 5.2.0, Amber 컨테이너 22.amd_100 vs. 2P EPYC™ 7742 기반 서버(1x N vidia A100 SXM(80GB HBM2e) 400W GPU 포함, MPS 활성화(2 인스턴스)), CUDA 11.6. MI200-73.

- 테스트는 2022년 10월 18일 AMD 퍼포먼스 랩에서 Gromacs STMV를 사용해 두 시스템을 비교하여 수행되었습니다. 2P EPYC™ 7763 기반 서버(Infinity Fabric™ 기술이 적용된 4x AMD Instinct™ MI250(128GB HBM2e) 560W GPU 포함), ROCm™ 5.2.0, Gromacs 컨테이너 2022.3.amd1_174 vs. Nvidia의 공개 클레임 https://developer.nvidia.com/hpc-application-performance. (Gromacs 2022.2). 듀얼 EPYC 7742(4x Nvidia Ampere A100 SXM 80GB GPU 포함). 서버 제조업체별 구성에 따라 다른 결과가 나올 수 있습니다. 최신 드라이버의 사용 여부 및 최적화를 포함한 요소에 따라 성능이 달라질 수 있습니다. MI200-74.

- 테스트는 AMD 퍼포먼스 랩 109.0322.22에서 LAMMPS: EAM, LJ, ReaxFF 및 Tersoff를 사용해 두 시스템을 비교하여 수행되었습니다. 2P EPYC™ 7763 기반 서버(4x AMD Instinct™ MI250(128GB HBM2e) 560W GPU 포함), ROCm 5.2.0, LAMMPS 컨테이너 2021.5.14_121amdih/LAMMPS:2022.5.04_130 vs. Nvidia의 공개 클레임 http://web.archive.org/web/20220718053400/https://developer.nvidia.com/hpc-application-performance (안정적인 2022년 6월 23일 업데이트 1). 서버 제조업체별 구성에 따라 다른 결과가 나올 수 있습니다. 최신 드라이버의 사용 여부 및 최적화에 따라 성능이 달라질 수 있습니다. MI200-77.

- 테스트는 2022년 9월 13일 기준 AMD 퍼포먼스 랩에서 다음을 사용하여 수행되었습니다. NAMD: STMV_NVE, APOA1_NVE 두 시스템 비교: 2P EPYC™ 7763 기반 서버 및 AMD Infinity Fabric™ 기술이 적용된 1x, 2x, 4x AMD Instinct™ MI250(128GB HBM2e) 560W GPU, ROCm 5.2.0, NAMD 컨테이너 namd3:3.0a9 vs. 2P EPYC 7742 서버 및 1x, 2x, 4x Nvidia Ampere A100 80GB SXM GPU 성능에 대한 Nvidia의 공개 클레임 https://developer.nvidia.com/hpc-application-performance. (v2.15a, AVX-512). 서버 제조업체별 구성에 따라 다른 결과가 나올 수 있습니다. 최신 드라이버의 사용 여부 및 최적화에 따라 성능이 달라질 수 있습니다. MI200-76.

- 테스트는 2022년 11월 14일 AMD 퍼포먼스 랩에서 AMD Infinity Fabric™ 기술이 활성화된 8x AMD Instinct™ MI210 GPU(PCIe® 64GB, 300W) 탑재 2P 소켓 AMD EPYC™ 7763 CPU Supermicro 4124에 대해 수행되었습니다. Ubuntu 18.04.6 LTS, Host ROCm 5.2.0, rocHPL 6.0.0. 결과는 5회 실행의 중간값으로 계산되었으며, 테스트는 AMD 퍼포먼스에서 2P 소켓 AMD EPYC™ 7763 Supermicro 4124(8x NVIDIA A100 GPU(PCIe 80GB 300W), Ubuntu 18.04.6 LTS, CUDA 11.6, HPL Nvidia 컨테이너 이미지 21.4-HPL 포함)에 대해 수행되었습니다. 모든 결과는 8개의 GPU, 4방향 Infinity Fabric™ 링크 브리지로 연결된 2쌍의 4xMI210 GPU, 2방향 NVLink 브리지로 연결된 4쌍의 2xA100 80GB PCIe GPU로 구성된 시스템에서 측정되었습니다. HPL에 대한 정보: https://www.netlib.org/benchmark/hpl/. AMD HPL 컨테이너 세부사항: HPL 컨테이너는 아직 Infinity Hub에서 사용할 수 없습니다. Nvidia HPL 컨테이너 세부사항: https://ngc.nvidia.com/catalog/containers/nvidia:hpc-benchmarks. 서버 제조업체별 구성에 따라 다른 결과가 나올 수 있습니다. 최신 드라이버의 사용 여부 및 최적화에 따라 성능이 달라질 수 있습니다. MI200-49A.

- HPL-AI 비교는 2022년 11월 2일 기준, 호스트 ROCm 5.2.0을 실행하는 Infinity Fabric 기술이 적용된 8x MI210 64MB HBM2e가 탑재된 2x EPYC 7763이 있는 서버, HPL-AI-AMD v1.0.0(AMD HPL-AI 컨테이너(아직 Infinity Hub에서 사용할 수 없음))과 CUDA 11.6,을 실행하는 8x A100 PCIe 80GB HBM2e가 탑재된 2x EPYC 7763이 있는 서버, HPL-AI-NVIDIA v2.0.0(컨테이너 nvcr.io/nvidia/hpc-benchmarks:21.4-hpl)을 비교 사용하여 HPL-AI 벤치마크 성능(TFLOPS)을 측정한 AMD 내부 테스트에 기초했습니다. 서버 제조업체별 구성에 따라 다른 결과가 나올 수 있습니다. 최신 드라이버의 사용 여부 및 최적화에 따라 성능이 달라질 수 있습니다. MI200-83.

- 테스트는 2022년 10월 3일 기준 다음을 사용하여 AMD 퍼포먼스 랩에서 수행되었습니다. 2P 소켓 AMD EPYC™ 7763 CPU Supermicro 4124 및 AMD Infinity Fabric™ 기술이 적용된 4x 및 8x AMD Instinct™ MI210 GPU(PCIe® 64GB, 300W) 기반. SBIOS2.2, Ubuntu® 18.04.6 LTS, host ROCm™ 5.2.0. LAMMPS 컨테이너 amdih-2022.5.04_130(ROCm 5.1) vs - 4x 및 8x A100 PCIe 80GB GPU에 대한 Nvidia의 공개 클레임 http://web.archive.org/web/20220718053400/https://developer.nvidia.com/hpc-application-performance. 서버 제조업체별 구성에 따라 다른 결과가 나올 수 있습니다. 최신 드라이버의 사용 여부 및 최적화에 따라 성능이 달라질 수 있습니다. MI200-47A.

- 상위 500개 목록, 2023년 6월

- 세계에서 가장 빠른 데이터 센터 GPU는 AMD Instinct™ MI250X입니다. 계산 결과는 AMD 퍼포먼스 랩에 의해 AMD Instinct™ MI250X(128GB HBM2e OAM 모듈) 가속기에서 1,700MHz 피크 부스트 엔진 클럭으로 2021년 9월 15일 수행되었으며 그 결과는 95.7TFLOPS 피크 이론상 배정도(FP64 매트릭스), 47.9TFLOPS 피크 이론상 배정도(FP64), 95.7TFLOPS 피크 이론상 단정도 매트릭스(FP32 매트릭스), 47.9TFLOPS 피크 이론상 단정도(FP32), 383.0TFLOPS 피크 이론상 반정도(FP16) 및 383.0TFLOPS 피크 이론상 Bfloat16 포맷 정도(BF16) 부동 소수점 성능이었습니다. 2020년 9월 18일 기준, AMD 퍼포먼스 랩에서 1,502MHz 최대 부스트 엔진 클럭으로 AMD Instinct™ MI100(32GB HBM2 PCIe® 카드) 가속기를 통해 측정된 성능 결과는 피크 이론상 배정밀도 연산(FP64) 11.54TFLOPS, 피크 이론상 단정밀도 매트릭스 연산(FP32) 46.1TFLOPS, 피크 이론상 단정밀도 연산(FP32) 23.1TFLOPS 피크 이론상 부동 소수점 성능(FP16) 184.6TFLOPS입니다. NVidia Ampere A100(80GB) GPU 가속기(1410MHz의 부스트 엔진 클럭)에 대한 발표된 결과에 따르면, 19.5TFLOPS 피크 배정도 텐서 코어(FP64 Tensor Core), 9.7TFLOPS 피크 배정도(FP64), 19.5TFLOPS 피크 단정도(FP32), 78TFLOPS 피크 반정도(FP16), 312TFLOPS 피크 반정도(FP16 Tensor Flow), 39TFLOPS 피크 Bfloat 16(BF16), 312TFLOPS 피크 Bfloat16 포맷 정도(BF16 Tensor Flow), 이론상 부동 소수점 성능이었습니다. TF32 데이터 포맷은 IEEE 적합이 아니며 본 비교에 포함되지 않았습니다. https://www.nvidia.com/content/dam/en-zz/Solutions/Data-Center/nvidia-ampere-architecture-whitepaper.pdf, 페이지 15, 표 1. MI200-01

- 2021년 9월 21일 기준, AMD 퍼포먼스 랩에서 AMD CDNA™ 2 6nm FinFet 공정 기술로 설계된 AMD Instinct™ MI250X 및 MI250(128GB HBM2e) OAM 가속기를 대상으로 1,600MHz 최대 메모리 클럭에서 계산한 결과 3.2768TFLOPS 피크 이론상 메모리 대역폭 성능을 기록했습니다. MI250/MI250X 메모리 버스 인터페이스는 4,096비트 x 2개 다이이고 메모리 데이터율은 3.20Gbps로 총 메모리 대역폭은 3.2768TB/s((3.20Gbps*(4,096비트*2))/8)입니다. NVidia Ampere A100(80GB) SXM GPU 가속기에서 발표된 가장 높은 결과는 2.039TB/s GPU 메모리 대역폭 성능을 나타냅니다. https://www.nvidia.com/content/dam/en-zz/Solutions/Data-Center/a100/pdf/nvidia-a100-datasheet-us-nvidia-1758950-r4-web.pdf MI200-07

- 2021년 9월 21일 기준, AMD 퍼포먼스 랩에서 AMD CDNA™ 2 6nm FinFet 공정 기술로 설계된 AMD Instinct™ MI250X 및 MI250 가속기(OAM)를 대상으로 1,600MHz 최대 메모리 클럭에서 계산한 결과 128GB HBMe 메모리 용량을 기록했습니다. NVidia Ampere A100(80GB) SXM 및 A100 가속기(PCIe®)에 대한 공개 사양은 80GB 메모리 용량을 나타냅니다. 결과 자료: https://www.nvidia.com/content/dam/en-zz/Solutions/Data-Center/a100/pdf/nvidia-a100-datasheet-us-nvidia-1758950-r4-web.pdf MI200-18

- 테스트는 2022년 11월 2일 AMD 퍼포먼스 랩에서 HPCG 3.0을 사용해 두 시스템을 비교하여 수행되었습니다. 2P EPYC™ 7763 기반 서버, SMT 비활성화, 1x, 2x, 4x AMD Instinct™ MI250(128GB HBM2e) 560W GPU, SBIOS M12, Ubuntu 20.04.4, Host ROCm 5.2.0 포함 vs. 2P AMD EPYC™ 7742 서버, 1x, 2x, 4x Nvidia Ampere A100 80GB SXM 400W GPU, SBIOS 0.34, Ubuntu 20.04.4, CUDA 11.6 포함. HPCG 3.0 컨테이너: nvcr.io/nvidia/hpc-benchmarks:21.4-hpcg 의 출처: https://catalog.ngc.nvidia.com/orgs/nvidia/containers/hpc-benchmarks. 서버 제조업체별 구성에 따라 다른 결과가 나올 수 있습니다. 최신 드라이버의 사용 여부 및 최적화에 따라 성능이 달라질 수 있습니다. MI200-70A.

- 테스트는 2022년 11월 14일 AMD 퍼포먼스 랩에서 HPL을 사용해 두 시스템을 비교하여 수행되었습니다. 2P EPYC™ 7763 기반 서버, SMT 비활성화, 1x, 2x, 4x AMD Instinct™ MI250(128GB HBM2e) 560W GPU, host ROCm 5.2.0, rocHPL6.0.0. AMD HPL 컨테이너(아직 Infinity Hub에서 사용할 수 없음). vs. 2P AMD EPYC™ 7742 서버, SMT 활성화, 1x, 2x, 4x Nvidia Ampere A100 80GB SXM 400W GPU, CUDA 11.6 및 드라이버 버전 510.47.03. HPL 컨테이너(nvcr.io/nvidia/hpc-benchmarks:21.4-hpl)의 출처: .https://catalog.ngc.nvidia.com/orgs/nvidia/containers/hpc-benchmarks. 서버 제조업체별 구성에 따라 다른 결과가 나올 수 있습니다. 최신 드라이버의 사용 여부 및 최적화에 따라 성능이 달라질 수 있습니다. MI200-69A.

- HPL-AI 비교는 2022년 11월 2일 기준, 호스트 ROCm 5.2.0을 실행하는 4x MI250 128MB HBM2e가 탑재된 2x EPYC 7763이 있는 서버, HPL-AI-AMD v1.0.0과 CUDA 11.6을 실행하는 4x A100 SXM 80GB HBM2e가 탑재된 2x EPYC 7742가 있는 서버 HPL-AI-NVIDIA v2.0.0, 컨테이너 nvcr.io/nvidia/hpc-benchmarks:21.4-hpl을 비교 사용하여 HPL-AI 벤치마크 성능(TFLOPS)을 측정한 AMD 내부 테스트에 기초했습니다. 서버 제조업체별 구성에 따라 다른 결과가 나올 수 있습니다. 최신 드라이버의 사용 여부 및 최적화에 따라 성능이 달라질 수 있습니다. MI200-81.

- 테스트는 2022년 11월 25일 기준, AMD 퍼포먼스 랩에서 PyFR TGV 및 NACA 0021을 사용해 다음 두 시스템을 비교하여 수행되었습니다. 2P EPYC™ 7763 기반 서버, SMT 비활성화, 1x AMD Instinct™ MI250(128GB HBM2e) 560W GPU, SBIOS M12, Ubuntu 20.04.4, Host ROCm 5.2.0 포함 vs. 2P AMD EPYC™ 7742 서버, SMT 활성화, 1x Nvidia Ampere A100 80GB SXM 400W GPU, SBIOS 0.34, Ubuntu 20.04.4, CUDA 11.6 포함. 서버 제조업체별 구성에 따라 다른 결과가 나올 수 있습니다. 최신 드라이버의 사용 여부 및 최적화에 따라 성능이 달라질 수 있습니다. MI200-82.

- 테스트는 AMD 퍼포먼스 랩에서 2023년 4월 14일에 AMD Infinity Fabric™ 기술이 활성화된 1x, 2x, 4x AMD Instinct™ MI250 GPU(128GB, 560W)가 탑재된 2P EPYC 7763 CPU 프로덕션 서버, ROCm™5.3.3, Ubuntu® 20.04.4와 NVLink 기술이 활성화된 1x, 2x, 4x Nvidia A100 80GB SXM GPU(400W)가 탑재된 2P EPYC 7742 CPU 프로덕션 서버, CUDA® 11.8, Ubuntu 20.04.4에서 OpenFOAM v2206을 사용하여 수행되었습니다. 서버 제조업체별 구성에 따라 다른 결과가 나올 수 있습니다. 최신 드라이버의 사용 여부 및 최적화에 따라 성능이 달라질 수 있습니다.

- 테스트는 2022년 8월 26일 기준 AMD 퍼포먼스 랩에서 다음을 사용하여 수행되었습니다. AMBER: Cellulose_production_NPT_4fs, Cellulose_production_NVE_4fs, FactorIX_production_NPT_4fs, FactorIX_production_NVE_4fs, STMV_production_NPT_4fs, STMV_production_NVE_4fs, JAC_production_NPT_4fs 및 JAC production_NVE_4fs. 두 시스템 비교: 2P EPYC™ 7763 기반 서버(1x A MD Instinct™ MI250(128GB HBM2e) 560W GPU 포함), ROCm 5.2.0, Amber 컨테이너 22.amd_100 vs. 2P EPYC™ 7742 기반 서버(1x N vidia A100 SXM(80GB HBM2e) 400W GPU 포함, MPS 활성화(2 인스턴스)), CUDA 11.6. MI200-73.

- 테스트는 2022년 10월 18일 AMD 퍼포먼스 랩에서 Gromacs STMV를 사용해 두 시스템을 비교하여 수행되었습니다. 2P EPYC™ 7763 기반 서버(Infinity Fabric™ 기술이 적용된 4x AMD Instinct™ MI250(128GB HBM2e) 560W GPU 포함), ROCm™ 5.2.0, Gromacs 컨테이너 2022.3.amd1_174 vs. Nvidia의 공개 클레임 https://developer.nvidia.com/hpc-application-performance. (Gromacs 2022.2). 듀얼 EPYC 7742(4x Nvidia Ampere A100 SXM 80GB GPU 포함). 서버 제조업체별 구성에 따라 다른 결과가 나올 수 있습니다. 최신 드라이버의 사용 여부 및 최적화를 포함한 요소에 따라 성능이 달라질 수 있습니다. MI200-74.

- 테스트는 AMD 퍼포먼스 랩 109.0322.22에서 LAMMPS: EAM, LJ, ReaxFF 및 Tersoff를 사용해 두 시스템을 비교하여 수행되었습니다. 2P EPYC™ 7763 기반 서버(4x AMD Instinct™ MI250(128GB HBM2e) 560W GPU 포함), ROCm 5.2.0, LAMMPS 컨테이너 2021.5.14_121amdih/LAMMPS:2022.5.04_130 vs. Nvidia의 공개 클레임 http://web.archive.org/web/20220718053400/https://developer.nvidia.com/hpc-application-performance (안정적인 2022년 6월 23일 업데이트 1). 서버 제조업체별 구성에 따라 다른 결과가 나올 수 있습니다. 최신 드라이버의 사용 여부 및 최적화에 따라 성능이 달라질 수 있습니다. MI200-77.

- 테스트는 2022년 9월 13일 기준 AMD 퍼포먼스 랩에서 다음을 사용하여 수행되었습니다. NAMD: STMV_NVE, APOA1_NVE 두 시스템 비교: 2P EPYC™ 7763 기반 서버 및 AMD Infinity Fabric™ 기술이 적용된 1x, 2x, 4x AMD Instinct™ MI250(128GB HBM2e) 560W GPU, ROCm 5.2.0, NAMD 컨테이너 namd3:3.0a9 vs. 2P EPYC 7742 서버 및 1x, 2x, 4x Nvidia Ampere A100 80GB SXM GPU 성능에 대한 Nvidia의 공개 클레임 https://developer.nvidia.com/hpc-application-performance. (v2.15a, AVX-512). 서버 제조업체별 구성에 따라 다른 결과가 나올 수 있습니다. 최신 드라이버의 사용 여부 및 최적화에 따라 성능이 달라질 수 있습니다. MI200-76.

- 테스트는 2022년 11월 14일 AMD 퍼포먼스 랩에서 AMD Infinity Fabric™ 기술이 활성화된 8x AMD Instinct™ MI210 GPU(PCIe® 64GB, 300W) 탑재 2P 소켓 AMD EPYC™ 7763 CPU Supermicro 4124에 대해 수행되었습니다. Ubuntu 18.04.6 LTS, Host ROCm 5.2.0, rocHPL 6.0.0. 결과는 5회 실행의 중간값으로 계산되었으며, 테스트는 AMD 퍼포먼스에서 2P 소켓 AMD EPYC™ 7763 Supermicro 4124(8x NVIDIA A100 GPU(PCIe 80GB 300W), Ubuntu 18.04.6 LTS, CUDA 11.6, HPL Nvidia 컨테이너 이미지 21.4-HPL 포함)에 대해 수행되었습니다. 모든 결과는 8개의 GPU, 4방향 Infinity Fabric™ 링크 브리지로 연결된 2쌍의 4xMI210 GPU, 2방향 NVLink 브리지로 연결된 4쌍의 2xA100 80GB PCIe GPU로 구성된 시스템에서 측정되었습니다. HPL에 대한 정보: https://www.netlib.org/benchmark/hpl/. AMD HPL 컨테이너 세부사항: HPL 컨테이너는 아직 Infinity Hub에서 사용할 수 없습니다. Nvidia HPL 컨테이너 세부사항: https://ngc.nvidia.com/catalog/containers/nvidia:hpc-benchmarks. 서버 제조업체별 구성에 따라 다른 결과가 나올 수 있습니다. 최신 드라이버의 사용 여부 및 최적화에 따라 성능이 달라질 수 있습니다. MI200-49A.

- HPL-AI 비교는 2022년 11월 2일 기준, 호스트 ROCm 5.2.0을 실행하는 Infinity Fabric 기술이 적용된 8x MI210 64MB HBM2e가 탑재된 2x EPYC 7763이 있는 서버, HPL-AI-AMD v1.0.0(AMD HPL-AI 컨테이너(아직 Infinity Hub에서 사용할 수 없음))과 CUDA 11.6,을 실행하는 8x A100 PCIe 80GB HBM2e가 탑재된 2x EPYC 7763이 있는 서버, HPL-AI-NVIDIA v2.0.0(컨테이너 nvcr.io/nvidia/hpc-benchmarks:21.4-hpl)을 비교 사용하여 HPL-AI 벤치마크 성능(TFLOPS)을 측정한 AMD 내부 테스트에 기초했습니다. 서버 제조업체별 구성에 따라 다른 결과가 나올 수 있습니다. 최신 드라이버의 사용 여부 및 최적화에 따라 성능이 달라질 수 있습니다. MI200-83.

- 테스트는 2022년 10월 3일 기준 다음을 사용하여 AMD 퍼포먼스 랩에서 수행되었습니다. 2P 소켓 AMD EPYC™ 7763 CPU Supermicro 4124 및 AMD Infinity Fabric™ 기술이 적용된 4x 및 8x AMD Instinct™ MI210 GPU(PCIe® 64GB, 300W) 기반. SBIOS2.2, Ubuntu® 18.04.6 LTS, host ROCm™ 5.2.0. LAMMPS 컨테이너 amdih-2022.5.04_130(ROCm 5.1) vs - 4x 및 8x A100 PCIe 80GB GPU에 대한 Nvidia의 공개 클레임 http://web.archive.org/web/20220718053400/https://developer.nvidia.com/hpc-application-performance. 서버 제조업체별 구성에 따라 다른 결과가 나올 수 있습니다. 최신 드라이버의 사용 여부 및 최적화에 따라 성능이 달라질 수 있습니다. MI200-47A.