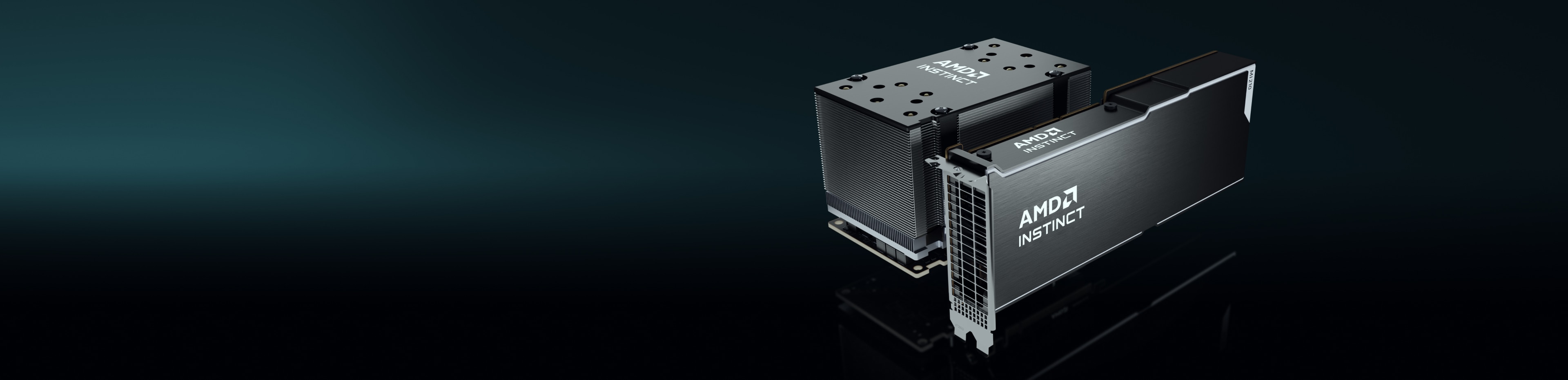

背後的秘密

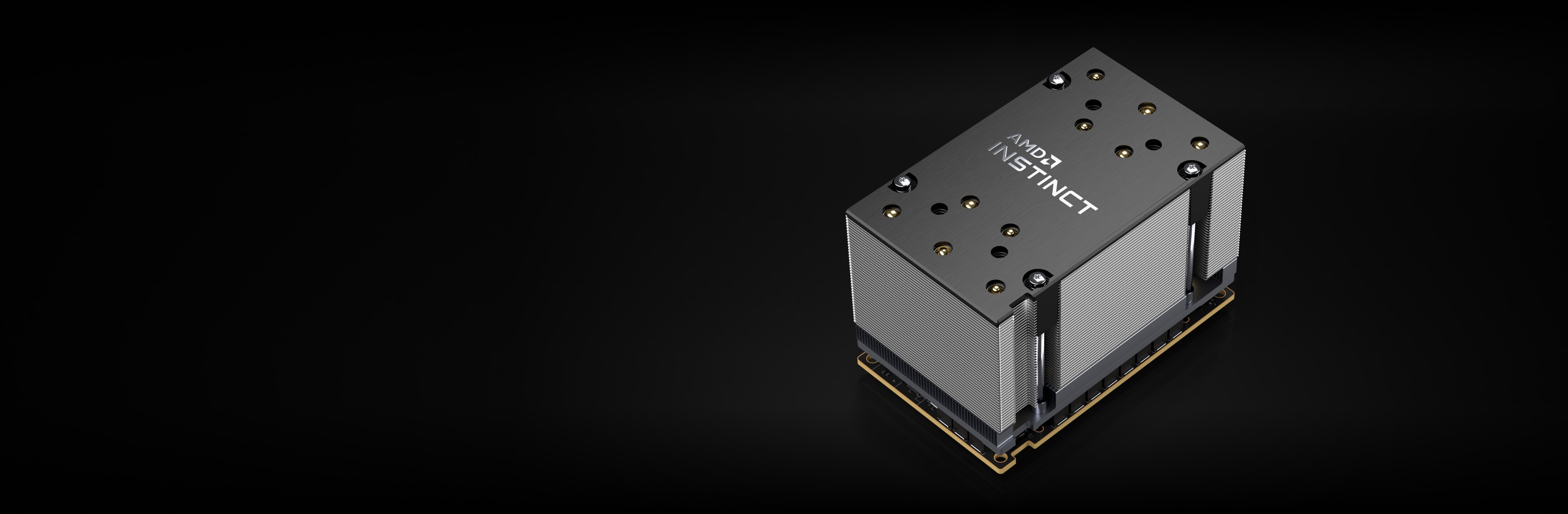

AMD Instinct 加速器採用 AMD CDNA™ 架構,可提供矩陣核心技術,並支援多種精準功能,從高效率的 INT8 與 FP8,到對 HPC 需求最高的 FP64,都包含在內。

AMD Instinct MI250X 加速器

AMD Instinct MI250X 加速器能驅動全球頂尖的超級電腦。

220 個 CU

220 個顯示卡運算單元

128 GB

128 GB HBM2e 記憶體

3.2 TB/s

3.2 TB/s 峰值記憶體頻寬

400 GB/s

400 GB/s 峰值總計 Infinity Fabric

規格比較

高達 383 TFLOPS 峰值理論半精度 (FP16) 效能,比其他適用於需求最大 AI 工作負載的競爭顯示卡多出高達 1.6 倍的記憶體容量和頻寬2、3、4

MI250X

A100

比競爭的顯示卡提供多達 4 倍的優勢,可提供高達 47.9 TFLOPs FP64 和高達 95.7 TFLOPs FP64 矩陣峰值理論效能。2

MI250X

A100

*TF32 資料格式不符合 IEEE 標準,因此不包括在此比較中。

AMD Instinct MI250 加速器

AMD Instinct MI250 加速器為企業、研究和學術相關使用案例帶來優異的 HPC 和 AI 效能。

208 個 CU

208 個顯示卡運算單元

128 GB

128 GB HBM2e 記憶體

3.2 TB/s

3.2 TB/s 峰值記憶體頻寬

100 GB/s

100 GB/s 峰值 Infinity Fabric™ 連結頻寬

效能基準測試

HPCG 3.0:高效能共軛梯度 (High Performance Conjugate Gradients, HPCG) 基準測試是 HPC 系統排名的指標。HPCG 意在輔助高效能 LINPACK (HPL) 基準測試,目前用於排序前 500 名的運算系統。5

指標 |

1xMI250 |

2xMI250 |

4xMI250 |

GFLOPS |

488.8 |

972.6 |

1927.7 |

HPL:HPL 是高效能 Linpack 基準測試實作。此程式碼使用標準作業計數公式,解出均勻的隨機線性方程式系統,並回報時間和浮點執行率。6

指標 |

1xMI250 |

2xMI250 |

4xMI250 |

TFLOPS |

40.45 |

80.666 |

161.97 |

針對加速器內省技術開發的高效能 LINPACK (High Performance LINPACK for Accelerator Introspection, HPL-AI) 是一種基準測試,強調透過使用新穎的混合精度演算法來解出線性方程式系統,以聚合 HPC 與 AI 工作負載。7

指標 |

測試模組 |

4xMI250 |

TFLOPS |

混合 FP16/32/64 |

930.44 |

PyFR 是以 Python 為基礎的開放原始碼框架,運用 Huynh 的通量重建方法,解決串流架構中移流擴散類型的問題。此框架經專門設計,可解決包含多種不同元素類型的混合非結構性網格上出現各式管理系統的狀況。8

指標 |

測試模組 |

1xMI250 |

模擬/天 |

TGV |

41.73 |

開放原始碼現場運作與處理軟體 (Open-source Field Operation And Manipulation, OpenFOAM) 是一款 C++ 工具包,用於開發自訂數字求解器,以及解決連續性機械問題的前/後處理公用程式,主要包括運算流體動力學 (CFD)。9

指標 |

測試模組 |

1xMI250 |

2xMI250 |

4xMI250 |

時間(秒) |

HPC Motorbike(大不見得好) |

662.3 |

364.26 |

209.84 |

Amber 是一組生物分子模擬程式。「Amber」一詞可指兩種事物。一為用於模擬生物分子的分子機械力場組,二為包含原始碼和展示的分子模擬程式套件。10

應用程式 |

指標 |

測試模組 |

越大越好 |

1xMI250 |

AMBER |

ns/天 |

Cellulose Production NPT 4fs |

是 |

227.2 |

AMBER |

ns/天 |

Cellulose Production NVE 4fs |

是 |

242.4 |

AMBER |

ns/天 |

FactorIX Production NPT 4fs |

是 |

803.1 |

AMBER |

ns/天 |

FactorIX Production NVE 4fs |

是 |

855.2 |

AMBER |

ns/天 |

JAC Production NPT 4fs |

是 |

1794 |

AMBER |

ns/天 |

JAC Production NVE 4fs |

是 |

1871 |

AMBER |

ns/天 |

STMV Production NPT 4fs |

是 |

80.65 |

AMBER |

ns/天 |

STMV Production NVE 4fs |

是 |

86.7 |

GROMACS 是分子動力學套件,主要為模擬蛋白質、脂質和核酸而設計。 GROMACS 原本由格羅寧根大學 (University of Groningen) 生物物理化學系所開發,現由全球大學和研究中心的貢獻者進行維護。11

應用程式 |

指標 |

測試模組 |

越大越好 |

1xMI250 |

2xMI250 |

4xMI250 |

GROMACS |

ns/天 |

STMV |

是 |

34.2 |

61.812 |

89.26 |

LAMMPS 是古典分子動力學程式碼,著重於材料建模。 LAMMPS 是 Large-scale Atomic/Molecular Massively Parallel Simulator (大尺度原子/分子並行模擬工具) 的縮寫,在固態材料(金屬、半導體)、軟質物質(生物分子、聚合物)以及粗粒或介觀系統方面都頗具潛力。12

應用程式 |

指標 |

測試模組 |

越大越好 |

1xMI250 |

2xMI250 |

4xMI250 |

LAMMPS |

Atom-Time 步/秒 |

LJ |

是 |

6E+08 |

1E+09 |

2E+09 |

LAMMPS |

Atom-Time 步/秒 |

ReaxFF |

是 |

7E+06 |

1E+07 |

3E+07 |

LAMMPS |

Atom-Time 步/秒 |

Tersoff |

是 |

5E+08 |

1E+09 |

2E+09 |

NAMD 是分子動力學套件,針對模擬生物分子隨時間移動的需求而設計。NAMD 適用於大型生物分子系統,且可用來模擬含有超過 10 億個原子的系統,為成千上萬的處理器核心和顯示卡提供優異的延展性。13

應用程式 |

指標 |

測試模組 |

越大越好 |

1xMI250 |

2xMI250 |

4xMI250 |

NAMD 3.0 |

ns/天 |

APOA1_NVE |

是 |

221.4 |

443.61 |

879.43 |

NAMD 3.0 |

ns/天 |

STMV_NVE |

是 |

19.87 |

39.545 |

77.132 |

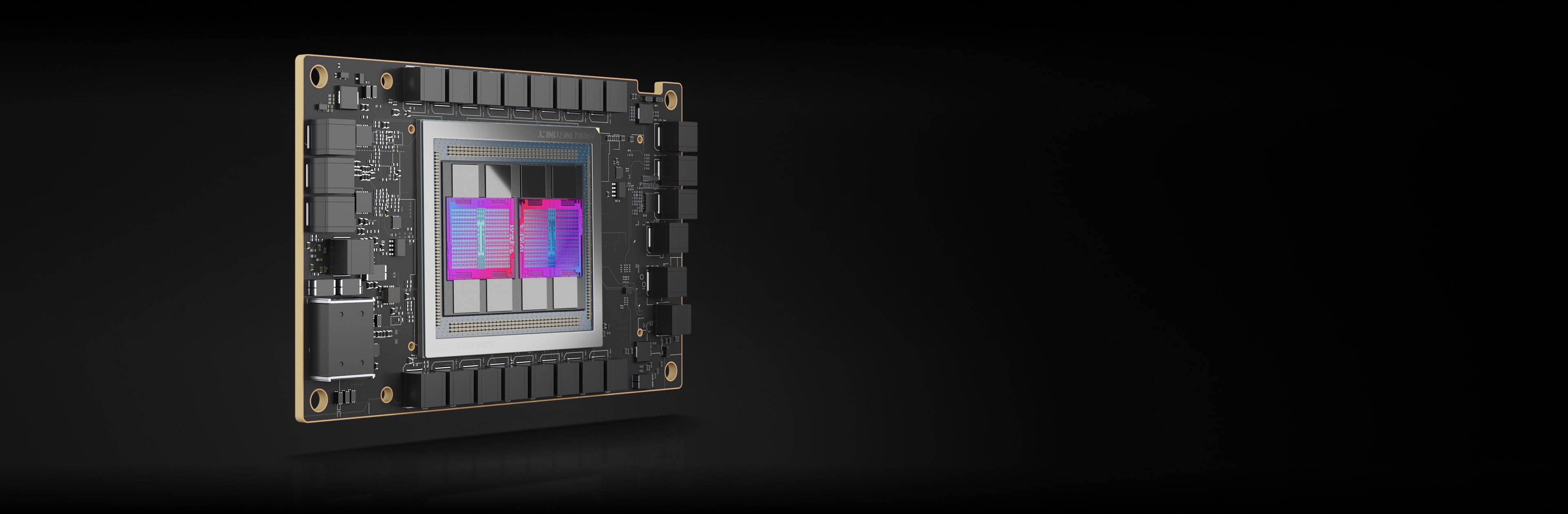

AMD Instinct MI210 加速器

AMD Instinct MI210 加速器為單一伺服器解決方案與更多應用程式驅動企業、研究與學術 HPC 和 AI 工作負載。

104 個 CU

104 個顯示卡運算單元

64 GB

64 GB HBM2e 記憶體

1.6 TB/s

1.6 TB/s 峰值記憶體頻寬

100 GB/s

100 GB/s 峰值 Infinity Fabric™ 連結頻寬

效能基準測試

HPL:HPL 是高效能 Linpack 基準測試實作。此程式碼使用標準作業計數公式,解出均勻的隨機線性方程式系統,並回報時間和浮點執行率。14

指標 |

越大越好 |

1xMI210 |

2xMI210 |

4xMI210 | 8xMI210 |

TFLOPS |

是 |

21.07 |

40.878 |

81.097 | 159.73 |

HPL-AI:針對加速器內省技術開發的高效能 LINPACK (High Performance LINPACK for Accelerator Introspection, HPL-AI) 是一種基準測試,強調透過使用新穎的混合精度演算法來解出線性方程式系統,以聚合 HPC 與 AI 工作負載。15

指標 |

測試模組 |

越大越好 |

4xMI210 |

8xMI210 |

TFLOPS |

混合 FP16/32/64 |

是 |

444.77 |

976.18 |

LAMMPS:LAMMPS 是古典分子動力學程式碼,著重於材料建模。LAMMPS 是 Large-scale Atomic/Molecular Massively Parallel Simulator (大尺度原子/分子並行模擬工具) 的縮寫,在固態材料(金屬、半導體)、軟質物質(生物分子、聚合物)以及粗粒或介觀系統方面都頗具潛力。16

指標 |

測試模組 |

越大越好 |

4xMI210 | 8xMI210 |

Atom-Time 步/秒 |

ReaxFF |

是 |

1E+07 | 3E+07 |

掌握最新動態

註冊以收到最新的資料中心消息和伺服器內容。

尾註

- 500 大排行榜,2023 年 6 月

- 世界上最快的資料中心顯示卡是 AMD Instinct™ MI250X。AMD 效能實驗室於 2021 年 9 月 15 日前對 1,700 MHz 峰值提升引擎時脈下的 AMD Instinct™ MI250X(128GB HBM2e OAM 模組)加速器進行的計算,計算結果為 95.7 TFLOPS 峰值理論雙精度(FP64 矩陣)、47.9 TFLOPS 峰值理論值雙精度 (FP64)、95.7 TFLOPS 峰值理論單精度矩陣(FP32 矩陣)、47.9 TFLOPS 峰值理論單精度 (FP32)、383.0 TFLOPS 峰值理論半精度 (FP16) 和 383.0 TFLOPS 峰值理論 Bfloat16 格式精度 (BF16) 浮點效能。AMD 效能實驗室於 2020 年 9 月 18 日前對 1,502 MHz 峰值提升引擎時脈頻率下的 AMD Instinct™ MI100(32GB HBM2 PCIe® 卡)加速器進行的計算,計算結果為 11.54 TFLOPS 的峰值理論雙精度 (FP64)、46.1 TFLOPS 的峰值理論單精度矩陣 (FP32)、23.1 TFLOPS 的峰值理論單精度 (FP32)、184.6 TFLOPS 的峰值理論半精度 (FP16) 浮點效能。發表的 1410 MHz 提升引擎時脈下的 NVidia Ampere A100 (80GB) 顯示卡加速器的結果:19.5 TFLOPS 峰值雙精度 Tensor 核心(FP64 Tensor 核心)、9.7 TFLOPS 峰值雙精度 (FP64)。19.5 TFLOPS 峰值單精度 (FP32)、78 TFLOPS 峰值半精度 (FP16)、312 TFLOPS 峰值半精度 (FP16 Tensor Flow)、39 TFLOPS 峰值 Bfloat 16 (BF16)、312 TFLOPS 峰值 Bfloat16 格式精度 (BF16 Tensor Flow)、理論浮點效能。 TF32 資料格式不符合 IEEE 標準,因此不包括在此比較中。https://www.nvidia.com/content/dam/en-zz/Solutions/Data-Center/nvidia-ampere-architecture-whitepaper.pdf,第 15 頁,表 1。MI200-01

- AMD 效能實驗室於 2021 年 9 月 21 日在 1,600 MHz 峰值記憶體時脈下,針對採用 AMD CDNA™ 2 6nm FinFet 工藝技術的 AMD Instinct™ MI250X 和 MI250 (128GB HBM2e) OAM 加速器進行的計算,計算結果為 3.2768 TFLOPS 峰值理論記憶體頻寬效能。MI250/MI250X 記憶體匯流排界面為 4,096 位元乘以 2 裸晶,記憶體資料速率為 3.20 Gbps,總記憶體頻寬為 3.2768 TB/s ((3.20 Gbps*(4,096 位元*2))/8)。NVidia Ampere A100 (80GB) SXM 顯示卡加速器的最高已公佈結果為 2.039 TB/s 顯示卡記憶體頻寬效能。https://www.nvidia.com/content/dam/en-zz/Solutions/Data-Center/a100/pdf/nvidia-a100-datasheet-us-nvidia-1758950-r4-web.pdf MI200-07

- AMD 效能實驗室於 2021 年 9 月 21 日在 1,600 MHz 峰值記憶體時脈下,針對採用 AMD CDNA™ 2 6nm FinFet 工藝技術的 AMD Instinct™ MI250X 和 MI250 加速器 (OAM) 進行的計算,計算結果為 128GB HBMe 記憶體容量。已發佈的 NVidia Ampere A100 (80GB) SXM 和 A100 加速器 (PCIe®) 規格顯示記憶體容量為 80GB。結果請參閱:https://www.nvidia.com/content/dam/en-zz/Solutions/Data-Center/a100/pdf/nvidia-a100-datasheet-us-nvidia-1758950-r4-web.pdf MI200-18

- AMD 效能實驗室於 2022 年 11 月 2 日使用 HPCG 3.0 進行測試,比較兩個系統:採用雙路 EPYC™ 7763 驅動的伺服器,停用 SMT,配置 1x、2x 和 4x AMD Instinct™ MI250 (128 GB HBM2e) 560W 顯示卡,SBIOS M12,Ubuntu 20.04.4,主機 ROCm 5.2.0 對比採用雙路 AMD EPYC™ 7742 的伺服器,配置 1x、2x 和 4x Nvidia Ampere A100 80GB SXM 400W 顯示卡,SBIOS 0.34,Ubuntu 20.04.4,CUDA 11.6。 HPCG 3.0 容器:nvcr.io/nvidia/hpc-benchmarks:21.4-hpcg at https://catalog.ngc.nvidia.com/orgs/nvidia/containers/hpc-benchmarks。伺服器製造商可能會改變配置,而得到不同的結果。效能可能會因使用了最新驅動程式及最佳化而不同。MI200-70A。

- AMD 效能實驗室於 2022 年 11 月 14 日使用 HPL 進行測試,比較兩個系統。採用雙路 EPYC™ 7763 的伺服器、停用 SMT、配置 1x、2x 和 4x AMD Instinct™ MI250 (128 GB HBM2e) 560W 顯示卡,主機 ROCm 5.2.0 rocHPL6.0.0。Infinity Hub 上尚無法使用 AMD HPL 容器。對比採用雙路 AMD EPYC™ 7742 的伺服器,啟用 SMT,配置 1x、2x 和 4x Nvidia Ampere A100 80GB SXM 400W 顯示卡,CUDA 11.6,以及驅動程式版本 510.47.03。HPL 容器 (nvcr.io/nvidia/hpc-benchmarks:21.4-hpl),獲自 https://catalog.ngc.nvidia.com/orgs/nvidia/containers/hpc-benchmarks。伺服器製造商可能會改變配置,而得到不同的結果。效能可能會因使用了最新驅動程式及最佳化而不同。MI200-69A。

- HPL-AI 比較是根據 AMD 於 2022 年 11 月 2 日進行的內部測試,測量 HPL-AI 基準測試效能 (TFLOPS),使用搭載 2x EPYC 7763 與 4x MI250 128MB HBM2e 的伺服器,運行主機 ROCm 5.2.0,HPL-AI-AMD v1.0.0,對比採用 2x EPYC 7742 的伺服器,配置 4x A100 SXM 80GB HBM2e,運行 CUDA 11.6,HPL-AI-NVIDIA v2.0.0,容器 nvcr.io/nvidia/hpc-benchmarks:21.4-hpl。伺服器製造商可能會改變配置,而得到不同的結果。效能可能會因使用了最新驅動程式及最佳化而不同。MI200-81。

- AMD 效能實驗室於 2022 年 11 月 25 日使用 PyFR TGV 和 NACA 0021 進行測試,比較兩個系統:採用雙路 EPYC™ 7763 驅動的伺服器,停用 SMT,配置 1x AMD Instinct™ MI250 (128 GB HBM2e) 560W 顯示卡,SBIOS M12,Ubuntu 20.04.4,主機 ROCm 5.2.0 對比採用雙路 AMD EPYC™ 7742 的伺服器,啟用 SMT,配置 1x Nvidia Ampere A100 80GB SXM 400W 顯示卡,SBIOS 0.34,Ubuntu 20.04.4,CUDA 11.6。 伺服器製造商可能會改變配置,而得到不同的結果。效能可能會因使用了最新驅動程式及最佳化而不同。MI200-82。

- AMD 效能實驗室於 2023 年 4 月 14 日使用 OpenFOAM v2206 進行測試,針對雙路 EPYC 7763 處理器產品伺服器,配置 1x、2x 和 4x AMD Instinct™ MI250 顯示卡 (128GB, 560W),啟用 AMD Infinity Fabric™ 技術,ROCm™5.3.3,Ubuntu® 20.04.4,對比雙路 EPYC 7742 處理器產品伺服器,配置 1x、2x 和 4x Nvidia A100 80GB SXM 顯示卡 (400W),啟用 NVLink 技術,CUDA®11.8,Ubuntu 20.04.4。伺服器製造商可能會改變配置,而得到不同的結果。效能可能會因使用了最新驅動程式及最佳化而不同。

- 測試由 AMD 效能實驗室於 2022 年 8 月 26 日使用 AMBER 進行:Cellulose_production_NPT_4fs、Cellulose_production_NVE_4fs、FactorIX_production_NPT_4fs、FactorIX_production_NVE_4fs、STMV_production_NPT_4fs、STMV_production_NVE_4fs、JAC_production_NPT_4fs 和 JAC production_NVE_4fs。比較兩個系統:採用雙路 EPYC™ 7763 驅動的伺服器,搭載 1x AMD Instinct™ MI250 (128GB HBM2e) 560W 顯示卡,ROCm 5.2.0,Amber 容器 22.amd_100,對比採用雙路 EPYC™ 7742 驅動的伺服器,搭載 1x Nvidia A100 SXM (80GB HBM2e) 400W 顯示卡,啟用 MPS (2 個實例),CUDA 11.6。 MI200-73。

- AMD 效能實驗室於 2022 年 10 月 18 日使用 Gromacs STMV 進行測試,比較兩個系統:採用雙路 EPYC™ 7763 的伺服器,配置具備 Infinity Fabric™ 技術的 4x AMD Instinct™ MI250 (128GB HBM2e) 560W 顯示卡,ROCm™ 5.2.0,Gromacs 容器 2022.3.amd1_174,對比 Nvidia 公開聲明 https://developer.nvidia.com/hpc-application-performance。 (Gromacs 2022.2)。雙 EPYC 7742 配置 4x Nvidia Ampere A100 SXM 80GB 顯示卡。伺服器製造商可能會改變配置,而得到不同的結果。效能可能會因使用了最新驅動程式及最佳化等因素而有所不同。MI200-74。

- 測試由 AMD 效能實驗室於 2022 年 10 月 3 日使用 LAMMPS 進行:EAM、LJ、ReaxFF 和 Termsoff 比較兩個系統:採用雙路 EPYC™ 7763 驅動的伺服器,配置 4x AMD Instinct™ MI250 (128GB HBM2e) 560W 顯示卡,ROCm 5.2.0,LAMMPS 容器 2021.5.14_121amdih/lammps:2022.5.04_130,對比 Nvidia 公開聲明 http://web.archive.org/web/20220718053400/https://developer.nvidia.com/hpc-application-performance。(2022 年 6 月 23 日穩定更新版本 1)。伺服器製造商可能會改變配置,而得到不同的結果。效能可能會因使用了最新驅動程式及最佳化而不同。MI200-77。

- 測試由 AMD 效能實驗室於 2022 年 9 月 13 日使用 NAMD 進行:STMV_NVE 和 APOA1_NVE 比較兩個系統:採用雙路 EPYC™ 7763 的伺服器,配置 AMD Infinity Fabric™ 技術的 1x、2x 和 4x AMD Instinct™ MI250 (128GB HBM2e) 560W 顯示卡 560W 顯示卡,NAMD 容器 namd3:3.0a9 對比 Nvidia 採用雙路 EPYC 7742 的伺服器,配置 1x、2x 和 4x Nvidia Ampere A100 80GB SXM 顯示卡的 NVIDIA 公開效能聲明 https://developer.nvidia.com/hpc-application-performance。(v2.15a AVX-512)。伺服器製造商可能會改變配置,而得到不同的結果。效能可能會因使用了最新驅動程式及最佳化而不同。MI200-76。

- AMD 效能實驗室於 2022 年 11 月 14 日對雙路插槽 AMD EPYC™ 7763 處理器 Supermicro 4124 進行測試,其配置為 8x AMD Instinct™ MI210 顯示卡 (PCIe® 64GB 300W),啟用 AMD Infinity Fabric™ 技術。Ubuntu 18.04.6 LTS,主機 ROCm 5.2.0,rocHPL 6.0.0。使用五次運行的中位數計算的結果,對比 AMD 效能實驗室對雙路插槽 AMD EPYC™ 7763 Supermicro 4124 進行測試,其配置為 8x NVIDIA A100 顯示卡 (PCIe 80GB 300W),Ubuntu 18.04.6 LTS,CUDA 11.6,HPL Nvidia 容器映像 21.4-HPL。所有結果皆在配置 8 張顯示卡的系統上測量;2 對 4xMI210 顯示卡,由 4 路 Infinity Fabric™ 連結橋連接;4 對 2xA100 80GB PCIe 顯示卡,由 2 路 NVLink 橋接器連接。HPL 相關資訊:https://www.netlib.org/benchmark/hpl/。 AMD HPL 容器詳情:Infinity Hub 上尚無法使用 HPL 容器。Nvidia HPL 容器詳情:https://ngc.nvidia.com/catalog/containers/nvidia:hpc-benchmarks。 伺服器製造商可能會改變配置,而得到不同的結果。效能可能會因使用了最新驅動程式及最佳化而不同。MI200-49A。

- HPL-AI 比較是比較是根據 AMD 於 2022 年 11 月 2 日進行的內部測試,測量 HPL-AI 基準測試效能 (TFLOPS),使用搭載 2x EPYC 7763 與具備 Infinity Fabric 技術之 8x MI210 64MB HBM2e 的伺服器,運行主機 ROCm 5.2.0,HPL-AI-AMD v1.0.0,Infinity Hub 上尚無法使用 AMD HPL-AI 容器。對比採用 2x EPYC 7763 的伺服器,配置 8x A100 PCIe 80GB HBM2e,運行 CUDA 11.6,HPL-AI-NVIDIA v2.0.0,容器 nvcr.io/nvidia/hpc-benchmarks:21.4-hpl。伺服器製造商可能會改變配置,而得到不同的結果。效能可能會因使用了最新驅動程式及最佳化而不同。MI200-83。

- AMD 效能實驗室於 2022 年 10 月 3 日 對雙路插槽 AMD EPYC™ 7763 處理器 Supermicro 4124 進行測試,其配置為 4x 和 8x AMD Instinct™ MI210 顯示卡 (PCIe® 64GB 300W),啟用 AMD Infinity Fabric™ 技術。SBIOS2.2,Ubuntu® 18.04.6 LTS,主機 ROCm™ 5.2.0。LAMMPS 容器 amdih-2022.5.04_130 (ROCm 5.1) 對比 Nvidia 對 4x 和 8x A100 PCIe 80GB 顯示卡的公開聲明 http://web.archive.org/web/20220718053400/https://developer.nvidia.com/hpc-application-performance。伺服器製造商可能會改變配置,而得到不同的結果。效能可能會因使用了最新驅動程式及最佳化而不同。MI200-47A。

- 500 大排行榜,2023 年 6 月

- 世界上最快的資料中心顯示卡是 AMD Instinct™ MI250X。AMD 效能實驗室於 2021 年 9 月 15 日前對 1,700 MHz 峰值提升引擎時脈下的 AMD Instinct™ MI250X(128GB HBM2e OAM 模組)加速器進行的計算,計算結果為 95.7 TFLOPS 峰值理論雙精度(FP64 矩陣)、47.9 TFLOPS 峰值理論值雙精度 (FP64)、95.7 TFLOPS 峰值理論單精度矩陣(FP32 矩陣)、47.9 TFLOPS 峰值理論單精度 (FP32)、383.0 TFLOPS 峰值理論半精度 (FP16) 和 383.0 TFLOPS 峰值理論 Bfloat16 格式精度 (BF16) 浮點效能。AMD 效能實驗室於 2020 年 9 月 18 日前對 1,502 MHz 峰值提升引擎時脈頻率下的 AMD Instinct™ MI100(32GB HBM2 PCIe® 卡)加速器進行的計算,計算結果為 11.54 TFLOPS 的峰值理論雙精度 (FP64)、46.1 TFLOPS 的峰值理論單精度矩陣 (FP32)、23.1 TFLOPS 的峰值理論單精度 (FP32)、184.6 TFLOPS 的峰值理論半精度 (FP16) 浮點效能。發表的 1410 MHz 提升引擎時脈下的 NVidia Ampere A100 (80GB) 顯示卡加速器的結果:19.5 TFLOPS 峰值雙精度 Tensor 核心(FP64 Tensor 核心)、9.7 TFLOPS 峰值雙精度 (FP64)。19.5 TFLOPS 峰值單精度 (FP32)、78 TFLOPS 峰值半精度 (FP16)、312 TFLOPS 峰值半精度 (FP16 Tensor Flow)、39 TFLOPS 峰值 Bfloat 16 (BF16)、312 TFLOPS 峰值 Bfloat16 格式精度 (BF16 Tensor Flow)、理論浮點效能。 TF32 資料格式不符合 IEEE 標準,因此不包括在此比較中。https://www.nvidia.com/content/dam/en-zz/Solutions/Data-Center/nvidia-ampere-architecture-whitepaper.pdf,第 15 頁,表 1。MI200-01

- AMD 效能實驗室於 2021 年 9 月 21 日在 1,600 MHz 峰值記憶體時脈下,針對採用 AMD CDNA™ 2 6nm FinFet 工藝技術的 AMD Instinct™ MI250X 和 MI250 (128GB HBM2e) OAM 加速器進行的計算,計算結果為 3.2768 TFLOPS 峰值理論記憶體頻寬效能。MI250/MI250X 記憶體匯流排界面為 4,096 位元乘以 2 裸晶,記憶體資料速率為 3.20 Gbps,總記憶體頻寬為 3.2768 TB/s ((3.20 Gbps*(4,096 位元*2))/8)。NVidia Ampere A100 (80GB) SXM 顯示卡加速器的最高已公佈結果為 2.039 TB/s 顯示卡記憶體頻寬效能。https://www.nvidia.com/content/dam/en-zz/Solutions/Data-Center/a100/pdf/nvidia-a100-datasheet-us-nvidia-1758950-r4-web.pdf MI200-07

- AMD 效能實驗室於 2021 年 9 月 21 日在 1,600 MHz 峰值記憶體時脈下,針對採用 AMD CDNA™ 2 6nm FinFet 工藝技術的 AMD Instinct™ MI250X 和 MI250 加速器 (OAM) 進行的計算,計算結果為 128GB HBMe 記憶體容量。已發佈的 NVidia Ampere A100 (80GB) SXM 和 A100 加速器 (PCIe®) 規格顯示記憶體容量為 80GB。結果請參閱:https://www.nvidia.com/content/dam/en-zz/Solutions/Data-Center/a100/pdf/nvidia-a100-datasheet-us-nvidia-1758950-r4-web.pdf MI200-18

- AMD 效能實驗室於 2022 年 11 月 2 日使用 HPCG 3.0 進行測試,比較兩個系統:採用雙路 EPYC™ 7763 驅動的伺服器,停用 SMT,配置 1x、2x 和 4x AMD Instinct™ MI250 (128 GB HBM2e) 560W 顯示卡,SBIOS M12,Ubuntu 20.04.4,主機 ROCm 5.2.0 對比採用雙路 AMD EPYC™ 7742 的伺服器,配置 1x、2x 和 4x Nvidia Ampere A100 80GB SXM 400W 顯示卡,SBIOS 0.34,Ubuntu 20.04.4,CUDA 11.6。 HPCG 3.0 容器:nvcr.io/nvidia/hpc-benchmarks:21.4-hpcg at https://catalog.ngc.nvidia.com/orgs/nvidia/containers/hpc-benchmarks。伺服器製造商可能會改變配置,而得到不同的結果。效能可能會因使用了最新驅動程式及最佳化而不同。MI200-70A。

- AMD 效能實驗室於 2022 年 11 月 14 日使用 HPL 進行測試,比較兩個系統。採用雙路 EPYC™ 7763 的伺服器、停用 SMT、配置 1x、2x 和 4x AMD Instinct™ MI250 (128 GB HBM2e) 560W 顯示卡,主機 ROCm 5.2.0 rocHPL6.0.0。Infinity Hub 上尚無法使用 AMD HPL 容器。對比採用雙路 AMD EPYC™ 7742 的伺服器,啟用 SMT,配置 1x、2x 和 4x Nvidia Ampere A100 80GB SXM 400W 顯示卡,CUDA 11.6,以及驅動程式版本 510.47.03。HPL 容器 (nvcr.io/nvidia/hpc-benchmarks:21.4-hpl),獲自 https://catalog.ngc.nvidia.com/orgs/nvidia/containers/hpc-benchmarks。伺服器製造商可能會改變配置,而得到不同的結果。效能可能會因使用了最新驅動程式及最佳化而不同。MI200-69A。

- HPL-AI 比較是根據 AMD 於 2022 年 11 月 2 日進行的內部測試,測量 HPL-AI 基準測試效能 (TFLOPS),使用搭載 2x EPYC 7763 與 4x MI250 128MB HBM2e 的伺服器,運行主機 ROCm 5.2.0,HPL-AI-AMD v1.0.0,對比採用 2x EPYC 7742 的伺服器,配置 4x A100 SXM 80GB HBM2e,運行 CUDA 11.6,HPL-AI-NVIDIA v2.0.0,容器 nvcr.io/nvidia/hpc-benchmarks:21.4-hpl。伺服器製造商可能會改變配置,而得到不同的結果。效能可能會因使用了最新驅動程式及最佳化而不同。MI200-81。

- AMD 效能實驗室於 2022 年 11 月 25 日使用 PyFR TGV 和 NACA 0021 進行測試,比較兩個系統:採用雙路 EPYC™ 7763 驅動的伺服器,停用 SMT,配置 1x AMD Instinct™ MI250 (128 GB HBM2e) 560W 顯示卡,SBIOS M12,Ubuntu 20.04.4,主機 ROCm 5.2.0 對比採用雙路 AMD EPYC™ 7742 的伺服器,啟用 SMT,配置 1x Nvidia Ampere A100 80GB SXM 400W 顯示卡,SBIOS 0.34,Ubuntu 20.04.4,CUDA 11.6。 伺服器製造商可能會改變配置,而得到不同的結果。效能可能會因使用了最新驅動程式及最佳化而不同。MI200-82。

- AMD 效能實驗室於 2023 年 4 月 14 日使用 OpenFOAM v2206 進行測試,針對雙路 EPYC 7763 處理器產品伺服器,配置 1x、2x 和 4x AMD Instinct™ MI250 顯示卡 (128GB, 560W),啟用 AMD Infinity Fabric™ 技術,ROCm™5.3.3,Ubuntu® 20.04.4,對比雙路 EPYC 7742 處理器產品伺服器,配置 1x、2x 和 4x Nvidia A100 80GB SXM 顯示卡 (400W),啟用 NVLink 技術,CUDA®11.8,Ubuntu 20.04.4。伺服器製造商可能會改變配置,而得到不同的結果。效能可能會因使用了最新驅動程式及最佳化而不同。

- 測試由 AMD 效能實驗室於 2022 年 8 月 26 日使用 AMBER 進行:Cellulose_production_NPT_4fs、Cellulose_production_NVE_4fs、FactorIX_production_NPT_4fs、FactorIX_production_NVE_4fs、STMV_production_NPT_4fs、STMV_production_NVE_4fs、JAC_production_NPT_4fs 和 JAC production_NVE_4fs。比較兩個系統:採用雙路 EPYC™ 7763 驅動的伺服器,搭載 1x AMD Instinct™ MI250 (128GB HBM2e) 560W 顯示卡,ROCm 5.2.0,Amber 容器 22.amd_100,對比採用雙路 EPYC™ 7742 驅動的伺服器,搭載 1x Nvidia A100 SXM (80GB HBM2e) 400W 顯示卡,啟用 MPS (2 個實例),CUDA 11.6。 MI200-73。

- AMD 效能實驗室於 2022 年 10 月 18 日使用 Gromacs STMV 進行測試,比較兩個系統:採用雙路 EPYC™ 7763 的伺服器,配置具備 Infinity Fabric™ 技術的 4x AMD Instinct™ MI250 (128GB HBM2e) 560W 顯示卡,ROCm™ 5.2.0,Gromacs 容器 2022.3.amd1_174,對比 Nvidia 公開聲明 https://developer.nvidia.com/hpc-application-performance。 (Gromacs 2022.2)。雙 EPYC 7742 配置 4x Nvidia Ampere A100 SXM 80GB 顯示卡。伺服器製造商可能會改變配置,而得到不同的結果。效能可能會因使用了最新驅動程式及最佳化等因素而有所不同。MI200-74。

- 測試由 AMD 效能實驗室於 2022 年 10 月 3 日使用 LAMMPS 進行:EAM、LJ、ReaxFF 和 Termsoff 比較兩個系統:採用雙路 EPYC™ 7763 驅動的伺服器,配置 4x AMD Instinct™ MI250 (128GB HBM2e) 560W 顯示卡,ROCm 5.2.0,LAMMPS 容器 2021.5.14_121amdih/lammps:2022.5.04_130,對比 Nvidia 公開聲明 http://web.archive.org/web/20220718053400/https://developer.nvidia.com/hpc-application-performance。(2022 年 6 月 23 日穩定更新版本 1)。伺服器製造商可能會改變配置,而得到不同的結果。效能可能會因使用了最新驅動程式及最佳化而不同。MI200-77。

- 測試由 AMD 效能實驗室於 2022 年 9 月 13 日使用 NAMD 進行:STMV_NVE 和 APOA1_NVE 比較兩個系統:採用雙路 EPYC™ 7763 的伺服器,配置 AMD Infinity Fabric™ 技術的 1x、2x 和 4x AMD Instinct™ MI250 (128GB HBM2e) 560W 顯示卡 560W 顯示卡,NAMD 容器 namd3:3.0a9 對比 Nvidia 採用雙路 EPYC 7742 的伺服器,配置 1x、2x 和 4x Nvidia Ampere A100 80GB SXM 顯示卡的 NVIDIA 公開效能聲明 https://developer.nvidia.com/hpc-application-performance。(v2.15a AVX-512)。伺服器製造商可能會改變配置,而得到不同的結果。效能可能會因使用了最新驅動程式及最佳化而不同。MI200-76。

- AMD 效能實驗室於 2022 年 11 月 14 日對雙路插槽 AMD EPYC™ 7763 處理器 Supermicro 4124 進行測試,其配置為 8x AMD Instinct™ MI210 顯示卡 (PCIe® 64GB 300W),啟用 AMD Infinity Fabric™ 技術。Ubuntu 18.04.6 LTS,主機 ROCm 5.2.0,rocHPL 6.0.0。使用五次運行的中位數計算的結果,對比 AMD 效能實驗室對雙路插槽 AMD EPYC™ 7763 Supermicro 4124 進行測試,其配置為 8x NVIDIA A100 顯示卡 (PCIe 80GB 300W),Ubuntu 18.04.6 LTS,CUDA 11.6,HPL Nvidia 容器映像 21.4-HPL。所有結果皆在配置 8 張顯示卡的系統上測量;2 對 4xMI210 顯示卡,由 4 路 Infinity Fabric™ 連結橋連接;4 對 2xA100 80GB PCIe 顯示卡,由 2 路 NVLink 橋接器連接。HPL 相關資訊:https://www.netlib.org/benchmark/hpl/。 AMD HPL 容器詳情:Infinity Hub 上尚無法使用 HPL 容器。Nvidia HPL 容器詳情:https://ngc.nvidia.com/catalog/containers/nvidia:hpc-benchmarks。 伺服器製造商可能會改變配置,而得到不同的結果。效能可能會因使用了最新驅動程式及最佳化而不同。MI200-49A。

- HPL-AI 比較是比較是根據 AMD 於 2022 年 11 月 2 日進行的內部測試,測量 HPL-AI 基準測試效能 (TFLOPS),使用搭載 2x EPYC 7763 與具備 Infinity Fabric 技術之 8x MI210 64MB HBM2e 的伺服器,運行主機 ROCm 5.2.0,HPL-AI-AMD v1.0.0,Infinity Hub 上尚無法使用 AMD HPL-AI 容器。對比採用 2x EPYC 7763 的伺服器,配置 8x A100 PCIe 80GB HBM2e,運行 CUDA 11.6,HPL-AI-NVIDIA v2.0.0,容器 nvcr.io/nvidia/hpc-benchmarks:21.4-hpl。伺服器製造商可能會改變配置,而得到不同的結果。效能可能會因使用了最新驅動程式及最佳化而不同。MI200-83。

- AMD 效能實驗室於 2022 年 10 月 3 日 對雙路插槽 AMD EPYC™ 7763 處理器 Supermicro 4124 進行測試,其配置為 4x 和 8x AMD Instinct™ MI210 顯示卡 (PCIe® 64GB 300W),啟用 AMD Infinity Fabric™ 技術。SBIOS2.2,Ubuntu® 18.04.6 LTS,主機 ROCm™ 5.2.0。LAMMPS 容器 amdih-2022.5.04_130 (ROCm 5.1) 對比 Nvidia 對 4x 和 8x A100 PCIe 80GB 顯示卡的公開聲明 http://web.archive.org/web/20220718053400/https://developer.nvidia.com/hpc-application-performance。伺服器製造商可能會改變配置,而得到不同的結果。效能可能會因使用了最新驅動程式及最佳化而不同。MI200-47A。