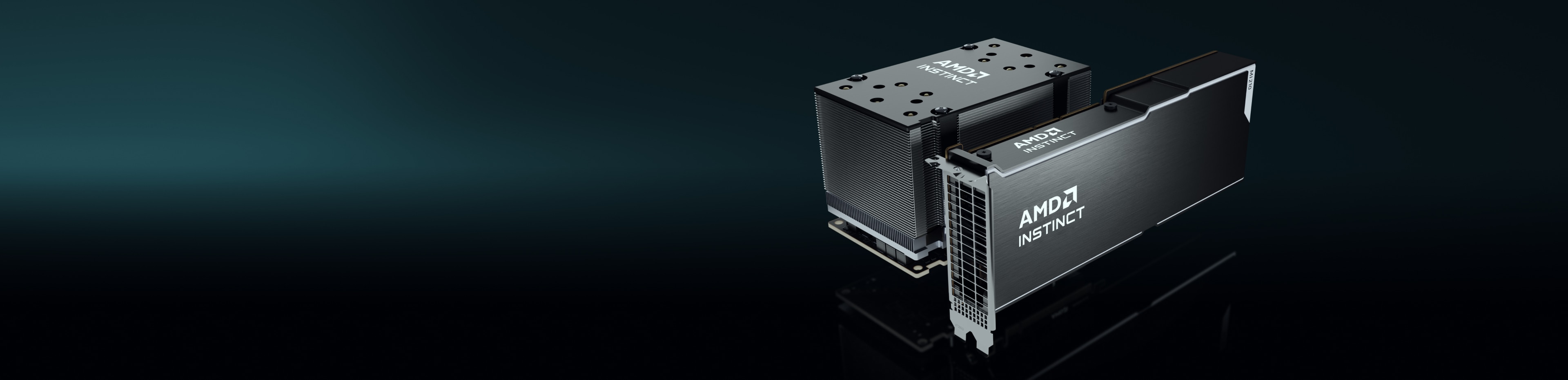

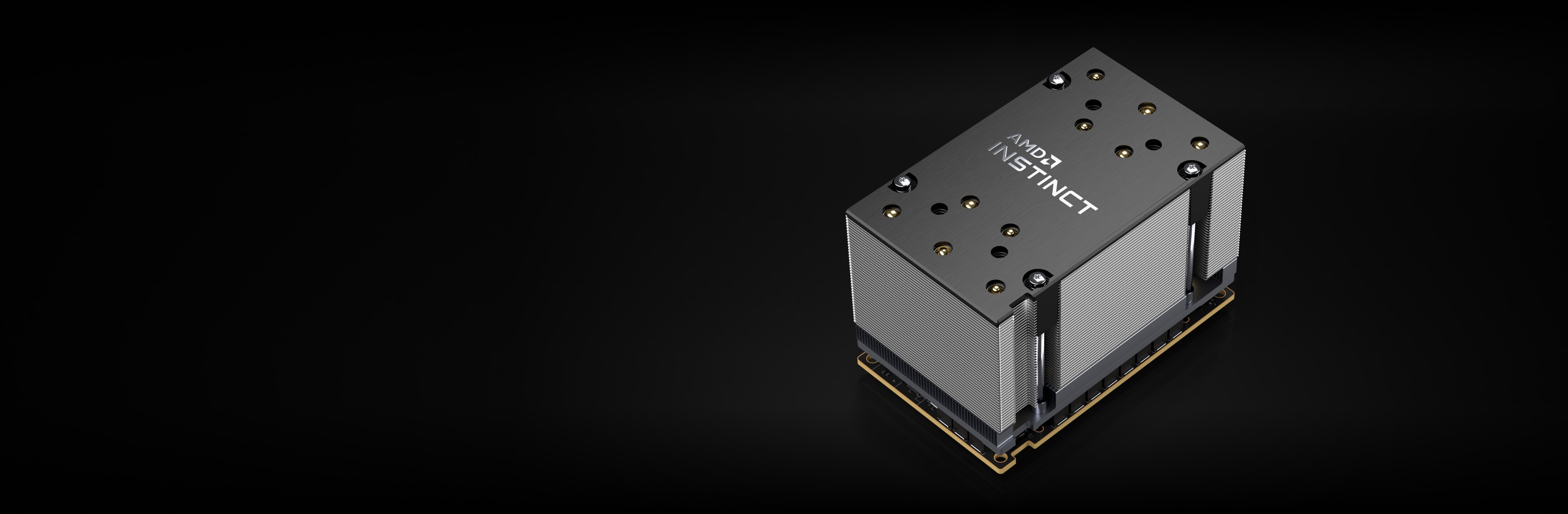

Equipamento interno

Os aceleradores AMD Instinct são construídos com base na arquitetura AMD CDNA™, que oferece Matrix Core Technologies e suporte para uma ampla gama de recursos de precisão — desde o altamente eficiente INT8 e FP8 até o mais exigente FP64 para HPC.

Aceleradores AMD Instinct MI250X

Os aceleradores AMD Instinct MI250X alimentam alguns dos principais supercomputadores do mundo.

220 CUs

220 unidades de computação de GPU

128 GB

128 GB de memória HBM2e

3,2 TB/s

3,2 TB/s de largura de banda máxima da memória

400 GB/s

Pico de 400 GB/s do Infinity Fabric agregado

Comparações de especificações

Até 383 TFLOPS de desempenho teórico de meia precisão (FP16) com até 1,6 vezes mais capacidade de memória e largura de banda do que as GPUs da concorrência para as cargas de trabalho de IA mais exigentes2,3,4

MI250X

A100

Proporciona uma vantagem de até 4 vezes em relação às GPUs da concorrência, oferecendo até 47,9 TFLOPs FP64 e até 95,7 TFLOPs FP64 de desempenho teórico de pico Matrix.2

MI250X

A100

*O formato de dados TF32 não é compatível com o IEEE e não está incluído nessa comparação.

Aceleradores AMD Instinct MI250

Os aceleradores AMD Instinct MI250 geram um desempenho excepcional de HPC e IA para casos de uso relacionados a empresas, pesquisas e universidades.

208 CUs

208 unidades de computação de GPU

128 GB

128 GB de memória HBM2e

3,2 TB/s

3,2 TB/s de largura de banda máxima da memória

100 GB/s

Largura de banda do link Infinity Fabric™ com pico de 100 GB/s

Performance da avaliação de desempenho

HPCG 3.0: O HPCG (Benchmark High Performance Conjugate Gradients, Gradientes conjugados de alto desempenho de referência) é uma métrica para classificar os sistemas HPC. O HPCG é destinado como um complemento para a referência HPL (High Performance LINPACK, LINPACK de alto desempenho), atualmente usado para classificar os TOP500 sistemas de computação.5

Métricas |

1xMI250 |

2xMI250 |

4xMI250 |

GFLOPS |

488,8 |

972,6 |

1927,7 |

HPL: HPL é uma implementação de referência do Linpack de alto desempenho. O código resolve um sistema uniformemente aleatório de equações lineares e informa o tempo e a taxa de execução de ponto flutuante usando uma fórmula padrão para a contagem de operações.6

Métricas |

1xMI250 |

2xMI250 |

4xMI250 |

TFLOPs |

40,45 |

80,666 |

161,97 |

O HPL_AI, ou LINPACK de alto desempenho para introspecção de aceleradores, é um parâmetro de comparação que destaca a convergência das cargas de trabalho de HPC e IA ao resolver um sistema de equações lineares usando novos algoritmos de precisão mista.7

Métricas |

Módulo de teste |

4xMI250 |

TFLOPs |

FP16/32/64 misto |

930,44 |

O PyFR é uma estrutura de código aberto baseada em Python para resolver problemas do tipo advecção-difusão em arquiteturas de streaming usando a abordagem de Reconstrução de Fluxo de Huynh. A estrutura foi projetada para resolver uma série de sistemas de controle em grades mistas não estruturadas contendo vários tipos de elementos.8

Métricas |

Módulo de teste |

1xMI250 |

Simulações/dia |

TGV |

41,73 |

O OpenFOAM (sigla em inglês para "Open-source Field Operation And Manipulation", Operação e manipulação de campo de código aberto) é uma caixa de ferramentas C++ para o desenvolvimento de solucionadores numéricos personalizados e utilitários de pré/pós-processamento para a solução de problemas de mecânica contínua, incluindo principalmente a dinâmica de fluidos computacional (CFD).9

Métricas |

Módulo de teste |

1xMI250 |

2xMI250 |

4xMI250 |

Tempo (s) |

Casos de teste HPC (maior não é melhor) |

662,3 |

364,26 |

209,84 |

O Amber é um conjunto de programas de simulação biomolecular. O termo "Amber" se refere a duas coisas. Primeiro, é um conjunto de campos de força mecânica molecular para a simulação de biomoléculas. Segundo, é um pacote de programas de simulação molecular que inclui código-fonte e demonstrações.10

Aplicativo |

Métricas |

Módulo de teste |

Quanto maior, melhor |

1xMI250 |

AMBER |

ns/dia |

Produção de celulose NPT 4fs |

Sim |

227,2 |

AMBER |

ns/dia |

Produção de celulose NVE 4fs |

Sim |

242,4 |

AMBER |

ns/dia |

Produção de FatorIX NPT 4fs |

Sim |

803,1 |

AMBER |

ns/dia |

Produção de FatorIX NVE 4fs |

Sim |

855,2 |

AMBER |

ns/dia |

Produção JAC NPT 4fs |

Sim |

1794 |

AMBER |

ns/dia |

Produção JAC NVE 4fs |

Sim |

1871 |

AMBER |

ns/dia |

Produção STMV NPT 4fs |

Sim |

80,65 |

AMBER |

ns/dia |

Produção STMV NVE 4fs |

Sim |

86,7 |

O GROMACS é um pacote de dinâmica molecular projetado principalmente para simulações de proteínas, lipídios e ácidos nucleicos. Ele foi originalmente desenvolvido no departamento de Química Biofísica da Universidade de Groningen e agora é mantido por colaboradores em universidades e centros de pesquisa em todo o mundo.11

Aplicativo |

Métricas |

Módulo de teste |

Quanto maior, melhor |

1xMI250 |

2xMI250 |

4xMI250 |

GROMACS |

ns/dia |

STMV |

Sim |

34,2 |

61,812 |

89,26 |

O LAMMPS é um código clássico de dinâmica molecular com foco na modelagem de materiais. É um acrônimo para Simulador paralelo massivo atômico/molecular de larga escala. O LAMMPS tem potencial para materiais de estado sólido (metais, semicondutores) e matéria mole (biomoléculas, polímeros) e sistemas mesoscópicos ou de granulação grossa.12

Aplicativo |

Métricas |

Módulo de teste |

Quanto maior, melhor |

1xMI250 |

2xMI250 |

4xMI250 |

LAMMPS |

Tempo do átomo etapas/seg. |

LJ |

Sim |

6E+08 |

1E+09 |

2E+09 |

LAMMPS |

Tempo do átomo etapas/seg. |

ReaxFF |

Sim |

7E+06 |

1E+07 |

3E+07 |

LAMMPS |

Tempo do átomo etapas/seg. |

Tersoff |

Sim |

5E+08 |

1E+09 |

2E+09 |

O NAMD é um pacote de dinâmica molecular projetado para simular o movimento de biomoléculas ao longo do tempo. Ele é adequado para grandes sistemas biomoleculares e tem sido usado para simular sistemas com mais de 1 bilhão de átomos, apresentando uma escalabilidade estelar em milhares de núcleos de CPU e GPUs.13

Aplicativo |

Métricas |

Módulo de teste |

Quanto maior, melhor |

1xMI250 |

2xMI250 |

4xMI250 |

NAMD 3.0 |

ns/dia |

APOA1_NVE |

Sim |

221,4 |

443,61 |

879,43 |

NAMD 3.0 |

ns/dia |

STMV_NVE |

Sim |

19,87 |

39,545 |

77,132 |

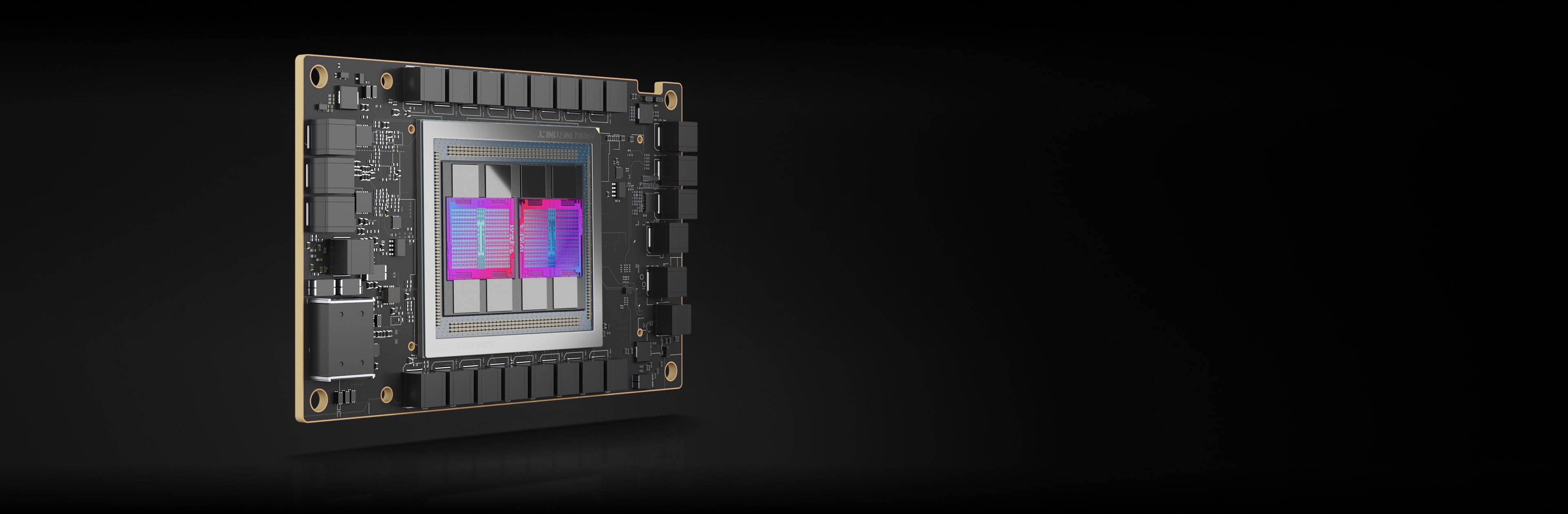

Aceleradores AMD Instinct MI210

Os aceleradores AMD Instinct MI210 potencializam as cargas de trabalho de HPC e IA empresariais, de pesquisa e acadêmicas para soluções de servidor único e muito mais.

104 CUs

104 unidades de computação de GPU

64 GB

64 GB de memória HBM2e

1,6 TB/s

1,6 TB/s de largura de banda máxima da memória

100 GB/s

Largura de banda do link Infinity Fabric™ com pico de 100 GB/s

Performance da avaliação de desempenho

HPL: HPL é uma implementação de referência do Linpack de alto desempenho. O código resolve um sistema uniformemente aleatório de equações lineares e informa o tempo e a taxa de execução de ponto flutuante usando uma fórmula padrão para a contagem de operações.14

Métricas |

Quanto maior, melhor |

1xMI210 |

2xMI210 |

4xMI210 | 8xMI210 |

TFLOPs |

Sim |

21,07 |

40,878 |

81,097 | 159,73 |

HPL-AI: O HPL_AI, ou LINPACK de alto desempenho para introspecção de aceleradores, é um parâmetro de comparação que destaca a convergência das cargas de trabalho de HPC e IA ao resolver um sistema de equações lineares usando novos algoritmos de precisão mista.15

Métricas |

Módulo de teste |

Quanto maior, melhor |

4xMI210 |

8xMI210 |

TFLOPs |

FP16/32/64 misto |

Sim |

444,77 |

976,18 |

LAMMPS: O LAMMPS é um código clássico de dinâmica molecular com foco na modelagem de materiais. É um acrônimo para Simulador paralelo massivo atômico/molecular de larga escala. O LAMMPS tem potencial para materiais de estado sólido (metais, semicondutores) e matéria mole (biomoléculas, polímeros) e sistemas mesoscópicos ou de granulação grossa.16

Métricas |

Módulo de teste |

Quanto maior, melhor |

4xMI210 | 8xMI210 |

Tempo do átomo etapas/seg. |

ReaxFF |

Sim |

1E+07 | 3E+07 |

Mantenha-se informado

Inscreva-se para receber as últimas notícias sobre data centers e conteúdo sobre servidores.

Notas de rodapé

- Lista dos 500 melhores, junho de 2023

- A GPU de data center mais rápida do mundo é a AMD Instinct™ MI250X. Cálculos realizados pelo AMD Performance Labs em 15 de setembro de 2021, para o acelerador AMD Instinct™ MI250X (módulo OAM com HBM2e de 128 GB) a um pico de aumento de clock do mecanismo de 1.700 MHz resultaram em um pico de 95,7 TFLOPs de precisão dupla teórica (Matriz FP64), pico de 47,9 TFLOPs de precisão dupla teórica (FP64), pico de 95,7 TFLOPs da matriz de precisão única teórica (Matriz FP32), pico de 47,9 TFLOPs de precisão única teórica (FP32), pico de 383,0 TFLOPs de meia precisão teórica (FP16) e pico de 383,0 TFLOPs de precisão teórica do formato Bfloat16 (BF16) no desempenho do ponto de flutuação. Cálculos realizados pelos AMD Performance Labs em 18 de setembro de 2020 para o acelerador AMD Instinct™ MI100 (placa 32 GB HBM2 PCIe®) a um pico de aumento de clock do mecanismo de 1.502 MHz resultaram em um pico de 11,54 TFLOPs de precisão dupla teórica (FP64), pico de 46,1 TFLOPs da matriz de precisão única teórica (FP32), pico de 23,1 TFLOPs de precisão única teórica (FP32), pico de 184,6 TFLOPs de meia precisão teórica (FP16) em desempenho do ponto de flutuação. Os resultados publicados sobre o acelerador de GPU NVidia Ampere A100 (80 GB), aumento de clock do mecanismo de 1410 MHz, resultaram em um pico de 19,5 TFLOPs de núcleos tensores de precisão dupla (Núcleo Tensor FP64), pico de 9,7 TFLOPs de precisão dupla (FP64). Pico de 19,5 TFLOPs de precisão única teórica (FP32), pico de 78 TFLOPs de meia precisão teórica (FP16), pico de 312 TFLOPs de meia precisão teórica (Fluxo do Tensor FP16), pico de 39 TFLOPs de Bfloat 16 (BF16), pico de 312 TFLOPs de precisão do formato Bfloat16 (Fluxo do Tensor BF16) no desempenho do ponto de flutuação teórico. O formato de dados TF32 não é compatível com IEEE e não está incluído nesta comparação. https://www.nvidia.com/content/dam/en-zz/Solutions/Data-Center/nvidia-ampere-architecture-whitepaper.pdf, página 15, Tabela 1. MI200-01

- Cálculos realizados pelos AMD Performance Labs em 21 de setembro de 2021, para os aceleradores AMD Instinct™ MI250X e MI250 (placa 128 GB HBM2e) OAM projetados com a tecnologia de processo AMD CDNA™ 2 6 nm FinFet a 1.600 MHz de pico de clock de memória resultou em 3,2768 TFLOPS de memória teórica de pico desempenho da largura de banda. A interface de barramento de memória MI250/MI250X é de 4.096 bits vezes 2 dados e a taxa de dados de memória é de 3,20 Gbps para largura de banda de memória total de 3,2768 TB/s ((3,20 Gbps*(4.096 bits*2))/8). Os maiores resultados publicados sobre o acelerador de GPU NVidia Ampere A100 (80 GB) SXM resultaram em desempenho de largura de banda de memória GPU de 2.039 TB/s. https://www.nvidia.com/content/dam/en-zz/Solutions/Data-Center/a100/pdf/nvidia-a100-datasheet-us-nvidia-1758950-r4-web.pdf MI200-07

- Cálculos realizados pelo AMD Performance Labs em 21 de setembro de 2021, para os aceleradores AMD Instinct™ MI250X e MI250 (OAM) projetados com a tecnologia de processo AMD CDNA™ 2 6nm FinFet com clock de memória de pico de 1.600 MHz resultaram em uma capacidade de memória HBMe de 128 GB. As especificações publicadas nos aceleradores NVidia Ampere A100 (80 GB) SXM e A100 (PCIe®) apresentaram capacidade de memória de 80 GB. Resultados encontrados em: https://www.nvidia.com/content/dam/en-zz/Solutions/Data-Center/a100/pdf/nvidia-a100-datasheet-us-nvidia-1758950-r4-web.pdf MI200-18

- Testes realizados pelo AMD Performance Labs em 02/11/2022 usando o HPCG 3.0, comparando dois sistemas: Servidor com tecnologia 2P EPYC™ 7763, SMT desativado, com 1x, 2x e 4x GPUs AMD Instinct™ MI250 (128 GB HBM2e) 560W, SBIOS M12, Ubuntu 20.04.4, host ROCm 5.2.0 vs. servidor 2P AMD EPYC™ 7742 com 1x, 2x e 4x GPUs Nvidia Ampere A100 80GB SXM 400W, SBIOS 0.34, Ubuntu 20.04.4, CUDA 11.6. Contêiner HPCG 3.0: nvcr.io/nvidia/hpc-benchmarks:21.4-hpcg at https://catalog.ngc.nvidia.com/orgs/nvidia/containers/hpc-benchmarks. Os fabricantes de servidores podem ter outras configurações, gerando resultados diferentes. O desempenho pode variar baseado no uso dos drivers e otimizações mais recentes. MI200-70A.

- Testes conduzidos pelo AMD Performance Labs em 14/11/2022 usando HPL comparando dois sistemas. Servidor com tecnologia 2P EPYC™ 7763, SMT desativado, com 1x, 2x e 4x GPUs AMD Instinct™ MI250 (128 GB HBM2e) 560 W, host ROCm 5.2.0 rocHPL6.0.0. O contêiner AMD HPL ainda não está disponível no Infinity Hub. Servidor 2P AMD EPYC™ 7742, habilitado para SMT, com 1x, 2x e 4x GPUs Nvidia Ampere A100 80 GB SXM 400 W, CUDA 11.6 e driver versão 510.47.03. Contêiner HPL (nvcr.io/nvidia/hpc-benchmarks:21.4-hpl) obtido de https://catalog.ngc.nvidia.com/orgs/nvidia/containers/hpc-benchmarks. Os fabricantes de servidores podem ter outras configurações, gerando resultados diferentes. O desempenho pode variar baseado no uso dos drivers e otimizações mais recentes. MI200-69A.

- Comparação HPL-AI baseada em testes internos da AMD em 2/11/2022 medindo o desempenho de referência HPL-AI (TFLOPS) usando um servidor com 2x EPYC 7763 com 4x MI250 128MB HBM2e executando ROCm 5.2.0, HPL-AI-AMD v1.0.0 comparado a um servidor com 2x EPYC 7742 com 4x A100 SXM 80GB HBM2e executando CUDA 11.6, HPL-AI-NVIDIA v2.0.0, contêiner nvcr.io/nvidia/hpc-benchmarks:21.4-hpl. Os fabricantes de servidores podem ter outras configurações, gerando resultados diferentes. O desempenho pode variar baseado no uso dos drivers e otimizações mais recentes. MI200-81.

- Testes realizados pelo AMD Performance Labs em 25/11/2022 usando PyFR TGV e NACA 0021 comparando dois sistemas: Servidor com tecnologia 2P EPYC™ 7763, SMT desativado, com 1x GPUs AMD Instinct™ MI250 (128 GB HBM2e) 560W, SBIOS M12, Ubuntu 20.04.4, Host ROCm 5.2.0 comparado ao servidor 2P AMD EPYC™ 7742, SMT ativado, com 1x GPUs Nvidia Ampere A100 80GB SXM 400W, SBIOS 0.34, Ubuntu 20.04.4, CUDA 11.6. Os fabricantes de servidores podem ter outras configurações, gerando resultados diferentes. O desempenho pode variar baseado no uso dos drivers e otimizações mais recentes. MI200-82.

- Testes conduzidos pelo AMD Performance Labs em 14/04/2023 usando o OpenFOAM v2206 em um servidor de produção de CPU 2P EPYC 7763 com 1x, 2x e 4x GPUs AMD Instinct™ MI250 (128GB, 560W) com tecnologia AMD Infinity Fabric™ habilitada, ROCm™5.3.3, Ubuntu® 20.04.4 comparado a um servidor de produção com CPU EPYC 7742 2P com 1x, 2x e 4x GPUs Nvidia A100 80GB SXM (400W) com tecnologia NVLink habilitada, CUDA® 11.8, Ubuntu 20.04.4. Os fabricantes de servidores podem ter outras configurações, gerando resultados diferentes. O desempenho pode variar baseado no uso dos drivers e otimizações mais recentes.

- Testes conduzidos pelo AMD Performance Labs em 26/08/2022 usando o AMBER: Cellulose_production_NPT_4fs, Cellulose_production_NVE_4fs, FactorIX_production_NPT_4fs, FactorIX_production_NVE_4fs, STMV_production_NPT_4fs, STMV_production_NVE_4fs, JAC_production_NPT_4fs e JAC production_NVE_4fs. Comparação de dois sistemas: Servidor alimentado por 2P EPYC™ 7763 com 1x A MD Instinct™ MI250 (128GB HBM2e) GPU 560W, ROCm 5.2.0, contêiner Amber 22.amd_100 comparado a um Servidor com tecnologia 2P EPYC™ 7742 com 1x N vidia A100 SXM (80GB HBM2e) GPU 400W, MPS habilitado (2 instâncias), CUDA 11.6. MI200-73.

- Testes conduzidos pelo AMD Performance Labs em 18/10/22 usando o Gromacs STMV comparando dois sistemas: Servidor 2P EPYC™ 7763 com 4x GPU AMD Instinct™ MI250 (128GB HBM2e) 560W com tecnologia Infinity Fabric™, ROCm™ 5.2.0, contêiner Gromacs 2022.3.amd1_174 comparado a reivindicações públicas da Nvidia https://developer.nvidia.com/hpc-application-performance. (Gromacs 2022.2). Dual EPYC 7742 com 4 GPUs Nvidia Ampere A100 SXM de 80 GB. Os fabricantes de servidores podem ter outras configurações, gerando resultados diferentes. O desempenho pode variar baseado em fatores incluindo uso dos drivers e otimizações mais recentes. MI200-74.

- Testes conduzidos pelo AMD Performance Labs em 109.0322.22 usando o LAMMPS: EAM, LJ, ReaxFF e Tersoff comparando dois sistemas: Servidor 2P EPYC™ 7763 com 4x GPU AMD Instinct™ MI250 (128GB HBM2e) 560W, ROCm 5.2.0, contêiner LAMMPS 2021.5.14_121amdih/lammps:2022.5.04_130 comparado a reivindicações públicas da Nvidia http://web.archive.org/web/20220718053400/https://developer.nvidia.com/hpc-application-performance. (estável em 23 de junho de 2022, atualização 1). Os fabricantes de servidores podem ter outras configurações, gerando resultados diferentes. O desempenho pode variar baseado no uso dos drivers e otimizações mais recentes. MI200-77.

- Testes conduzidos pelo AMD Performance Labs em 9.13.22 usando o NAMD: STMV_NVE, APOA1_NVE comparando dois sistemas: Servidor 2P EPYC™ 7763 com 1x, 2x e 4x AMD Instinct™ MI250 (128 GB HBM2e) GPU de 560 W com tecnologia AMD Infinity Fabric™, ROCm 5.2.0, contêiner NAMD namd3:3.0a9 em comparação com as declarações públicas da Nvidia de desempenho de um servidor 2P EPYC 7742 com 1x, 2x e 4x Nvidia Ampere A100 80 GB SXM GPU https://developer.nvidia.com/hpc-application-performance. (v2.15a AVX-512). Os fabricantes de servidores podem ter outras configurações, gerando resultados diferentes. O desempenho pode variar baseado no uso dos drivers e otimizações mais recentes. MI200-76.

- Testes realizados pelo AMD Performance Labs em 14/11/2022 em um soquete 2P AMD EPYC™ '7763 CPU Supermicro 4124 com 8x AMD Instinct™ MI210 GPU (PCIe® 64GB, 300W), tecnologia AMD Infinity Fabric™ habilitada. Ubuntu 18.04.6 LTS, Host ROCm 5.2.0, rocHPL 6.0.0. Resultados calculados a partir de medianas de cinco execuções Vs. Testes conduzidos pelo desempenho da AMD no soquete 2P AMD EPYC™ 7763 Supermicro 4124 com 8x GPU NVIDIA A100 (PCIe 80GB 300W), Ubuntu 18.04.6 LTS, CUDA 11.6, imagem de contêiner HPL Nvidia 21.4-HPL. Todos os resultados foram medidos em sistemas configurados com 8 GPUs; 2 pares de GPUs 4xMI210 conectadas por uma ponte de link Infinity Fabric™ de 4 vias; 4 pares de GPUs PCIe 2xA100 80GB conectadas por pontes NVLink de 2 vias. Informações sobre HPL: https://www.netlib.org/benchmark/hpl/. Detalhes do contêiner AMD HPL: O HPL Container ainda não está disponível no Infinity Hub. Detalhe do contêiner HPL da Nvidia: https://ngc.nvidia.com/catalog/containers/nvidia:hpc-benchmarks. Os fabricantes de servidores podem ter outras configurações, gerando resultados diferentes. O desempenho pode variar baseado no uso dos drivers e otimizações mais recentes. MI200-49A.

- Comparação de HPL-AI com base em testes internos da AMD em 2/11/2022 medindo o desempenho de referência HPL-AI (TFLOPS) usando um servidor com 2x EPYC 7763 com 8x MI210 64MB HBM2e com tecnologia Infinity Fabric executando ROCm 5.2.0 do host, HPL-AI-AMD v1.0.0; o contêiner AMD HPL-AI ainda não está disponível no Infinity Hub em comparação com um servidor com 2x EPYC 7763 com 8x A100 PCIe 80GB HBM2e executando CUDA 11.6, HPL-AI-NVIDIA v2.0.0, contêiner nvcr.io/nvidia/hpc-benchmarks:21.4-hpl. Os fabricantes de servidores podem variar as configurações, produzindo resultados diferentes. O desempenho pode variar baseado no uso dos drivers e otimizações mais recentes. MI200-83.

- Testes realizados em 03/10/2022 pelo AMD Performance Labs em um soquete 2P AMD EPYC™ '7763 CPU Supermicro 4124 com 4x e 8x GPUs AMD Instinct™ MI210 (PCIe® 64 GB, 300 W) com a tecnologia AMD Infinity Fabric™ habilitada. SBIOS2.2, Ubuntu® 18.04.6 LTS, host ROCm™ 5.2.0. Contêiner LAMMPS amdih-2022.5.04_130 (ROCm 5.1) em comparação com as declarações públicas da Nvidia para 4x e 8x GPUs A100 PCIe de 80 GB http://web.archive.org/web/20220718053400/https://developer.nvidia.com/hpc-application-performance. Os fabricantes de servidores podem ter outras configurações, gerando resultados diferentes. O desempenho pode variar baseado no uso dos drivers e otimizações mais recentes. MI200-47A.

- Lista dos 500 melhores, junho de 2023

- A GPU de data center mais rápida do mundo é a AMD Instinct™ MI250X. Cálculos realizados pelo AMD Performance Labs em 15 de setembro de 2021, para o acelerador AMD Instinct™ MI250X (módulo OAM com HBM2e de 128 GB) a um pico de aumento de clock do mecanismo de 1.700 MHz resultaram em um pico de 95,7 TFLOPs de precisão dupla teórica (Matriz FP64), pico de 47,9 TFLOPs de precisão dupla teórica (FP64), pico de 95,7 TFLOPs da matriz de precisão única teórica (Matriz FP32), pico de 47,9 TFLOPs de precisão única teórica (FP32), pico de 383,0 TFLOPs de meia precisão teórica (FP16) e pico de 383,0 TFLOPs de precisão teórica do formato Bfloat16 (BF16) no desempenho do ponto de flutuação. Cálculos realizados pelos AMD Performance Labs em 18 de setembro de 2020 para o acelerador AMD Instinct™ MI100 (placa 32 GB HBM2 PCIe®) a um pico de aumento de clock do mecanismo de 1.502 MHz resultaram em um pico de 11,54 TFLOPs de precisão dupla teórica (FP64), pico de 46,1 TFLOPs da matriz de precisão única teórica (FP32), pico de 23,1 TFLOPs de precisão única teórica (FP32), pico de 184,6 TFLOPs de meia precisão teórica (FP16) em desempenho do ponto de flutuação. Os resultados publicados sobre o acelerador de GPU NVidia Ampere A100 (80 GB), aumento de clock do mecanismo de 1410 MHz, resultaram em um pico de 19,5 TFLOPs de núcleos tensores de precisão dupla (Núcleo Tensor FP64), pico de 9,7 TFLOPs de precisão dupla (FP64). Pico de 19,5 TFLOPs de precisão única teórica (FP32), pico de 78 TFLOPs de meia precisão teórica (FP16), pico de 312 TFLOPs de meia precisão teórica (Fluxo do Tensor FP16), pico de 39 TFLOPs de Bfloat 16 (BF16), pico de 312 TFLOPs de precisão do formato Bfloat16 (Fluxo do Tensor BF16) no desempenho do ponto de flutuação teórico. O formato de dados TF32 não é compatível com IEEE e não está incluído nesta comparação. https://www.nvidia.com/content/dam/en-zz/Solutions/Data-Center/nvidia-ampere-architecture-whitepaper.pdf, página 15, Tabela 1. MI200-01

- Cálculos realizados pelos AMD Performance Labs em 21 de setembro de 2021, para os aceleradores AMD Instinct™ MI250X e MI250 (placa 128 GB HBM2e) OAM projetados com a tecnologia de processo AMD CDNA™ 2 6 nm FinFet a 1.600 MHz de pico de clock de memória resultou em 3,2768 TFLOPS de memória teórica de pico desempenho da largura de banda. A interface de barramento de memória MI250/MI250X é de 4.096 bits vezes 2 dados e a taxa de dados de memória é de 3,20 Gbps para largura de banda de memória total de 3,2768 TB/s ((3,20 Gbps*(4.096 bits*2))/8). Os maiores resultados publicados sobre o acelerador de GPU NVidia Ampere A100 (80 GB) SXM resultaram em desempenho de largura de banda de memória GPU de 2.039 TB/s. https://www.nvidia.com/content/dam/en-zz/Solutions/Data-Center/a100/pdf/nvidia-a100-datasheet-us-nvidia-1758950-r4-web.pdf MI200-07

- Cálculos realizados pelo AMD Performance Labs em 21 de setembro de 2021, para os aceleradores AMD Instinct™ MI250X e MI250 (OAM) projetados com a tecnologia de processo AMD CDNA™ 2 6nm FinFet com clock de memória de pico de 1.600 MHz resultaram em uma capacidade de memória HBMe de 128 GB. As especificações publicadas nos aceleradores NVidia Ampere A100 (80 GB) SXM e A100 (PCIe®) apresentaram capacidade de memória de 80 GB. Resultados encontrados em: https://www.nvidia.com/content/dam/en-zz/Solutions/Data-Center/a100/pdf/nvidia-a100-datasheet-us-nvidia-1758950-r4-web.pdf MI200-18

- Testes realizados pelo AMD Performance Labs em 02/11/2022 usando o HPCG 3.0, comparando dois sistemas: Servidor com tecnologia 2P EPYC™ 7763, SMT desativado, com 1x, 2x e 4x GPUs AMD Instinct™ MI250 (128 GB HBM2e) 560W, SBIOS M12, Ubuntu 20.04.4, host ROCm 5.2.0 vs. servidor 2P AMD EPYC™ 7742 com 1x, 2x e 4x GPUs Nvidia Ampere A100 80GB SXM 400W, SBIOS 0.34, Ubuntu 20.04.4, CUDA 11.6. Contêiner HPCG 3.0: nvcr.io/nvidia/hpc-benchmarks:21.4-hpcg at https://catalog.ngc.nvidia.com/orgs/nvidia/containers/hpc-benchmarks. Os fabricantes de servidores podem ter outras configurações, gerando resultados diferentes. O desempenho pode variar baseado no uso dos drivers e otimizações mais recentes. MI200-70A.

- Testes conduzidos pelo AMD Performance Labs em 14/11/2022 usando HPL comparando dois sistemas. Servidor com tecnologia 2P EPYC™ 7763, SMT desativado, com 1x, 2x e 4x GPUs AMD Instinct™ MI250 (128 GB HBM2e) 560 W, host ROCm 5.2.0 rocHPL6.0.0. O contêiner AMD HPL ainda não está disponível no Infinity Hub. Servidor 2P AMD EPYC™ 7742, habilitado para SMT, com 1x, 2x e 4x GPUs Nvidia Ampere A100 80 GB SXM 400 W, CUDA 11.6 e driver versão 510.47.03. Contêiner HPL (nvcr.io/nvidia/hpc-benchmarks:21.4-hpl) obtido de https://catalog.ngc.nvidia.com/orgs/nvidia/containers/hpc-benchmarks. Os fabricantes de servidores podem ter outras configurações, gerando resultados diferentes. O desempenho pode variar baseado no uso dos drivers e otimizações mais recentes. MI200-69A.

- Comparação HPL-AI baseada em testes internos da AMD em 2/11/2022 medindo o desempenho de referência HPL-AI (TFLOPS) usando um servidor com 2x EPYC 7763 com 4x MI250 128MB HBM2e executando ROCm 5.2.0, HPL-AI-AMD v1.0.0 comparado a um servidor com 2x EPYC 7742 com 4x A100 SXM 80GB HBM2e executando CUDA 11.6, HPL-AI-NVIDIA v2.0.0, contêiner nvcr.io/nvidia/hpc-benchmarks:21.4-hpl. Os fabricantes de servidores podem ter outras configurações, gerando resultados diferentes. O desempenho pode variar baseado no uso dos drivers e otimizações mais recentes. MI200-81.

- Testes realizados pelo AMD Performance Labs em 25/11/2022 usando PyFR TGV e NACA 0021 comparando dois sistemas: Servidor com tecnologia 2P EPYC™ 7763, SMT desativado, com 1x GPUs AMD Instinct™ MI250 (128 GB HBM2e) 560W, SBIOS M12, Ubuntu 20.04.4, Host ROCm 5.2.0 comparado ao servidor 2P AMD EPYC™ 7742, SMT ativado, com 1x GPUs Nvidia Ampere A100 80GB SXM 400W, SBIOS 0.34, Ubuntu 20.04.4, CUDA 11.6. Os fabricantes de servidores podem ter outras configurações, gerando resultados diferentes. O desempenho pode variar baseado no uso dos drivers e otimizações mais recentes. MI200-82.

- Testes conduzidos pelo AMD Performance Labs em 14/04/2023 usando o OpenFOAM v2206 em um servidor de produção de CPU 2P EPYC 7763 com 1x, 2x e 4x GPUs AMD Instinct™ MI250 (128GB, 560W) com tecnologia AMD Infinity Fabric™ habilitada, ROCm™5.3.3, Ubuntu® 20.04.4 comparado a um servidor de produção com CPU EPYC 7742 2P com 1x, 2x e 4x GPUs Nvidia A100 80GB SXM (400W) com tecnologia NVLink habilitada, CUDA® 11.8, Ubuntu 20.04.4. Os fabricantes de servidores podem ter outras configurações, gerando resultados diferentes. O desempenho pode variar baseado no uso dos drivers e otimizações mais recentes.

- Testes conduzidos pelo AMD Performance Labs em 26/08/2022 usando o AMBER: Cellulose_production_NPT_4fs, Cellulose_production_NVE_4fs, FactorIX_production_NPT_4fs, FactorIX_production_NVE_4fs, STMV_production_NPT_4fs, STMV_production_NVE_4fs, JAC_production_NPT_4fs e JAC production_NVE_4fs. Comparação de dois sistemas: Servidor alimentado por 2P EPYC™ 7763 com 1x A MD Instinct™ MI250 (128GB HBM2e) GPU 560W, ROCm 5.2.0, contêiner Amber 22.amd_100 comparado a um Servidor com tecnologia 2P EPYC™ 7742 com 1x N vidia A100 SXM (80GB HBM2e) GPU 400W, MPS habilitado (2 instâncias), CUDA 11.6. MI200-73.

- Testes conduzidos pelo AMD Performance Labs em 18/10/22 usando o Gromacs STMV comparando dois sistemas: Servidor 2P EPYC™ 7763 com 4x GPU AMD Instinct™ MI250 (128GB HBM2e) 560W com tecnologia Infinity Fabric™, ROCm™ 5.2.0, contêiner Gromacs 2022.3.amd1_174 comparado a reivindicações públicas da Nvidia https://developer.nvidia.com/hpc-application-performance. (Gromacs 2022.2). Dual EPYC 7742 com 4 GPUs Nvidia Ampere A100 SXM de 80 GB. Os fabricantes de servidores podem ter outras configurações, gerando resultados diferentes. O desempenho pode variar baseado em fatores incluindo uso dos drivers e otimizações mais recentes. MI200-74.

- Testes conduzidos pelo AMD Performance Labs em 109.0322.22 usando o LAMMPS: EAM, LJ, ReaxFF e Tersoff comparando dois sistemas: Servidor 2P EPYC™ 7763 com 4x GPU AMD Instinct™ MI250 (128GB HBM2e) 560W, ROCm 5.2.0, contêiner LAMMPS 2021.5.14_121amdih/lammps:2022.5.04_130 comparado a reivindicações públicas da Nvidia http://web.archive.org/web/20220718053400/https://developer.nvidia.com/hpc-application-performance. (estável em 23 de junho de 2022, atualização 1). Os fabricantes de servidores podem ter outras configurações, gerando resultados diferentes. O desempenho pode variar baseado no uso dos drivers e otimizações mais recentes. MI200-77.

- Testes conduzidos pelo AMD Performance Labs em 9.13.22 usando o NAMD: STMV_NVE, APOA1_NVE comparando dois sistemas: Servidor 2P EPYC™ 7763 com 1x, 2x e 4x AMD Instinct™ MI250 (128 GB HBM2e) GPU de 560 W com tecnologia AMD Infinity Fabric™, ROCm 5.2.0, contêiner NAMD namd3:3.0a9 em comparação com as declarações públicas da Nvidia de desempenho de um servidor 2P EPYC 7742 com 1x, 2x e 4x Nvidia Ampere A100 80 GB SXM GPU https://developer.nvidia.com/hpc-application-performance. (v2.15a AVX-512). Os fabricantes de servidores podem ter outras configurações, gerando resultados diferentes. O desempenho pode variar baseado no uso dos drivers e otimizações mais recentes. MI200-76.

- Testes realizados pelo AMD Performance Labs em 14/11/2022 em um soquete 2P AMD EPYC™ '7763 CPU Supermicro 4124 com 8x AMD Instinct™ MI210 GPU (PCIe® 64GB, 300W), tecnologia AMD Infinity Fabric™ habilitada. Ubuntu 18.04.6 LTS, Host ROCm 5.2.0, rocHPL 6.0.0. Resultados calculados a partir de medianas de cinco execuções Vs. Testes conduzidos pelo desempenho da AMD no soquete 2P AMD EPYC™ 7763 Supermicro 4124 com 8x GPU NVIDIA A100 (PCIe 80GB 300W), Ubuntu 18.04.6 LTS, CUDA 11.6, imagem de contêiner HPL Nvidia 21.4-HPL. Todos os resultados foram medidos em sistemas configurados com 8 GPUs; 2 pares de GPUs 4xMI210 conectadas por uma ponte de link Infinity Fabric™ de 4 vias; 4 pares de GPUs PCIe 2xA100 80GB conectadas por pontes NVLink de 2 vias. Informações sobre HPL: https://www.netlib.org/benchmark/hpl/. Detalhes do contêiner AMD HPL: O HPL Container ainda não está disponível no Infinity Hub. Detalhe do contêiner HPL da Nvidia: https://ngc.nvidia.com/catalog/containers/nvidia:hpc-benchmarks. Os fabricantes de servidores podem ter outras configurações, gerando resultados diferentes. O desempenho pode variar baseado no uso dos drivers e otimizações mais recentes. MI200-49A.

- Comparação de HPL-AI com base em testes internos da AMD em 2/11/2022 medindo o desempenho de referência HPL-AI (TFLOPS) usando um servidor com 2x EPYC 7763 com 8x MI210 64MB HBM2e com tecnologia Infinity Fabric executando ROCm 5.2.0 do host, HPL-AI-AMD v1.0.0; o contêiner AMD HPL-AI ainda não está disponível no Infinity Hub em comparação com um servidor com 2x EPYC 7763 com 8x A100 PCIe 80GB HBM2e executando CUDA 11.6, HPL-AI-NVIDIA v2.0.0, contêiner nvcr.io/nvidia/hpc-benchmarks:21.4-hpl. Os fabricantes de servidores podem variar as configurações, produzindo resultados diferentes. O desempenho pode variar baseado no uso dos drivers e otimizações mais recentes. MI200-83.

- Testes realizados em 03/10/2022 pelo AMD Performance Labs em um soquete 2P AMD EPYC™ '7763 CPU Supermicro 4124 com 4x e 8x GPUs AMD Instinct™ MI210 (PCIe® 64 GB, 300 W) com a tecnologia AMD Infinity Fabric™ habilitada. SBIOS2.2, Ubuntu® 18.04.6 LTS, host ROCm™ 5.2.0. Contêiner LAMMPS amdih-2022.5.04_130 (ROCm 5.1) em comparação com as declarações públicas da Nvidia para 4x e 8x GPUs A100 PCIe de 80 GB http://web.archive.org/web/20220718053400/https://developer.nvidia.com/hpc-application-performance. Os fabricantes de servidores podem ter outras configurações, gerando resultados diferentes. O desempenho pode variar baseado no uso dos drivers e otimizações mais recentes. MI200-47A.