Visão geral

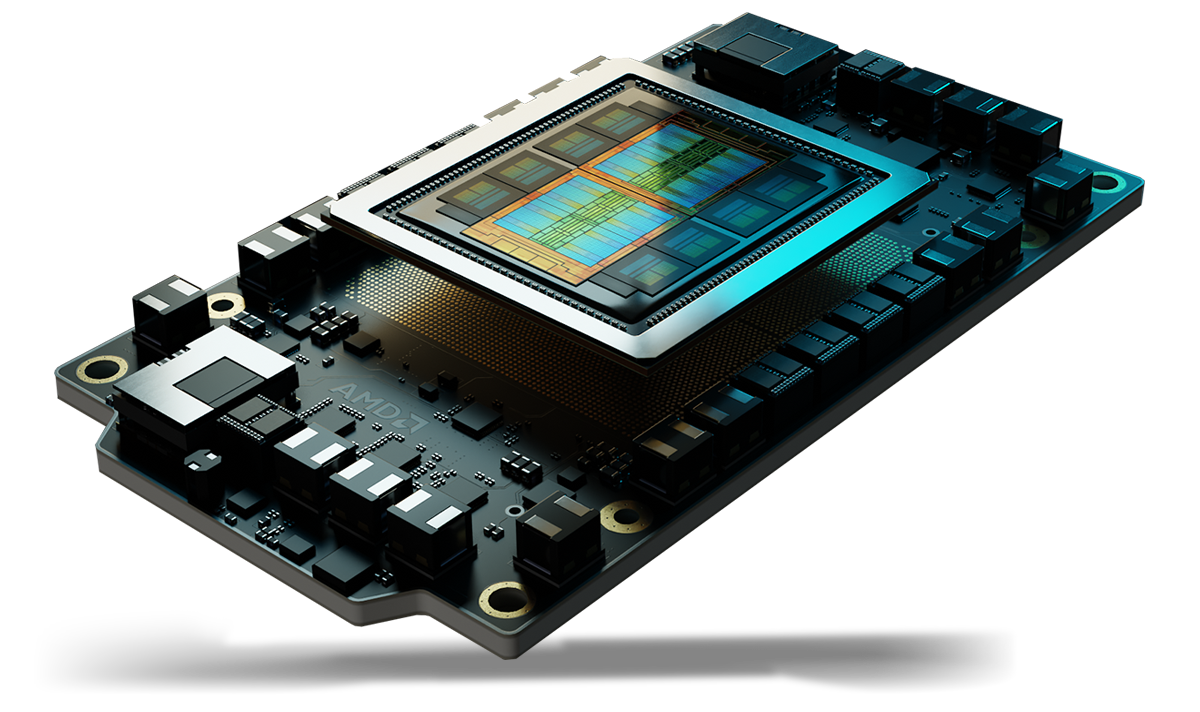

A arquitetura de computação dedicada AMD CDNA™ serve de base para as GPUs e APUs AMD Instinct™. Ela conta com encapsulamento avançado que unifica as tecnologias de chiplet da AMD com memória de alta largura de banda (HBM), uma malha Infinity Architecture de alta produtividade e tecnologia avançada de núcleos de matriz, compatível com um conjunto abrangente de formatos de dados para IA e computação de alto desempenho, projetada para reduzir a sobrecarga de movimentação de dados e aumentar a eficiência energética.

Comparativo entre gerações:

| CDNA | CDNA 2 | CDNA 3 | CDNA 4 | |

| Tecnologia de processo | 7 nm FinFET | 6 nm FinFET | 5 nm + 6 nm FinFET | 3 nm + 6 nm FinFET |

| Transistores | 25,6 bilhões | Até 58 bilhões | Até 146 bilhões | Até 185 bilhões |

| CUs | Núcleos de matriz | 120 | 440 | Até 220 | 880 | Até 304 | 1216 | 256 | 1024 |

| Tipo de memória | HBM2 de 32 GB | Até 128 GB de HBM2E | Até 256 GB de HBM3 | HBM3E | HBM3E de 288 GB |

| Largura de banda de memória (Pico) | 1,2 TB/s | Até 3,2 TB/s | Até 6 TB/s | 8 TB/s |

| AMD Infinity Cache™ | N/A | N/A | 256 MB | 256 MB |

| Coerência da GPU | N/A | Cache | Cache e HBM | Cache e HBM |

| Suporte a tipos de dados | INT4, INT8, BF16, FP16, FP32, FP64 | INT4, INT8, BF16, FP16, FP32, FP64 | Matriz: INT8, FP8, BF16, FP16, TF32, FP32, FP64 Vetor: FP16, FP32, FP64 Esparsidade: INT8, FP8, BF16, FP16 |

Matriz: MXFP4, MXFP6, INT8, MXFP8, OCP FP8, BF16, FP16, TF32*, FP32, FP64 Vetor: FP16, FP32, FP64 Esparsidade: OCP-FP8, INT8, FP16, BF16 |

| Produtos | AMD Instinct™ Série MI100 | AMD Instinct™ Série MI200 | AMD Instinct™ Série MI300 | AMD Instinct™ Série MI350 |

O TF32 é compatível pela emulação de software.

Benefícios

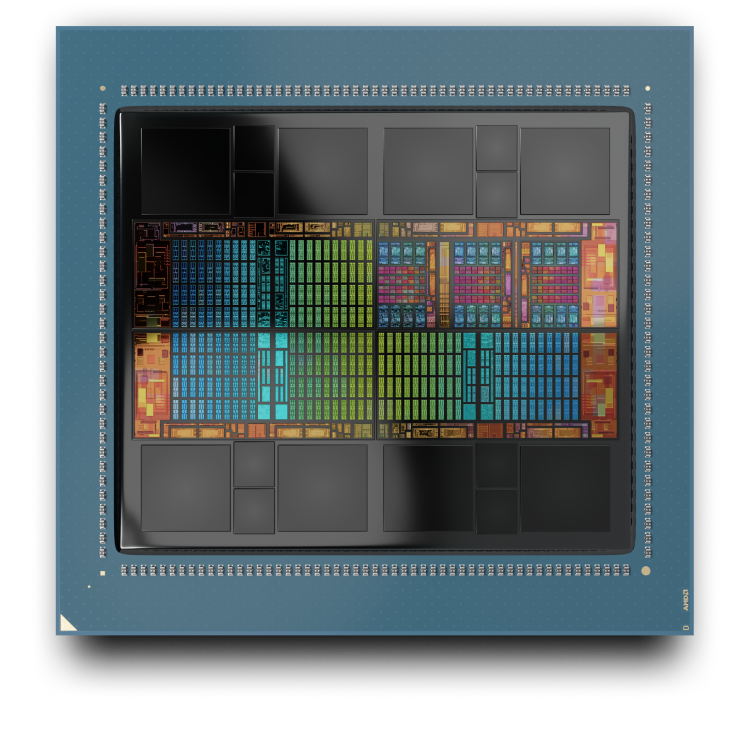

Tecnologias Matrix Core

A AMD CDNA 4 oferece tecnologias aprimoradas de núcleos de matriz que dobram a produtividade computacional para tipos de dados de matriz de baixa precisão em comparação com a arquitetura da geração anterior. A AMD CDNA 4 também proporciona maior paralelismo em nível de instrução, expande os recursos LDS compartilhados com o dobro da largura de banda e inclui suporte a uma ampla gama de precisões, agora com MXFP4 e MXFP6, além de suporte a dados de matriz esparsos (esparsidade) para OCP-FP8, INT8, FP16 e BF16.

Aceleração de IA aprimorada

A AMD CDNA 4 apresenta novos recursos de aceleração de IA avançadas para LLMs, incluindo desempenho GEMM aprimorado com latência reduzida, maior eficiência energética com formatos de menor precisão e mais flexibilidade para projetos de IA com precisão mista, permitindo equilibrar prioridades entre precisão do modelo, velocidade e eficiência energética.

Memória HBM, coerência e cache

As GPUs AMD Instinct Série MI350 oferecem capacidade de memória HBM3E de 256 GB, líder do setor, para serem compatíveis com modelos de maior porte com toda a largura de banda necessária, além de memória compartilhada e AMD Infinity Cache™ (último nível de cache compartilhado), eliminando a cópia de dados e melhorando a latência.

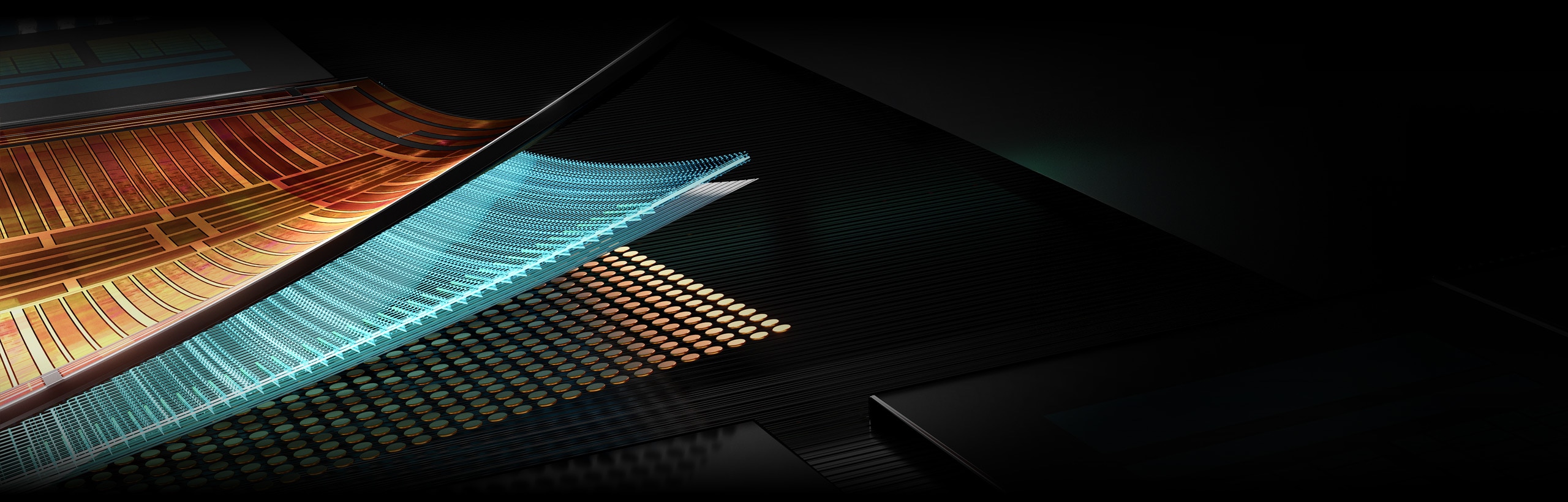

Fabric unificado

A arquitetura AMD Infinity de última geração, aliada à tecnologia AMD Infinity Fabric™, possibilita a unificação coerente e de alta produtividade da tecnologia de chiplet das GPUs AMD com memória HBM3E empilhada em dispositivos únicos e em plataformas com vários dispositivos. Ela também oferece E/S aprimorada com compatibilidade com PCIe® 5.

Apresentando a AMD CDNA™ 4

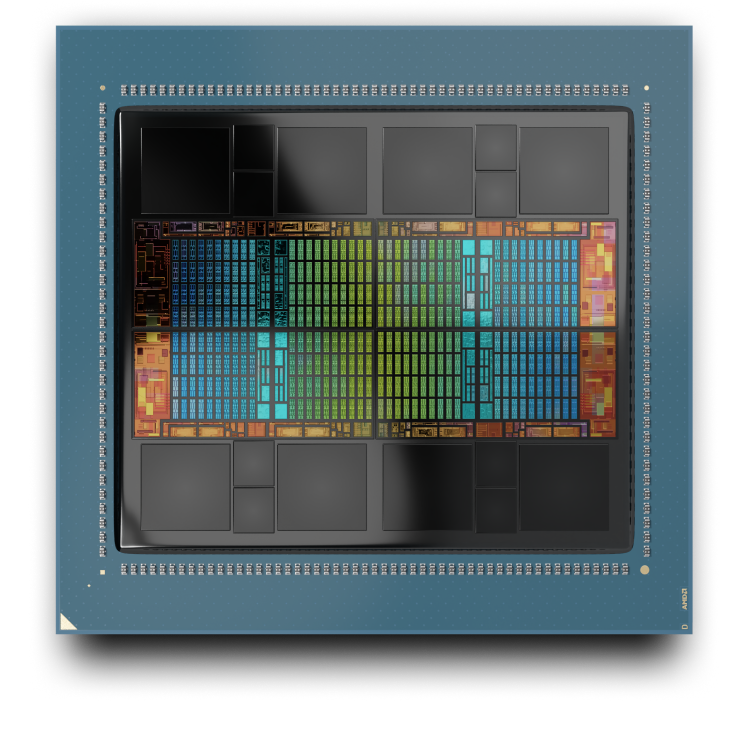

A AMD CDNA™ 4 é a arquitetura de computação dedicada que serve de base para as GPUs AMD Instinct™ Série MI350. Ele apresenta uma pacote avançado com tecnologias de chiplet, projetadas para reduzir a sobrecarga de movimento de dados e aumentar a eficiência de energia.

GPUs AMD Instinct Série MI350

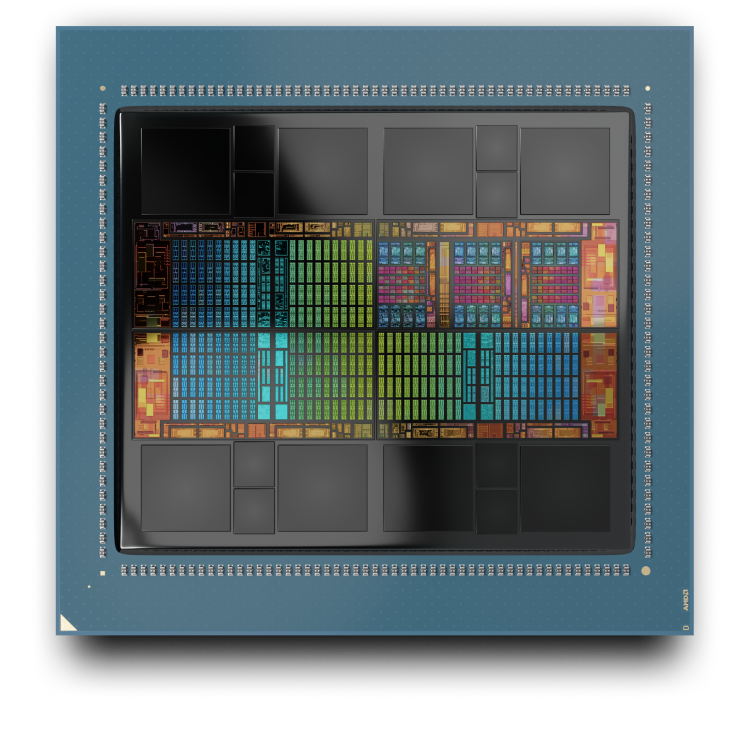

AMD CDNA 3

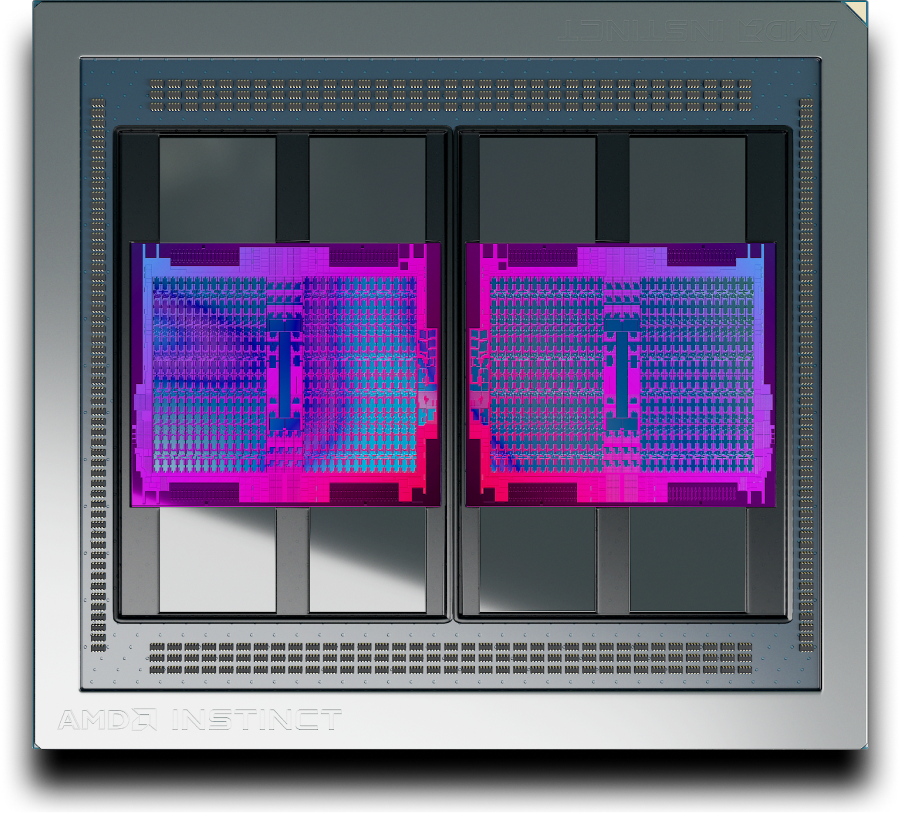

A arquitetura de computação dedicada AMD CDNA 3 serve de base para as GPUs AMD Instinct™ Série MI300. Ele apresenta uma pacote avançado com tecnologias de chiplet, projetadas para reduzir a sobrecarga de movimento de dados e aumentar a eficiência de energia.

AMD Instinct MI300A APU

AMD Instinct MI325X GPU

AMD CDNA 2

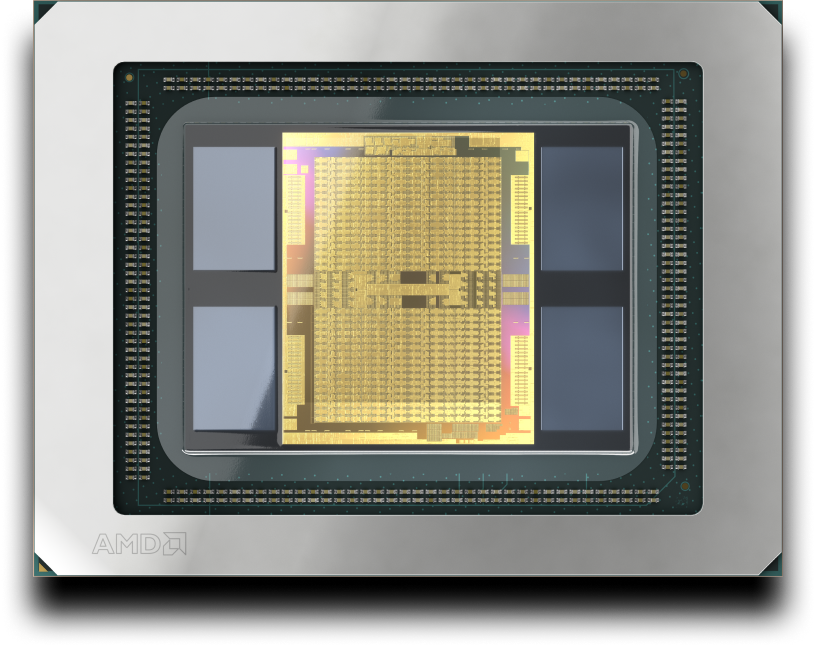

A arquitetura AMD CDNA 2 foi projetada para acelerar até mesmo as cargas de trabalho de computação científica e os aplicativos de aprendizado de máquina mais exigentes. Ela fundamenta as GPUs AMD Instinct Série MI200.

AMD CDNA

A arquitetura AMD CDNA é uma arquitetura dedicada para computação baseada em GPU que foi projetada para inaugurar a era da computação de classe Exascale. Ela fundamenta as GPUs AMD Instinct Série MI100.

Aceleradores AMD Instinct

Descubra como as GPUs AMD Instinct estão estabelecendo novos padrões para IA generativa, treinamento e computação de alto desempenho.

Software AMD ROCm™

A arquitetura AMD CDNA é compatível com o software AMD ROCm™, uma pilha de software aberta que inclui um amplo conjunto de modelos de programação, ferramentas, compiladores, bibliotecas e tempos de execução para o desenvolvimento de soluções de IA e computação de alto desempenho com foco nas GPUs AMD Instinct.