Übersicht

Die AMD CDNA™ Architektur ist die dedizierte Computing-Architektur, die als Grundlage der AMD Instinct™ GPUs und APUs dient. Sie verfügt über ein fortschrittliches Gehäuse, das AMD Chiplet-Technologien und High-Bandwidth-Memory (HBM), eine Infinity Architecture Fabric mit hohem Durchsatz, vereint, und bietet fortschrittliche Matrix Core Technologie, die eine umfassende Reihe von KI- und HPC-Datenformaten unterstützt. So wird der Overhead für Datenbewegungen reduziert und die Energieeffizienz erhöht.

Vergleich der Generationen im Tabellenformat:

| CDNA | CDNA 2 | CDNA 3 | CDNA 4 | |

| Prozesstechnologie | 7 nm FinFET | 6 nm FinFET | 5 nm + 6 nm FinFET | 3 nm + 6 nm FinFET |

| Transistoren | 25,6 Milliarden | Bis zu 58 Milliarden | Bis zu 146 Milliarden | Bis zu 185 Milliarden |

| CUs | Matrixkerne | 120 | 440 | Bis zu 220 | 880 | Bis zu 304 | 1216 | 256 | 1024 |

| Speichertyp | 32 GB HBM2 | Bis zu 128 GB HBM2E | Bis zu 256 GB HBM3 | HBM3E | 288 GB HBM3E |

| Speicherbandbreite (Spitze) | 1,2 TB/s | Bis zu 3,2 TB/s | Bis zu 6 TB/s | 8 TB/s |

| AMD Infinity Cache™ | k. A. | k. A. | 256 MB | 256 MB |

| GPU-Kohärenz | k. A. | Cache | Cache und HBM | Cache und HBM |

| Unterstützung für Datentypen | INT4, INT8, BF16, FP16, FP32, FP64 | INT4, INT8, BF16, FP16, FP32, FP64 | Matrix: INT8, FP8, BF16, FP16, TF32, FP32, FP64 Vektor: FP16, FP32, FP64 Sparsity: INT8, FP8, BF16, FP16 |

Matrix: MXFP4, MXFP6, INT8, MXFP8, OCP FP8, BF16, FP16, TF32*, FP32, FP64 Vektor: FP16, FP32, FP64 Sparsity: OCP-FP8, INT8, FP16, BF16 |

| Produkte | AMD Instinct™ MI100-Serie | AMD Instinct™ MI200-Serie | AMD Instinct™ MI300-Serie | AMD Instinct™ MI350-Serie |

* TF32 wird von der Softwareemulation unterstützt.

Vorteile

Matrix-Core-Technologien

AMD CDNA 4 bietet erweiterte Matrix Core Technologien, die den Rechendurchsatz für Matrix-Datentypen mit geringer Präzision im Vergleich zur Architektur der vorherigen Generation verdoppeln. AMD CDNA 4 bietet verbesserte Parallelität auf Anweisungsebene, erweitert gemeinsam genutzte LDS-Ressourcen mit doppelter Bandbreite und unterstützt eine breite Palette von Genauigkeiten, die jetzt MXFP4 und MXFP6 sowie Unterstützung von Sparse-Matrix-Daten (d. h. Sparsity) für OCP-FP8, INT8, FP16 und BF16 umfassen.

Verbesserte KI-Beschleunigung

AMD CDNA 4 bietet neue verbesserte KI-Beschleunigungsfunktionen für LLMs, darunter verbesserte GEMM-Performance mit reduzierter Latenz, Energieeffizienz mit Angeboten mit geringerer Genauigkeit und mehr Flexibilität für KI-Projekte mit gemischter Genauigkeit, die auf der Abstimmung zwischen Modellgenauigkeit, Geschwindigkeit oder Energieeffizienz basieren.

HBM Speicher, Cache und Kohärenz

AMD Instinct MI350-Serie GPUs bieten eine branchenführende HBM3E-Speicherkapazität von 256 GB zur Unterstützung größerer Modelle mit der erforderlichen Bandbreite sowie einen gemeinsam genutzten Speicher und AMD Infinity Cache™ (gemeinsam genutzter Last-Level-Cache), wodurch Datenkopien entfallen und die Latenz verbessert wird.

Vereinheitlichtes Fabric

Die AMD Infinity Architektur der nächsten Generation zusammen mit der AMD Infinity Fabric™ Technologie ermöglicht eine kohärente, durchsatzstarke Vereinheitlichung der AMD GPU Chiplet-Technologie mit gestapeltem HBM3E-Speicher in einzelnen Geräten und über Plattformen mit mehreren Geräten hinweg. Sie bietet auch erweiterten E/A mit PCIe® 5 Kompatibilität.

Wir stellen vor: AMD CDNA™ 4

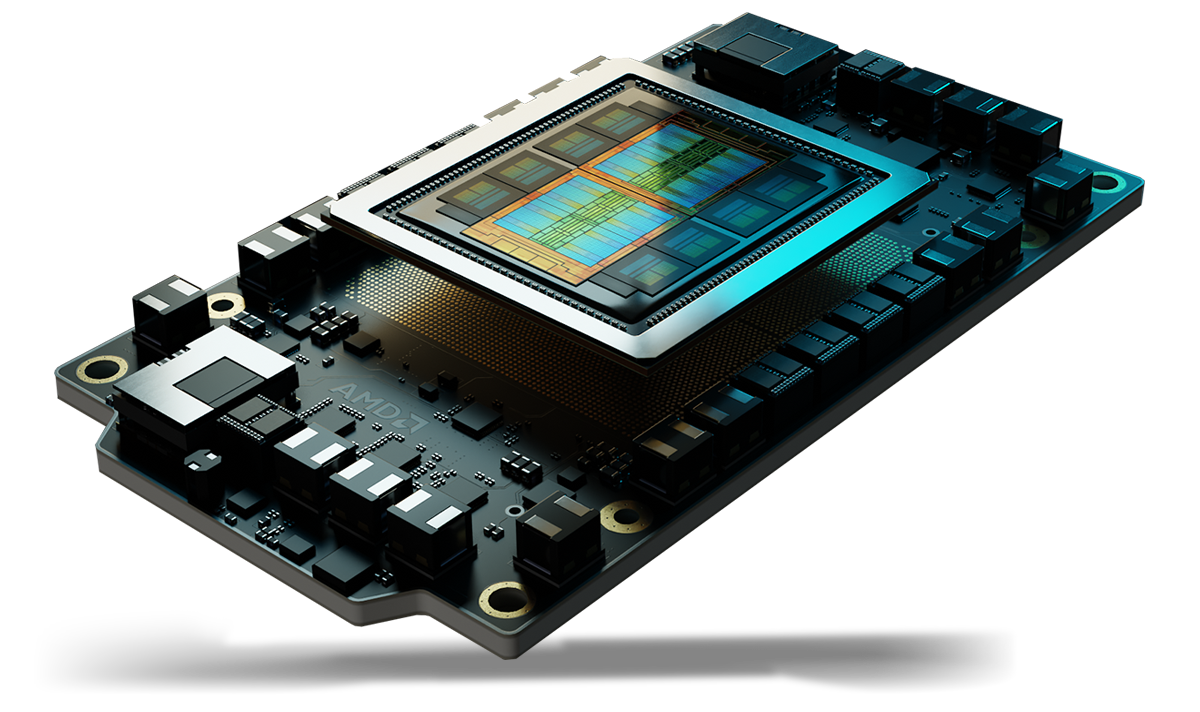

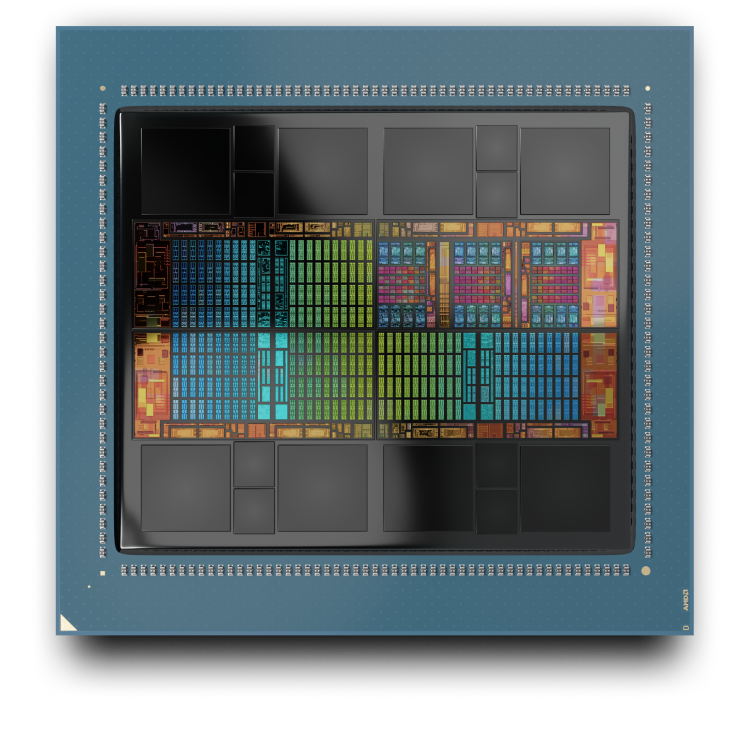

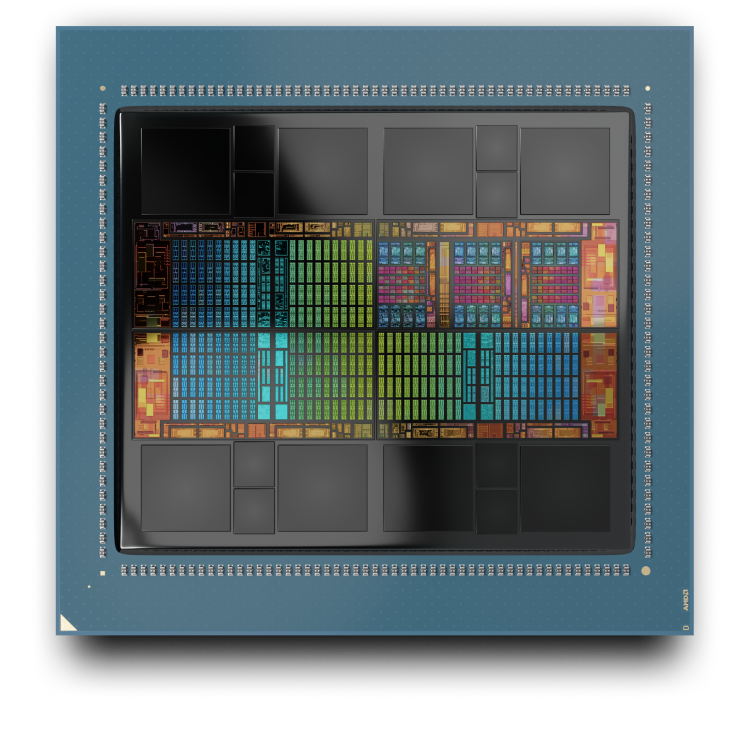

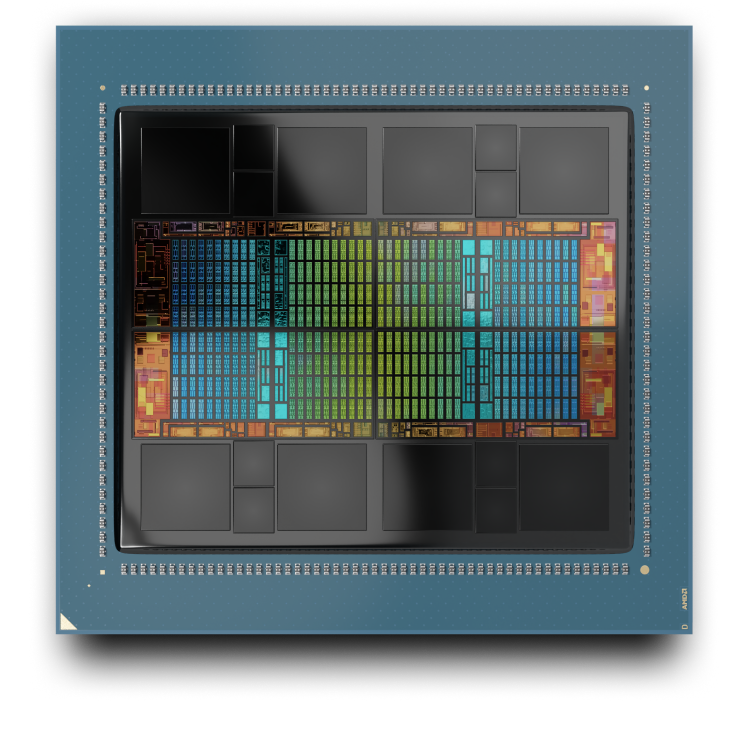

AMD CDNA™ 4 ist die dedizierte Computing-Architektur, die als Grundlage der AMD Instinct™ MI350-Serie GPUs dient. Sie beinhaltet ein fortschrittliches Paket mit Chiplet-Technologien – entwickelt, um den Overhead bei der Datenübertragung zu verringern und die Energieeffizienz zu verbessern.

AMD Instinct MI350-Serie GPUs

AMD CDNA 3

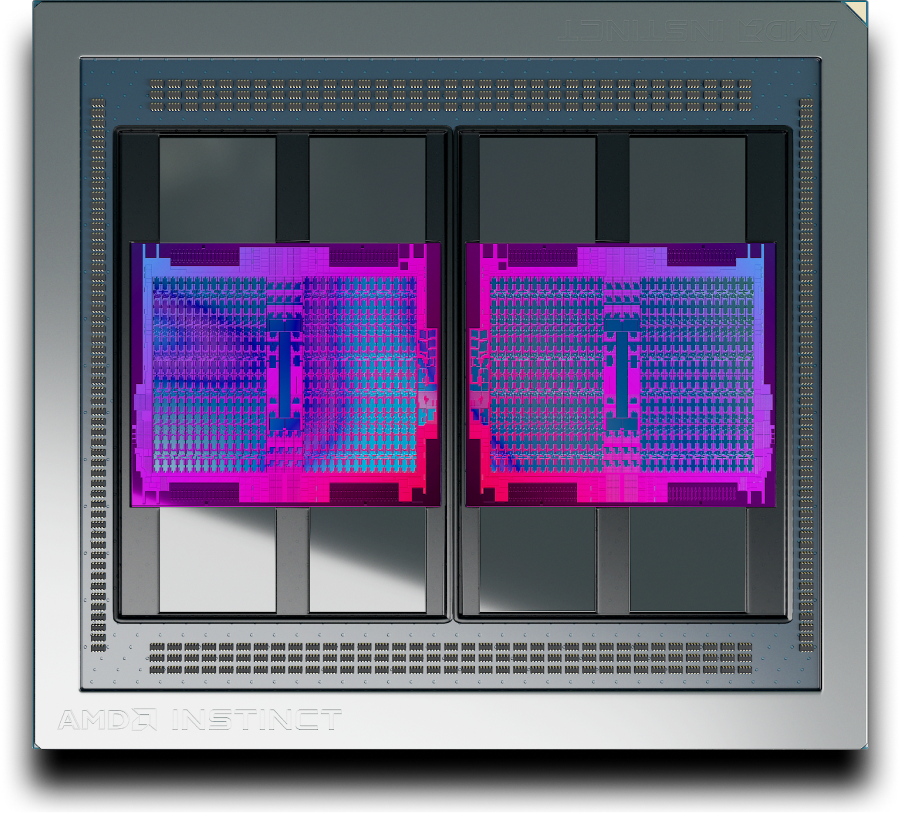

Die AMD CDNA 3 Architektur ist die dedizierte Computing-Architektur, die als Grundlage der AMD Instinct™ MI300-Serie GPUs dient. Sie beinhaltet ein fortschrittliches Paket mit Chiplet-Technologien – entwickelt, um den Overhead bei der Datenübertragung zu verringern und die Energieeffizienz zu verbessern.

AMD Instinct MI300A APU

AMD Instinct MI325X GPU

AMD CDNA 2

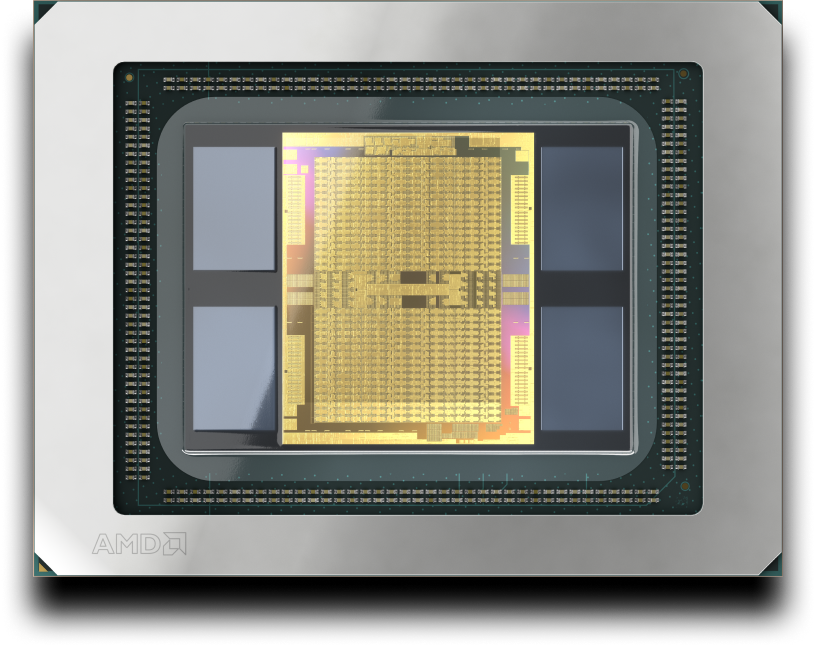

Die AMD CDNA 2 Architektur ist für die anspruchsvollsten wissenschaftlichen Computing-Auslastungen und Anwendungen für maschinelles Lernen konzipiert. Sie basiert auf den AMD Instinct MI200-Serie GPUs.

AMD CDNA

Die AMD CDNA Architektur ist eine dedizierte Architektur für GPU-basiertes Computing, die entwickelt wurde, um die Ära des Exascale-Computings einzuläuten. Sie basiert auf den AMD Instinct MI100-Serie GPUs.

AMD Instinct Beschleuniger

Erfahren Sie, wie AMD Instinct GPUs neue Standards für generative KI, Training und HPC setzen.

AMD ROCm™ Software

Die AMD CDNA Architektur wird durch die AMD ROCm™ Software unterstützt, einen offenen Software-Stack, der zahlreiche Programmiermodelle, Tools, Compiler, Bibliotheken und Laufzeiten für die Entwicklung von KI- und HPC-Lösungen für AMD Instinct GPUs beinhaltet.