개요

AMD CDNA™ 아키텍처는 AMD Instinct™ GPU 및 APU의 기반이 되는 전용 컴퓨팅 아키텍처입니다. 이 제품은 AMD 칩렛 기술과 처리율이 높은 Infinity 아키텍처 패브릭인 HBM(고대역폭 메모리)을 통합하는 고급 패키징을 갖추고 있으며, 데이터 이동 오버헤드를 줄이고 전력 효율을 높이기 위해 설계된 포괄적인 AI 및 HPC 데이터 형식을 지원하는 고급 Matrix Core 기술을 제공합니다.

세대 간 비교표:

| CDNA | CDNA 2 | CDNA 3 | CDNA 4 | |

| 처리 기술 | 7nm FinFET | 6nm FinFET | 5nm + 6nm FinFET | 3nm + 6nm FinFET |

| 트랜지스터 | 256억 개 | 최대 580억 개 | 최대 1460억 개 | 최대 1850억 개 |

| CU | Matrix Core | 120 | 440 | 최대 220 | 880 | 최대 304 | 1216 | 256 | 1024 |

| 메모리 유형 | 32GB HBM2 | 최대 128GB HBM2E | 최대 256GB HBM3 | HBM3E | 288GB HBM3E |

| 메모리 대역폭(최고치) | 1.2TB/s | 최대 3.2TB/초 | 최대 6TB/초 | 8TB/s |

| AMD Infinity Cache™ | 해당 없음 | 해당 없음 | 256MB | 256MB |

| GPU 일관성 | 해당 없음 | 캐시 | 캐시 및 HBM | 캐시 및 HBM |

| 데이터 형식 지원 | INT4, INT8, BF16, FP16, FP32, FP64 | INT4, INT8, BF16, FP16, FP32, FP64 | Matrix: INT8, FP8, BF16, FP16, TF32, FP32, FP64 Vector: FP16, FP32, FP64 Sparsity: INT8, FP8, BF16, FP16 |

Matrix: MXFP4, MXFP6, INT8, MXFP8, OCP FP8, BF16, FP16, TF32*, FP32, FP64 Vector: FP16, FP32, FP64 Sparsity: OCP-FP8, INT8, FP16, BF16 |

| 제품 | AMD Instinct™ MI100 시리즈 | AMD Instinct™ MI200 시리즈 | AMD Instinct™ MI300 시리즈 | AMD Instinct™ MI350 시리즈 |

*TF32는 소프트웨어 에뮬레이션에 의해 지원됩니다.

혜택

Matrix Core 기술

AMD CDNA 4는 이전 세대 아키텍처와 비교하여 정밀도가 낮은 Matrix 데이터 유형의 연산 처리율을 두 배로 높여주는 향상된 Matrix Core 기술을 제공합니다. AMD CDNA 4는 명령 수준 병렬화를 개선하고, 대역폭을 두 배로 늘려 공유 LDS 리소스를 확장하며, 이제 MXFP4, MXFP6 등 광범위한 정밀도 지원과 함께 OCP-FP8, INT8, FP16, BF16 지원을 위한 희소 Matrix 데이터(예: Sparsity) 지원을 포함합니다.

강화된 AI 가속화

AMD CDNA 4는 지연 시간이 감소하는 개선된 GEMM 성능, 낮은 정밀도를 제공하는 전력 효율성, 모델 정확도, 속도 또는 전력 효율성 간의 우선 순위 균형을 기반으로 혼합된 정밀 AI 프로젝트의 향상된 유연성이 포함하여 LLM을 위한 향상된 AI 가속화 기능을 제공합니다.

HBM 메모리, 캐시 및 일관성

AMD Instinct MI350 시리즈 GPU는 모든 대역폭의 대규모 모델 크기를 지원하는 데 필요한 업계 최고의 256GB HBM3E 메모리 용량과 공유 메모리, AMD Infinity Cache™(공유된 Last Level 캐시)를 제공하므로 데이터 복제가 없고 지연 시간이 개선됩니다.

통합 패브릭

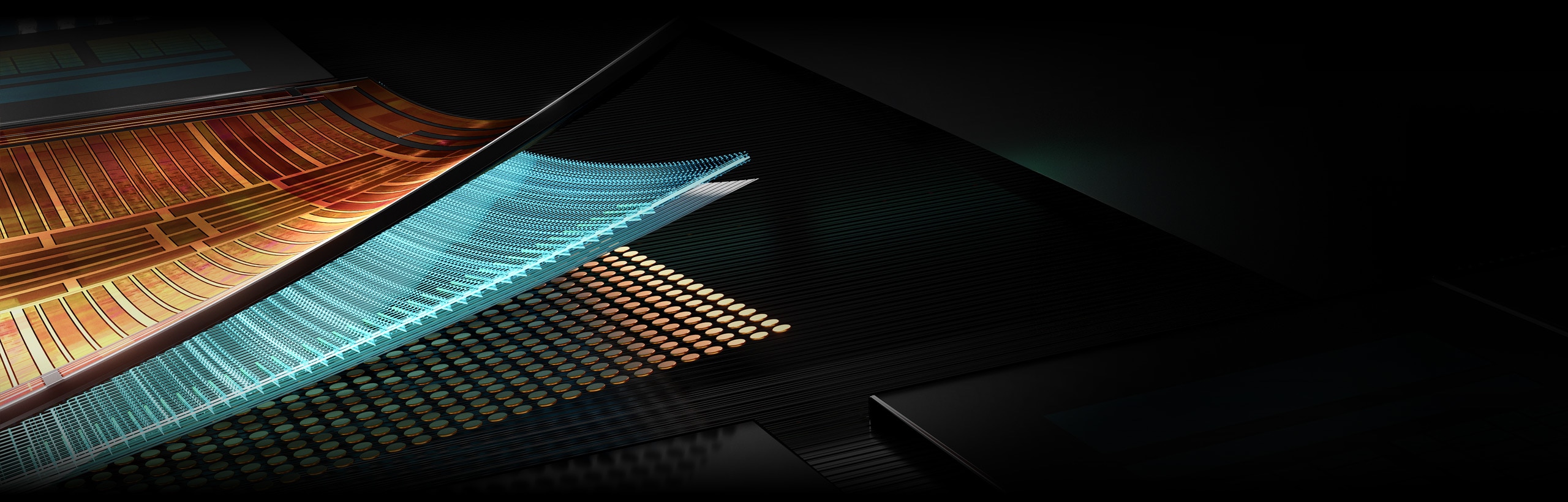

차세대 AMD Infinity 아키텍처는 AMD Infinity Fabric™ 기술과 함께 단일 장치 및 다중 장치 플랫폼에서 스택형 HBM3E 메모리를 사용하여 AMD GPU 칩렛 기술을 일관된 높은 처리율로 통합할 수 있습니다. 또한 PCIe® 5 호환성을 통해 강화된 I/O를 제공합니다.

AMD CDNA™ 4 소개

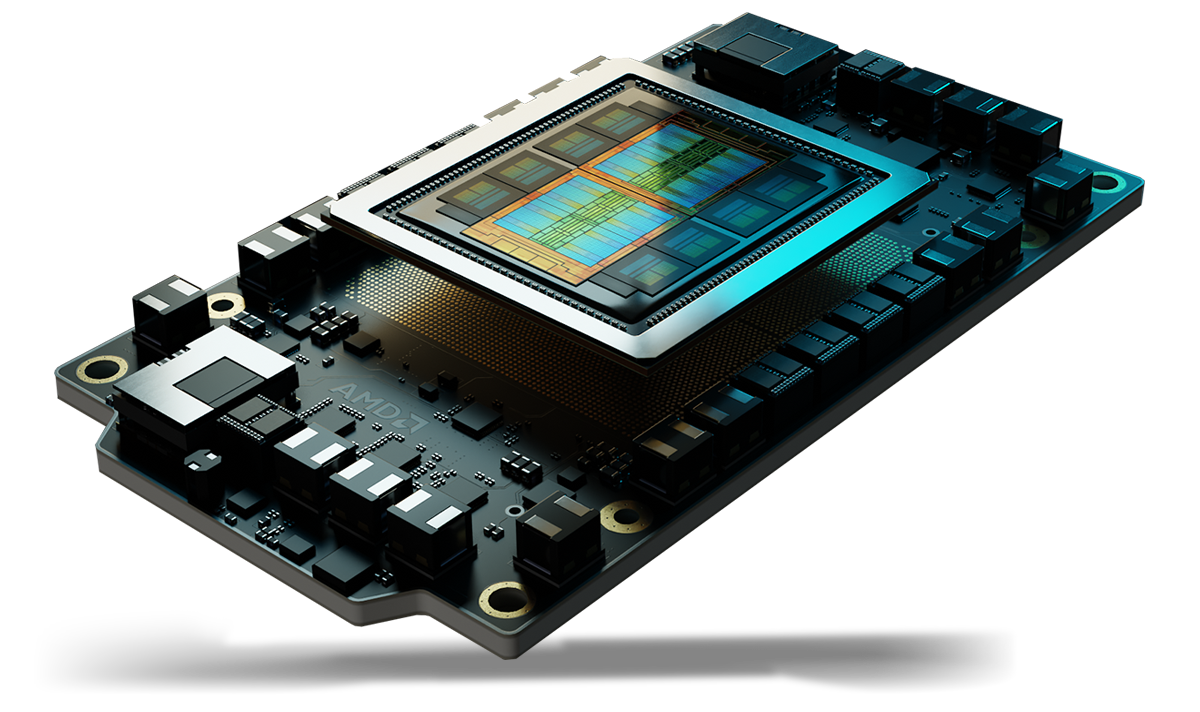

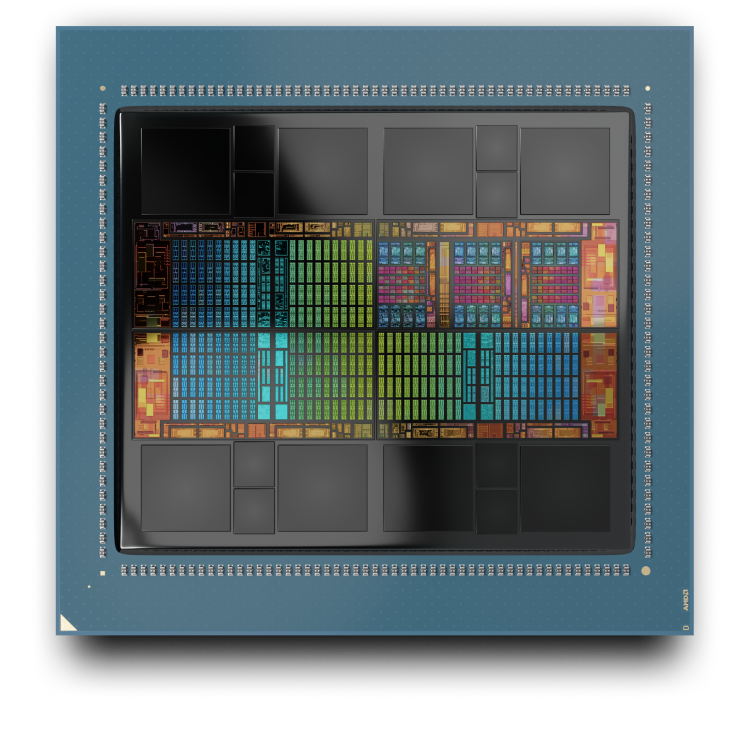

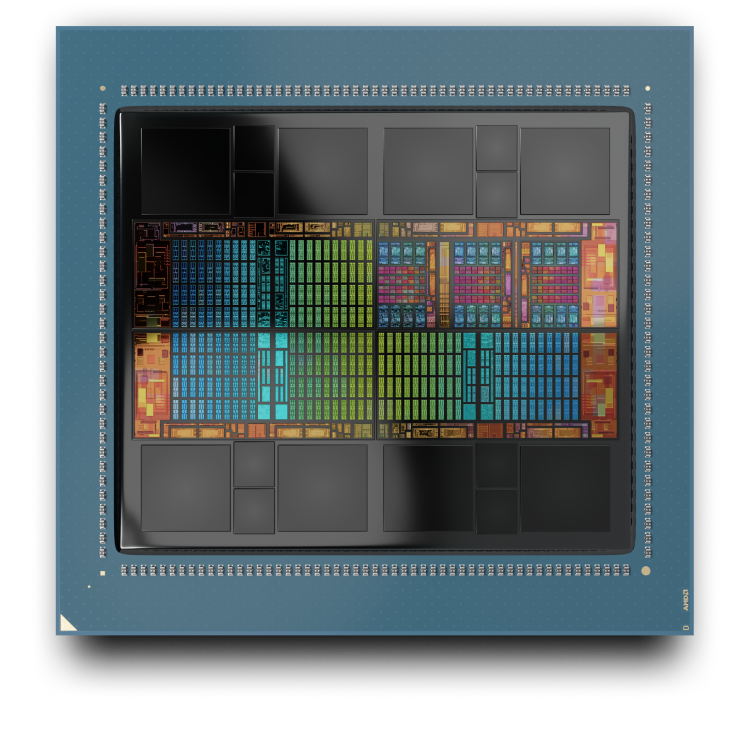

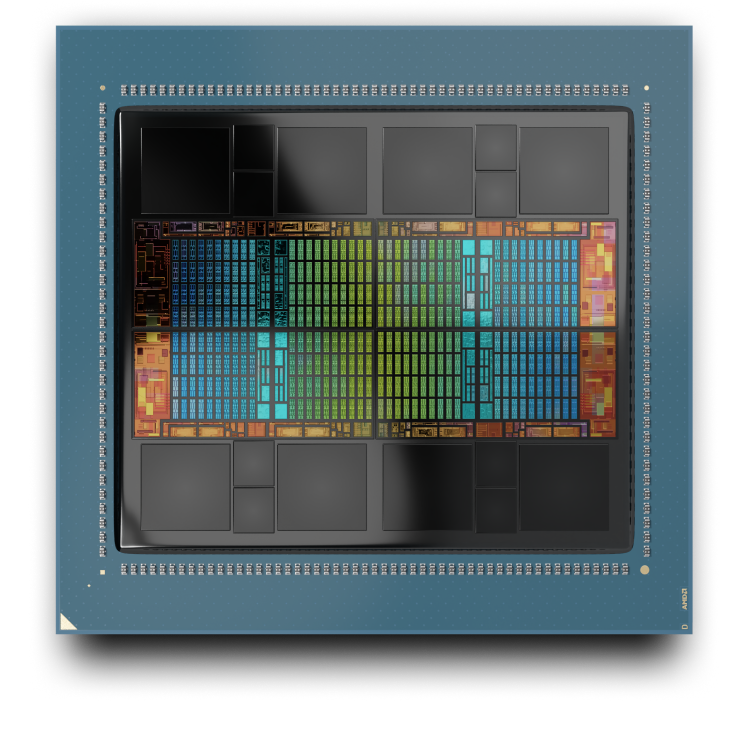

AMD CDNA™ 4는 AMD Instinct™ MI350 시리즈 GPU의 기반이 되는 전용 컴퓨팅 아키텍처입니다. 데이터 이동 오버헤드를 줄이고 전력 효율을 높이도록 설계된 칩렛 기술을 사용한 고급 패키징을 특징으로 합니다.

AMD Instinct MI350 시리즈 GPU

AMD CDNA 3

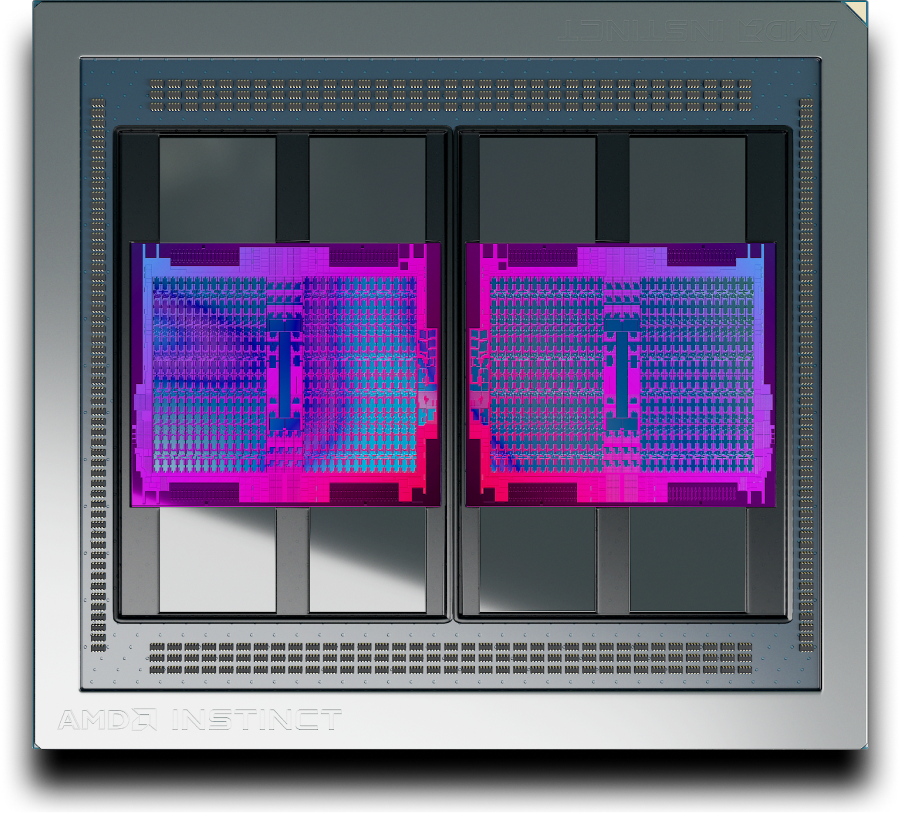

AMD CDNA 3는 AMD Instinct™ MI300 시리즈 GPU의 기반이 되는 전용 컴퓨팅 아키텍처입니다. 데이터 이동 오버헤드를 줄이고 전력 효율을 높이도록 설계된 칩렛 기술을 사용한 고급 패키징을 특징으로 합니다.

AMD Instinct MI300A APU

AMD Instinct MI325X GPU

AMD CDNA 2

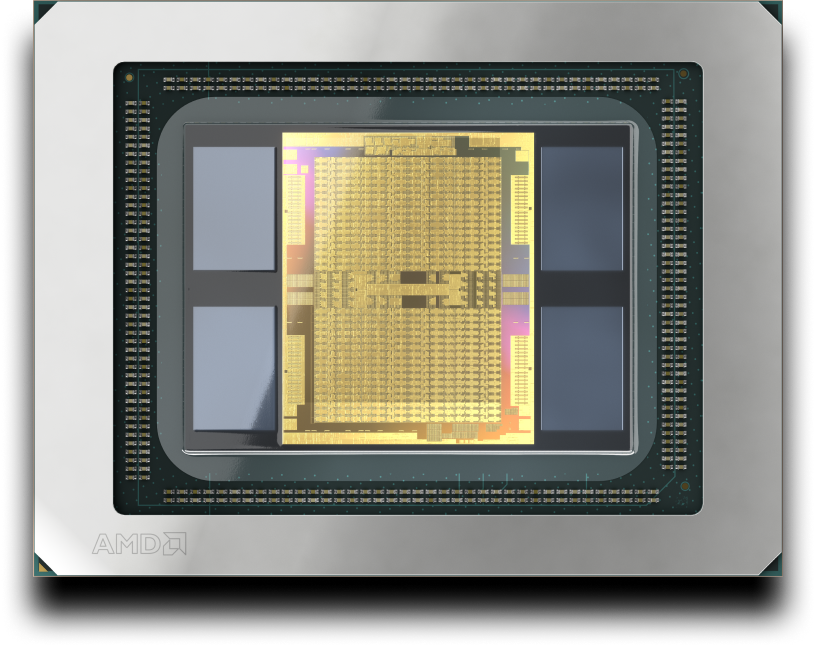

AMD CDNA 2 아키텍처는 가장 까다로운 과학 컴퓨팅 워크로드 및 머신러닝 애플리케이션도 가속화하도록 설계되었습니다. 이 아키텍처는 AMD Instinct MI200 시리즈 GPU의 기반이 됩니다.

AMD CDNA

AMD CDNA 아키텍처는 엑사스케일급 컴퓨팅 시대를 열도록 설계된 GPU 기반 컴퓨팅 전용 아키텍처입니다. 이 아키텍처는 AMD Instinct MI100 시리즈 GPU의 기반이 됩니다.

AMD Instinct 가속기

AMD Instinct GPU가 어떻게 생성형 AI, 학습, HPC에 대한 새로운 표준을 수립하고 있는지 알아보세요.

AMD ROCm™ 소프트웨어

AMD CDNA 아키텍처는 AMD Instinct GPU를 대상으로 하는 AI 및 HPC 솔루션 개발을 위한 광범위한 프로그래밍 모델, 도구, 컴파일러, 라이브러리, 런타임 세트가 포함된 개방형 소프트웨어 스택인 AMD ROCm™ 소프트웨어에서 지원됩니다.