AI 및 HPC 강화

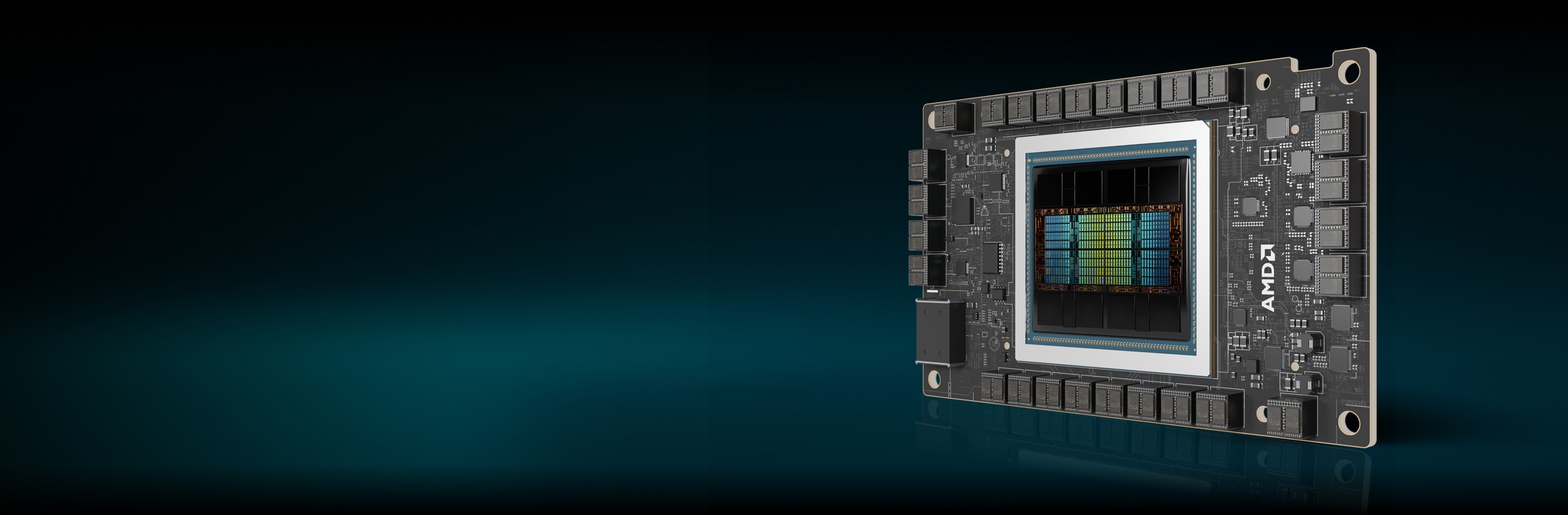

AMD Instinct™ MI300 시리즈 가속기는 특히 가장 까다로운 AI 및 HPC 워크로드를 지원하는 데 매우 적합하며, 탁월한 컴퓨팅 성능, 고대역폭 대용량 메모리 밀도, 특수 데이터 포맷 지원을 제공합니다.

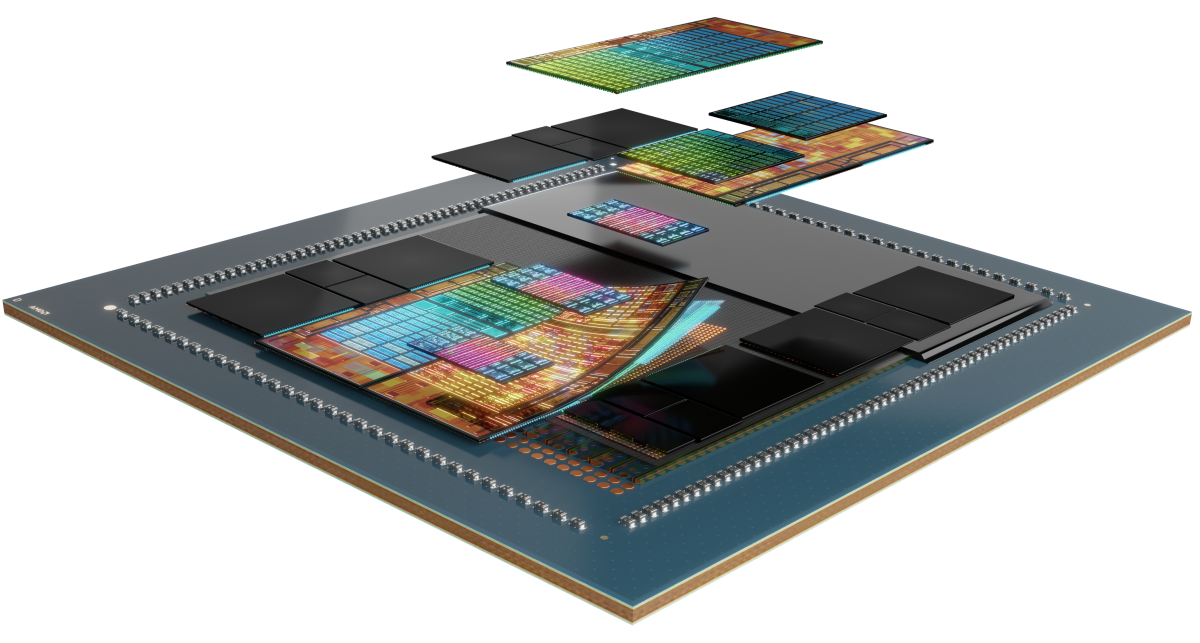

후드 밑

AMD Instinct MI300 시리즈 가속기는 AMD CDNA™ 3 아키텍처를 기반으로 구축되어 매트릭스 코어 기술과 고효율 INT8 및 FP8부터(AI를 위한 스파시티 지원 포함) 가장 까다로운 HPC용 FP64에 이르기까지 다양한 정밀 기능에 대한 지원을 제공합니다.

시리즈 살펴보기

AMD Instinct MI300 시리즈 가속기, AMD Instinct MI300 시리즈 플랫폼, AMD Instinct MI300A APU를 살펴보세요.

AMD Instinct™ MI325X 가속기 소개

AMD Instinct™ MI325X GPU 가속기는 3세대 AMD CDNA™ 아키텍처로 AI 성능의 새로운 표준을 설정하고, 학습 및 추론을 위한 놀라운 성능과 효율성을 제공합니다. 업계 최고의 256GB HBM3E 메모리와 6TB/s 대역폭을 통해 성능을 최적화하고 TCO를 절감할 수 있습니다.1

304개의 CU

GPU 컴퓨팅 유닛 304개

256GB

256GB HBM3E 메모리

6TB/s

6TB/s 피크 이론상 메모리 대역폭

스펙 비교

- AI 성능

- HPC 성능

- 메모리

AI 성능(피크 TFLOPs)

경쟁사 가속기 대비 최대 1.3배의 AI 성능2, 3

H200 SXM 141GB

MI325X OAM 256GB

HPC 성능(피크 TFLOPs)

경쟁사 가속기 대비 최대 2.4배의 HPC 성능3

H200 SXM 141GB

MI325X OAM 256GB

메모리 용량 및 대역폭

경쟁사 가속기 대비 1.8배의 메모리 용량 및 1.2배의 메모리 대역폭1

H200 SXM 141GB

MI325X OAM 256GB

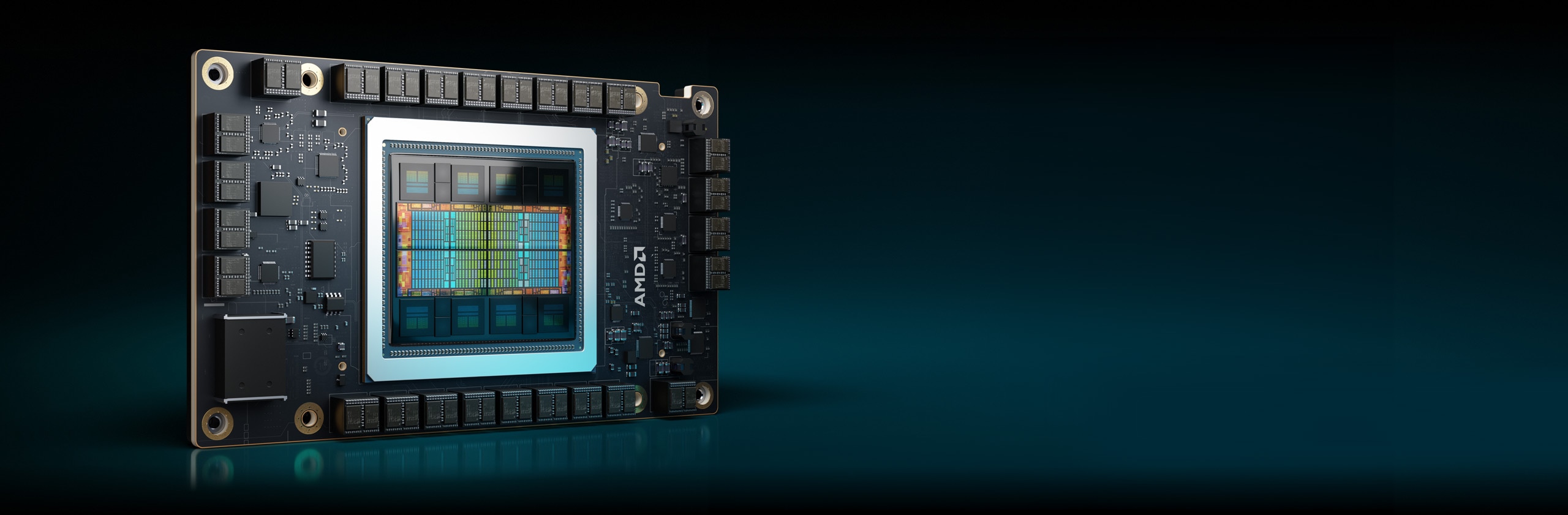

Instinct MI300X 가속기

AMD Instinct MI300X 시리즈 가속기는 생성형 AI 워크로드 및 HPC 애플리케이션에 최고의 성능을 제공하도록 설계되었습니다.

304개의 CU

GPU 컴퓨팅 유닛 304개

192GB

192GB HBM3 메모리

5.3TB/s

5.3TB/s 피크 이론상 메모리 대역폭

AI 성능(피크 TFLOPs)

경쟁사 가속기 대비 최대 1.3배의 AI 성능6

HPC 성능(피크 TFLOPs)

경쟁사 가속기 대비 최대 2.4배의 HPC 성능7

메모리 용량 및 대역폭

경쟁사 가속기 대비 2.4배의 메모리 용량 및 1.6배의 피크 이론상 메모리 대역폭8

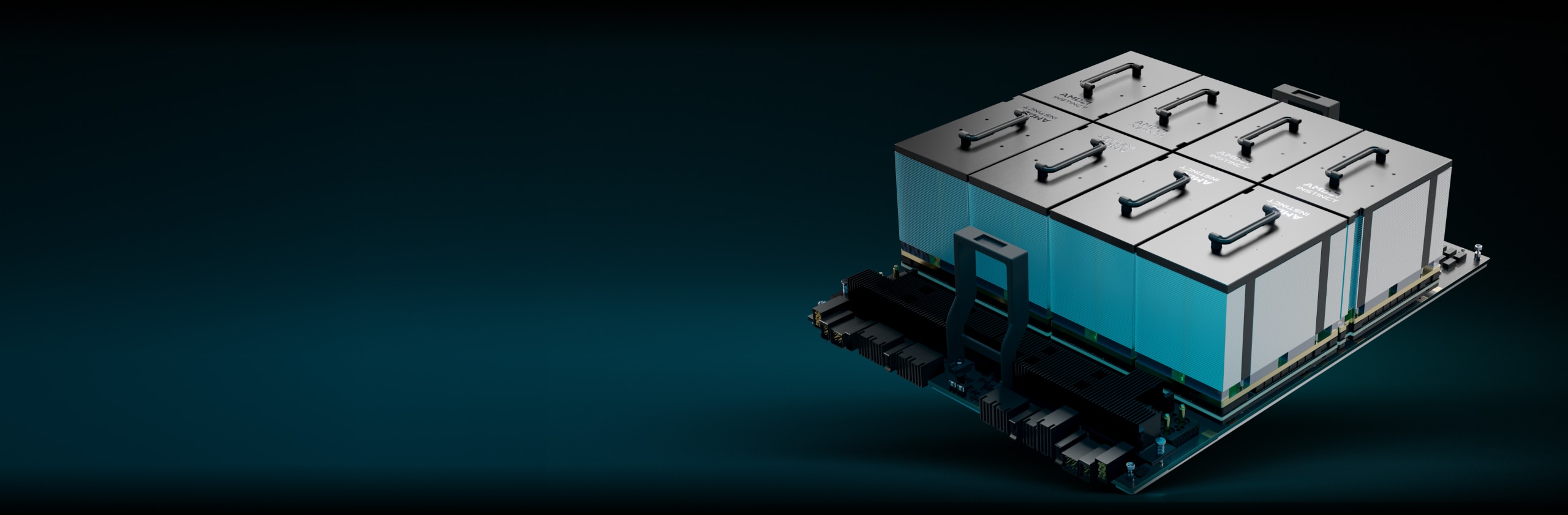

AMD Instinct 플랫폼

AMD Instinct MI325X 플랫폼은 4세대 AMD Infinity Fabric™ 링크를 통해 8개의 완전 연결된 MI325X GPU OAM 모듈을 업계 표준 OCP 설계에 통합하여 낮은 지연율의 AI 프로세싱을 위해 최대 2TB HBM3E 용량을 제공합니다. 즉시 배포 가능한 이 플랫폼은 기존 AI 랙 및 서버 인프라에 MI325X 가속기를 추가하면 출시 기간을 단축하고 개발 비용을 절감할 수 있습니다.

MI325X 8개

MI325X GPU OAM 모듈 8개

2TB

총 2TB HBM3E 메모리

48TB/s

48TB/s 피크 이론상 총 메모리 대역폭

AMD Instinct MI300A APU

AMD Instinct MI300A 가속 프로세싱 유닛(APU)은 AMD Instinct 가속기와 AMD EPYC™ 프로세서의 성능을 공유 메모리와 결합하여 효율성, 유연성 및 프로그래밍 가능성을 실현합니다. AI와 HPC의 융합을 가속화하여 연구를 발전시키고 새로운 발견을 추진하도록 설계되었습니다.

228개의 CU

GPU 컴퓨팅 유닛 228개

24

"Zen 4" x86 CPU 코어 24개

128GB

128GB 통합 HBM3 메모리

5.3TB/s

5.3TB/s 피크 이론상 메모리 대역폭

AI 성능(피크 TFLOPs)11

HPC 성능(피크 TFLOPs)

경쟁사 가속기 대비 최대 1.8배의 HPC 성능12

메모리 용량 및 대역폭

경쟁사 가속기 대비 2.4배의 메모리 용량 및 1.6배의 피크 이론상 메모리 대역폭13

엑사스케일 컴퓨팅 발전

AMD Instinct 가속기는 Lawrence Livermore 국립연구소의 El Capitan 시스템을 비롯한 세계 최고의 슈퍼컴퓨터를 구동합니다. 이 2 엑사스케일 슈퍼컴퓨터가 어떻게 AI를 사용하여 최초의 시뮬레이션을 실행하고 과학 연구를 발전시키는지 알아보세요.

AMD ROCm™ 소프트웨어

AMD ROCm™ 소프트웨어에는 AMD Instinct 가속기를 대상으로 하는 AI 모델 및 HPC 워크로드를 위한 광범위한 프로그래밍 모델, 도구, 컴파일러, 라이브러리 및 런타임 세트가 포함되어 있습니다.

사례 연구

솔루션 찾기

AMD Instinct 가속기 기반 솔루션을 제공하는 파트너를 찾아보세요.

리소스

새로운 정보를 놓치지 마세요

최신 데이터 센터 소식과 서버 관련 콘텐츠를 받으려면 등록하세요.

각주

- MI325-001A - 2024년 9월 26일 현재 AMD 퍼포먼스 랩에서 현재 사양 및/또는 추정치를 기준으로 수행한 계산입니다. AMD Instinct™ MI325X OAM 가속기는 256GB HBM3E 메모리 용량과 6TB/s GPU의 이론상 최대 메모리 대역폭 성능을 제공합니다. 프로덕션 실리콘에 따라 실제 결과는 다를 수 있습니다.

Nvidia Hopper H200(141GB) SXM GPU 가속기에 대해 게시된 최고 결과는 141GB HBM3E 메모리 용량 및 4.8TB/s GPU 메모리 대역폭 성능입니다. https://nvdam.widen.net/s/nb5zzzsjdf/hpc-datasheet-sc23-h200-datasheet-3002446

Nvidia Blackwell HGX B100(192GB) 700W GPU 가속기에 대해 게시된 최고 결과는 192GB HBM3e 메모리 용량 및 8TB/s GPU 메모리 대역폭 성능입니다.

Nvidia Blackwell HGX B200(192GB) GPU 가속기에 대해 게시된 최고 결과는 192GB HBM3E 메모리 용량 및 8TB/s GPU 메모리 대역폭 성능입니다.

Nvidia Blackwell 사양은 다음 페이지에서 확인할 수 있습니다. https://resources.nvidia.com/en-us-blackwell-architecture?_gl=1*1r4pme7*_gcl_aw*R0NMLjE3MTM5NjQ3NTAuQ2p3S0NBancyNkt4QmhCREVpd0F1NktYdDlweXY1dlUtaHNKNmhPdHM4UVdPSlM3dFdQaE40WkI4THZBaWFVajFy

- MI325-002 - 2024년 5월 28일 AMD 퍼포먼스 랩에서 AMD Instinct™ MI325X GPU에 대해 수행한 계산 결과 1307.4TFLOPS 이론상 최대 반정도(FP16), 1307.4TFLOPS 이론상 최대 Bfloat16 포맷 정도(BF16), 2614.9TFLOPS 이론상 최대 8비트 정도(FP8), 2614.9TOPs INT8 부동 소수점 성능이 나타났습니다. 실제 성능은 최종 사양 및 시스템 구성에 따라 달라집니다.

Nvidia H200 SXM(141GB) GPU에 대해 게시된 결과: 989.4TFLOPS 이론상 최대 반정도 텐서(FP16 텐서), 989.4TFLOPS 이론상 최대 Bfloat16 텐서 포맷 정도(BF16 텐서), 1,978.9TFLOPS 이론상 최대 8비트 정도(FP8), 1,978.9TOPs 이론상 최대 INT8 부동 소수점 성능. Nvidia는 BFLOAT16 텐서 코어, FP16 텐서 코어, FP8 텐서 코어, INT8 텐서 코어 성능을 스파시티를 사용해 게시했습니다. AMD는 비교를 위해 이 숫자를 2로 나누어 비스파시티/밀도로 변환했으며 이러한 숫자는 상단에 나와 있습니다.

Nvidia H200 출처: https://nvdam.widen.net/s/nb5zzzsjdf/hpc-datasheet-sc23-h200-datasheet-3002446 및 https://www.anandtech.com/show/21136/nvidia-at-sc23-h200-accelerator-with-hbm3e-and-jupiter-supercomputer-for-2024

참고: Nvidia H200 GPU는 H100 제품과 동일한 FLOP 성능이 게시되었습니다(https://resources.nvidia.com/en-us-tensor-core/). MI325-02

- MI325-008 - 2024년 10월 2일 기준, AMD 퍼포먼스 랩이 AMD CDNA™ 3 5nm | 6nm FinFET 공정 기술로 설계된 AMD Instinct™ MI325X(1000W) GPU를 대상으로 2,100MHz 최대 부스트 엔진 클럭에서 측정한 결과 163.4TFLOPS의 이론상 최대 배정도 매트릭스(FP64 매트릭스), 81.7TFLOPS의 이론상 최대 배정도(FP64), 163.4TFLOPS의 이론상 최대 단정도 매트릭스(FP32 매트릭스), 163.4TFLOPS의 이론상 최대 단정도(FP32), 653.7TFLOPS의 이론상 최대 TensorFloat-32(TF32), 1307.4TFLOPS의 이론상 최대 반정도(FP16)의 성능을 기록했습니다. 실제 성능은 최종 사양과 시스템 구성에 따라 달라질 수 있습니다.

Nvidia H200 SXM(141GB) GPU에 대해 게시된 결과: 66.9TFLOPS의 최대 이론상 배정도 텐서(FP64 텐서), 33.5TFLOPS의 최대 이론상 배정도(FP64), 66.9TFLOPS의 이론상 최대 단정도(FP32), 494.7TFLOPS의 최대 TensorFloat-32(TF32), 989.5TFLOPS의 이론상 최대 반정도 텐서(FP16 텐서). Nvidia는 TF32 텐서 코어 성능을 스파시티를 사용해 게시했습니다. AMD는 비교를 위해 이 숫자를 2로 나누어 비스파시티/밀도 값으로 변환했으며, 이 숫자는 상단에 나와 있습니다.

Nvidia H200 출처: https://nvdam.widen.net/s/nb5zzzsjdf/hpc-datasheet-sc23-h200-datasheet-3002446 및 https://www.anandtech.com/show/21136/nvidia-at-sc23-h200-accelerator-with-hbm3e-and-jupiter-supercomputer-for-2024

참고: Nvidia H200 GPU는 H100 제품과 동일한 FLOP 성능이 게시되었습니다(https://resources.nvidia.com/en-us-tensor-core/).

* Nvidia H200 GPU는 FP32 텐서를 지원하지 않습니다.

- 2023년 11월 11일 기준, AMD 퍼포먼스 랩이 AMD CDNA™ 3 5nm | 6nm FinFET 공정 기술로 설계된 AMD Instinct™ MI300X(750W) GPU를 대상으로 2,100MHz 최대 부스트 엔진 클럭에서 측정한 결과 653.7TFLOPS의 이론상 최대 TensorFloat-32(TF32), 1307.4TFLOPS의 이론상 최대 반정도(FP16), 1307.4TFLOPS의 이론상 최대 Bfloat16 포맷 정도(BF16), 2614.9TFLOPS의 이론상 최대 8비트 정도(FP8), 2614.9TOPs의 INT8 부동 소수점 성능을 기록했습니다. MI300X는 정교한 조직 구조 스파시티를 활용해 수학 연산 효율을 약 2배 향상할 것으로 예상되며 1,307.4TFLOPS의 이론상 최대 TensorFloat-32(TF32), 2,614.9TFLOPS의 이론상 최대 반정도(FP16), 2,614.9TFLOPS의 이론상 최대 Bfloat16 포맷 정도(BF16), 5,229.8TFLOPS의 이론상 최대 8비트 정도(FP8), 스파시티 사용 시 5,229.8TOPS의 INT8 부동 소수점 성능을 기록했습니다. AMD CDNA™ 2 5nm FinFET 공정 기술로 설계된 AMD Instinct™ MI250X(560W) 128GB HBM2e OAM 가속기를 대상으로 1,700MHz 최대 부스트 엔진 클럭에서 계산한 결과 TF32*(해당 없음), 383.0TFLOPS의 이론상 최대 반정도(FP16), 383.0TFLOPS의 이론상 최대 Bfloat16 포맷 정도(BF16), FP8*(해당 없음), 383.0TOPs의 INT8 부동 소수점 성능을 기록했습니다. *AMD Instinct MI200 시리즈 GPU는 TF32, FP8, 스파시티를 지원하지 않습니다. MI300-16

- 현재 사양 및/또는 내부 엔지니어링 계산에 대한 2023년 6월 2일 기준 내부 AMD 퍼포먼스 랩의 측정. Falcon-7B(7B, 40B 파라미터), Llama(13B, 33B 파라미터), OPT(66B 파라미터), GPT-3(175B 파라미터), BLOOM(176B 파라미터) 및 PaLM(340B, 540B 파라미터) 모델을 실행하는 데 필요한 최소 GPU 수를 결정하기 위해 FP16 정밀도로 거대 언어 모델(LLM)을 실행하거나 계산했습니다. 정의된 파라미터와 10% 오버헤드를 더한 모델에서 필요한 메모리 대비 GPU 전용 메모리 크기를 기준으로 계산된 추정치입니다. 계산은 게시된 메모리 크기와 때로는 예비 모델 메모리 크기에 따라 달라집니다. GPT-3, BLOOM 및 PaML 결과는 시스템/부품 가용성으로 인해 MI300X에서 추정됩니다. 테스트 결과 구성: EPYC 9654(96코어) CPU 1개와 AMD Instinct™ MI300X(192GB HBM3, OAM 모듈) 750W 가속기 1개로 구성된 AMD 랩 시스템

결과(FP16 정밀도):

모델

파라미터

총 필요 메모리

필요 MI300X

Falcon-7B

70억 개

15.4GB

1 실제

LLaMA

130억 개

44GB

1 실제

LLaMA

330억 개

72.5GB

1 실제

Falcon-40B

400억 개

88GB

1 실제

OPT

660억 개

145.2GB

1 실제

GPT-3

1,750억 개

385GB

3 계산됨

Bloom

1,760억 개

387.2GB

3 계산됨

PaLM

3,400억 개

748GB

4 계산됨

PaLM

5,400억 개

1188GB

7 계산됨

계산된 추정치는 최종 모델 크기에 따라 달라질 수 있습니다. 실제 및 추정치는 실제 필요한 오버헤드와 GPU 이상의 시스템 메모리 사용으로 인해 달라질 수 있습니다. 서버 제조업체마다 구성 서비스가 다양하여 다른 결과가 나올 수 있습니다. MI300-07

- 2023년 11월 11일 기준, AMD 퍼포먼스 랩이 AMD CDNA™ 3 5nm | 6nm FinFET 공정 기술로 설계된 AMD Instinct™ MI300X(750W) GPU를 대상으로 2,100MHz 최대 부스트 엔진 클럭에서 측정한 결과 653.7TFLOPS의 이론상 최대 TensorFloat-32(TF32), 1307.4TFLOPS의 이론상 최대 반정도(FP16), 1307.4TFLOPS의 이론상 최대 Bfloat16 포맷 정도(BF16), 2614.9TFLOPS의 이론상 최대 8비트 정도(FP8), 2614.9TOPs의 INT8 부동 소수점 성능을 기록했습니다. MI300X는 정교한 조직 구조 스파시티를 활용해 수학 연산 효율을 약 2배 향상할 것으로 예상되며 1,307.4TFLOPS의 이론상 최대 TensorFloat-32(TF32), 2,614.9TFLOPS의 이론상 최대 반정도(FP16), 2,614.9TFLOPS의 이론상 최대 Bfloat16 포맷 정도(BF16), 5,229.8TFLOPS의 이론상 최대 8비트 정도(FP8), 스파시티 사용 시 5,229.8TOPS의 INT8 부동 소수점 성능을 기록했습니다. Nvidia H100 SXM(80GB) 700W GPU에 대해 게시된 결과는 스파시티 사용 시 989.4TFLOPs의 최대 TensorFloat-32(TF32), 스파시티 사용 시 1,978.9TFLOPS의 이론상 최대 반정도(FP16), 스파시티 사용 시 1,978.9TFLOPS의 이론상 최대 Bfloat16 포맷 정도(BF16), 스파시티 사용 시 3,957.8TFLOPS의 이론상 최대 8비트 정도(FP8), 스파시티 부동 소수점 성능 사용 시 3,957.8TOPs의 이론상 최대 INT8을 기록했습니다. Nvidia H100 출처: https://resources.nvidia.com/en-us-tensor-core. MI300-17

- 2023년 11월 11일 기준, AMD 퍼포먼스 랩이 AMD CDNA™ 3 5nm | 6nm FinFET 공정 기술로 설계된 AMD Instinct™ MI300X(750W) GPU를 대상으로 2,100MHz 최대 부스트 엔진 클럭에서 측정한 결과 163.4TFLOPS의 이론상 최대 배정도 매트릭스(FP64 매트릭스), 81.7TFLOPS의 이론상 최대 배정도(FP64), 163.4TFLOPS의 이론상 최대 단정도 매트릭스(FP32 매트릭스), 163.4TFLOPS의 이론상 최대 단정도(FP32), 653.7TFLOPS의 이론상 최대 TensorFloat-32(TF32), 1307.4TFLOPS의 이론상 최대 반정도(FP16), 1307.4TFLOPS의 이론상 최대 Bfloat16 포맷 정도(BF16), 2614.9TFLOPS의 이론상 최대 8비트 정도(FP8), 2614.9TOPs의 INT8 부동 소수점 성능을 기록했습니다. Nvidia H100 SXM(80GB) GPU에 대해 발표된 결과는 66.9TFLOPS의 이론상 최대 배정도 텐서(FP64 텐서), 33.5TFLOPS의 이론상 최대 배정도(FP64), 66.9TFLOPS의 이론상 최대 단정도(FP32), 494.7TFLOPS의 최대 TensorFloat-32(TF32)*, 989.4TFLOPS의 이론상 최대 반정도 텐서(FP16 텐서), 133.8TFLOPS의 이론상 최대 반정도(FP16), 989.4TFLOPS의 이론상 최대 Bfloat16 텐서 포맷 정도(BF16 텐서), 133.8TFLOPS의 이론상 최대 Bfloat16 포맷 정도(BF16), 1,978.9TFLOPS의 이론상 최대 8비트 정도(FP8), 1,978.9TOPs의 이론상 최대 INT8 부동 소수점 성능을 기록했습니다. NVIDIA H100 출처: https://resources.nvidia.com/en-us-tensor-core/ * Nvidia H100 GPU는 FP32 텐서를 지원하지 않습니다. MI300-18

- 2023년 11월 17일 기준, AMD 퍼포먼스 랩이 AMD CDNA™ 3 5nm FinFet 공정 기술로 설계된 AMD Instinct™ MI300X OAM 가속기 750W(192GB HBM3)에 대해 계산한 결과 192GB의 HBM3 메모리 용량과 5.325TFLOPS의 이론상 최대 메모리 대역폭 성능을 기록했습니다. MI300X 메모리 버스 인터페이스는 8,192비트이고 메모리 데이터율은 5.2Gbps로 총 최대 메모리 대역폭은 5.325TB/s를 기록했습니다(8,192비트 메모리 버스 인터페이스 * 5.2Gbps 메모리 데이터율/8). NVidia Hopper H200(141GB) SXM GPU 가속기에 대해 게시된 최고 결과는 141GB HBM3e 메모리 용량 및 4.8TB/s GPU 메모리 대역폭 성능입니다(https://nvdam.widen.net/s/nb5zzzsjdf/hpc-datasheet-sc23-h200-datasheet-3002446). NVidia Hopper H100(80GB) SXM5 GPU 가속기에 대해 게시된 최고 결과는 80GB HBM3 메모리 용량 및 3.35TB/s GPU 메모리 대역폭 성능입니다(https://resources.nvidia.com/en-us-tensor-core/nvidia-tensor-core-gpu-datasheet MI300-05A).

- 2023년 11월 18일 기준, AMD 퍼포먼스 랩이 AMD CDNA™ 3 5nm | 6ㅜm FinFET 공정 기술로 설계된 AMD Instinct™ MI300X(192GB HBM3) 750W GPU를 대상으로 2,100MHz 최대 부스트 엔진 클럭에서 측정한 결과 1307.4TFLOPS의 이론상 최대 반정도(FP16), 1307.4TFLOPS의 이론상 최대 Bfloat16 포맷 정도(BF16)를 기록했습니다. MI300X는 정교한 조직 구조 스파시티를 활용해 수학 연산 효율을 약 2배 향상할 것으로 예상되며 2,614.9TFLOPS의 이론상 최대 반정도(FP16), 스파시티 사용 시 2,614.9TFLOPS의 이론상 최대 Bfloat16 포맷 정도(BF16) 부동 소수점 성능을 기록했습니다. Nvidia H100 SXM(80GB HBM3) 700W GPU에 대해 게시된 결과는 스파시티 사용 시 1,978.9TFLOPS의 피크 이론상 반정도(FP16), 스파시티 부동 소수점 성능 사용 시 1,978.9TFLOPS의 피크 이론상 Bfloat16 포맷 정도(BF16)를 기록했습니다. Nvidia H100 출처: https://resources.nvidia.com/en-us-tensor-core/ AMD Instinct™ MI300X AMD CDNA 3 기술 기반 가속기에는 최대 8개의 Infinity Fabric 링크가 포함되어 GPU OAM 모듈당 최대 1,024GB/s의 이론상 총 GPU 피어투피어(P2P) 전송률 대역폭 성능을 제공합니다. MI300-25

- 2023년 11월 11일 기준, AMD 퍼포먼스 랩이 AMD CDNA™ 3 5nm | 6nm FinFET 공정 기술로 설계된 AMD Instinct™ MI300A(760W) APU를 대상으로 2,100MHz 최대 부스트 엔진 클럭에서 측정한 결과 122.6TFLOPS의 이론상 최대 배정도(FP64 매트릭스), 61.3TFLOPS의 이론상 최대 배정도(FP64), 122.6TFLOPS의 이론상 최대 단정도 매트릭스(FP32 매트릭스), 122.6TFLOPS의 이론상 최대 단정도(FP32), 490.3TFLOPS의 이론상 최대 TensorFloat-32(TF32), 980.6TFLOPS의 이론상 최대 반정도(FP16), 980.6TFLOPS의 이론상 최대 Bfloat16 포맷 정도(BF16), 1961.2TFLOPS의 이론상 최대 8비트 정도(FP8), 1961.2TOPs의 INT8 부동 소수점 성능을 기록했습니다. AMD CDNA™ 2 5nm FinFET 공정 기술로 설계된 AMD Instinct™ MI250X(560W) 128GB HBM2e OAM 가속기를 대상으로 1,700MHz 최대 부스트 엔진 클럭에서 계산한 결과 95.7TFLOPS의 이론상 최대 배정도(FP64 매트릭스), 47.9TFLOPS의 이론상 최대 배정도(FP64), 95.7TFLOPS의 이론상 최대 단정도 매트릭스(FP32 매트릭스), 47.9TFLOPS의 이론상 최대 단정도(FP32), TF32*(해당 없음), 383.0TFLOPS의 이론상 최대 반정도(FP16), 383.0TFLOPS의 이론상 최대 Bfloat16 포맷 정도(BF16), FP8(해당 없음), 383.0TOPs의 INT8 부동 소수점 성능을 기록했습니다. 서버 제조업체마다 구성 서비스가 다양하여 다른 결과가 나올 수 있습니다. * MI200 시리즈 GPU는 TF32, FP8, 스파시티를 지원하지 않습니다. MI300-10

- 2023년 11월 11일 기준, AMD 퍼포먼스 랩이 AMD CDNA™ 3 5nm | 6nm FinFET 공정 기술로 설계된 AMD Instinct™ MI300A(750W) APU를 대상으로 2,100MHz 최대 부스트 엔진 클럭에서 측정한 결과 490.29TFLOPS의 이론상 최대 TensorFloat-32(TF32), 980.58TFLOPS의 이론상 최대 반정도(FP16), 980.58TFLOPS의 이론상 최대 Bfloat16 포맷 정도(BF16), 1,961.16TFLOPS의 이론상 최대 8비트 정도(FP8), 1,961.16TOPs의 INT8 부동 소수점 성능을 기록했습니다. MI300A는 정교한 조직 구조 스파시티를 활용해 수학 연산 효율을 약 2배 향상할 것으로 예상되며 980.58TFLOPS의 이론상 최대 TensorFloat-32(TF32), 1,961.16TFLOPS의 이론상 최대 반정도(FP16), 1,961.16TFLOPS의 이론상 최대 Bfloat16 포맷 정도(BF16), 3,922.33TFLOPS의 이론상 최대 8비트 정도(FP8), 스파시티 사용 시 3,922.33TOPs의 INT8 부동 소수점 성능을 기록했습니다. Nvidia H100 SXM5(80GB) GPU에 대해 게시된 결과는 스파시티 사용 시 989.4TFLOPS의 최대 TensorFloat-32(TF32) 텐서 코어, 스파시티 사용 시 1,978.9TFLOPS의 이론상 최대 반정도(FP16) 텐서 코어, 스파시티 사용 시 1,978.9TFLOPS의 이론상 최대 Bfloat16 포맷 정도(BF16) 텐서 코어, 스파시티 사용 시 3,957.8TFLOPS의 이론상 최대 8비트 정도(FP8) 텐서 코어, 스파시티 부동 소수점 성능 사용 시 3,957.8TOPs의 이론상 최대 INT8 텐서 코어를 기록했습니다. NVIDIA H100 출처: https://resources.nvidia.com/en-us-tensor-core/ 서버 제조업체마다 구성 서비스가 다양하여 다른 결과가 나올 수 있습니다. MI300-21

- 2023년 11월 11일 기준, AMD 퍼포먼스 랩이 AMD CDNA™ 3 5nm | 6nm FinFET 공정 기술로 설계된 AMD Instinct™ MI300A(760W) GPU를 대상으로 2,100MHz 최대 부스트 엔진 클럭에서 측정한 결과 122.6TFLOPS의 이론상 최대 배정도 매트릭스(FP64 매트릭스), 61.3TFLOPS의 이론상 최대 배정도(FP64), 122.6TFLOPS의 이론상 최대 단정도 매트릭스(FP32 매트릭스), 122.6TFLOPS의 이론상 최대 단정도(FP32), 490.29TFLOPS의 이론상 최대 TensorFloat-32(TF32), 980.58TFLOPS의 이론상 최대 반정도(FP16), 980.58TFLOPS의 이론상 최대 Bfloat16 포맷 정도(BF16), 1,961.16TFLOPS의 이론상 최대 8비트 정도(FP8), 1,961.16TOPs의 INT8 부동 소수점 성능을 기록했습니다. Nvidia H100 SXM(80GB) 700W GPU에 대해 발표된 결과는 66.9TFLOPS의 이론상 최대 배정도 텐서(FP64 텐서), 33.5TFLOPS의 이론상 최대 배정도(FP64), 66.9TFLOPS의 이론상 최대 단정도(FP32), 494.7TFLOPS의 최대 TensorFloat-32(TF32)*, 989.4TFLOPS의 이론상 최대 반정도 텐서(FP16 텐서), 133.8TFLOPS의 이론상 최대 반정도(FP16), 989.4TFLOPS의 이론상 최대 Bfloat16 텐서 포맷 정도(BF16 텐서), 133.8TFLOPS의 이론상 최대 Bfloat16 포맷 정도(BF16), 1,978.9TFLOPS의 이론상 최대 8비트 정도(FP8), 1,978.9TOPs의 이론상 최대 INT8 부동 소수점 성능을 기록했습니다. NVIDIA H100 출처: https://resources.nvidia.com/en-us-tensor-core/ 서버 제조업체마다 구성 서비스가 다양하여 다른 결과가 나올 수 있습니다. * Nvidia H100 GPU는 FP32 텐서를 지원하지 않습니다. MI300-20

- 2023년 11월 7일 기준, AMD 퍼포먼스 랩이 AMD CDNA™ 3 5nm FinFet 공정 기술로 설계된 AMD Instinct™ MI300A APU 가속기 760W(128GB HBM3)에 대해 계산한 결과 128GB HBM3 메모리 용량과 5.325TFLOPS의 이론상 최대 메모리 대역폭 성능을 기록했습니다. MI300A 메모리 버스 인터페이스는 8,192비트(1024비트 x 8개 다이)이고 메모리 데이터율은 5.2Gbps로 총 최대 메모리 대역폭은 5.325TB/s를 기록했습니다(8,192비트 메모리 버스 인터페이스 * 5.2Gbps 메모리 데이터율/8). NVidia Hopper H200(141GB) SXM GPU 가속기에 대해 게시된 최고 결과는 141GB HBM3e 메모리 용량 및 4.8TB/s GPU 메모리 대역폭 성능입니다(https://nvdam.widen.net/s/nb5zzzsjdf/hpc-datasheet-sc23-h200-datasheet-3002446). NVidia Hopper H100(80GB) SXM GPU 가속기에 대해 게시된 최고 결과는 80GB HBM3 메모리 용량 및 3.35TB/s GPU 메모리 대역폭 성능입니다(https://resources.nvidia.com/en-us-tensor-core/nvidia-tensor-core-gpu-datasheet). 서버 제조업체마다 구성 서비스가 다양하여 다른 결과가 나올 수 있습니다. MI300-12

- MI325-001A - 2024년 9월 26일 현재 AMD 퍼포먼스 랩에서 현재 사양 및/또는 추정치를 기준으로 수행한 계산입니다. AMD Instinct™ MI325X OAM 가속기는 256GB HBM3E 메모리 용량과 6TB/s GPU의 이론상 최대 메모리 대역폭 성능을 제공합니다. 프로덕션 실리콘에 따라 실제 결과는 다를 수 있습니다.

Nvidia Hopper H200(141GB) SXM GPU 가속기에 대해 게시된 최고 결과는 141GB HBM3E 메모리 용량 및 4.8TB/s GPU 메모리 대역폭 성능입니다. https://nvdam.widen.net/s/nb5zzzsjdf/hpc-datasheet-sc23-h200-datasheet-3002446

Nvidia Blackwell HGX B100(192GB) 700W GPU 가속기에 대해 게시된 최고 결과는 192GB HBM3e 메모리 용량 및 8TB/s GPU 메모리 대역폭 성능입니다.

Nvidia Blackwell HGX B200(192GB) GPU 가속기에 대해 게시된 최고 결과는 192GB HBM3E 메모리 용량 및 8TB/s GPU 메모리 대역폭 성능입니다.

Nvidia Blackwell 사양은 다음 페이지에서 확인할 수 있습니다. https://resources.nvidia.com/en-us-blackwell-architecture?_gl=1*1r4pme7*_gcl_aw*R0NMLjE3MTM5NjQ3NTAuQ2p3S0NBancyNkt4QmhCREVpd0F1NktYdDlweXY1dlUtaHNKNmhPdHM4UVdPSlM3dFdQaE40WkI4THZBaWFVajFy - MI325-002 - 2024년 5월 28일 AMD 퍼포먼스 랩에서 AMD Instinct™ MI325X GPU에 대해 수행한 계산 결과 1307.4TFLOPS 이론상 최대 반정도(FP16), 1307.4TFLOPS 이론상 최대 Bfloat16 포맷 정도(BF16), 2614.9TFLOPS 이론상 최대 8비트 정도(FP8), 2614.9TOPs INT8 부동 소수점 성능이 나타났습니다. 실제 성능은 최종 사양 및 시스템 구성에 따라 달라집니다.

Nvidia H200 SXM(141GB) GPU에 대해 게시된 결과: 989.4TFLOPS 이론상 최대 반정도 텐서(FP16 텐서), 989.4TFLOPS 이론상 최대 Bfloat16 텐서 포맷 정도(BF16 텐서), 1,978.9TFLOPS 이론상 최대 8비트 정도(FP8), 1,978.9TOPs 이론상 최대 INT8 부동 소수점 성능. Nvidia는 BFLOAT16 텐서 코어, FP16 텐서 코어, FP8 텐서 코어, INT8 텐서 코어 성능을 스파시티를 사용해 게시했습니다. AMD는 비교를 위해 이 숫자를 2로 나누어 비스파시티/밀도로 변환했으며 이러한 숫자는 상단에 나와 있습니다.

Nvidia H200 출처: https://nvdam.widen.net/s/nb5zzzsjdf/hpc-datasheet-sc23-h200-datasheet-3002446 및 https://www.anandtech.com/show/21136/nvidia-at-sc23-h200-accelerator-with-hbm3e-and-jupiter-supercomputer-for-2024

참고: Nvidia H200 GPU는 H100 제품과 동일한 FLOP 성능이 게시되었습니다(https://resources.nvidia.com/en-us-tensor-core/). MI325-02 - MI325-008 - 2024년 10월 2일 기준, AMD 퍼포먼스 랩이 AMD CDNA™ 3 5nm | 6nm FinFET 공정 기술로 설계된 AMD Instinct™ MI325X(1000W) GPU를 대상으로 2,100MHz 최대 부스트 엔진 클럭에서 측정한 결과 163.4TFLOPS의 이론상 최대 배정도 매트릭스(FP64 매트릭스), 81.7TFLOPS의 이론상 최대 배정도(FP64), 163.4TFLOPS의 이론상 최대 단정도 매트릭스(FP32 매트릭스), 163.4TFLOPS의 이론상 최대 단정도(FP32), 653.7TFLOPS의 이론상 최대 TensorFloat-32(TF32), 1307.4TFLOPS의 이론상 최대 반정도(FP16)의 성능을 기록했습니다. 실제 성능은 최종 사양과 시스템 구성에 따라 달라질 수 있습니다.

Nvidia H200 SXM(141GB) GPU에 대해 게시된 결과: 66.9TFLOPS의 최대 이론상 배정도 텐서(FP64 텐서), 33.5TFLOPS의 최대 이론상 배정도(FP64), 66.9TFLOPS의 이론상 최대 단정도(FP32), 494.7TFLOPS의 최대 TensorFloat-32(TF32), 989.5TFLOPS의 이론상 최대 반정도 텐서(FP16 텐서). Nvidia는 TF32 텐서 코어 성능을 스파시티를 사용해 게시했습니다. AMD는 비교를 위해 이 숫자를 2로 나누어 비스파시티/밀도 값으로 변환했으며, 이 숫자는 상단에 나와 있습니다.

Nvidia H200 출처: https://nvdam.widen.net/s/nb5zzzsjdf/hpc-datasheet-sc23-h200-datasheet-3002446 및 https://www.anandtech.com/show/21136/nvidia-at-sc23-h200-accelerator-with-hbm3e-and-jupiter-supercomputer-for-2024

참고: Nvidia H200 GPU는 H100 제품과 동일한 FLOP 성능이 게시되었습니다(https://resources.nvidia.com/en-us-tensor-core/).

* Nvidia H200 GPU는 FP32 텐서를 지원하지 않습니다. - 2023년 11월 11일 기준, AMD 퍼포먼스 랩이 AMD CDNA™ 3 5nm | 6nm FinFET 공정 기술로 설계된 AMD Instinct™ MI300X(750W) GPU를 대상으로 2,100MHz 최대 부스트 엔진 클럭에서 측정한 결과 653.7TFLOPS의 이론상 최대 TensorFloat-32(TF32), 1307.4TFLOPS의 이론상 최대 반정도(FP16), 1307.4TFLOPS의 이론상 최대 Bfloat16 포맷 정도(BF16), 2614.9TFLOPS의 이론상 최대 8비트 정도(FP8), 2614.9TOPs의 INT8 부동 소수점 성능을 기록했습니다. MI300X는 정교한 조직 구조 스파시티를 활용해 수학 연산 효율을 약 2배 향상할 것으로 예상되며 1,307.4TFLOPS의 이론상 최대 TensorFloat-32(TF32), 2,614.9TFLOPS의 이론상 최대 반정도(FP16), 2,614.9TFLOPS의 이론상 최대 Bfloat16 포맷 정도(BF16), 5,229.8TFLOPS의 이론상 최대 8비트 정도(FP8), 스파시티 사용 시 5,229.8TOPS의 INT8 부동 소수점 성능을 기록했습니다. AMD CDNA™ 2 5nm FinFET 공정 기술로 설계된 AMD Instinct™ MI250X(560W) 128GB HBM2e OAM 가속기를 대상으로 1,700MHz 최대 부스트 엔진 클럭에서 계산한 결과 TF32*(해당 없음), 383.0TFLOPS의 이론상 최대 반정도(FP16), 383.0TFLOPS의 이론상 최대 Bfloat16 포맷 정도(BF16), FP8*(해당 없음), 383.0TOPs의 INT8 부동 소수점 성능을 기록했습니다. *AMD Instinct MI200 시리즈 GPU는 TF32, FP8, 스파시티를 지원하지 않습니다. MI300-16

- 현재 사양 및/또는 내부 엔지니어링 계산에 대한 2023년 6월 2일 기준 내부 AMD 퍼포먼스 랩의 측정. Falcon-7B(7B, 40B 파라미터), Llama(13B, 33B 파라미터), OPT(66B 파라미터), GPT-3(175B 파라미터), BLOOM(176B 파라미터) 및 PaLM(340B, 540B 파라미터) 모델을 실행하는 데 필요한 최소 GPU 수를 결정하기 위해 FP16 정밀도로 거대 언어 모델(LLM)을 실행하거나 계산했습니다. 정의된 파라미터와 10% 오버헤드를 더한 모델에서 필요한 메모리 대비 GPU 전용 메모리 크기를 기준으로 계산된 추정치입니다. 계산은 게시된 메모리 크기와 때로는 예비 모델 메모리 크기에 따라 달라집니다. GPT-3, BLOOM 및 PaML 결과는 시스템/부품 가용성으로 인해 MI300X에서 추정됩니다. 테스트 결과 구성: EPYC 9654(96코어) CPU 1개와 AMD Instinct™ MI300X(192GB HBM3, OAM 모듈) 750W 가속기 1개로 구성된 AMD 랩 시스템

결과(FP16 정밀도):

모델 파라미터 총 필요 메모리 필요 MI300X Falcon-7B 70억 개 15.4GB 1 실제 LLaMA 130억 개 44GB 1 실제 LLaMA 330억 개 72.5GB 1 실제 Falcon-40B 400억 개 88GB 1 실제 OPT 660억 개 145.2GB 1 실제 GPT-3 1,750억 개 385GB 3 계산됨 Bloom 1,760억 개 387.2GB 3 계산됨 PaLM 3,400억 개 748GB 4 계산됨 PaLM 5,400억 개 1188GB 7 계산됨 계산된 추정치는 최종 모델 크기에 따라 달라질 수 있습니다. 실제 및 추정치는 실제 필요한 오버헤드와 GPU 이상의 시스템 메모리 사용으로 인해 달라질 수 있습니다. 서버 제조업체마다 구성 서비스가 다양하여 다른 결과가 나올 수 있습니다. MI300-07

- 2023년 11월 11일 기준, AMD 퍼포먼스 랩이 AMD CDNA™ 3 5nm | 6nm FinFET 공정 기술로 설계된 AMD Instinct™ MI300X(750W) GPU를 대상으로 2,100MHz 최대 부스트 엔진 클럭에서 측정한 결과 653.7TFLOPS의 이론상 최대 TensorFloat-32(TF32), 1307.4TFLOPS의 이론상 최대 반정도(FP16), 1307.4TFLOPS의 이론상 최대 Bfloat16 포맷 정도(BF16), 2614.9TFLOPS의 이론상 최대 8비트 정도(FP8), 2614.9TOPs의 INT8 부동 소수점 성능을 기록했습니다. MI300X는 정교한 조직 구조 스파시티를 활용해 수학 연산 효율을 약 2배 향상할 것으로 예상되며 1,307.4TFLOPS의 이론상 최대 TensorFloat-32(TF32), 2,614.9TFLOPS의 이론상 최대 반정도(FP16), 2,614.9TFLOPS의 이론상 최대 Bfloat16 포맷 정도(BF16), 5,229.8TFLOPS의 이론상 최대 8비트 정도(FP8), 스파시티 사용 시 5,229.8TOPS의 INT8 부동 소수점 성능을 기록했습니다. Nvidia H100 SXM(80GB) 700W GPU에 대해 게시된 결과는 스파시티 사용 시 989.4TFLOPs의 최대 TensorFloat-32(TF32), 스파시티 사용 시 1,978.9TFLOPS의 이론상 최대 반정도(FP16), 스파시티 사용 시 1,978.9TFLOPS의 이론상 최대 Bfloat16 포맷 정도(BF16), 스파시티 사용 시 3,957.8TFLOPS의 이론상 최대 8비트 정도(FP8), 스파시티 부동 소수점 성능 사용 시 3,957.8TOPs의 이론상 최대 INT8을 기록했습니다. Nvidia H100 출처: https://resources.nvidia.com/en-us-tensor-core. MI300-17

- 2023년 11월 11일 기준, AMD 퍼포먼스 랩이 AMD CDNA™ 3 5nm | 6nm FinFET 공정 기술로 설계된 AMD Instinct™ MI300X(750W) GPU를 대상으로 2,100MHz 최대 부스트 엔진 클럭에서 측정한 결과 163.4TFLOPS의 이론상 최대 배정도 매트릭스(FP64 매트릭스), 81.7TFLOPS의 이론상 최대 배정도(FP64), 163.4TFLOPS의 이론상 최대 단정도 매트릭스(FP32 매트릭스), 163.4TFLOPS의 이론상 최대 단정도(FP32), 653.7TFLOPS의 이론상 최대 TensorFloat-32(TF32), 1307.4TFLOPS의 이론상 최대 반정도(FP16), 1307.4TFLOPS의 이론상 최대 Bfloat16 포맷 정도(BF16), 2614.9TFLOPS의 이론상 최대 8비트 정도(FP8), 2614.9TOPs의 INT8 부동 소수점 성능을 기록했습니다. Nvidia H100 SXM(80GB) GPU에 대해 발표된 결과는 66.9TFLOPS의 이론상 최대 배정도 텐서(FP64 텐서), 33.5TFLOPS의 이론상 최대 배정도(FP64), 66.9TFLOPS의 이론상 최대 단정도(FP32), 494.7TFLOPS의 최대 TensorFloat-32(TF32)*, 989.4TFLOPS의 이론상 최대 반정도 텐서(FP16 텐서), 133.8TFLOPS의 이론상 최대 반정도(FP16), 989.4TFLOPS의 이론상 최대 Bfloat16 텐서 포맷 정도(BF16 텐서), 133.8TFLOPS의 이론상 최대 Bfloat16 포맷 정도(BF16), 1,978.9TFLOPS의 이론상 최대 8비트 정도(FP8), 1,978.9TOPs의 이론상 최대 INT8 부동 소수점 성능을 기록했습니다. NVIDIA H100 출처: https://resources.nvidia.com/en-us-tensor-core/ * Nvidia H100 GPU는 FP32 텐서를 지원하지 않습니다. MI300-18

- 2023년 11월 17일 기준, AMD 퍼포먼스 랩이 AMD CDNA™ 3 5nm FinFet 공정 기술로 설계된 AMD Instinct™ MI300X OAM 가속기 750W(192GB HBM3)에 대해 계산한 결과 192GB의 HBM3 메모리 용량과 5.325TFLOPS의 이론상 최대 메모리 대역폭 성능을 기록했습니다. MI300X 메모리 버스 인터페이스는 8,192비트이고 메모리 데이터율은 5.2Gbps로 총 최대 메모리 대역폭은 5.325TB/s를 기록했습니다(8,192비트 메모리 버스 인터페이스 * 5.2Gbps 메모리 데이터율/8). NVidia Hopper H200(141GB) SXM GPU 가속기에 대해 게시된 최고 결과는 141GB HBM3e 메모리 용량 및 4.8TB/s GPU 메모리 대역폭 성능입니다(https://nvdam.widen.net/s/nb5zzzsjdf/hpc-datasheet-sc23-h200-datasheet-3002446). NVidia Hopper H100(80GB) SXM5 GPU 가속기에 대해 게시된 최고 결과는 80GB HBM3 메모리 용량 및 3.35TB/s GPU 메모리 대역폭 성능입니다(https://resources.nvidia.com/en-us-tensor-core/nvidia-tensor-core-gpu-datasheet MI300-05A).

- 2023년 11월 18일 기준, AMD 퍼포먼스 랩이 AMD CDNA™ 3 5nm | 6ㅜm FinFET 공정 기술로 설계된 AMD Instinct™ MI300X(192GB HBM3) 750W GPU를 대상으로 2,100MHz 최대 부스트 엔진 클럭에서 측정한 결과 1307.4TFLOPS의 이론상 최대 반정도(FP16), 1307.4TFLOPS의 이론상 최대 Bfloat16 포맷 정도(BF16)를 기록했습니다. MI300X는 정교한 조직 구조 스파시티를 활용해 수학 연산 효율을 약 2배 향상할 것으로 예상되며 2,614.9TFLOPS의 이론상 최대 반정도(FP16), 스파시티 사용 시 2,614.9TFLOPS의 이론상 최대 Bfloat16 포맷 정도(BF16) 부동 소수점 성능을 기록했습니다. Nvidia H100 SXM(80GB HBM3) 700W GPU에 대해 게시된 결과는 스파시티 사용 시 1,978.9TFLOPS의 피크 이론상 반정도(FP16), 스파시티 부동 소수점 성능 사용 시 1,978.9TFLOPS의 피크 이론상 Bfloat16 포맷 정도(BF16)를 기록했습니다. Nvidia H100 출처: https://resources.nvidia.com/en-us-tensor-core/ AMD Instinct™ MI300X AMD CDNA 3 기술 기반 가속기에는 최대 8개의 Infinity Fabric 링크가 포함되어 GPU OAM 모듈당 최대 1,024GB/s의 이론상 총 GPU 피어투피어(P2P) 전송률 대역폭 성능을 제공합니다. MI300-25

- 2023년 11월 11일 기준, AMD 퍼포먼스 랩이 AMD CDNA™ 3 5nm | 6nm FinFET 공정 기술로 설계된 AMD Instinct™ MI300A(760W) APU를 대상으로 2,100MHz 최대 부스트 엔진 클럭에서 측정한 결과 122.6TFLOPS의 이론상 최대 배정도(FP64 매트릭스), 61.3TFLOPS의 이론상 최대 배정도(FP64), 122.6TFLOPS의 이론상 최대 단정도 매트릭스(FP32 매트릭스), 122.6TFLOPS의 이론상 최대 단정도(FP32), 490.3TFLOPS의 이론상 최대 TensorFloat-32(TF32), 980.6TFLOPS의 이론상 최대 반정도(FP16), 980.6TFLOPS의 이론상 최대 Bfloat16 포맷 정도(BF16), 1961.2TFLOPS의 이론상 최대 8비트 정도(FP8), 1961.2TOPs의 INT8 부동 소수점 성능을 기록했습니다. AMD CDNA™ 2 5nm FinFET 공정 기술로 설계된 AMD Instinct™ MI250X(560W) 128GB HBM2e OAM 가속기를 대상으로 1,700MHz 최대 부스트 엔진 클럭에서 계산한 결과 95.7TFLOPS의 이론상 최대 배정도(FP64 매트릭스), 47.9TFLOPS의 이론상 최대 배정도(FP64), 95.7TFLOPS의 이론상 최대 단정도 매트릭스(FP32 매트릭스), 47.9TFLOPS의 이론상 최대 단정도(FP32), TF32*(해당 없음), 383.0TFLOPS의 이론상 최대 반정도(FP16), 383.0TFLOPS의 이론상 최대 Bfloat16 포맷 정도(BF16), FP8(해당 없음), 383.0TOPs의 INT8 부동 소수점 성능을 기록했습니다. 서버 제조업체마다 구성 서비스가 다양하여 다른 결과가 나올 수 있습니다. * MI200 시리즈 GPU는 TF32, FP8, 스파시티를 지원하지 않습니다. MI300-10

- 2023년 11월 11일 기준, AMD 퍼포먼스 랩이 AMD CDNA™ 3 5nm | 6nm FinFET 공정 기술로 설계된 AMD Instinct™ MI300A(750W) APU를 대상으로 2,100MHz 최대 부스트 엔진 클럭에서 측정한 결과 490.29TFLOPS의 이론상 최대 TensorFloat-32(TF32), 980.58TFLOPS의 이론상 최대 반정도(FP16), 980.58TFLOPS의 이론상 최대 Bfloat16 포맷 정도(BF16), 1,961.16TFLOPS의 이론상 최대 8비트 정도(FP8), 1,961.16TOPs의 INT8 부동 소수점 성능을 기록했습니다. MI300A는 정교한 조직 구조 스파시티를 활용해 수학 연산 효율을 약 2배 향상할 것으로 예상되며 980.58TFLOPS의 이론상 최대 TensorFloat-32(TF32), 1,961.16TFLOPS의 이론상 최대 반정도(FP16), 1,961.16TFLOPS의 이론상 최대 Bfloat16 포맷 정도(BF16), 3,922.33TFLOPS의 이론상 최대 8비트 정도(FP8), 스파시티 사용 시 3,922.33TOPs의 INT8 부동 소수점 성능을 기록했습니다. Nvidia H100 SXM5(80GB) GPU에 대해 게시된 결과는 스파시티 사용 시 989.4TFLOPS의 최대 TensorFloat-32(TF32) 텐서 코어, 스파시티 사용 시 1,978.9TFLOPS의 이론상 최대 반정도(FP16) 텐서 코어, 스파시티 사용 시 1,978.9TFLOPS의 이론상 최대 Bfloat16 포맷 정도(BF16) 텐서 코어, 스파시티 사용 시 3,957.8TFLOPS의 이론상 최대 8비트 정도(FP8) 텐서 코어, 스파시티 부동 소수점 성능 사용 시 3,957.8TOPs의 이론상 최대 INT8 텐서 코어를 기록했습니다. NVIDIA H100 출처: https://resources.nvidia.com/en-us-tensor-core/ 서버 제조업체마다 구성 서비스가 다양하여 다른 결과가 나올 수 있습니다. MI300-21

- 2023년 11월 11일 기준, AMD 퍼포먼스 랩이 AMD CDNA™ 3 5nm | 6nm FinFET 공정 기술로 설계된 AMD Instinct™ MI300A(760W) GPU를 대상으로 2,100MHz 최대 부스트 엔진 클럭에서 측정한 결과 122.6TFLOPS의 이론상 최대 배정도 매트릭스(FP64 매트릭스), 61.3TFLOPS의 이론상 최대 배정도(FP64), 122.6TFLOPS의 이론상 최대 단정도 매트릭스(FP32 매트릭스), 122.6TFLOPS의 이론상 최대 단정도(FP32), 490.29TFLOPS의 이론상 최대 TensorFloat-32(TF32), 980.58TFLOPS의 이론상 최대 반정도(FP16), 980.58TFLOPS의 이론상 최대 Bfloat16 포맷 정도(BF16), 1,961.16TFLOPS의 이론상 최대 8비트 정도(FP8), 1,961.16TOPs의 INT8 부동 소수점 성능을 기록했습니다. Nvidia H100 SXM(80GB) 700W GPU에 대해 발표된 결과는 66.9TFLOPS의 이론상 최대 배정도 텐서(FP64 텐서), 33.5TFLOPS의 이론상 최대 배정도(FP64), 66.9TFLOPS의 이론상 최대 단정도(FP32), 494.7TFLOPS의 최대 TensorFloat-32(TF32)*, 989.4TFLOPS의 이론상 최대 반정도 텐서(FP16 텐서), 133.8TFLOPS의 이론상 최대 반정도(FP16), 989.4TFLOPS의 이론상 최대 Bfloat16 텐서 포맷 정도(BF16 텐서), 133.8TFLOPS의 이론상 최대 Bfloat16 포맷 정도(BF16), 1,978.9TFLOPS의 이론상 최대 8비트 정도(FP8), 1,978.9TOPs의 이론상 최대 INT8 부동 소수점 성능을 기록했습니다. NVIDIA H100 출처: https://resources.nvidia.com/en-us-tensor-core/ 서버 제조업체마다 구성 서비스가 다양하여 다른 결과가 나올 수 있습니다. * Nvidia H100 GPU는 FP32 텐서를 지원하지 않습니다. MI300-20

- 2023년 11월 7일 기준, AMD 퍼포먼스 랩이 AMD CDNA™ 3 5nm FinFet 공정 기술로 설계된 AMD Instinct™ MI300A APU 가속기 760W(128GB HBM3)에 대해 계산한 결과 128GB HBM3 메모리 용량과 5.325TFLOPS의 이론상 최대 메모리 대역폭 성능을 기록했습니다. MI300A 메모리 버스 인터페이스는 8,192비트(1024비트 x 8개 다이)이고 메모리 데이터율은 5.2Gbps로 총 최대 메모리 대역폭은 5.325TB/s를 기록했습니다(8,192비트 메모리 버스 인터페이스 * 5.2Gbps 메모리 데이터율/8). NVidia Hopper H200(141GB) SXM GPU 가속기에 대해 게시된 최고 결과는 141GB HBM3e 메모리 용량 및 4.8TB/s GPU 메모리 대역폭 성능입니다(https://nvdam.widen.net/s/nb5zzzsjdf/hpc-datasheet-sc23-h200-datasheet-3002446). NVidia Hopper H100(80GB) SXM GPU 가속기에 대해 게시된 최고 결과는 80GB HBM3 메모리 용량 및 3.35TB/s GPU 메모리 대역폭 성능입니다(https://resources.nvidia.com/en-us-tensor-core/nvidia-tensor-core-gpu-datasheet). 서버 제조업체마다 구성 서비스가 다양하여 다른 결과가 나올 수 있습니다. MI300-12