AI と HPC を大幅に強化

AMD Instinct™ MI300 シリーズ アクセラレータは、最も要求の厳しい AI や HPC のワークロード処理に高度に特化し、卓越した演算能力、広帯域幅の高メモリ集積度、特殊なデータ形式のサポートを提供します。

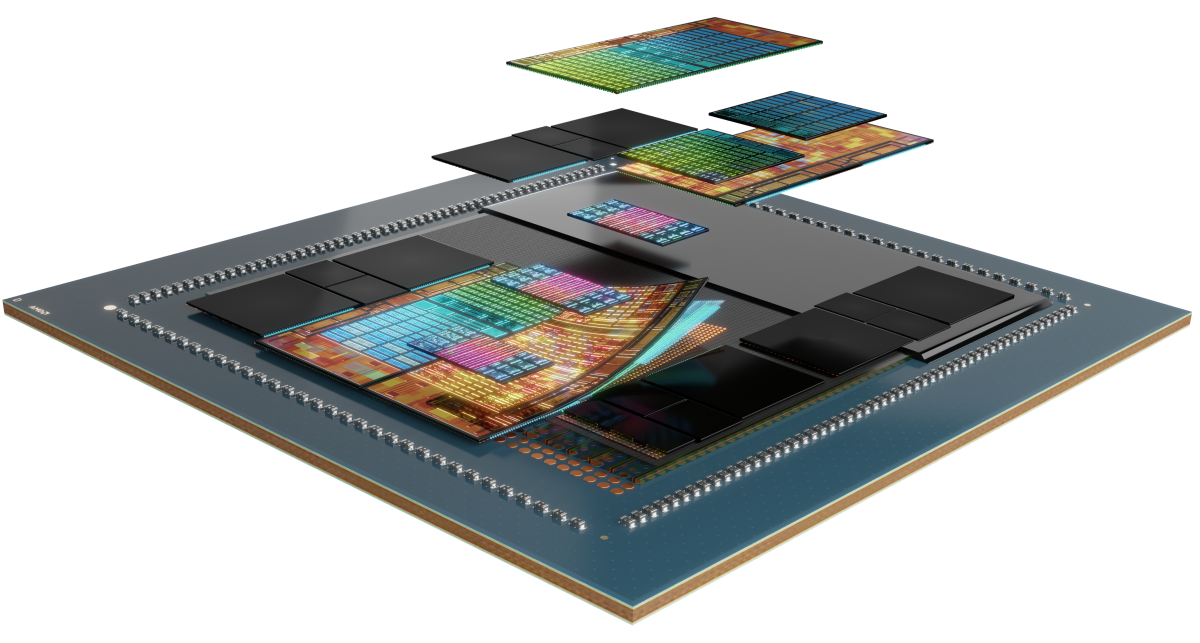

内部のテクノロジ

AMD Instinct MI300 シリーズ アクセラレータは、マトリックス コア テクノロジを提供する AMD CDNA™ 3 アーキテクチャに基づいて構築されており、高効率の INT8 および FP8 (AI 向けスパース性への対応を含む) から HPC 向けの最も要求の厳しい FP64 まで、幅広い精度をサポートしています。

シリーズの紹介

AMD Instinct MI300 シリーズ アクセラレータ、AMD Instinct MI300 シリーズ プラットフォーム、AMD Instinct MI300A APU をご紹介します。

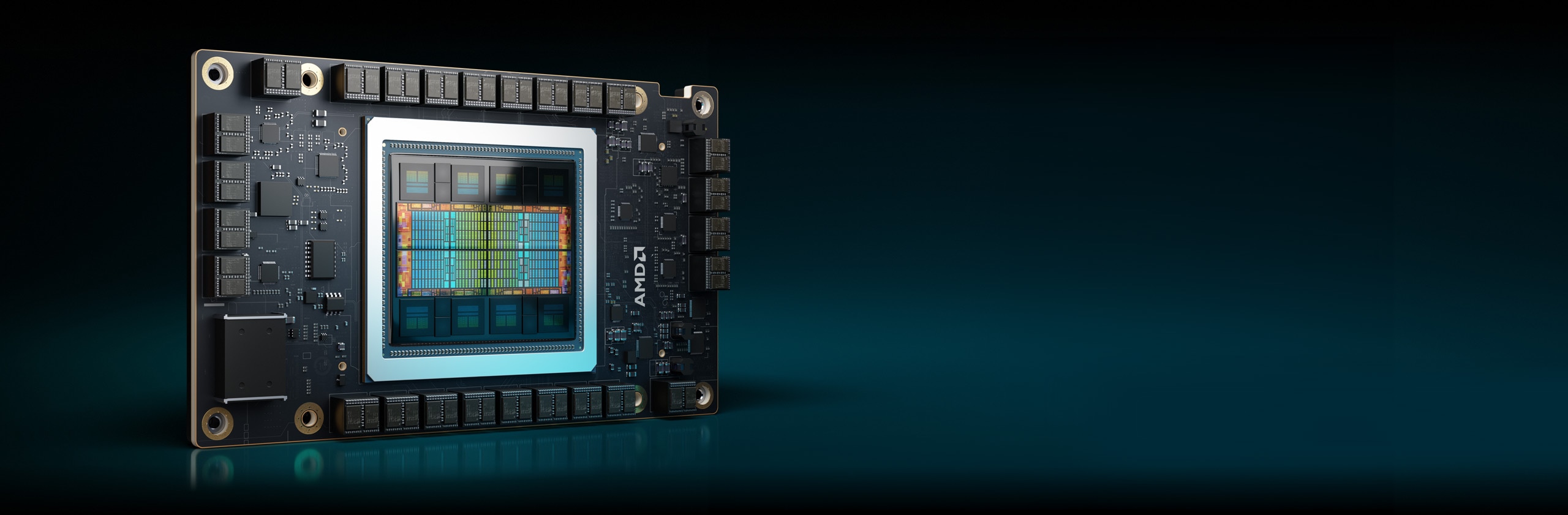

AMD Instinct™ MI325X アクセラレータのご紹介

AMD Instinct™ MI325X GPU アクセラレータは、第 3 世代 AMD CDNA™ アーキテクチャによって AI パフォーマンスの新しい標準を確立し、トレーニングと推論に驚異的なパフォーマンスと効率性を提供します。業界をリードする 256 GB HBM3E メモリと 6 TB/秒の帯域幅により、パフォーマンスを最適化し、TCO の削減を支援します。1

304 CU

304 個の GPU 演算ユニット

256 ギガバイト

256 GB HBM3E メモリ

6TB/s

6TB/s ピーク理論メモリ帯域幅

仕様比較

- AI パフォーマンス

- HPC 性能

- メモリ

AI パフォーマンス (ピーク TFLOPs)

競合アクセラレータと比較して最大 1.3 倍の AI パフォーマンス2、3

H200 SXM 141 GB

MI325X OAM 256 GB

HPC パフォーマンス (ピーク TFLOPs)

競合アクセラレータと比較して最大 2.4 倍の HPC 性能3

H200 SXM 141 GB

MI325X OAM 256 GB

メモリの容量と帯域幅

競合アクセラレータと比較して 1.8 倍のメモリ容量と 1.2 倍のメモリ帯域幅1

H200 SXM 141 GB

MI325X OAM 256 GB

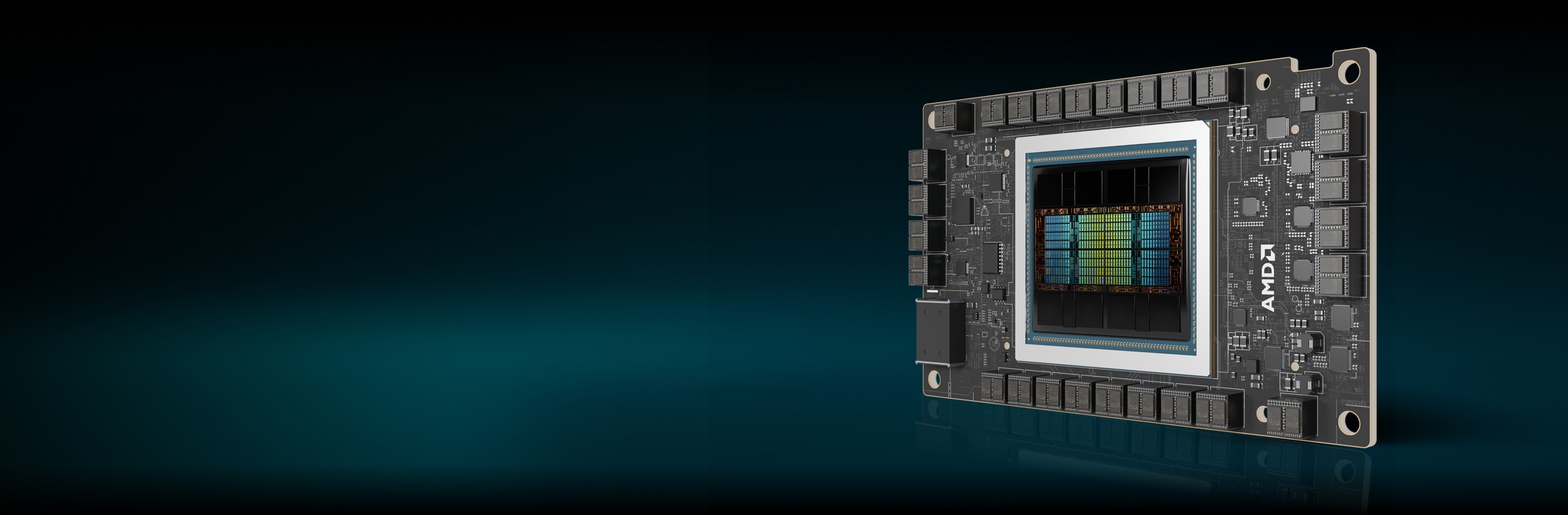

Instinct MI300X アクセラレータ

AMD Instinct MI300X シリーズ アクセラレータは、生成 AI ワークロードおよび HPC アプリケーション向けにリーダーシップ パフォーマンスを提供するように設計されています。

304 CU

304 個の GPU 演算ユニット

192GB

192 GB HBM3 メモリ

5.3TB/s

5.3TB/s ピーク理論メモリ帯域幅

AI パフォーマンス (ピーク TFLOPs)

競合アクセラレータと比較して最大 1.3 倍の AI パフォーマンス6

HPC 性能 (ピーク TFLOPs)

競合アクセラレータと比較して最大 2.4 倍の HPC 性能7

メモリの容量と帯域幅

競合アクセラレータと比較して 2.4 倍のメモリ容量と 1.6 倍のピーク理論メモリ帯域幅8

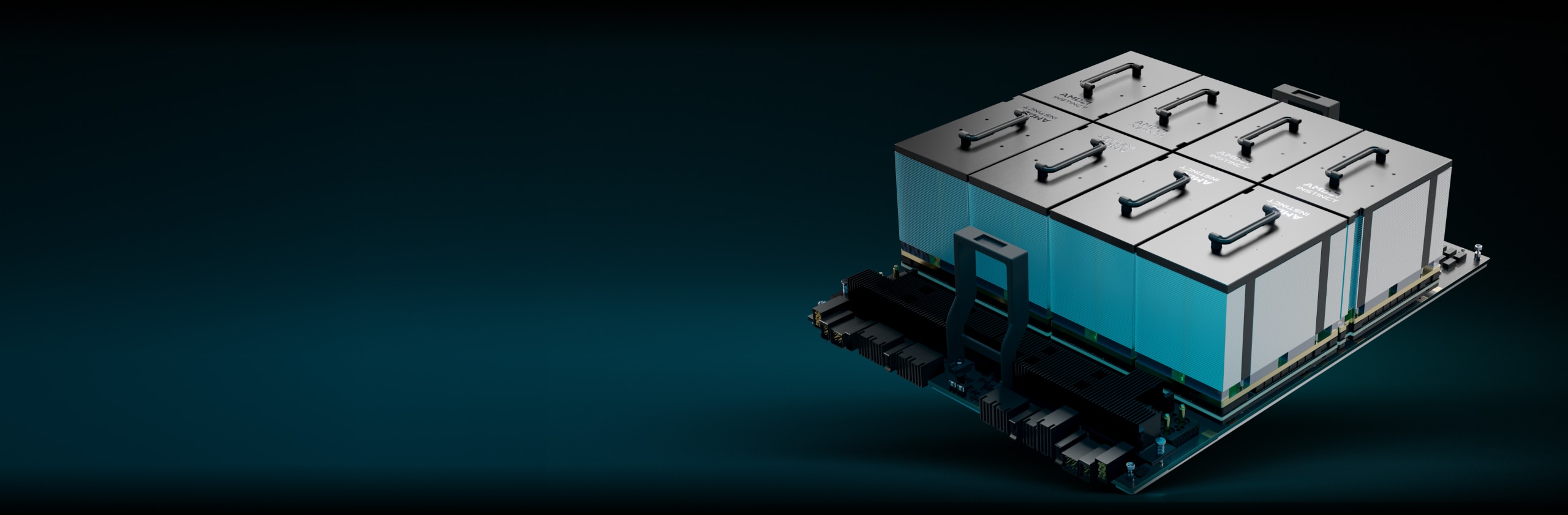

AMD Instinct プラットフォーム

AMD Instinct MI325X プラットフォームは、完全に接続された 8 個の MI325X GPU OAM モジュールを、第 4 世代 AMD Infinity Fabric™ リンクを介して業界標準の OCP 設計に統合し、低レイテンシの AI 処理向けに最大 2 TB の HBM3E 容量を提供します。すぐに導入可能なこのプラットフォームは、既存の AI ラックやサーバー インフラに MI325X アクセラレータを追加することで、タイム トゥ マーケットの時間を短縮し、開発コストを削減できます。

8 MI325X

8 MI325X GPU OAM モジュール

2 テラバイト

合計 2 TB の HBM3E メモリ

48TB/s

ピーク理論集約メモリ帯域幅 48 TB/s

AMD Instinct MI300A APU

AMD Instinct MI300A アクセラレーテッド プロセッシング ユニット (APU) は、AMD Instinct アクセラレータと AMD EPYC™ プロセッサの性能を共有メモリと組み合わせることで、効率性、柔軟性、プログラマビリティを向上させます。AI と HPC の集約を加速し、研究の進展と新たな発見の推進を支援するよう設計されています。

228 CU

228 個の GPU 演算ユニット

24

24 個の "Zen 4" x86 CPU コア

128GB

128 GB の統合された HBM3 メモリ

5.3TB/s

5.3TB/s ピーク理論メモリ帯域幅

AI パフォーマンス (ピーク TFLOPs)11

HPC 性能 (ピーク TFLOPs)

競合アクセラレータと比較して最大 1.8 倍の HPC 性能12

メモリの容量と帯域幅

競合アクセラレータと比較して 2.4 倍のメモリ容量と 1.6 倍のピーク理論メモリ帯域幅13

エクサスケールのコンピューティングの推進

AMD Instinct アクセラレータは、ローレンス リバモア国立研究所の El Capitan システムなど、世界トップクラスのスーパーコンピューターに搭載されています。この 2 エクサスケールのスーパーコンピューターが、AI を利用してどのように史上初のシミュレーションを実行し、科学研究を前進させているのかをご覧ください。

AMD ROCm™ ソフトウェア

AMD ROCm™ ソフトウェアには、AMD Instinct アクセラレータをターゲットとする AI モデルおよび HPC ワークロード向けのプログラミング モデル、ツール、コンパイラ、ライブラリ、ランタイムの幅広いセットが含まれています。

ケース スタディ

ソリューションの検索

AMD Instinct アクセラレータ ベースのソリューションを提供するパートナーの検索

リソース

最新情報を入手

サインアップして、最新のデータセンター ニュースとサーバー コンテンツを受信します。

脚注

- MI325-001A - 計算は、2024 年 9 月 26 日時点での仕様および/または推定に基づいて AMD パフォーマンス ラボにより実行されたものです。AMD Instinct™ MI325X OAM アクセラレータは、256 GB HBM3E メモリ容量と 6 TB/秒 GPU ピーク理論メモリ帯域幅のパフォーマンスを発揮します。製品版の半導体によって、実際の結果は異なる場合があります。

NVIDIA Hopper H200 (141 GB) SXM GPU アクセラレータの最高の公開結果は、141 GB HBM3E メモリ容量、4.8 TB/秒 GPU メモリ帯域幅パフォーマンスとなっています。 https://nvdam.widen.net/s/nb5zzzsjdf/hpc-datasheet-sc23-h200-datasheet-3002446

NVIDIA Blackwell HGX B100 (192 GB) 700 W GPU アクセラレータの公開結果で最高の値は以下のようになっています。HBM3E メモリ容量は 192 GB、GPU メモリの帯域幅パフォーマンスは 8 TB/秒。

NVIDIA Blackwell HGX B200 (192 GB) GPU アクセラレータの公開結果で最高の値は以下のようになっています。HBM3E メモリ容量は 192 GB、GPU メモリの帯域幅パフォーマンスは 8 TB/秒。

Nvidia Blackwell の仕様については、https://resources.nvidia.com/en-us-blackwell-architecture?_gl=1*1r4pme7*_gcl_aw*R0NMLjE3MTM5NjQ3NTAuQ2p3S0NBancyNkt4QmhCREVpd0F1NktYdDlweXY1dlUtaHNKNmhPdHM4UVdPSlM3dFdQaE40WkI4THZBaWFVajFy をご覧ください。

- MI325-002 - 2024 年 5 月 28 日に AMD パフォーマンス ラボで計算を実施しました。AMD Instinct™ MI325X GPU を計測したところ、結果は次のようになりました。1307.4 TFLOPS のピーク理論半精度 (FP16)、1307.4 TFLOPS のピーク理論 Bfloat16 フォーマット精度 (BF16)、2614.9 TFLOPS のピーク理論 8 ビット精度 (FP8)、2614.9 TOPs INT8 浮動小数点演算パフォーマンス。実際のパフォーマンスは最終仕様およびシステム構成により異なる場合があります。

Nvidia H200 SXM (141 GB) GPU に関して、次の結果が公開されています。989.4 TFLOPS ピーク理論半精度 Tensor (FP16 Tensor)、989.4 TFLOPS ピーク理論 Bfloat16 Tensor フォーマット精度 (BF16 Tensor)、1,978.9 TFLOPS ピーク理論 8 ビット精度 (FP8)、1,978.9 TOPs ピーク理論 INT8 浮動小数点演算パフォーマンス。BFLOAT16 Tensor コア、FP16 Tensor コア、FP8 Tensor コアおよび INT8 Tensor コア パフォーマンスは、Nvidia によりスパース性を使用して公開されました。AMD は、比較目的でこれらの数値を 2 で割ってスパース性なし/密度に変換しました。これらの数値は上に表示されます。

NVIDIA H200 の出典: https://nvdam.widen.net/s/nb5zzzsjdf/hpc-datasheet-sc23-h200-datasheet-3002446 および https://www.anandtech.com/show/21136/nvidia-at-sc23-h200-accelerator-with-hbm3e-and-jupiter-supercomputer-for-2024

注記: Nvidia H200 GPU の公開された FLOPS パフォーマンスは H100 製品のものと同じです (https://resources.nvidia.com/en-us-tensor-core/)。 MI325-02

- MI325-008 - AMD パフォーマンス ラボが 2024 年 10 月 2 日に AMD CDNA™ 3 5 nm | 6 nm FinFET プロセス テクノロジを使用して設計した AMD Instinct™ MI325X (1000 W) GPU で計算した結果、2,100 MHz のピーク ブースト エンジン クロックで 163.4 TFLOPS のピーク理論倍精度マトリックス (FP64 マトリックス)、81.7 TFLOPS ピーク理論倍精度 (FP64)、163.4 TFLOPS ピーク理論単精度マトリックス (FP32 マトリックス)、163.4 TFLOPS ピーク理論単精度 (FP32)、653.7 TFLOPS ピーク理論 TensorFloat-32 (TF32)、1307.4 TFLOPS ピーク理論半精度 (FP16) が得られました。実際のパフォーマンスは最終仕様およびシステム構成により異なる場合があります。

Nvidia H200 SXM (141 GB) GPU に関して、次の結果が公開されています。 66.9 TFLOPS ピーク理論倍精度 Tensor (FP64 Tensor)、33.5 TFLOPS ピーク理論倍精度 (FP64)、66.9 TFLOPS ピーク理論単精度 (FP32)、494.7 TFLOPS ピーク TensorFloat-32 (TF32)、989.5 TFLOPS ピーク理論半精度 Tensor (FP16 Tensor)。TF32 Tensor コア パフォーマンスは、Nvidia によりスパース性を使用して公開されました。AMD は、比較目的でこれらの数値を 2 で割ってスパース性なし/密度に変換しました。この数値は上に表示されます。

NVIDIA H200 の出典: https://nvdam.widen.net/s/nb5zzzsjdf/hpc-datasheet-sc23-h200-datasheet-3002446 および https://www.anandtech.com/show/21136/nvidia-at-sc23-h200-accelerator-with-hbm3e-and-jupiter-supercomputer-for-2024

注記: Nvidia H200 GPU の公開された FLOPS パフォーマンスは H100 製品のものと同じです (https://resources.nvidia.com/en-us-tensor-core/)。

* Nvidia H200 GPU は FP32 Tensor をサポートしていません。

- AMD パフォーマンス ラボが 2023 年 11 月 11 日に AMD CDNA™ 3 5 nm | 6 nm FinFET プロセス テクノロジを使用して設計した AMD Instinct™ MI300X (750 W) GPU で測定した結果、2,100 MHz のピーク ブースト エンジン クロックで 653.7 TFLOPS ピーク理論 TensorFloat-32 (TF32)、1307.4 TFLOPS ピーク理論半精度 (FP16)、1307.4 TFLOPS ピーク理論 Bfloat16 フォーマット精度 (BF16)、2614.9 TFLOPS ピーク理論 8 ビット精度 (FP8)、2614.9 TOPs INT8 浮動小数点の演算能力が得られました。MI300X は、微細な構造のスパース性を活用できるため、演算効率が推定で 2 倍向上し、その結果、1,307.4 TFLOPS ピーク理論 TensorFloat-32 (TF32)、2,614.9 TFLOPS ピーク理論半精度 (FP16)、2,614.9 TFLOPS ピーク理論 Bfloat16 フォーマット精度 (BF16)、5,229.8 TFLOPS ピーク理論 8 ビット精度 (FP8)、5,229.8 TOPs INT8 スパース浮動小数点演算パフォーマンスが得られると予想されます。AMD CDNA™ 2 5 nm FinFET プロセス テクノロジを使用して設計された AMD Instinct™ MI250X (560 W) 128 GB HBM2e OAM アクセラレータで測定した結果、1,700 MHz ピーク ブースト エンジン クロックで TF32* (N/A)、383.0 TFLOPS ピーク理論半精度 (FP16)、383.0 TFLOPS ピーク理論 Bfloat16 フォーマット精度 (BF16)、FP8* (N/A)、383.0 TOPs INT8 浮動小数点の演算能力が得られました。*AMD Instinct MI200 シリーズ GPU は、TF32、FP8、またはスパース性をサポートしていません。MI300-16

- 2023 年 6 月 2 日現在、AMD パフォーマンス ラボによる現行仕様あるいは社内エンジニアリング計算による測定値。Falcon-7B (7B、40B パラメーター)、LLaMA (13B、33B パラメーター)、OPT (66B パラメーター)、GPT-3 (175B パラメーター)、BLOOM (176B パラメーター)、PaLM (340B、540B パラメーター) モデルを実行するのに最低限必要な GPU 数を決定するために、FP16 精度で大規模言語モデル (LLM) を実行または計算します。計算された推定値は、GPU のみのメモリ サイズと、定義されたパラメーターに 10% のオーバーヘッドを加えたモデルで必要とされるメモリに基づいています。計算は、公表されている、場合によっては予備的なモデルのメモリ サイズに依存しています。GPT-3、BLOOM、PaML の結果は、システム/部品の有無により MI300X で推定されます。テスト結果の構成: AMD Instinct™ MI300X (192 GB HBM3、OAM モジュール) 750W アクセラレータ 1 基、EPYC 9654 (96 コア) CPU 1 基で構成される AMD ラボ システム

結果 (FP16 の精度):

モデル

パラメーター

必要メモリ合計

MI300X が必要

Falcon-7B

70 億

15.4GB

1 実測値

LLaMA

130 億

44GB

1 実測値

LLaMA

330 億

72.5GB

1 実測値

Falcon-40B

400 億

88GB

1 実測値

OPT

660 億

145.2GB

1 実測値

GPT-3

1,750 億

385GB

3 計算済み

ブルーム

1760 億

387.2GB

3 計算済み

PaLM

3,400 億

748GB

4 計算済み

PaLM

5,400 億

1188GB

7 計算済み

計算された推定値は、最終的なモデル サイズに応じて異なる可能性があります。実測値と推定値は、実際に必要となるオーバーヘッドや GPU メモリ以上のシステム メモリの使用によって異なる場合があります。サーバー メーカーの構成によって、異なる結果が生じる場合があります。MI300-07

- AMD パフォーマンス ラボが 2023 年 11 月 11 日に AMD CDNA™ 3 5 nm | 6 nm FinFET プロセス テクノロジを使用して設計した AMD Instinct™ MI300X (750 W) GPU で測定した結果、2,100 MHz のピーク ブースト エンジン クロックで 653.7 TFLOPS ピーク理論 TensorFloat-32 (TF32)、1307.4 TFLOPS ピーク理論半精度 (FP16)、1307.4 TFLOPS ピーク理論 Bfloat16 フォーマット精度 (BF16)、2614.9 TFLOPS ピーク理論 8 ビット精度 (FP8)、2614.9 TOPs INT8 浮動小数点の演算能力が得られました。MI300X は、微細な構造のスパース性を活用できるため、演算効率が推定で 2 倍向上し、その結果、1,307.4 TFLOPS ピーク理論 TensorFloat-32 (TF32)、2,614.9 TFLOPS ピーク理論半精度 (FP16)、2,614.9 TFLOPS ピーク理論 Bfloat16 フォーマット精度 (BF16)、5,229.8 TFLOPS ピーク理論 8 ビット精度 (FP8)、5,229.8 TOPs INT8 スパース浮動小数点演算パフォーマンスが得られると予想されます。NVIDIA H100 SXM (80GB) 700W GPU での公表結果では、スパース性を持つ TensorFloat-32 (TF32) のピーク値が 989.4 TFLOPS、スパース性を持つ理論半精度 (FP16) のピーク値が 1,978.9 TFLOPS、スパース性を含む理論 Bfloat16 フォーマット精度 (BF16) のピーク値が 1,978.9 TFLOPS、スパース性を持つ 8 ビット精度 (FP8) のピーク理論が 3,957.8 TFLOPS、スパース性を持つ INT8 浮動小数点性能のピーク理論が 3,957.8 TOPs。NVIDIA H100 ソース: https://resources.nvidia.com/en-us-tensor-core.MI300-17

- AMD パフォーマンス ラボが 2023 年 11 月 11 日に AMD CDNA™ 3 5 nm | 6 nm FinFET プロセス テクノロジを使用して設計した AMD Instinct™ MI300X (750 W) GPU で測定した結果、2,100 MHz のピーク ブースト エンジン クロックで 163.4 TFLOPS のピーク理論倍精度マトリックス (FP64 マトリックス)、81.7 TFLOPS ピーク理論倍精度 (FP64)、163.4 TFLOPS ピーク理論単精度マトリックス (FP32 マトリックス)、163.4 TFLOPS ピーク理論単精度 (FP32)、653.7 TFLOPS ピーク理論 TensorFloat-32 (TF32)、1307.4 TFLOPS ピーク理論半精度 (FP16)、1307.4 TFLOPS ピーク理論 Bfloat16 フォーマット精度 (BF16)、2614.9 TFLOPS ピーク理論 8 ビット精度 (FP8)、2614.9 TOPs INT8 浮動小数点の演算能力が得られました。NVIDIA H100 SXM (80 GB) GPU に関して公開された結果では、66.9 TFLOPS ピーク理論倍精度テンソル (FP64 テンソル)、33.5 TFLOPS ピーク理論倍精度 (FP64)、66.9 TFLOPS ピーク理論単精度 (FP32)、494.7 TFLOPS ピーク TensorFloat-32 (TF32)*、989.4 TFLOPS 理論半精度テンソル (FP16 テンソル)、133.8 TFLOPS ピーク理論半精度 (FP16)、989.4 TFLOPS ピーク理論 Bfloat16 テンソル フォーマット精度 (BF16 テンソル)、133.8 TFLOPS ピーク理論 Bfloat16 フォーマット精度 (BF16)、1,978.9 TFLOPS ピーク理論 8 ビット精度 (FP8)、1,978.9 TOPs ピーク理論 INT8 浮動小数点の演算能力が得られました。NVIDIA H100 ソース: https://resources.nvidia.com/en-us-tensor-core/ *NVIDIA H100 GPU は FP32 テンソルをサポートしていません。MI300-18

- 2023 年 11 月 17 日、AMD パフォーマンス ラボが次のシステムを使用して計算した結果です。AMD Instinct™ MI300X OAM アクセラレータ 750W (192 GB HBM3) は、AMD CDNA™ 3 5 nm FinFet プロセス テクノロジを使用して設計され、192 GB HBM3 メモリ容量と 5.325 TFLOPS のピーク理論メモリ帯域幅パフォーマンスが得られました。MI300X メモリ バス インターフェイスは 8,192、メモリ データ レートは 5.2 Gbps、合計ピーク メモリ帯域幅は 5.325 TB/秒 (8,192 ビット メモリ バス インターフェイス * 5.2 Gbps メモリ データ レート/8) です。NVIDIA Hopper H200 (141 GB) SXM GPU アクセラレータに関して公開されている結果の最高値は、141 GB の HBM3e メモリ容量と 4.8 Tb/s の GPU メモリ帯域幅パフォーマンスです (https://nvdam.widen.net/s/nb5zzzsjdf/hpc-datasheet-sc23-h200-datasheet-3002446)。NVIDIA Hopper H100 (80 GB) SXM5 GPU アクセラレータに関して公開されている結果の最高値は、80 GB の HBM3 メモリ容量と 3.35 TB/s の GPU メモリ帯域幅パフォーマンスです (https://resources.nvidia.com/en-us-tensor-core/nvidia-tensor-core-gpu-datasheet MI300-05A)。

- AMD パフォーマンス ラボが 2023 年 11 月 18 日に AMD CDNA™ 3 5 nm | 6 nm FinFET プロセス テクノロジを使用して設計した AMD Instinct™ MI300X (192 GB HBM3) 750 W GPU で測定した結果、2,100 MHz のピーク ブースト エンジン クロックで 1307.4 TFLOPS ピーク理論半精度 (FP16)、1307.4 TFLOPS ピーク理論 Bfloat16 フォーマット精度 (BF16) が得られました。MI300X は、微細な構造のスパースを活用できるため、演算効率が推定で 2 倍向上し、その結果、2,614.9 TFLOPS ピーク理論半精度 (FP16)、2,614.9 TFLOPS ピーク理論 Bfloat16 フォーマット精度 (スパース性を持つ BF16 浮動小数点の演算能力) が得られると予想されます。NVIDIA H100 SXM (80 GB HBM3) 700 W GPU に関して公開された結果では、スパース性を持つ 1,978.9 TFLOPS ピーク理論半精度 (FP16)、スパース性を持つ 1,978.9 TFLOPS ピーク理論 Bfloat16 フォーマット精度 (BF16) 浮動小数点の演算能力が得られました。NVIDIA H100 ソース: https://resources.nvidia.com/en-us-tensor-core/ 最大 8 個の AMD Infinity Fabric リンクが含まれている AMD Instinct™ MI300X AMD CDNA 3 テクノロジ ベースのアクセラレータでは、GPU ピアツーピア (P2P) データ転送において、GPU OAM モジュールあたり最大 1,024 GB/秒のピーク時理論帯域幅パフォーマンスが実現します。MI300-25

- AMD パフォーマンス ラボが 2023 年 11 月 11 日に AMD CDNA™ 3 5 nm | 6 nm FinFET プロセス テクノロジを使用して設計した AMD Instinct™ MI300A (760 W) APU で測定した結果、2,100 MHz のピーク ブースト エンジン クロックで 122.6 TFLOPS の理論倍精度 (FP64 マトリックス)、61.3 TFLOPS ピーク理論倍精度 (FP64)、122.6 TFLOPS ピーク理論単精度マトリックス (FP32 マトリックス)、122.6 TFLOPS ピーク理論単精度 (FP32)、490.3 TFLOPS ピーク理論 TensorFloat-32 (TF32)、980.6 TFLOPS ピーク理論半精度 (FP16)、980.6 TFLOPS ピーク理論 Bfloat16 フォーマット精度 (BF16)、1961.2 TFLOPS ピーク理論 8 ビット精度 (FP8)、1961.2 TOPs INT8 浮動小数点の演算能力が得られました。AMD CDNA™ 2 5 nm FinFET プロセス テクノロジを使用して設計された AMD Instinct™ MI250X (560 W) 128 GB HBM2e OAM アクセラレータで測定した結果、1,700 MHz ピーク ブースト エンジン クロックで 95.7 TFLOPS ピーク理論倍精度 (FP64 マトリックス)、47.9 TFLOPS 理論倍精度 (FP64)、95.7 TFLOPS ピーク理論単精度マトリックス (FP32 マトリックス)、47.9 TFLOPS ピーク理論単精度 (FP32)、TF32* (N/A)、383.0 TFLOPS ピーク理論半精度 (FP16)、383.0 TFLOPS ピーク理論 Bfloat16 フォーマット精度 (BF16)、FP8* (N/A)、383.0 TOPS INT8 浮動小数点の演算能力が得られました。サーバー メーカーの構成によって、異なる結果が生じる場合があります。* MI200 シリーズ GPU は、TF32、FP8、スパース性をサポートしていません。MI300-10

- AMD パフォーマンス ラボが 2023 年 11 月 11 日に AMD CDNA™ 3 5 nm | 6 nm FinFET プロセス テクノロジを使用して設計した AMD Instinct™ MI300A (750 W) APU で測定した結果、2,100 MHz のピーク ブースト エンジン クロックで 490.29 TFLOPS ピーク理論 TensorFloat-32 (TF32)、980.58 TFLOPS ピーク理論半精度 (FP16)、980.58 TFLOPS ピーク理論 Bfloat16 フォーマット精度 (BF16)、1961.16 TFLOPS ピーク理論 8 ビット精度 (FP8)、1961.16 TOPs INT8 浮動小数点の演算能力が得られました。MI300A は、微細な構造のスパース性を活用できるため、演算効率が推定で 2 倍向上し、その結果、980.58 TFLOPS ピーク理論 TensorFloat-32 (TF32)、1,961.16 TFLOPS ピーク理論半精度 (FP16)、1,961.16 TFLOPS ピーク理論 Bfloat16 フォーマット精度 (BF16)、3,922.33 TFLOPS ピーク理論 8 ビット精度 (FP8)、スパース性を持つ 3,922.33 TOPs INT8 浮動小数点の演算能力が得られると予想されます。NVIDIA H100 SXM5 (80GB) GPU に関して公開された結果では、スパース性を持つ TensorFloat-32 (TF32) Tensor Core のピーク理論値が 989.4 TFLOPS、スパース性を持つ半精度 (FP16) Tensor Core のピーク理論値が 1,978.9 TFLOPS、スパース性を持つ Bfloat16 形式精度 (BF16) Tensor Core のピーク理論値が 1,978.9 TFLOPS、スパース性を持つ 8 ビット精度 (FP8) Tensor Core のピーク理論値が 3,957.8 TFLOPS、スパース性を持つ INT8 Tensor Core 浮動小数点の演算能力のピーク理論値が 3,957.8 TOPs でした。NVIDIA H100 ソース: https://resources.nvidia.com/en-us-tensor-core/ サーバー メーカーの構成によって、異なる結果が生じる場合があります。MI300-21

- AMD パフォーマンス ラボが 2023 年 11 月 11 日に AMD CDNA™ 3 5 nm | 6 nm FinFET プロセス テクノロジを使用して設計した AMD Instinct™ MI300A (760W) GPU で測定した結果、2,100 MHz のピーク ブースト エンジン クロックで 122.6 TFLOPS のピーク理論倍精度マトリックス (FP64 マトリックス)、61.3 TFLOPS ピーク理論倍精度 (FP64)、122.6 TFLOPS ピーク理論単精度マトリックス (FP32 マトリックス)、122.6 TFLOPS ピーク理論単精度 (FP32)、490.29 TFLOPS ピーク理論 TensorFloat-32 (TF32)、980.58 TFLOPS ピーク理論半精度 (FP16)、980.58 TFLOPS ピーク理論 Bfloat16 フォーマット精度 (BF16)、1961.16 TFLOPS ピーク理論 8 ビット精度 (FP8)、1961.16 TOPs INT8 浮動小数点の演算能力が得られました。NVIDIA H100 SXM (80 GB) 700 W GPU に関して公開された結果では、66.9 TFLOPS ピーク理論倍精度テンソル (FP64 テンソル)、33.5 TFLOPS ピーク理論倍精度テンソル (FP64)、66.9 TFLOPS ピーク理論単精度テンソル (FP32)、494.7 TFLOPS ピーク TensorFloat-32 (TF32)*、989.4 TFLOPS 理論半精度テンソル (FP16 テンソル)、133.8 TFLOPS ピーク理論半精度 (FP16)、989.4 TFLOPS ピーク理論 Bfloat16 テンソル フォーマット精度 (BF16 テンソル)、133.8 TFLOPS ピーク理論 Bfloat16 フォーマット精度 (BF16)、1,978.9 TFLOPS ピーク理論 8 ビット精度 (FP8)、1,978.9 TOPs ピーク理論 INT8 浮動小数点の演算能力が得られました。NVIDIA H100 ソース: https://resources.nvidia.com/en-us-tensor-core/ サーバー メーカーの構成によって、異なる結果が生じる場合があります。*NVIDIA H100 GPU は FP32 テンソルをサポートしていませんMI300-20

- 2023 年 11 月 7 日、AMD パフォーマンス ラボが次のシステムを使用して計算した結果です。AMD Instinct™ MI300A APU アクセラレータ 760 W (128 GB HBM3) は、AMD CDNA™ 3 5 nm FinFet プロセス テクノロジを使用して設計され、128 GB HBM3 メモリ容量と 5.325 TFLOPS のピーク理論メモリ帯域幅パフォーマンスが得られました。MI300A メモリ バス インターフェイスは 8,192 (1024 ビット x 8 チップ)、メモリ データ レートは 5.2 Gbps、合計ピーク メモリ帯域幅は 5.325 TB/秒 (8,192 ビット メモリ バス インターフェイス * 5.2 Gbps メモリ データ レート/8) です。NVIDIA Hopper H200 (141 GB) SXM GPU アクセラレータに関して公開されている結果の最高値は、141 GB の HBM3e メモリ容量と 4.8 TB/秒の GPU メモリ帯域幅パフォーマンスです (https://nvdam.widen.net/s/nb5zzzsjdf/hpc-datasheet-sc23-h200-datasheet-3002446)。NVIDIA Hopper H100 (80GB) SXM GPU アクセラレータに関して公開されている結果の最高値は、80 GB の HBM3 メモリ容量と 3.35 TB/秒の GPU メモリ帯域幅パフォーマンスです (https://resources.nvidia.com/en-us-tensor-core/nvidia-tensor-core-gpu-datasheet)。サーバー メーカーの構成によって、異なる結果が生じる場合があります。MI300-12

- MI325-001A - 計算は、2024 年 9 月 26 日時点での仕様および/または推定に基づいて AMD パフォーマンス ラボにより実行されたものです。AMD Instinct™ MI325X OAM アクセラレータは、256 GB HBM3E メモリ容量と 6 TB/秒 GPU ピーク理論メモリ帯域幅のパフォーマンスを発揮します。製品版の半導体によって、実際の結果は異なる場合があります。

NVIDIA Hopper H200 (141 GB) SXM GPU アクセラレータの最高の公開結果は、141 GB HBM3E メモリ容量、4.8 TB/秒 GPU メモリ帯域幅パフォーマンスとなっています。 https://nvdam.widen.net/s/nb5zzzsjdf/hpc-datasheet-sc23-h200-datasheet-3002446

NVIDIA Blackwell HGX B100 (192 GB) 700 W GPU アクセラレータの公開結果で最高の値は以下のようになっています。HBM3E メモリ容量は 192 GB、GPU メモリの帯域幅パフォーマンスは 8 TB/秒。

NVIDIA Blackwell HGX B200 (192 GB) GPU アクセラレータの公開結果で最高の値は以下のようになっています。HBM3E メモリ容量は 192 GB、GPU メモリの帯域幅パフォーマンスは 8 TB/秒。

Nvidia Blackwell の仕様については、https://resources.nvidia.com/en-us-blackwell-architecture?_gl=1*1r4pme7*_gcl_aw*R0NMLjE3MTM5NjQ3NTAuQ2p3S0NBancyNkt4QmhCREVpd0F1NktYdDlweXY1dlUtaHNKNmhPdHM4UVdPSlM3dFdQaE40WkI4THZBaWFVajFy をご覧ください。 - MI325-002 - 2024 年 5 月 28 日に AMD パフォーマンス ラボで計算を実施しました。AMD Instinct™ MI325X GPU を計測したところ、結果は次のようになりました。1307.4 TFLOPS のピーク理論半精度 (FP16)、1307.4 TFLOPS のピーク理論 Bfloat16 フォーマット精度 (BF16)、2614.9 TFLOPS のピーク理論 8 ビット精度 (FP8)、2614.9 TOPs INT8 浮動小数点演算パフォーマンス。実際のパフォーマンスは最終仕様およびシステム構成により異なる場合があります。

Nvidia H200 SXM (141 GB) GPU に関して、次の結果が公開されています。989.4 TFLOPS ピーク理論半精度 Tensor (FP16 Tensor)、989.4 TFLOPS ピーク理論 Bfloat16 Tensor フォーマット精度 (BF16 Tensor)、1,978.9 TFLOPS ピーク理論 8 ビット精度 (FP8)、1,978.9 TOPs ピーク理論 INT8 浮動小数点演算パフォーマンス。BFLOAT16 Tensor コア、FP16 Tensor コア、FP8 Tensor コアおよび INT8 Tensor コア パフォーマンスは、Nvidia によりスパース性を使用して公開されました。AMD は、比較目的でこれらの数値を 2 で割ってスパース性なし/密度に変換しました。これらの数値は上に表示されます。

NVIDIA H200 の出典: https://nvdam.widen.net/s/nb5zzzsjdf/hpc-datasheet-sc23-h200-datasheet-3002446 および https://www.anandtech.com/show/21136/nvidia-at-sc23-h200-accelerator-with-hbm3e-and-jupiter-supercomputer-for-2024

注記: Nvidia H200 GPU の公開された FLOPS パフォーマンスは H100 製品のものと同じです (https://resources.nvidia.com/en-us-tensor-core/)。 MI325-02 - MI325-008 - AMD パフォーマンス ラボが 2024 年 10 月 2 日に AMD CDNA™ 3 5 nm | 6 nm FinFET プロセス テクノロジを使用して設計した AMD Instinct™ MI325X (1000 W) GPU で計算した結果、2,100 MHz のピーク ブースト エンジン クロックで 163.4 TFLOPS のピーク理論倍精度マトリックス (FP64 マトリックス)、81.7 TFLOPS ピーク理論倍精度 (FP64)、163.4 TFLOPS ピーク理論単精度マトリックス (FP32 マトリックス)、163.4 TFLOPS ピーク理論単精度 (FP32)、653.7 TFLOPS ピーク理論 TensorFloat-32 (TF32)、1307.4 TFLOPS ピーク理論半精度 (FP16) が得られました。実際のパフォーマンスは最終仕様およびシステム構成により異なる場合があります。

Nvidia H200 SXM (141 GB) GPU に関して、次の結果が公開されています。 66.9 TFLOPS ピーク理論倍精度 Tensor (FP64 Tensor)、33.5 TFLOPS ピーク理論倍精度 (FP64)、66.9 TFLOPS ピーク理論単精度 (FP32)、494.7 TFLOPS ピーク TensorFloat-32 (TF32)、989.5 TFLOPS ピーク理論半精度 Tensor (FP16 Tensor)。TF32 Tensor コア パフォーマンスは、Nvidia によりスパース性を使用して公開されました。AMD は、比較目的でこれらの数値を 2 で割ってスパース性なし/密度に変換しました。この数値は上に表示されます。

NVIDIA H200 の出典: https://nvdam.widen.net/s/nb5zzzsjdf/hpc-datasheet-sc23-h200-datasheet-3002446 および https://www.anandtech.com/show/21136/nvidia-at-sc23-h200-accelerator-with-hbm3e-and-jupiter-supercomputer-for-2024

注記: Nvidia H200 GPU の公開された FLOPS パフォーマンスは H100 製品のものと同じです (https://resources.nvidia.com/en-us-tensor-core/)。

* Nvidia H200 GPU は FP32 Tensor をサポートしていません。 - AMD パフォーマンス ラボが 2023 年 11 月 11 日に AMD CDNA™ 3 5 nm | 6 nm FinFET プロセス テクノロジを使用して設計した AMD Instinct™ MI300X (750 W) GPU で測定した結果、2,100 MHz のピーク ブースト エンジン クロックで 653.7 TFLOPS ピーク理論 TensorFloat-32 (TF32)、1307.4 TFLOPS ピーク理論半精度 (FP16)、1307.4 TFLOPS ピーク理論 Bfloat16 フォーマット精度 (BF16)、2614.9 TFLOPS ピーク理論 8 ビット精度 (FP8)、2614.9 TOPs INT8 浮動小数点の演算能力が得られました。MI300X は、微細な構造のスパース性を活用できるため、演算効率が推定で 2 倍向上し、その結果、1,307.4 TFLOPS ピーク理論 TensorFloat-32 (TF32)、2,614.9 TFLOPS ピーク理論半精度 (FP16)、2,614.9 TFLOPS ピーク理論 Bfloat16 フォーマット精度 (BF16)、5,229.8 TFLOPS ピーク理論 8 ビット精度 (FP8)、5,229.8 TOPs INT8 スパース浮動小数点演算パフォーマンスが得られると予想されます。AMD CDNA™ 2 5 nm FinFET プロセス テクノロジを使用して設計された AMD Instinct™ MI250X (560 W) 128 GB HBM2e OAM アクセラレータで測定した結果、1,700 MHz ピーク ブースト エンジン クロックで TF32* (N/A)、383.0 TFLOPS ピーク理論半精度 (FP16)、383.0 TFLOPS ピーク理論 Bfloat16 フォーマット精度 (BF16)、FP8* (N/A)、383.0 TOPs INT8 浮動小数点の演算能力が得られました。*AMD Instinct MI200 シリーズ GPU は、TF32、FP8、またはスパース性をサポートしていません。MI300-16

- 2023 年 6 月 2 日現在、AMD パフォーマンス ラボによる現行仕様あるいは社内エンジニアリング計算による測定値。Falcon-7B (7B、40B パラメーター)、LLaMA (13B、33B パラメーター)、OPT (66B パラメーター)、GPT-3 (175B パラメーター)、BLOOM (176B パラメーター)、PaLM (340B、540B パラメーター) モデルを実行するのに最低限必要な GPU 数を決定するために、FP16 精度で大規模言語モデル (LLM) を実行または計算します。計算された推定値は、GPU のみのメモリ サイズと、定義されたパラメーターに 10% のオーバーヘッドを加えたモデルで必要とされるメモリに基づいています。計算は、公表されている、場合によっては予備的なモデルのメモリ サイズに依存しています。GPT-3、BLOOM、PaML の結果は、システム/部品の有無により MI300X で推定されます。テスト結果の構成: AMD Instinct™ MI300X (192 GB HBM3、OAM モジュール) 750W アクセラレータ 1 基、EPYC 9654 (96 コア) CPU 1 基で構成される AMD ラボ システム

結果 (FP16 の精度):

モデル パラメーター 必要メモリ合計 MI300X が必要 Falcon-7B 70 億 15.4GB 1 実測値 LLaMA 130 億 44GB 1 実測値 LLaMA 330 億 72.5GB 1 実測値 Falcon-40B 400 億 88GB 1 実測値 OPT 660 億 145.2GB 1 実測値 GPT-3 1,750 億 385GB 3 計算済み ブルーム 1760 億 387.2GB 3 計算済み PaLM 3,400 億 748GB 4 計算済み PaLM 5,400 億 1188GB 7 計算済み 計算された推定値は、最終的なモデル サイズに応じて異なる可能性があります。実測値と推定値は、実際に必要となるオーバーヘッドや GPU メモリ以上のシステム メモリの使用によって異なる場合があります。サーバー メーカーの構成によって、異なる結果が生じる場合があります。MI300-07

- AMD パフォーマンス ラボが 2023 年 11 月 11 日に AMD CDNA™ 3 5 nm | 6 nm FinFET プロセス テクノロジを使用して設計した AMD Instinct™ MI300X (750 W) GPU で測定した結果、2,100 MHz のピーク ブースト エンジン クロックで 653.7 TFLOPS ピーク理論 TensorFloat-32 (TF32)、1307.4 TFLOPS ピーク理論半精度 (FP16)、1307.4 TFLOPS ピーク理論 Bfloat16 フォーマット精度 (BF16)、2614.9 TFLOPS ピーク理論 8 ビット精度 (FP8)、2614.9 TOPs INT8 浮動小数点の演算能力が得られました。MI300X は、微細な構造のスパース性を活用できるため、演算効率が推定で 2 倍向上し、その結果、1,307.4 TFLOPS ピーク理論 TensorFloat-32 (TF32)、2,614.9 TFLOPS ピーク理論半精度 (FP16)、2,614.9 TFLOPS ピーク理論 Bfloat16 フォーマット精度 (BF16)、5,229.8 TFLOPS ピーク理論 8 ビット精度 (FP8)、5,229.8 TOPs INT8 スパース浮動小数点演算パフォーマンスが得られると予想されます。NVIDIA H100 SXM (80GB) 700W GPU での公表結果では、スパース性を持つ TensorFloat-32 (TF32) のピーク値が 989.4 TFLOPS、スパース性を持つ理論半精度 (FP16) のピーク値が 1,978.9 TFLOPS、スパース性を含む理論 Bfloat16 フォーマット精度 (BF16) のピーク値が 1,978.9 TFLOPS、スパース性を持つ 8 ビット精度 (FP8) のピーク理論が 3,957.8 TFLOPS、スパース性を持つ INT8 浮動小数点性能のピーク理論が 3,957.8 TOPs。NVIDIA H100 ソース: https://resources.nvidia.com/en-us-tensor-core.MI300-17

- AMD パフォーマンス ラボが 2023 年 11 月 11 日に AMD CDNA™ 3 5 nm | 6 nm FinFET プロセス テクノロジを使用して設計した AMD Instinct™ MI300X (750 W) GPU で測定した結果、2,100 MHz のピーク ブースト エンジン クロックで 163.4 TFLOPS のピーク理論倍精度マトリックス (FP64 マトリックス)、81.7 TFLOPS ピーク理論倍精度 (FP64)、163.4 TFLOPS ピーク理論単精度マトリックス (FP32 マトリックス)、163.4 TFLOPS ピーク理論単精度 (FP32)、653.7 TFLOPS ピーク理論 TensorFloat-32 (TF32)、1307.4 TFLOPS ピーク理論半精度 (FP16)、1307.4 TFLOPS ピーク理論 Bfloat16 フォーマット精度 (BF16)、2614.9 TFLOPS ピーク理論 8 ビット精度 (FP8)、2614.9 TOPs INT8 浮動小数点の演算能力が得られました。NVIDIA H100 SXM (80 GB) GPU に関して公開された結果では、66.9 TFLOPS ピーク理論倍精度テンソル (FP64 テンソル)、33.5 TFLOPS ピーク理論倍精度 (FP64)、66.9 TFLOPS ピーク理論単精度 (FP32)、494.7 TFLOPS ピーク TensorFloat-32 (TF32)*、989.4 TFLOPS 理論半精度テンソル (FP16 テンソル)、133.8 TFLOPS ピーク理論半精度 (FP16)、989.4 TFLOPS ピーク理論 Bfloat16 テンソル フォーマット精度 (BF16 テンソル)、133.8 TFLOPS ピーク理論 Bfloat16 フォーマット精度 (BF16)、1,978.9 TFLOPS ピーク理論 8 ビット精度 (FP8)、1,978.9 TOPs ピーク理論 INT8 浮動小数点の演算能力が得られました。NVIDIA H100 ソース: https://resources.nvidia.com/en-us-tensor-core/ *NVIDIA H100 GPU は FP32 テンソルをサポートしていません。MI300-18

- 2023 年 11 月 17 日、AMD パフォーマンス ラボが次のシステムを使用して計算した結果です。AMD Instinct™ MI300X OAM アクセラレータ 750W (192 GB HBM3) は、AMD CDNA™ 3 5 nm FinFet プロセス テクノロジを使用して設計され、192 GB HBM3 メモリ容量と 5.325 TFLOPS のピーク理論メモリ帯域幅パフォーマンスが得られました。MI300X メモリ バス インターフェイスは 8,192、メモリ データ レートは 5.2 Gbps、合計ピーク メモリ帯域幅は 5.325 TB/秒 (8,192 ビット メモリ バス インターフェイス * 5.2 Gbps メモリ データ レート/8) です。NVIDIA Hopper H200 (141 GB) SXM GPU アクセラレータに関して公開されている結果の最高値は、141 GB の HBM3e メモリ容量と 4.8 Tb/s の GPU メモリ帯域幅パフォーマンスです (https://nvdam.widen.net/s/nb5zzzsjdf/hpc-datasheet-sc23-h200-datasheet-3002446)。NVIDIA Hopper H100 (80 GB) SXM5 GPU アクセラレータに関して公開されている結果の最高値は、80 GB の HBM3 メモリ容量と 3.35 TB/s の GPU メモリ帯域幅パフォーマンスです (https://resources.nvidia.com/en-us-tensor-core/nvidia-tensor-core-gpu-datasheet MI300-05A)。

- AMD パフォーマンス ラボが 2023 年 11 月 18 日に AMD CDNA™ 3 5 nm | 6 nm FinFET プロセス テクノロジを使用して設計した AMD Instinct™ MI300X (192 GB HBM3) 750 W GPU で測定した結果、2,100 MHz のピーク ブースト エンジン クロックで 1307.4 TFLOPS ピーク理論半精度 (FP16)、1307.4 TFLOPS ピーク理論 Bfloat16 フォーマット精度 (BF16) が得られました。MI300X は、微細な構造のスパースを活用できるため、演算効率が推定で 2 倍向上し、その結果、2,614.9 TFLOPS ピーク理論半精度 (FP16)、2,614.9 TFLOPS ピーク理論 Bfloat16 フォーマット精度 (スパース性を持つ BF16 浮動小数点の演算能力) が得られると予想されます。NVIDIA H100 SXM (80 GB HBM3) 700 W GPU に関して公開された結果では、スパース性を持つ 1,978.9 TFLOPS ピーク理論半精度 (FP16)、スパース性を持つ 1,978.9 TFLOPS ピーク理論 Bfloat16 フォーマット精度 (BF16) 浮動小数点の演算能力が得られました。NVIDIA H100 ソース: https://resources.nvidia.com/en-us-tensor-core/ 最大 8 個の AMD Infinity Fabric リンクが含まれている AMD Instinct™ MI300X AMD CDNA 3 テクノロジ ベースのアクセラレータでは、GPU ピアツーピア (P2P) データ転送において、GPU OAM モジュールあたり最大 1,024 GB/秒のピーク時理論帯域幅パフォーマンスが実現します。MI300-25

- AMD パフォーマンス ラボが 2023 年 11 月 11 日に AMD CDNA™ 3 5 nm | 6 nm FinFET プロセス テクノロジを使用して設計した AMD Instinct™ MI300A (760 W) APU で測定した結果、2,100 MHz のピーク ブースト エンジン クロックで 122.6 TFLOPS の理論倍精度 (FP64 マトリックス)、61.3 TFLOPS ピーク理論倍精度 (FP64)、122.6 TFLOPS ピーク理論単精度マトリックス (FP32 マトリックス)、122.6 TFLOPS ピーク理論単精度 (FP32)、490.3 TFLOPS ピーク理論 TensorFloat-32 (TF32)、980.6 TFLOPS ピーク理論半精度 (FP16)、980.6 TFLOPS ピーク理論 Bfloat16 フォーマット精度 (BF16)、1961.2 TFLOPS ピーク理論 8 ビット精度 (FP8)、1961.2 TOPs INT8 浮動小数点の演算能力が得られました。AMD CDNA™ 2 5 nm FinFET プロセス テクノロジを使用して設計された AMD Instinct™ MI250X (560 W) 128 GB HBM2e OAM アクセラレータで測定した結果、1,700 MHz ピーク ブースト エンジン クロックで 95.7 TFLOPS ピーク理論倍精度 (FP64 マトリックス)、47.9 TFLOPS 理論倍精度 (FP64)、95.7 TFLOPS ピーク理論単精度マトリックス (FP32 マトリックス)、47.9 TFLOPS ピーク理論単精度 (FP32)、TF32* (N/A)、383.0 TFLOPS ピーク理論半精度 (FP16)、383.0 TFLOPS ピーク理論 Bfloat16 フォーマット精度 (BF16)、FP8* (N/A)、383.0 TOPS INT8 浮動小数点の演算能力が得られました。サーバー メーカーの構成によって、異なる結果が生じる場合があります。* MI200 シリーズ GPU は、TF32、FP8、スパース性をサポートしていません。MI300-10

- AMD パフォーマンス ラボが 2023 年 11 月 11 日に AMD CDNA™ 3 5 nm | 6 nm FinFET プロセス テクノロジを使用して設計した AMD Instinct™ MI300A (750 W) APU で測定した結果、2,100 MHz のピーク ブースト エンジン クロックで 490.29 TFLOPS ピーク理論 TensorFloat-32 (TF32)、980.58 TFLOPS ピーク理論半精度 (FP16)、980.58 TFLOPS ピーク理論 Bfloat16 フォーマット精度 (BF16)、1961.16 TFLOPS ピーク理論 8 ビット精度 (FP8)、1961.16 TOPs INT8 浮動小数点の演算能力が得られました。MI300A は、微細な構造のスパース性を活用できるため、演算効率が推定で 2 倍向上し、その結果、980.58 TFLOPS ピーク理論 TensorFloat-32 (TF32)、1,961.16 TFLOPS ピーク理論半精度 (FP16)、1,961.16 TFLOPS ピーク理論 Bfloat16 フォーマット精度 (BF16)、3,922.33 TFLOPS ピーク理論 8 ビット精度 (FP8)、スパース性を持つ 3,922.33 TOPs INT8 浮動小数点の演算能力が得られると予想されます。NVIDIA H100 SXM5 (80GB) GPU に関して公開された結果では、スパース性を持つ TensorFloat-32 (TF32) Tensor Core のピーク理論値が 989.4 TFLOPS、スパース性を持つ半精度 (FP16) Tensor Core のピーク理論値が 1,978.9 TFLOPS、スパース性を持つ Bfloat16 形式精度 (BF16) Tensor Core のピーク理論値が 1,978.9 TFLOPS、スパース性を持つ 8 ビット精度 (FP8) Tensor Core のピーク理論値が 3,957.8 TFLOPS、スパース性を持つ INT8 Tensor Core 浮動小数点の演算能力のピーク理論値が 3,957.8 TOPs でした。NVIDIA H100 ソース: https://resources.nvidia.com/en-us-tensor-core/ サーバー メーカーの構成によって、異なる結果が生じる場合があります。MI300-21

- AMD パフォーマンス ラボが 2023 年 11 月 11 日に AMD CDNA™ 3 5 nm | 6 nm FinFET プロセス テクノロジを使用して設計した AMD Instinct™ MI300A (760W) GPU で測定した結果、2,100 MHz のピーク ブースト エンジン クロックで 122.6 TFLOPS のピーク理論倍精度マトリックス (FP64 マトリックス)、61.3 TFLOPS ピーク理論倍精度 (FP64)、122.6 TFLOPS ピーク理論単精度マトリックス (FP32 マトリックス)、122.6 TFLOPS ピーク理論単精度 (FP32)、490.29 TFLOPS ピーク理論 TensorFloat-32 (TF32)、980.58 TFLOPS ピーク理論半精度 (FP16)、980.58 TFLOPS ピーク理論 Bfloat16 フォーマット精度 (BF16)、1961.16 TFLOPS ピーク理論 8 ビット精度 (FP8)、1961.16 TOPs INT8 浮動小数点の演算能力が得られました。NVIDIA H100 SXM (80 GB) 700 W GPU に関して公開された結果では、66.9 TFLOPS ピーク理論倍精度テンソル (FP64 テンソル)、33.5 TFLOPS ピーク理論倍精度テンソル (FP64)、66.9 TFLOPS ピーク理論単精度テンソル (FP32)、494.7 TFLOPS ピーク TensorFloat-32 (TF32)*、989.4 TFLOPS 理論半精度テンソル (FP16 テンソル)、133.8 TFLOPS ピーク理論半精度 (FP16)、989.4 TFLOPS ピーク理論 Bfloat16 テンソル フォーマット精度 (BF16 テンソル)、133.8 TFLOPS ピーク理論 Bfloat16 フォーマット精度 (BF16)、1,978.9 TFLOPS ピーク理論 8 ビット精度 (FP8)、1,978.9 TOPs ピーク理論 INT8 浮動小数点の演算能力が得られました。NVIDIA H100 ソース: https://resources.nvidia.com/en-us-tensor-core/ サーバー メーカーの構成によって、異なる結果が生じる場合があります。*NVIDIA H100 GPU は FP32 テンソルをサポートしていませんMI300-20

- 2023 年 11 月 7 日、AMD パフォーマンス ラボが次のシステムを使用して計算した結果です。AMD Instinct™ MI300A APU アクセラレータ 760 W (128 GB HBM3) は、AMD CDNA™ 3 5 nm FinFet プロセス テクノロジを使用して設計され、128 GB HBM3 メモリ容量と 5.325 TFLOPS のピーク理論メモリ帯域幅パフォーマンスが得られました。MI300A メモリ バス インターフェイスは 8,192 (1024 ビット x 8 チップ)、メモリ データ レートは 5.2 Gbps、合計ピーク メモリ帯域幅は 5.325 TB/秒 (8,192 ビット メモリ バス インターフェイス * 5.2 Gbps メモリ データ レート/8) です。NVIDIA Hopper H200 (141 GB) SXM GPU アクセラレータに関して公開されている結果の最高値は、141 GB の HBM3e メモリ容量と 4.8 TB/秒の GPU メモリ帯域幅パフォーマンスです (https://nvdam.widen.net/s/nb5zzzsjdf/hpc-datasheet-sc23-h200-datasheet-3002446)。NVIDIA Hopper H100 (80GB) SXM GPU アクセラレータに関して公開されている結果の最高値は、80 GB の HBM3 メモリ容量と 3.35 TB/秒の GPU メモリ帯域幅パフォーマンスです (https://resources.nvidia.com/en-us-tensor-core/nvidia-tensor-core-gpu-datasheet)。サーバー メーカーの構成によって、異なる結果が生じる場合があります。MI300-12