Oferecendo suporte ao futuro da computação de IA e HPC

A IA e a computação de alto desempenho (HPC) continuam a transformar setores em todos os lugares, permitindo a automação e a melhoria da tomada de decisões, além de possibilitar novos produtos e serviços. Em quase todos os campos e em todos os setores, novas oportunidades levam a uma melhor produtividade, resultados de negócios e um futuro mais brilhante.

No entanto, a demanda cada vez maior por computação está direcionando os requisitos para hardware mais poderoso. À medida que mais empresas constroem sistemas suficientemente grandes para oferecer o nível de IA gerativa e aprendizado de máquina necessário para oferecer suporte a milhões de usuários, o foco da preocupação passa a ser na eficiência e no espaço: como os clientes podem configurar soluções que exigem muitos componentes e muitos sistemas e consomem energia considerável?

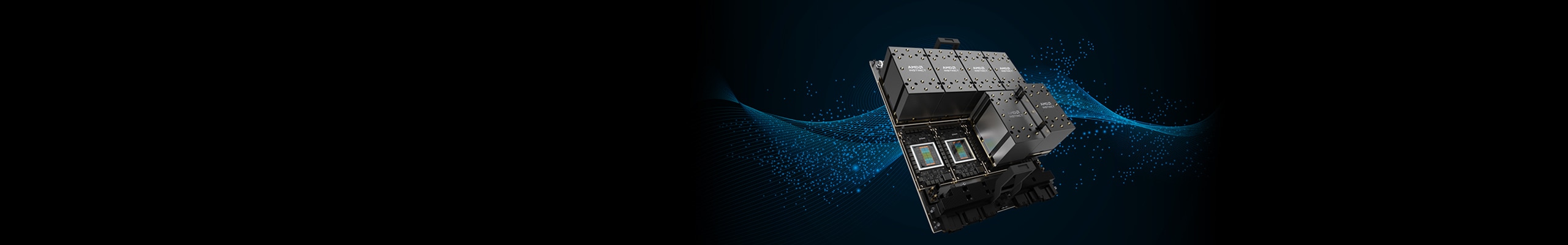

Para clientes que desejam aproveitar a IA e a HPC em seus negócios, os aceleradores AMD Instinct™ estão aqui para fazer isso acontecer, oferecendo um desempenho incrível sem saltos no tamanho do servidor ou no uso de energia, tudo graças às revoluções na arquitetura e inovações de produtos. A AMD tem o prazer de anunciar a disponibilidade para o acelerador AMD Instinct MI300X: um produto de GPU com a capacidade que os clientes precisam para atender às cargas de trabalho de IA e HPC mais exigentes – seja qual for o setor que estão servindo.

Acelerando a IA e a HPC para a era Exascale

Com base na arquitetura AMD CDNA™, os aceleradores AMD Instinct redefinem a computação para os negócios modernos. Projetado desde o início para a era Exascale, este processo oferece enormes ganhos em desempenho quando comparado a produtos baseados em GCN de geração anterior, como produtos AMD Radeon™ Instinct.1 Agora, com uma nova geração de produtos AMD Instinct, esse salto no desempenho continua a crescer.

Os aceleradores AMD Instinct Série MI300, projetados com a arquitetura CDNA AMD de 3a geração, foram revelados no início deste ano com a introdução do acelerador APU AMD Instinct™ MI300A, o primeiro APU do mundo criado especificamente para cargas de trabalho de IA e HPC. Um poderoso acelerador para densidade e eficiência revolucionárias, o acelerador AMD Instinct MI300A combina CPU, GPU e memória de largura de banda alta (HBM3) em uma APU para proporcionar um desempenho versátil em uma variedade de cargas de trabalho de ponta que se beneficiam de um hardware acelerado.

À medida que a IA continua a crescer tanto em aplicativos quanto em demanda possíveis, o acelerador de GPU AMD Instinct MI300X reúne os produtos AMD existentes no mercado para oferecer o nível de desempenho que os clientes buscam. Deixando de lado os núcleos da CPU, o acelerador AMD Instinct MI300X foca apenas no fornecimento de poder bruto da GPU, com a capacidade de combinar até oito GPUs em um nó. O resultado? Desempenho incrível e capacidade de memória HBM3 com suporte de largura de banda de memória líder para ajudar a elevar a novos patamares a aceleração de cargas de trabalho de HPC de longa data e a recente explosão de demandas de computação de IA generativa.2

Os aceleradores AMD Instinct MI300X oferecem 192 GB de memória HBM3, fornecendo cerca de 2,4 vezes a densidade de produtos concorrentes, com suporte de até 5,3 TB/s de largura de banda de memória de pico e oferecendo cerca de 1,6x a largura de banda em relação aos produtos concorrentes disponíveis.2

Eficiência em escala

À medida que as cargas de trabalho de IA são dimensionadas, o hardware presentes nelas também precisam se expandir. O espaço rapidamente se torna um fator premium à medida que as empresas dimensionam para atender à demanda, mas acaba se tornando um gargalo que os clientes precisam superar.

É com isso em mente que os aceleradores AMD Instinct MI300X fornecem uma solução pronta para uso de projeto de plataforma OCP padrão do setor UBB que permite aos clientes combinar oito GPUs em um único nó orientado por desempenho com um projeto de anel ponto a ponto totalmente conetado com um total de 1,5 TB de memória HBM3 em uma única plataforma, fazendo dele uma solução com densidade de desempenho para qualquer implantação de carga de trabalho de IA ou HPC.

AMD ROCm™: a plataforma de software aberto cheia de possibilidades de IA

O AMD ROCm™ é a única plataforma de software aberto do setor para computação de GPU, liberando os clientes da restrição a opções limitadas de qualquer fornecedor. Com uma plataforma de software aberta e portátil, os clientes podem obter flexibilidade de arquitetura e liberdade para fazer mais com seu hardware.

A AMD está ajudando a impulsionar a possibilidade no espaço de IA graças a produtos inovadores, como o acelerador AMD MI300X. É hora de aprender mais sobre os aceleradores AMD Instinct, com um ecossistema aberto, uma gama cada vez mais ampla de produtos poderosos para usuários de servidores e soluções personalizadas por meio de arquiteturas dedicadas e adaptáveis. Libere as possibilidades em IA e computação de alto desempenho hoje.

Entre em contato com seu representante AMD hoje mesmo para obter mais informações ou, para saber mais, visite o AMD Instinct Hub.

Notas de rodapé

- MI100-04: Os cálculos realizados pelo AMD Performance Labs em 18 de setembro de 2020 para o acelerador AMD Instinct™ MI100 a um pico de 1.502 MHz de aumento de clock do mecanismo resultaram em um pico de 184,57 TFLOPS (FP16) de desempenho teórico do ponto de flutuação de meia precisão e em um pico de 46,14 TFLOPS de desempenho teórico do ponto de flutuação de matriz de precisão única (FP32). Os resultados calculados para a GPU Radeon Instinct™ MI50 a um pico de 1,725 MHz no clock do mecanismo resultaram em um pico de 26,5 TFLOPS (FP16) de desempenho do ponto de flutuação teórico de precisão e em um pico de 13,25 TLOPS de precisão única (matriz FP32). Os fabricantes de servidores podem variar as configurações oferecidas, gerando resultados diferentes.

- MI300-05A: Cálculos conduzidos pelo AMD Performance Labs em 17 de maio de 2023 para o acelerador AMD Instinct™ MI300X OAM de 750 W (HBM3 de 192 GB), projetado com a tecnologia de processo AMD CDNA™ 3 5 nm FinFet, que resultou em capacidade de memória HBM3 de 192 GB e desempenho de largura de banda de memória máxima e contínua de 5,218 TFLOPs. A interface do barramento de memória MI300X é de 8.192 bits, e a taxa de dados de memória é de 5,6 Gbps para largura de banda de memória total e contínua de ajuste de entrega de 5,218 TB/s (interface de barramento de memória de 8.192 bits * taxa de dados de memória de 5,6 Gbps/8)*0,91. Os resultados publicados mais elevados para o acelerador de GPU NVidia Hopper H100 (80 GB) SXM resultaram em capacidade de memória HBM3 de 80 GB e desempenho de largura de banda de memória de GPU de 3,35 TB/s.

- MI100-04: Os cálculos realizados pelo AMD Performance Labs em 18 de setembro de 2020 para o acelerador AMD Instinct™ MI100 a um pico de 1.502 MHz de aumento de clock do mecanismo resultaram em um pico de 184,57 TFLOPS (FP16) de desempenho teórico do ponto de flutuação de meia precisão e em um pico de 46,14 TFLOPS de desempenho teórico do ponto de flutuação de matriz de precisão única (FP32). Os resultados calculados para a GPU Radeon Instinct™ MI50 a um pico de 1,725 MHz no clock do mecanismo resultaram em um pico de 26,5 TFLOPS (FP16) de desempenho do ponto de flutuação teórico de precisão e em um pico de 13,25 TLOPS de precisão única (matriz FP32). Os fabricantes de servidores podem variar as configurações oferecidas, gerando resultados diferentes.

- MI300-05A: Cálculos conduzidos pelo AMD Performance Labs em 17 de maio de 2023 para o acelerador AMD Instinct™ MI300X OAM de 750 W (HBM3 de 192 GB), projetado com a tecnologia de processo AMD CDNA™ 3 5 nm FinFet, que resultou em capacidade de memória HBM3 de 192 GB e desempenho de largura de banda de memória máxima e contínua de 5,218 TFLOPs. A interface do barramento de memória MI300X é de 8.192 bits, e a taxa de dados de memória é de 5,6 Gbps para largura de banda de memória total e contínua de ajuste de entrega de 5,218 TB/s (interface de barramento de memória de 8.192 bits * taxa de dados de memória de 5,6 Gbps/8)*0,91. Os resultados publicados mais elevados para o acelerador de GPU NVidia Hopper H100 (80 GB) SXM resultaram em capacidade de memória HBM3 de 80 GB e desempenho de largura de banda de memória de GPU de 3,35 TB/s.