AI と HPC コンピューティングの未来を支える

AI とハイパフォーマンス コンピューティング (HPC) は、あらゆる産業で変革を起こし続けており、自動化を推し進め、意思決定を向上させ、新しい製品やサービスを生み出しています。ほぼすべての分野、産業にわたって新しい機会が生まれ、それが生産性の向上や事業上の成果、明るい未来へとつながっていますが、

コンピューティングに対する需要は止めどなく強まっており、ハードウェアのパフォーマンス要件がますます厳しくなっています。何百人もの利用者の対応に求められる生成 AI や機械学習のレベルまで到達できるようにするだけの十分な規模のシステムを構築する企業が増えているなか、関心事項は効率とスペースに移りつつあります。顧客は、多くのコンポーネントやシステム、膨大な電力を必要とするソリューションを、どのように構成すればよいのでしょうか?

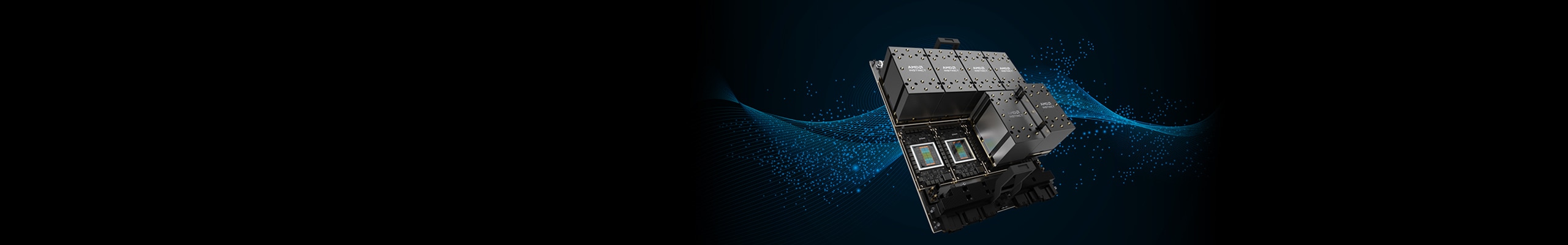

ビジネスに AI や HPC を活用しようと考えている顧客にとって、その答えは AMD Instinct™ アクセラレータです。サーバーのサイズや消費エネルギーを増やすことなく、驚異的なパフォーマンスを発揮できるようになります。まさにアーキテクチャと製品イノベーションの革命がなし得ることです。AMD が今回リリースする AMD Instinct MI300X アクセラレータは、顧客の業界が何かに関係なく、要求が厳しい AI や HPC のワークロードに対応することができる GPU 製品です。

エクサスケール時代の流れに乗った AI と HPC

AMD CDNA™ アーキテクチャをベースにした AMD Instinct アクセラレータは、現代のビジネスに合わせてコンピューティングのあり方を変えました。このプロセスは、エクサスケール時代に合わせるためにゼロから構築したもので、AMD Radeon™ Instinct 製品のような旧世代の GCN ベースの製品と比較してパフォーマンス面で大きな飛躍を遂げています。1そして今回、新世代の AMD Instinct 製品の誕生と共に、パフォーマンスの向上はさらなる高みへと進んでいきます。

第 3 世代 AMD CDNA アーキテクチャを採用した AMD Instinct MI300 シリーズ アクセラレータが発表されたのは今年初頭です。AI や HPC のワークロードに特化した世界初の APU として AMD Instinct™ MI300A APU アクセラレータが発表されました。AMD Instinct MI300A アクセラレータは、画期的な集積度と効率を備えた強力なアクセラレータであり、CPU、GPU、広帯域幅メモリ (HBM3) を 1 つの APU に統合しています。そのため、幅広い最先端のワークロード、幅広い用途に応用することができ、ハードウェア高速化の恩恵を受けることができます。

現在、AI は応用分野と需要の両方で成長し続けており、顧客が求めているレベルのパフォーマンスに応えられるよう、AMD Instinct MI300X GPU アクセラレータも既存の AMD 製品と同じく市場に投入されています。AMD Instinct MI300X アクセラレータは、CPU コアを廃し、GPU パワーだけに特化した形で 1 ノードに最大 8 個の GPU を搭載しています。その結果、業界をリードするメモリ帯域幅に支えられた驚異的なパフォーマンスと HBM3 メモリ容量は、長年にわたって HPC ワークロードの高速化に貢献し、近年爆発的に増えている生成 AI コンピューティングの需要を新しい高みへと押し上げます。2

AMD Instinct MI300X アクセラレータには、192 GB の HBM3 メモリが搭載されており、その集積度は競合製品の約 2.4 倍に達し、また、ピーク メモリ帯域幅は最大 5.3 TB/秒で、市場に出ている競合製品の約 1.6 倍の帯域幅を備えています。2

規模拡大に応じた効率性の向上

AI ワークロードの規模の拡大に伴い、その原動力となるハードウェアも拡大する必要があります。その需要を満たすために規模を拡大すると、その占有スペースがコスト高を生むようになり、顧客にとって克服すべきボトルネックになります。

AMD Instinct MI300X アクセラレータは、このことを念頭に置いて構築されており、UBB 業界標準の OCP プラットフォーム設計のドロップイン ソリューションとなります。1 つのパフォーマンス主導型のノードに 8 個の GPU を集約し、ピアツーピアのリング設計でフルに接続し、1 台のプラットフォームに合計 1.5 TB の HBM3 メモリを搭載することができます。AI や HPC のワークロードの導入に適したパフォーマンス集約型のソリューションとなっています。

AMD ROCm™: AI の可能性を広げるオープン ソフトウェア プラットフォーム

AMD ROCm™ は、GPU コンピューティングを対象とした業界唯一のオープン ソフトウェア プラットフォームであり、ベンダー 1 社しか選択できないという制約から顧客を解放します。オープンでポータブルなソフトウェア プラットフォームであるため、顧客にとってアーキテクチャの自由度が高まり、また、ハードウェアでできることを増やすことができます。

AMD は、AMD MI300X アクセラレータのような革新的な製品をリリースすることで、AI 分野における可能性の拡大に貢献しています。AMD Instinct アクセラレータは、オープンなエコシステム、サーバー ユーザー向けに範囲を広げた強力な製品群、そして、適応性の高い専用アーキテクチャによるソリューションのカスタマイズ機能を備えています。ぜひこの機会に、AMD Instinct アクセラレータの詳細をご確認ください。今こそ、AI とハイパフォーマンス コンピューティングの可能性を引き出すタイミングです。

詳細については、AMD の担当者にお問い合わせいただくか、または AMD Instinct Hub をご覧ください。

脚注

- MI100-04: 2020 年 9 月 18 日に AMD パフォーマンス ラボが行った計算に基づきます。AMD Instinct™ MI100 アクセラレータを 1,502 MHz のピーク ブースト エンジン クロックで計算した結果、184.57 TFLOPS ピーク理論半精度 (FP16) および 46.14 TFLOPS ピーク理論単精度 (FP32) マトリックス浮動小数点パフォーマンスが得られました。Radeon Instinct™ MI50 GPU の計測を 1,725 MHz のピーク エンジン クロックで実施したところ、結果は以下のようになりました。26.5 TFLOPS のピーク理論半精度 (FP16)、13.25 TFLOPS のピーク理論単精度 (FP32) マトリックス浮動小数点演算パフォーマンス。サーバー メーカーの構成によって、異なる結果が生じる場合があります。

- MI300-05A: 2023 年 5 月 17 日に AMD パフォーマンス ラボで以下のシステムを使用して計算を実施しました。AMD CDNA™ 3 5 nm FinFet プロセス テクノロジを使用して設計された AMD Instinct™ MI300X OAM アクセラレータ 750 W (192 GB HBM3) では、192 GB の HBM3 メモリ容量と 5.218 TFLOPS の持続ピーク メモリ帯域幅パフォーマンスが得られました。MI300X のメモリ バス インターフェイスは 8,192 ビット、メモリ データ レートは 5.6 Gbps、持続可能なピーク メモリ帯域幅の合計は 5.218 TB/秒 (8,192 ビットのメモリ バス インターフェイス * 5.6 Gbps のメモリ データ レート/8) * 0.91 (調整値) です。 NVIDIA Hopper H100 (80 GB) SXM GPU アクセラレータの公開結果で最高の値は以下のようになっています。HBM3 メモリ容量は 80 GB、GPU メモリの帯域幅パフォーマンスは 3.35 TB/秒。

- MI100-04: 2020 年 9 月 18 日に AMD パフォーマンス ラボが行った計算に基づきます。AMD Instinct™ MI100 アクセラレータを 1,502 MHz のピーク ブースト エンジン クロックで計算した結果、184.57 TFLOPS ピーク理論半精度 (FP16) および 46.14 TFLOPS ピーク理論単精度 (FP32) マトリックス浮動小数点パフォーマンスが得られました。Radeon Instinct™ MI50 GPU の計測を 1,725 MHz のピーク エンジン クロックで実施したところ、結果は以下のようになりました。26.5 TFLOPS のピーク理論半精度 (FP16)、13.25 TFLOPS のピーク理論単精度 (FP32) マトリックス浮動小数点演算パフォーマンス。サーバー メーカーの構成によって、異なる結果が生じる場合があります。

- MI300-05A: 2023 年 5 月 17 日に AMD パフォーマンス ラボで以下のシステムを使用して計算を実施しました。AMD CDNA™ 3 5 nm FinFet プロセス テクノロジを使用して設計された AMD Instinct™ MI300X OAM アクセラレータ 750 W (192 GB HBM3) では、192 GB の HBM3 メモリ容量と 5.218 TFLOPS の持続ピーク メモリ帯域幅パフォーマンスが得られました。MI300X のメモリ バス インターフェイスは 8,192 ビット、メモリ データ レートは 5.6 Gbps、持続可能なピーク メモリ帯域幅の合計は 5.218 TB/秒 (8,192 ビットのメモリ バス インターフェイス * 5.6 Gbps のメモリ データ レート/8) * 0.91 (調整値) です。 NVIDIA Hopper H100 (80 GB) SXM GPU アクセラレータの公開結果で最高の値は以下のようになっています。HBM3 メモリ容量は 80 GB、GPU メモリの帯域幅パフォーマンスは 3.35 TB/秒。