La pila de software de IA de AMD más avanzada

Algoritmos y modelos más recientes

Razonamiento mejorado, algoritmos de atención y MoE disperso para mejorar la eficiencia

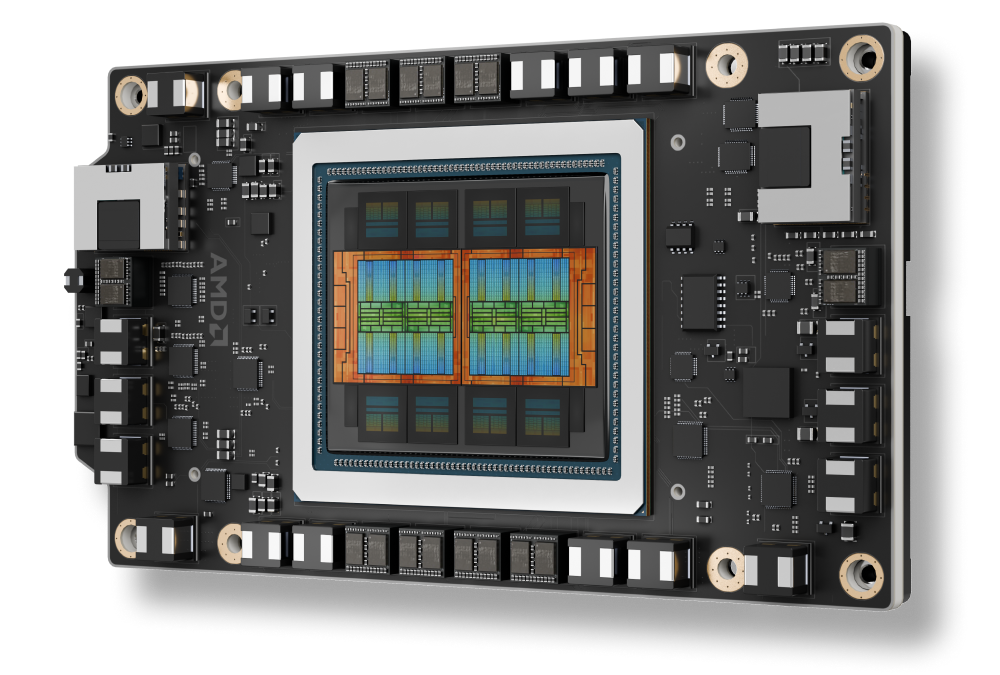

Compatibilidad con AMD Instinct™ Serie MI350

Arquitectura AMD CDNA 4, compatible con nuevos tipos de datos con HBM avanzado

Funciones avanzadas para escalación de IA

Inferencia distribuida sin interrupciones, capacitación de MoE, aprendizaje por refuerzo a escala

Herramientas de IA listas para empresas

Implementa y administra la IA en clústeres con orquestación y soporte para puntos de conexión

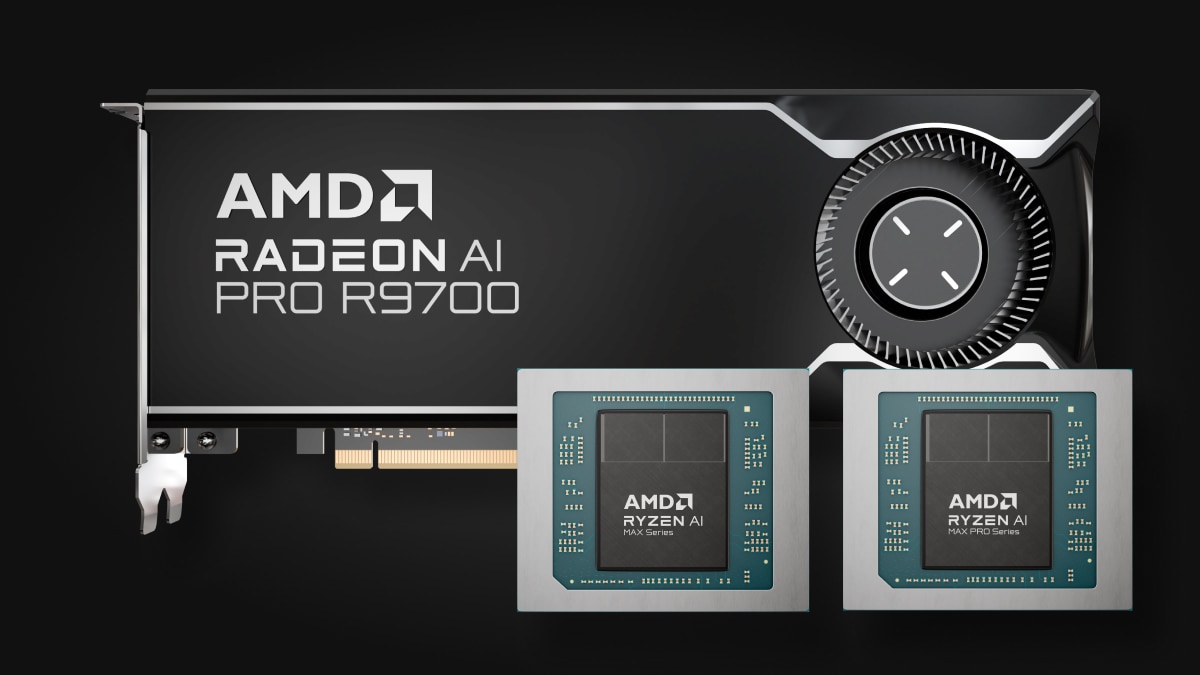

IA en el punto de conexión

Desde Ryzen™ AI hasta gráficos Radeon™, un procesador versátil con IA en el punto de conexión para cualquier aplicación

Salto generacional en rendimiento

ROCm 7 frente a ROCm 6

Inferencia¹

Capacitación²

Compatibilidad con AMD Instinct™ Serie MI350

Potencia las GPU de AMD Instinct™ Serie MI350

Mejora la integración sin interrupciones de las plataformas AMD Instinct MI350X con infraestructura de rack abierto, lo que permite una implementación rápida y un rendimiento de IA optimizado a escala.

Escala la IA empresarial

Inferencia distribuida con Open Ecosystem

Con vLLM-d, DeepEP, SGLang y acceso directo a la GPU, la plataforma de software ROCm permite el mayor rendimiento de servicio a escala de rack, en lotes, en nodos y en modelos.

ROCm para el ciclo de vida de IA

El software ROCm se integra en los marcos de IA empresarial para proporcionar un flujo de trabajo integral de código abierto dirigido a la IA de producción, que abarca ROCm Enterprise AI y la gestión de clústeres ROCm para facilitar una implementación y una escalabilidad sin interrupciones.

IA en el punto de conexión

Expande el ecosistema ROCm en los procesadores AMD Ryzen™ AI y las tarjetas gráficas AMD Radeon™

El ecosistema de IA de puntos de conexión ROCm cuenta con tecnología de la eficiente plataforma de compilación de código abierto TheROCK, que presenta lanzamientos nocturnos de ROCm y PyTorch. Este sistema, ahora compatible con Linux y Windows, se adapta a los productos Radeon RX Serie 9000 más recientes y los Ryzen AI Max líderes, de modo que proporciona una base sólida para el desarrollo y la implementación de IA sin interrupciones.

Una vista previa de PyTorch ya está disponible: Compatibilidad con Linux para AMD Ryzen™ AI Serie 300* y Ryzen AI Serie Max, y compatibilidad con Windows para AMD Ryzen AI Serie 300*, Ryzen AI Serie Max y todas las series AMD Radeon™ RX 7000 y Radeon W7000 (y posteriores).

* Para obtener una lista completa de los productos compatibles, visita nuestra página de matriz de compatibilidad.

Comienza hoy

Acelera tus tareas de IA/ML, computación de alto rendimiento y análisis de datos con la nube de desarrolladores de AMD.

Mantente informado

Mantente al día con lo último de ROCm.

Notas al pie

- MI300-080: pruebas realizadas por laboratorios de rendimiento de AMD al 15 de mayo del 2025, que miden el rendimiento de inferencia en tokens por segundo (TPS) del software AMD ROCm 6.x, vLLM 0.3.3 frente al software en versión de vista previa AMD ROCm 7.0, vLLM 0.8.5 en un sistema con (8) GPU de AMD Instinct MI300X que ejecuta modelos Llama 3.1-70B (TP2), Qwen 72B (TP2), y DeepSeek-R1 (FP16) con tamaños de lote de 1-256 y longitudes de secuencia de 128-204. El aumento del rendimiento declarado se expresa como el TPS promedio sobre los (3) LLM probados.

Configuración de hardwareServidor de CPU AMD EPYC™ 9534 de 1P con 8 GPU AMD Instinct™ MI300X (192 GB, 750 W), Supermicro AS-8125GS-TNMR2, NPS1 (1 NUMA por socket), 1,5 TiB (24 DIMM, 4800 mts de memoria, 64 GiB/DIMM), almacenamiento de 4 Micron 7450 de 3,49 TB, versión del BIOS: 1.8

Configuración de software

Ubuntu 22.04 LTS con kernel de Linux 5.15.0-119 genérico

Qwen 72B y Llama 3.1-70B:

software en versión de vista previa ROCm 7.0

PyTorch 2.7.0. DeepSeek R-1: ROCm 7.0 versión de vista previa, SGLang 0.4.6, PyTorch 2.6.0

frente a

Qwen 72 y Llama 3.1-70B: software ROCm 6.x con disponibilidad general

PyTorch 2.7.0 y 2.1.1, respectivamente,

DeepSeek R-1: software ROCm 6.x con disponibilidad general

SGLang 0.4.1, PyTorch 2.5.0

Los fabricantes de servidores pueden variar las configuraciones, lo que arroja resultados diferentes. El rendimiento puede variar según la configuración, el software, la versión de vLLM y el uso de los controladores y optimizaciones más recientes.

- MI300-081: pruebas realizadas por laboratorios de rendimiento de AMD al 15 de mayo del 2025, para medir el rendimiento de capacitación (TFLOPS) del software en versión de vista previa ROCm 7.0, Megatron-LM, con (8) GPU de AMD Instinct MI300X que ejecutan modelos Llama 2-70B (4K), Qwen1.5-14B y Llama 3.1-8B y un contenedor de acoplamiento personalizado, en comparación con un sistema configurado de manera similar con el software ROCm 6.0 de AMD.

Configuración de hardware

CPU AMD EPYC™ 9454 de 1P, 8 GPU AMD Instinct MI300X (192 GB, 750 W), versión del BIOS de American Megatrends International LLC: 1.8, BIOS 1.8.

Configuración de software

Ubuntu 22.04 LTS con kernel de Linux 5.15.0-70 genérico

ROCm 7.0., Megatron-LM, PyTorch 2.7.0

frente a

software ROCm 6.0 de versión pública, secciones de código Megatron-LM hanl/disable_te_llama2 para Llama 2-7B, guihong_dev para Llama 2-70B, renwuli/disable_te_qwen1.5 para Qwen1.5-14B, PyTorch 2.2.

Los fabricantes de servidores pueden variar las configuraciones, lo que arroja resultados diferentes. El rendimiento puede variar según la configuración, el software, la versión de vLLM y el uso de los controladores y optimizaciones más recientes.

- MI300-080: pruebas realizadas por laboratorios de rendimiento de AMD al 15 de mayo del 2025, que miden el rendimiento de inferencia en tokens por segundo (TPS) del software AMD ROCm 6.x, vLLM 0.3.3 frente al software en versión de vista previa AMD ROCm 7.0, vLLM 0.8.5 en un sistema con (8) GPU de AMD Instinct MI300X que ejecuta modelos Llama 3.1-70B (TP2), Qwen 72B (TP2), y DeepSeek-R1 (FP16) con tamaños de lote de 1-256 y longitudes de secuencia de 128-204. El aumento del rendimiento declarado se expresa como el TPS promedio sobre los (3) LLM probados.

Configuración de hardwareServidor de CPU AMD EPYC™ 9534 de 1P con 8 GPU AMD Instinct™ MI300X (192 GB, 750 W), Supermicro AS-8125GS-TNMR2, NPS1 (1 NUMA por socket), 1,5 TiB (24 DIMM, 4800 mts de memoria, 64 GiB/DIMM), almacenamiento de 4 Micron 7450 de 3,49 TB, versión del BIOS: 1.8

Configuración de software

Ubuntu 22.04 LTS con kernel de Linux 5.15.0-119 genérico

Qwen 72B y Llama 3.1-70B:

software en versión de vista previa ROCm 7.0

PyTorch 2.7.0. DeepSeek R-1: ROCm 7.0 versión de vista previa, SGLang 0.4.6, PyTorch 2.6.0

frente a

Qwen 72 y Llama 3.1-70B: software ROCm 6.x con disponibilidad general

PyTorch 2.7.0 y 2.1.1, respectivamente,

DeepSeek R-1: software ROCm 6.x con disponibilidad general

SGLang 0.4.1, PyTorch 2.5.0

Los fabricantes de servidores pueden variar las configuraciones, lo que arroja resultados diferentes. El rendimiento puede variar según la configuración, el software, la versión de vLLM y el uso de los controladores y optimizaciones más recientes.

- MI300-081: pruebas realizadas por laboratorios de rendimiento de AMD al 15 de mayo del 2025, para medir el rendimiento de capacitación (TFLOPS) del software en versión de vista previa ROCm 7.0, Megatron-LM, con (8) GPU de AMD Instinct MI300X que ejecutan modelos Llama 2-70B (4K), Qwen1.5-14B y Llama 3.1-8B y un contenedor de acoplamiento personalizado, en comparación con un sistema configurado de manera similar con el software ROCm 6.0 de AMD.

Configuración de hardware

CPU AMD EPYC™ 9454 de 1P, 8 GPU AMD Instinct MI300X (192 GB, 750 W), versión del BIOS de American Megatrends International LLC: 1.8, BIOS 1.8.

Configuración de software

Ubuntu 22.04 LTS con kernel de Linux 5.15.0-70 genérico

ROCm 7.0., Megatron-LM, PyTorch 2.7.0

frente a

software ROCm 6.0 de versión pública, secciones de código Megatron-LM hanl/disable_te_llama2 para Llama 2-7B, guihong_dev para Llama 2-70B, renwuli/disable_te_qwen1.5 para Qwen1.5-14B, PyTorch 2.2.

Los fabricantes de servidores pueden variar las configuraciones, lo que arroja resultados diferentes. El rendimiento puede variar según la configuración, el software, la versión de vLLM y el uso de los controladores y optimizaciones más recientes.