Der fortschrittlichste KI-Software-Stack von AMD

Neueste Algorithmen und Modelle

Verbessertes Reasoning, Aufmerksamkeitsalgorithmen und Sparse MoE für mehr Effizienz

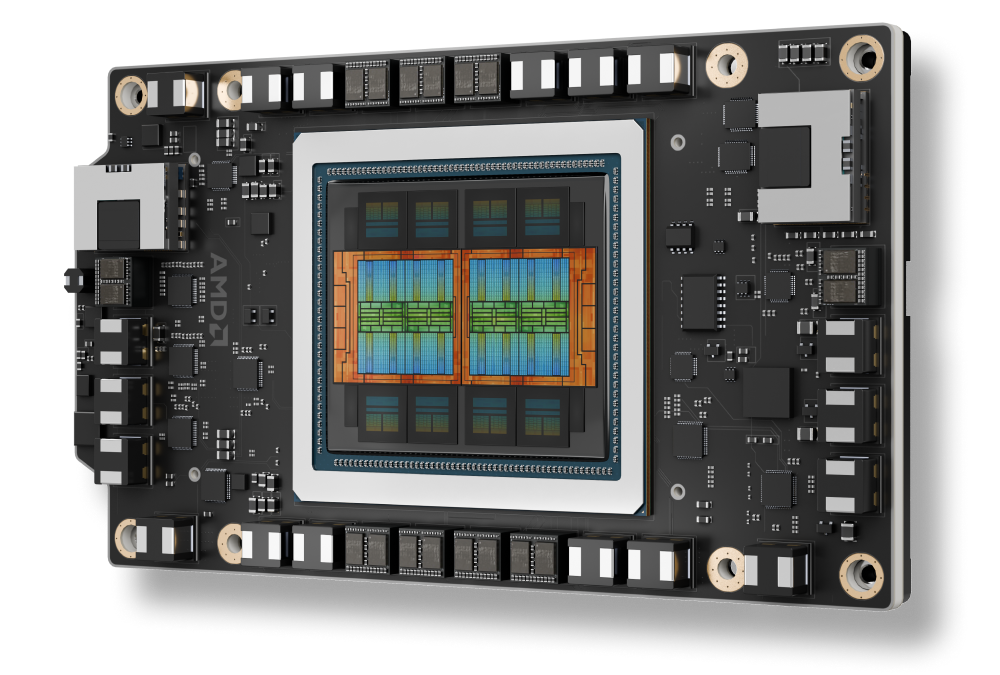

Unterstützung für AMD Instinct™ MI350-Serie

AMD CDNA 4 Architektur zur Unterstützung neuer Datentypen mit erweitertem HBM

Erweiterte Funktionen zur Skalierung von KI

Nahtlos verteilte Inferenz, MoE-Training, Verstärkungslernen im großen Maßstab

KI-Tools für Unternehmen

KI mit Orchestrierung und Endpunkt-Unterstützung über Cluster hinweg bereitstellen und verwalten

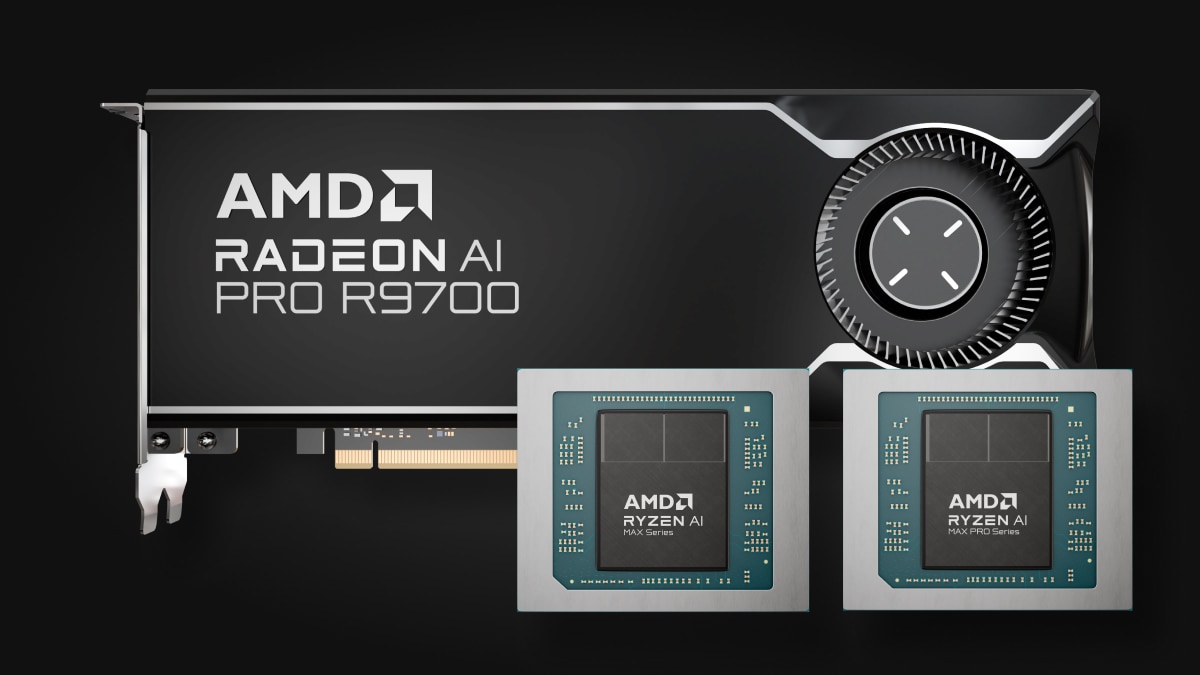

KI am Endpunkt

Von Ryzen™ AI bis hin zu Radeon™ Grafikkarten – vielseitiger Endpunkt-KI-Prozessor für jede Anwendung

Eine neue Generation an Performance

ROCm 7 im Vergleich zu ROCm 6

Inferenz¹

Training²

Unterstützung für AMD Instinct™ MI350-Serie

Unterstützung für AMD Instinct™ MI350-Serie GPUs

Verbesserung der nahtlosen Integration von AMD Instinct MI350X Plattformen in die offene Rack-Infrastruktur für eine schnelle Bereitstellung und optimierte KI-Performance im großen Maßstab.

Skalierung von Unternehmens-KI

Verteilte Inferenz mit offenem Ökosystem

Mit vLLM-d, DeepEP, SGLang und GPU-Direktzugriff ermöglicht die ROCm Softwareplattform den höchsten Durchsatz im Rack-Maßstab – über Batches, Knoten und Modelle hinweg.

ROCm für KI-Lebenszyklus

Die ROCm Software lässt sich in Unternehmens-KI-Frameworks integrieren und stellt so einen vollständig offenen End-to-End-Workflow für Produktions-KI bereit. Dieser umfasst ROCm Enterprise AI und ROCm Cluster Management, sodass eine nahtlose Bereitstellung und Skalierbarkeit möglich werden.

KI am Endpunkt

Erweiterung des ROCm Ökosystems auf AMD Ryzen™ AI Prozessoren und AMD Radeon™ Grafikeinheiten

Das ROCm-Endpoint-KI-Ökosystem basiert auf der effizienten Open-Source-Plattform für Builds TheROCK mit nächtlichen Releases von ROCm und PyTorch. Dieses System unterstützt jetzt sowohl Linux als auch Windows und ist für die neueste Radeon RX 9000-Serie und die führenden Ryzen AI Max Produkte ausgelegt. Es bietet eine robuste Grundlage für eine nahtlose KI-Entwicklung und -Bereitstellung.

Eine Vorschau von PyTorch ist jetzt verfügbar: Linux-Unterstützung für AMD Ryzen™ AI 300-Serie* und Ryzen AI Max-Serie sowie Windows-Unterstützung für AMD Ryzen AI 300-Serie*, Ryzen AI Max-Serie und für alle AMD Radeon™ RX 7000- und Radeon W7000-Serie (und neuer).

*Vollständige Liste der unterstützten Produkte siehe Seite mit Kompatibilitätsmatrix.

Noch heute durchstarten

Beschleunigen Sie Ihre KI/ML-, High-Performance-Computing- und Datenanalyseaufgaben mit der AMD Developer Cloud.

Immer informiert bleiben

Bleiben Sie mit den neuesten Nachrichten über ROCm informiert.

Fußnoten

- MI300-080 – Tests durchgeführt vom AMD Leistungslabor am 15. Mai 2025 zur Messung der Inferenz-Performance in Token pro Sekunde (TPS) der AMD ROCm 6.x Software, vLLM 0.3.3 im Vergleich zu AMD ROCm 7.0 Preview Version SW, vLLM 0.8.5 auf einem System mit (8) AMD Instinct MI300X GPUs mit Llama 3.1-70B (TP2), Qwen 72B (TP2) und Deepseek-R1 (FP16) Modellen mit Batch-Größen von 1–256 und Sequenzlängen von 128–204. Die angegebene Performance-Verbesserung wird als durchschnittliche TPS über die (3) getesteten LLMs ausgedrückt.

Hardwarekonfiguration1P AMD EPYC™ 9534 CPU Server mit 8 x AMD Instinct™ MI300X (192 GB, 750 W) GPUs, Supermicro AS-8125GS-TNMR2, NPS1 (1 NUMA pro Sockel), 1,5 TiB (24 DIMMs, 4800 MT/s Speicher, 64 GiB/DIMM), 4 x 3,49 TB Micron 7450 Speicher, BIOS-Version: 1,8

Softwarekonfiguration(en)

Ubuntu 22.04 LTS mit Linux-Kernel 5.15.0-119-generic

Qwen 72B und Llama 3.1-70B –

ROCm 7.0 Preview Version SW

PyTorch 2.7.0. DeepSeek R-1 – ROCm 7.0 Preview Version, SGLang 0.4.6, PyTorch 2.6.0

im Vergleich zu

Qwen 72 und Llama 3.1-70B – ROCm 6.x GA SW

PyTorch 2.7.0 bzw. 2.1.1,

DeepSeek R-1: ROCm 6.x GA SW

SGLang 0.4.1, PyTorch 2.5.0

Serverhersteller wählen möglicherweise andere Konfigurationen, was zu anderen Ergebnissen führen kann. Die Performance kann je nach Konfiguration, Software, vLLM-Version und Verwendung der neuesten Treiber und Optimierungen variieren.

- MI300-081 – Tests durchgeführt vom AMD Leistungslabor am 15. Mai 2025 zur Messung der Trainings-Performance (TFLOPS) der ROCm 7.0 Preview Version Software, Megatron-LM auf (8) AMD Instinct MI300X GPUs mit Llama 2-70B (4K), Qwen1.5-14B und Llama3.1-8B Modellen sowie einem benutzerdefinierten Docker Container im Vergleich zu einem ähnlich konfigurierten System mit AMD ROCm 6.0 Software.

Hardwarekonfiguration

1P AMD EPYC™ 9454 CPU, 8 x AMD Instinct MI300X (192 GB, 750 W) GPUs, American Megatrends International LLC BIOS-Version: 1.8, BIOS 1.8.

Softwarekonfiguration

Ubuntu 22.04 LTS mit Linux-Kernel 5.15.0-70-generic

ROCm 7.0, Megatron-LM, PyTorch 2.7.0

im Vergleich zu

ROCm 6.0 Public Release SW, Megatron-LM Codeverzweigungen hanl/disable_te_llama2 for Llama 2-7B, guihong_dev for Lama 2-70B, renwuli/disable_te_qwen1.5 for Qwen1.5-14B, PyTorch 2.2.

Serverhersteller wählen möglicherweise andere Konfigurationen, was zu anderen Ergebnissen führen kann. Die Performance kann je nach Konfiguration, Software, vLLM-Version und Verwendung der neuesten Treiber und Optimierungen variieren.

- MI300-080 – Tests durchgeführt vom AMD Leistungslabor am 15. Mai 2025 zur Messung der Inferenz-Performance in Token pro Sekunde (TPS) der AMD ROCm 6.x Software, vLLM 0.3.3 im Vergleich zu AMD ROCm 7.0 Preview Version SW, vLLM 0.8.5 auf einem System mit (8) AMD Instinct MI300X GPUs mit Llama 3.1-70B (TP2), Qwen 72B (TP2) und Deepseek-R1 (FP16) Modellen mit Batch-Größen von 1–256 und Sequenzlängen von 128–204. Die angegebene Performance-Verbesserung wird als durchschnittliche TPS über die (3) getesteten LLMs ausgedrückt.

Hardwarekonfiguration1P AMD EPYC™ 9534 CPU Server mit 8 x AMD Instinct™ MI300X (192 GB, 750 W) GPUs, Supermicro AS-8125GS-TNMR2, NPS1 (1 NUMA pro Sockel), 1,5 TiB (24 DIMMs, 4800 MT/s Speicher, 64 GiB/DIMM), 4 x 3,49 TB Micron 7450 Speicher, BIOS-Version: 1,8

Softwarekonfiguration(en)

Ubuntu 22.04 LTS mit Linux-Kernel 5.15.0-119-generic

Qwen 72B und Llama 3.1-70B –

ROCm 7.0 Preview Version SW

PyTorch 2.7.0. DeepSeek R-1 – ROCm 7.0 Preview Version, SGLang 0.4.6, PyTorch 2.6.0

im Vergleich zu

Qwen 72 und Llama 3.1-70B – ROCm 6.x GA SW

PyTorch 2.7.0 bzw. 2.1.1,

DeepSeek R-1: ROCm 6.x GA SW

SGLang 0.4.1, PyTorch 2.5.0

Serverhersteller wählen möglicherweise andere Konfigurationen, was zu anderen Ergebnissen führen kann. Die Performance kann je nach Konfiguration, Software, vLLM-Version und Verwendung der neuesten Treiber und Optimierungen variieren.

- MI300-081 – Tests durchgeführt vom AMD Leistungslabor am 15. Mai 2025 zur Messung der Trainings-Performance (TFLOPS) der ROCm 7.0 Preview Version Software, Megatron-LM auf (8) AMD Instinct MI300X GPUs mit Llama 2-70B (4K), Qwen1.5-14B und Llama3.1-8B Modellen sowie einem benutzerdefinierten Docker Container im Vergleich zu einem ähnlich konfigurierten System mit AMD ROCm 6.0 Software.

Hardwarekonfiguration

1P AMD EPYC™ 9454 CPU, 8 x AMD Instinct MI300X (192 GB, 750 W) GPUs, American Megatrends International LLC BIOS-Version: 1.8, BIOS 1.8.

Softwarekonfiguration

Ubuntu 22.04 LTS mit Linux-Kernel 5.15.0-70-generic

ROCm 7.0, Megatron-LM, PyTorch 2.7.0

im Vergleich zu

ROCm 6.0 Public Release SW, Megatron-LM Codeverzweigungen hanl/disable_te_llama2 for Llama 2-7B, guihong_dev for Lama 2-70B, renwuli/disable_te_qwen1.5 for Qwen1.5-14B, PyTorch 2.2.

Serverhersteller wählen möglicherweise andere Konfigurationen, was zu anderen Ergebnissen führen kann. Die Performance kann je nach Konfiguration, Software, vLLM-Version und Verwendung der neuesten Treiber und Optimierungen variieren.