最先端の AMD AI ソフトウェア スタック

最新のアルゴリズムとモデル

推論、Attention アルゴリズム、スパース MoE の強化によって効率の向上を実現

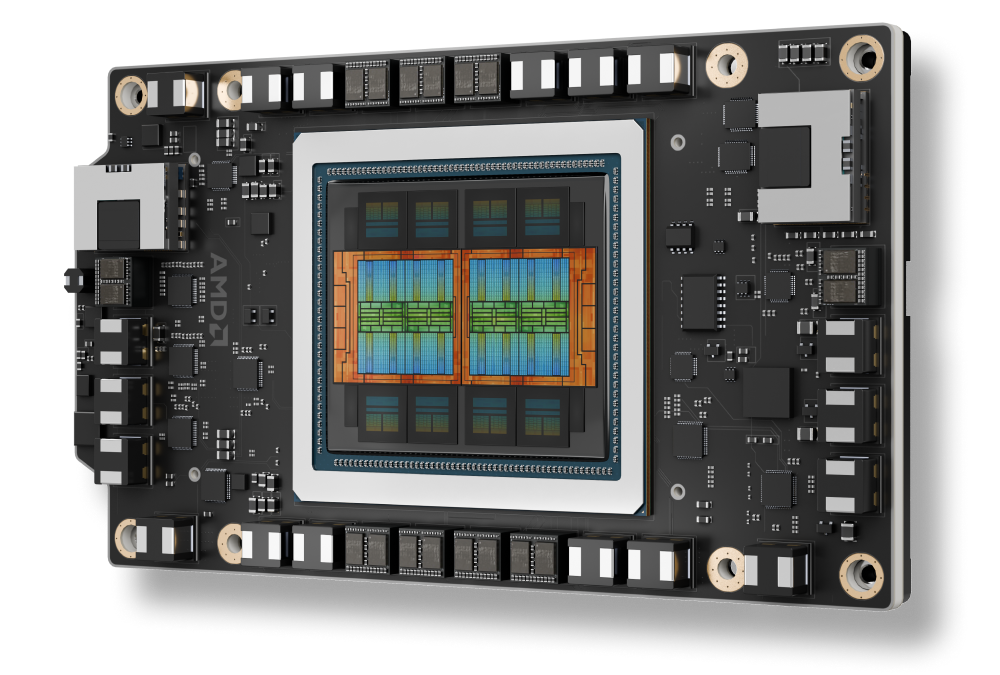

AMD Instinct™ MI350 シリーズに対応

AMD CDNA 4 アーキテクチャ、高度な HBM により新しいデータ型をサポート

AI スケーリングのための高度な機能

シームレスな分散推論、MoE トレーニング、大規模な強化学習

エンタープライズ対応 AI ツール

オーケストレーションとエンドポイントのサポートにより、AI をクラスター全体に導入、管理

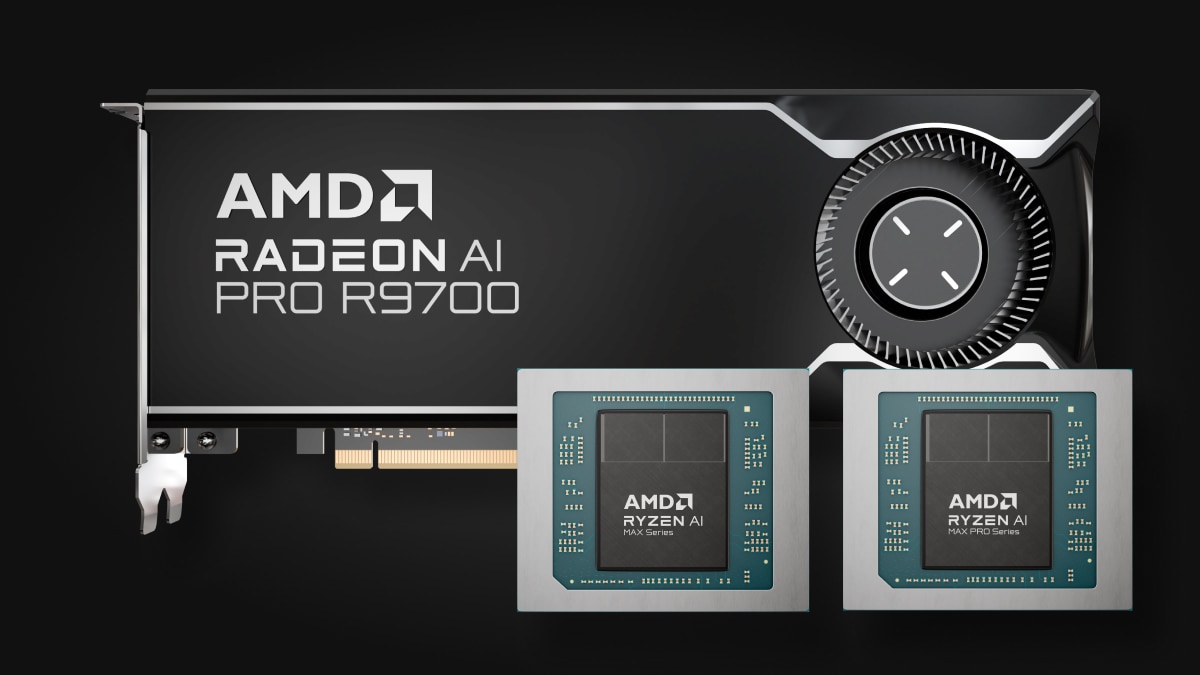

エンドポイントでの AI

Ryzen™ AI から Radeon™ グラフィックスまで、あらゆるアプリケーションに対応する汎用性の高いエンドポイントでの AI プロセッサ

世代間で飛躍的に向上したパフォーマンス

ROCm 7 と ROCm 6 の比較

推論¹

トレーニング²

AMD Instinct™ MI350 シリーズに対応

AMD Instinct™ MI350 シリーズ GPU 搭載

AMD Instinct MI350X プラットフォームとオープン ラック インフラストラクチャのシームレスな統合を強化し、迅速な展開と大規模な AI パフォーマンスの最適化を実現します。

エンタープライズ AI のスケーリング

オープン エコシステムによる分散推論

vLLM-d、DeepEP、SGLang、および GPU ダイレクト アクセスにより、ROCm ソフトウェア プラットフォームは、ラック スケールにおいてバッチ間、ノード間、モデル間で最高のスループットを発揮します。

AI ライフサイクルのための ROCm

ROCm ソフトウェアはエンタープライズ AI フレームワークと統合され、本番環境向け AI のための完全オープンソースによるエンドツーエンドのワークフローを提供します。このワークフローには ROCm Enterprise AI と ROCm クラスター管理が含まれており、シームレスな展開とスケーラビリティを実現します。

エンドポイントでの AI

AMD Ryzen™ AI プロセッサと AMD Radeon™ グラフィックスにまたがる ROCm エコシステムの拡大

ROCm エンドポイント AI エコシステムは、効率的なオープンソースの TheROCK 構築プラットフォームを基盤としており、ROCm と PyTorch の毎晩のリリースを特徴としています。このシステムは現在 Linux と Windows の両方をサポートしており、最新の Radeon RX 9000 シリーズと業界をリードする Ryzen AI Max 製品に対応し、シームレスな AI 開発と運用のための堅牢な基盤を提供します。

PyTorch のプレビュー版が次で利用可能になりました。AMD Ryzen™ AI 300 シリーズ* および Ryzen AI Max シリーズの Linux サポート。AMD Ryzen AI 300 シリーズ*、Ryzen AI Max シリーズ、およびすべての AMD Radeon™ RX 7000 および Radeon W7000 シリーズ (および以降) の Windows サポート。

*サポートされている製品の一覧については、互換性一覧ページをご参照ください。

今すぐ設計をはじめよう

AMD 開発者向けクラウドを使用して、AI/ML、ハイパフォーマンス コンピューティング、データ分析タスクを加速できます。

最新情報を入手

ROCm 関連ニュースで最新情報をお届けします。

脚注

- MI300-080 - 2025 年 5 月 15 日に AMD パフォーマンス ラボでテストを実施しました。このテストでは、バッチ サイズが 1 ~ 256 でシーケンス長が 128 ~ 204 の Llama 3.1-70B (TP2)、Qwen 72B (TP2)、Deepseek-R1 (FP16) モデルを実行する (8) AMD Instinct MI300X GPU を搭載したシステム上で、AMD ROCm 6.x ソフトウェア (vLLM 0.3.3) と、AMD ROCm 7.0 プレビュー版 SW (vLLM 0.8.5) の推論性能をトークン数/秒 (TPS) で測定しました。記載されている性能向上は、テストした (3) LLM の平均 TPS です。

ハードウェア構成AMD Instinct™ MI300X (192 GB、750 W) GPU 8 基搭載の 1P AMD EPYC™ 9534 CPU サーバー、Supermicro AS-8125GS-TNMR2、NPS1 (1 ソケットあたり 1 NUMA)、1.5 TiB (24 DIMM、4800 mts メモリ、64 GiB/DIMM)、4x 3.49 TB Micron 7450 ストレージ。BIOS バージョン: 1.8

ソフトウェア構成

Ubuntu 22.04 LTS + Linux kernel 5.15.0-119-generic

Qwen 72B および Llama 3.1-70B -

ROCm 7.0 プレビュー版 SW

PyTorch 2.7.0。Deepseek R-1 - ROCm 7.0 プレビュー版、SGLang 0.4.6、PyTorch 2.6.0。

比較対象は、

Qwen 72 および Llama 3.1-70B - ROCm 6.x GA SW

PyTorch 2.7.0 および 2.1.1

Deepseek R-1: ROCm 6.x GA SW

SGLang 0.4.1、PyTorch 2.5.0。

サーバー メーカーの構成によって、異なる結果が生じる場合があります。構成、ソフトウェア、vLLM のバージョン、最新ドライバーの使用、最適化の状態により、パフォーマンスが異なる可能性があります。

- MI300-081 - 2025 年 5 月 15 日に AMD パフォーマンス ラボでテストを実施しました。このテストでは、Llama 2-70B (4K)、Qwen1.5-14B、Llama3.1-8B モデルとカスタム Docker コンテナーを実行する (8) AMD Instinct MI300X GPU 上で ROCm 7.0 プレビュー版ソフトウェア、Megatron-LM を実行したときと、同様の構成システムで AMD ROCm 6.0 ソフトウェアを実行したときのトレーニング パフォーマンス (TFLOPS) を測定しました。

ハードウェア構成

1P AMD EPYC™ 9454 CPU、8x AMD Instinct MI300X (192 GB、750 W) GPU、American Megatrends International LLC。BIOS バージョン: 1.8、BIOS 1.8。

ソフトウェア構成

Ubuntu 22.04 LTS + Linux kernel 5.15.0-70-generic

ROCm 7.0、Megatron-LM、PyTorch 2.7.0。

比較対象は、

ROCm 6.0 公開リリース SW、Megatron-LM コード ブランチ hanl/disable_te_llama2 (Llama 2-7B)、guihong_dev (LLama 2-70B)、renwuli/disable_te_qwen1.5 (Qwen1.5-14B)、PyTorch 2.2。

サーバー メーカーの構成によって、異なる結果が生じる場合があります。構成、ソフトウェア、vLLM のバージョン、最新ドライバーの使用、最適化の状態により、パフォーマンスが異なる可能性があります。

- MI300-080 - 2025 年 5 月 15 日に AMD パフォーマンス ラボでテストを実施しました。このテストでは、バッチ サイズが 1 ~ 256 でシーケンス長が 128 ~ 204 の Llama 3.1-70B (TP2)、Qwen 72B (TP2)、Deepseek-R1 (FP16) モデルを実行する (8) AMD Instinct MI300X GPU を搭載したシステム上で、AMD ROCm 6.x ソフトウェア (vLLM 0.3.3) と、AMD ROCm 7.0 プレビュー版 SW (vLLM 0.8.5) の推論性能をトークン数/秒 (TPS) で測定しました。記載されている性能向上は、テストした (3) LLM の平均 TPS です。

ハードウェア構成AMD Instinct™ MI300X (192 GB、750 W) GPU 8 基搭載の 1P AMD EPYC™ 9534 CPU サーバー、Supermicro AS-8125GS-TNMR2、NPS1 (1 ソケットあたり 1 NUMA)、1.5 TiB (24 DIMM、4800 mts メモリ、64 GiB/DIMM)、4x 3.49 TB Micron 7450 ストレージ。BIOS バージョン: 1.8

ソフトウェア構成

Ubuntu 22.04 LTS + Linux kernel 5.15.0-119-generic

Qwen 72B および Llama 3.1-70B -

ROCm 7.0 プレビュー版 SW

PyTorch 2.7.0。Deepseek R-1 - ROCm 7.0 プレビュー版、SGLang 0.4.6、PyTorch 2.6.0。

比較対象は、

Qwen 72 および Llama 3.1-70B - ROCm 6.x GA SW

PyTorch 2.7.0 および 2.1.1

Deepseek R-1: ROCm 6.x GA SW

SGLang 0.4.1、PyTorch 2.5.0。

サーバー メーカーの構成によって、異なる結果が生じる場合があります。構成、ソフトウェア、vLLM のバージョン、最新ドライバーの使用、最適化の状態により、パフォーマンスが異なる可能性があります。

- MI300-081 - 2025 年 5 月 15 日に AMD パフォーマンス ラボでテストを実施しました。このテストでは、Llama 2-70B (4K)、Qwen1.5-14B、Llama3.1-8B モデルとカスタム Docker コンテナーを実行する (8) AMD Instinct MI300X GPU 上で ROCm 7.0 プレビュー版ソフトウェア、Megatron-LM を実行したときと、同様の構成システムで AMD ROCm 6.0 ソフトウェアを実行したときのトレーニング パフォーマンス (TFLOPS) を測定しました。

ハードウェア構成

1P AMD EPYC™ 9454 CPU、8x AMD Instinct MI300X (192 GB、750 W) GPU、American Megatrends International LLC。BIOS バージョン: 1.8、BIOS 1.8。

ソフトウェア構成

Ubuntu 22.04 LTS + Linux kernel 5.15.0-70-generic

ROCm 7.0、Megatron-LM、PyTorch 2.7.0。

比較対象は、

ROCm 6.0 公開リリース SW、Megatron-LM コード ブランチ hanl/disable_te_llama2 (Llama 2-7B)、guihong_dev (LLama 2-70B)、renwuli/disable_te_qwen1.5 (Qwen1.5-14B)、PyTorch 2.2。

サーバー メーカーの構成によって、異なる結果が生じる場合があります。構成、ソフトウェア、vLLM のバージョン、最新ドライバーの使用、最適化の状態により、パフォーマンスが異なる可能性があります。