最先端の AI および HPC アクセラレーション

AMD Instinct™ MI350 シリーズ GPU は、データセンターにおける生成 AI および高性能コンピューティング (HPC) の分野で、新たな基準を打ち立てています。最新の第 4 世代 AMD CDNA™ アーキテクチャに基づいて構築されているこれらの GPU は、大規模な AI モデルのトレーニングや高速推論のほか、科学シミュレーション、データ処理、計算モデリングといった複雑な HPC ワークロードに対して、優れた効率性と卓越したパフォーマンスを提供します。

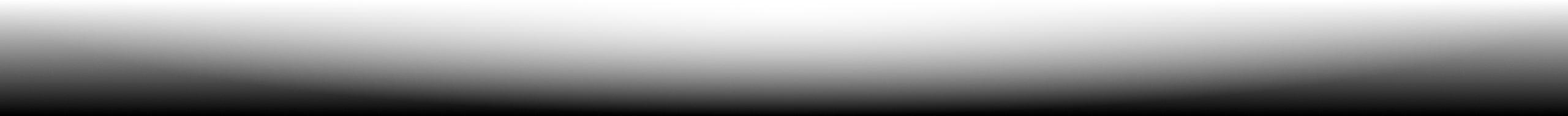

内部のテクノロジ

究極の AI および HPC パフォーマンス

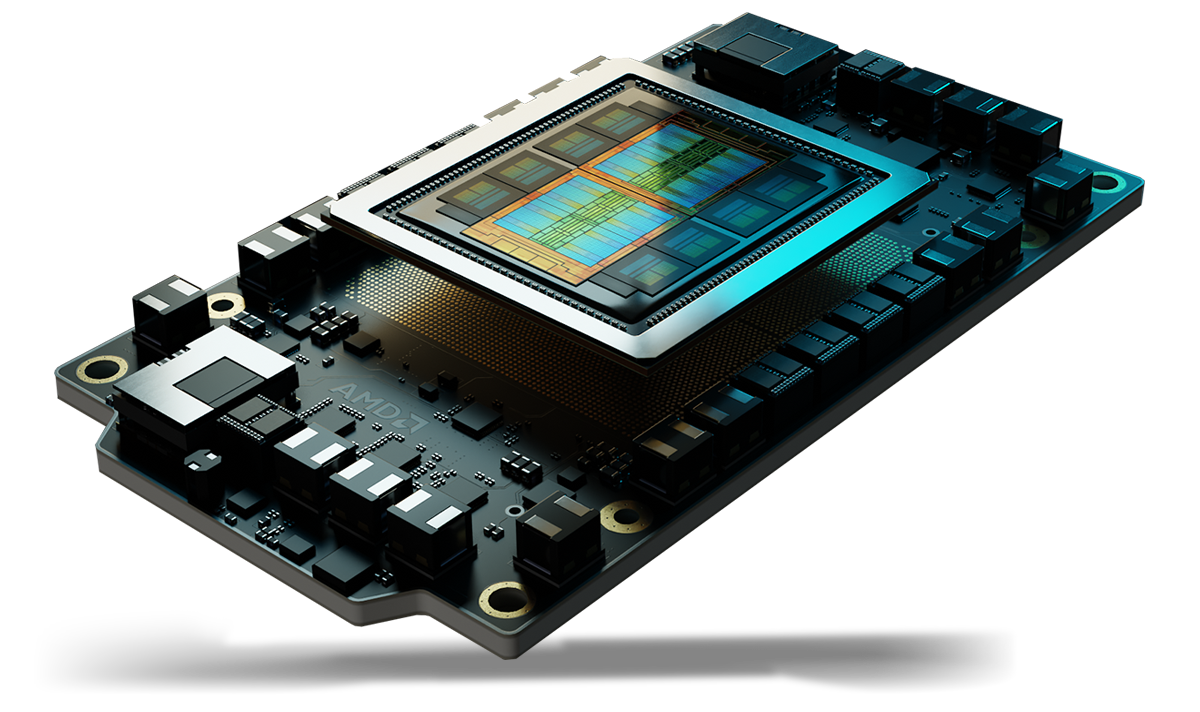

最先端の第 4 世代 AMD CDNA™ アーキテクチャをベースに構築された AMD Instinct™ MI350 シリーズ GPU は、強力で電力効率に優れたコアを搭載しており、ワット パフォーマンスを最大限に高め、AI および HPC イノベーションの次の時代を推進します。

利点

- 大容量メモリによる画期的な AI アクセラレーション

- AI & HPC 向けの高度なセキュリティ

- シームレスな導入と AI の最適化

- AI リーダーからの支持

大容量メモリによる画期的な AI アクセラレーション

AMD Instinct™ MI350 シリーズ GPU は、次世代の MXFP6 および MXFP4 データ型のサポートによって AI アクセラレーションを再定義し、効率性、帯域幅、エネルギー使用を最適化して、AI の推論とトレーニングを高速化します。

最も要求の厳しい AI モデルのパフォーマンスを向上させるように設計された Instinct MI350 GPU は、288 GB の大容量 HBM3E メモリと 8 TB/秒の帯域幅を備えており、前世代を大幅に上回るパフォーマンスを発揮します。1

AI & HPC 向けの高度なセキュリティ

AMD Instinct™ MI350 シリーズ GPU は、信頼性の高いファームウェアの確保、ハードウェアの整合性の検証、セキュアなマルチテナント GPU 共有の実現、GPU 通信の暗号化を支援し、クラウド AI およびミッションクリティカルなワークロードの信頼性、拡張性、データ セキュリティの強化を支援します。

シームレスな導入と AI の最適化

AMD Instinct™ MI350 シリーズ GPU は、ドロップイン互換性によりスムーズな導入を可能にし、AMD GPU Operator が Kubernetes での導入とワークロードの設定を簡素化します。オープンな AMD ROCm™ ソフトウェア スタックを搭載しているため、開発者は OpenAI、Meta、PyTorch、Hugging Face などの主要な AI フレームワークやモデルのゼロデイ サポートを受けることができ、ベンダー ロックインのない効率的で高性能な実行を確保できます。

AI リーダーからの支持

Llama 405B や GPT などの大規模な高性能 AI モデルに対応可能な AMD Instinct™ GPU は、業界のリーダーやイノベーターからの信頼を得ています。クラウド サービス プロバイダーと OEM による広範な AMD Instinct GPU の採用は、次世代 AI の大規模な推進に貢献しています。

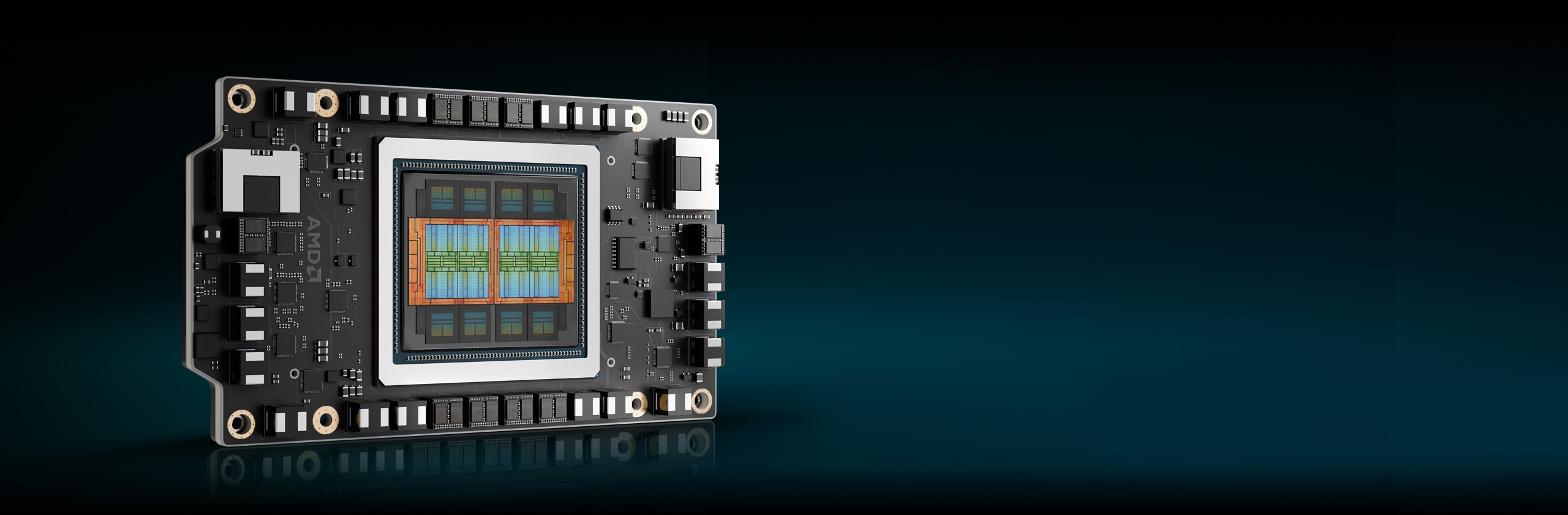

シリーズの紹介

AMD Instinct MI350 シリーズ GPU と AMD Instinct MI350 シリーズ プラットフォームをご紹介します。

AMD Instinct™ MI350 シリーズ GPU のご紹介

AMD Instinct™ MI350 シリーズ GPU は、第 4 世代 AMD CDNA™ アーキテクチャをベースに構築されており、288 GB の大容量 HBM3E メモリ、8 TB/秒の帯域幅、および MXFP6、MXFP4 などのデータ型の拡張サポートにより、優れた AI 推論、トレーニング、および HPC ワークロード性能を実現します。

256 CU

256 個の GPU 演算ユニット

288 GB

288 GB HBM3E メモリ

8 TB/秒

8 TB/秒のピーク理論メモリ帯域幅

仕様比較

- AI パフォーマンス

- HPC 性能

- メモリ

AI パフォーマンス (ピーク PFLOPs)

競合アクセラレータと比較して最大 2.2 倍の AI パフォーマンス2

FP16/BF16 Tensor / FP16/BF16 Matrix

(スパース性対応)

FP8 Tensor / OCP-FP8 Matrix

(スパース性対応)

FP6 Tensor / MXFP6 Matrix

B200 SXM5 180 GB

MI355X OAM 288 GB

HPC 性能 (ピーク TFLOPs)

競合アクセラレータと比較して最大 2.1 倍の HPC パフォーマンス3

B200 SXM5 180 GB

MI355X OAM 288 GB

メモリの容量と帯域幅

競合アクセラレータと比較して 1.6 倍のメモリ容量1

B200 SXM5 180 GB

MI355X OAM 288 GB

AMD Instinct プラットフォーム

AMD Instinct MI350 シリーズ プラットフォームは、完全に接続された 8 個の MI355X または MI350X GPU OAM モジュールを、第 4 世代 AMD Infinity Fabric™ テクノロジを介して業界標準の OCP 設計に統合しています。また、業界最先端の最大 2.3 TB の HBM3E メモリ容量を備えており、AI 処理のスループットを向上させています。これらのすぐに導入可能なプラットフォームは、標準の空冷式 UBB ベースのサーバーから超高密度の Direct Liquid Cooled (DLC) プラットフォームまで、さまざまなシステムをサポートするようになりました。これにより、AMD Instinct MI350 シリーズ GPU を既存の AI ラックおよびサーバー インフラストラクチャに追加する際に、市場投入までの時間を短縮し、開発コストを削減できます。

8 基の MI350 シリーズ GPU

8 つの MI355X または MI350X GPU OAM モジュール

2.3 TB

合計 2.3 TB HBM3E メモリ

64 TB/秒

ピーク理論集約メモリ帯域幅 64 TB/秒

AMD ROCm™ ソフトウェア

AMD ROCm™ ソフトウェアには、AMD Instinct GPU をターゲットとする、AI モデルおよび HPC ワークロード向けのプログラミング モデル、ツール、コンパイラ、ライブラリ、ランタイムの幅広いセットが含まれています。

ケース スタディ

ソリューションの検索

クラウドで AMD Instinct GPU を活用

主要なクラウド サービス プロバイダーがサポートするプログラムで、AI、HPC、ソフトウェア開発のニーズをサポートします。

AMD Instinct GPU パートナーおよびサーバー ソリューション

AMD は、大手 OEM やプラットフォーム設計者と協力して、AMD Instinct GPU 搭載ソリューションの堅牢なエコシステムを提供しています。

リソース

最新情報を入手

サインアップして、最新のデータセンター ニュースとサーバー コンテンツを受信します。

脚注

- 計算は、2025 年 5 月 22 日時点での仕様および/または推定に基づいて AMD パフォーマンス ラボにより実行されたものです。AMD Instinct™ MI355X OAM アクセラレータは、288 GB の HBM3e メモリ容量と 8 TB/秒の GPU ピーク理論メモリ帯域幅パフォーマンスを備えています。NVidia Hopper H200 (141 GB) SXM GPU アクセラレータの公開結果の最高値は、HBM3e メモリ容量が 141 GB、GPU メモリ帯域幅パフォーマンスが 4.8 TB/秒となっています。https://nvdam.widen.net/s/nb5zzzsjdf/hpc-datasheet-sc23-h200-datasheet-3002446 NVidia Blackwell HGX B200 (180 GB) GPU アクセラレータの公開結果の最高値は、HBM3e メモリ容量が 180 GB、GPU メモリ帯域幅パフォーマンスが 7.7 TB/秒となっています。https://nvdam.widen.net/s/wwnsxrhm2w/blackwell-datasheet-3384703 NVidia Grace Blackwell GB200 (186 GB) GPU アクセラレータの公開結果の最高値は、HBM3e メモリ容量が 186 GB、GPU メモリ帯域幅パフォーマンス 8 TB/秒となっています。https://nvdam.widen.net/s/wwnsxrhm2w/blackwell-datasheet-3384703 MI350-001

- 2025 年 5 月に AMD パフォーマンス ラボが実施した計算に基づき、AMD Instinct™ MI350X/MI355X GPU のピーク時における理論上の精度性能を判定。性能の測定にあたって、Vector、Matrix、または Tensor with Sparsity の演算を用い (適用可能な場合)、FP64、FP32、FP16、OCP-FP8、FP8、MXFP6、FP6、MXFP4、FP4、INT8、および bfloat16 データ型を比較。同じ条件で NVIDIA Blackwell B200 アクセラレータと比較しました。サーバー メーカーの構成によって、異なる結果が生じる場合があります。MI350-009A

- 2025 年 5 月に AMD パフォーマンス ラボが実施した計算に基づき、AMD Instinct™ MI350X/MI355X GPU のピーク時における理論上の精度性能を判定。性能の測定にあたって、Vector、Matrix、または Tensor の演算を用い (適用可能な場合)、FP64 と FP32 を比較。同じ条件で NVIDIA Blackwell B200 アクセラレータと比較しました。実際の結果は、サーバーの構成、データ型、ワークロードによって異なります。最新ドライバーと最適化の有無によって、パフォーマンスが異なる可能性があります。MI350-019

- 2025 年 4 月 17 日時点の AMD による計算に基づいています。この計算では、AMD Instinct MI350X/MI355X GPU (288 GB)、MI300X (192 GB)、および MI325X (256 GB) の公開メモリ仕様を使用しています。 次の LLM を実行するために必要な GPU の最小数 (メモリ サイズに基づく) を決定するために、FP16 精度データ型 (パラメーターあたり 2 バイト) で計算が実行されました。OPT (130B パラメーター)、GPT-3 (175B パラメーター)、BLOOM (176B パラメーター)、Gopher (280B パラメーター)、PaLM 1 (340B パラメーター)、Generic LM (420B、500B、520B、1.047T パラメーター)、Megatron-LM (530B パラメーター)、LLaMA (405B パラメーター)、および Samba (1T パラメーター)。結果は、GPU のメモリ サイズと、定義されたパラメーターでモデルに必要とされるメモリ (10% のオーバーヘッドを加算) を比較した値に基づいています。サーバー メーカーの構成によって、異なる結果が生じる場合があります。結果は、GPU メモリ構成、LLM サイズ、および GPU メモリ アクセスまたはサーバー動作環境の潜在的な差異によって異なる場合があります。*FP16 データ型に基づくすべてのデータ。FP8 では 2 倍。 FP4 では 4 倍。MI350-012

- 2025 年 5 月に AMD パフォーマンス ラボで、8 基の AMD Instinct™ MI350X/MI355X GPU を搭載したプラットフォームにおける、FP64、FP32、FP16、OCP-FP8、FP8、MXFP6、FP6、MXFP4、FP4、INT8 の各データ型の理論上のピーク精度性能 (必要に応じて Matrix、Tensor、Vector、および Sparsity の演算を適用) を算出し、NVIDIA HGX Blackwell B200 アクセラレータ プラットフォームと比較しました。実際の結果は、構成、データ型、ワークロードによって異なります。MI350-010A

- 計算は、2025 年 5 月 22 日時点での仕様および/または推定に基づいて AMD パフォーマンス ラボにより実行されたものです。AMD Instinct™ MI355X OAM アクセラレータは、288 GB の HBM3e メモリ容量と 8 TB/秒の GPU ピーク理論メモリ帯域幅パフォーマンスを備えています。NVidia Hopper H200 (141 GB) SXM GPU アクセラレータの公開結果の最高値は、HBM3e メモリ容量が 141 GB、GPU メモリ帯域幅パフォーマンスが 4.8 TB/秒となっています。https://nvdam.widen.net/s/nb5zzzsjdf/hpc-datasheet-sc23-h200-datasheet-3002446 NVidia Blackwell HGX B200 (180 GB) GPU アクセラレータの公開結果の最高値は、HBM3e メモリ容量が 180 GB、GPU メモリ帯域幅パフォーマンスが 7.7 TB/秒となっています。https://nvdam.widen.net/s/wwnsxrhm2w/blackwell-datasheet-3384703 NVidia Grace Blackwell GB200 (186 GB) GPU アクセラレータの公開結果の最高値は、HBM3e メモリ容量が 186 GB、GPU メモリ帯域幅パフォーマンス 8 TB/秒となっています。https://nvdam.widen.net/s/wwnsxrhm2w/blackwell-datasheet-3384703 MI350-001

- 2025 年 5 月に AMD パフォーマンス ラボが実施した計算に基づき、AMD Instinct™ MI350X/MI355X GPU のピーク時における理論上の精度性能を判定。性能の測定にあたって、Vector、Matrix、または Tensor with Sparsity の演算を用い (適用可能な場合)、FP64、FP32、FP16、OCP-FP8、FP8、MXFP6、FP6、MXFP4、FP4、INT8、および bfloat16 データ型を比較。同じ条件で NVIDIA Blackwell B200 アクセラレータと比較しました。サーバー メーカーの構成によって、異なる結果が生じる場合があります。MI350-009A

- 2025 年 5 月に AMD パフォーマンス ラボが実施した計算に基づき、AMD Instinct™ MI350X/MI355X GPU のピーク時における理論上の精度性能を判定。性能の測定にあたって、Vector、Matrix、または Tensor の演算を用い (適用可能な場合)、FP64 と FP32 を比較。同じ条件で NVIDIA Blackwell B200 アクセラレータと比較しました。実際の結果は、サーバーの構成、データ型、ワークロードによって異なります。最新ドライバーと最適化の有無によって、パフォーマンスが異なる可能性があります。MI350-019

- 2025 年 4 月 17 日時点の AMD による計算に基づいています。この計算では、AMD Instinct MI350X/MI355X GPU (288 GB)、MI300X (192 GB)、および MI325X (256 GB) の公開メモリ仕様を使用しています。 次の LLM を実行するために必要な GPU の最小数 (メモリ サイズに基づく) を決定するために、FP16 精度データ型 (パラメーターあたり 2 バイト) で計算が実行されました。OPT (130B パラメーター)、GPT-3 (175B パラメーター)、BLOOM (176B パラメーター)、Gopher (280B パラメーター)、PaLM 1 (340B パラメーター)、Generic LM (420B、500B、520B、1.047T パラメーター)、Megatron-LM (530B パラメーター)、LLaMA (405B パラメーター)、および Samba (1T パラメーター)。結果は、GPU のメモリ サイズと、定義されたパラメーターでモデルに必要とされるメモリ (10% のオーバーヘッドを加算) を比較した値に基づいています。サーバー メーカーの構成によって、異なる結果が生じる場合があります。結果は、GPU メモリ構成、LLM サイズ、および GPU メモリ アクセスまたはサーバー動作環境の潜在的な差異によって異なる場合があります。*FP16 データ型に基づくすべてのデータ。FP8 では 2 倍。 FP4 では 4 倍。MI350-012

- 2025 年 5 月に AMD パフォーマンス ラボで、8 基の AMD Instinct™ MI350X/MI355X GPU を搭載したプラットフォームにおける、FP64、FP32、FP16、OCP-FP8、FP8、MXFP6、FP6、MXFP4、FP4、INT8 の各データ型の理論上のピーク精度性能 (必要に応じて Matrix、Tensor、Vector、および Sparsity の演算を適用) を算出し、NVIDIA HGX Blackwell B200 アクセラレータ プラットフォームと比較しました。実際の結果は、構成、データ型、ワークロードによって異なります。MI350-010A