Führende KI- und HPC-Beschleunigung

AMD Instinct™ MI350-Serie GPUs setzen neue Maßstäbe für generative KI und High-Performance Computing (HPC) in Rechenzentren. Diese GPUs basieren auf der neuen, hochmodernen AMD CDNA™ Architektur der 4. Generation und bieten außergewöhnliche Effizienz und Performance für das Training sehr großer KI-Modelle, Hochgeschwindigkeitsinferenz und komplexe HPC-Auslastungen wie wissenschaftliche Simulationen, Datenverarbeitung und Computermodellierung.

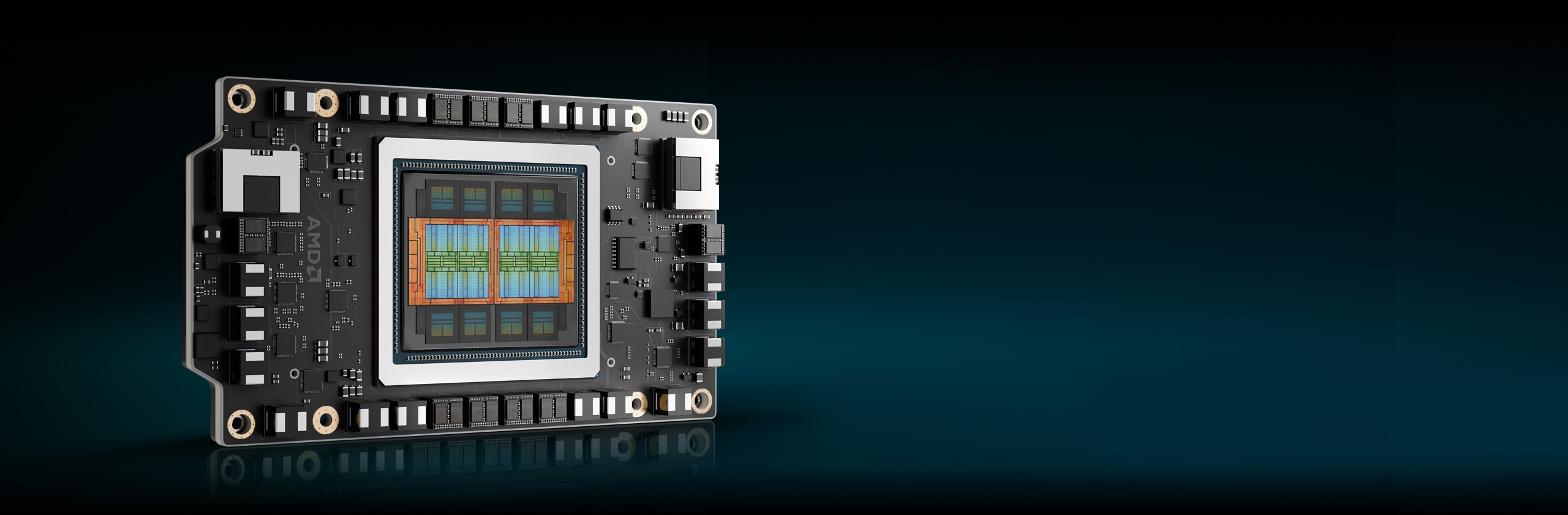

Unter der Haube

Die ultimative KI- und HPC-Performance

Die AMD Instinct™ MI350-Serie GPUs basieren auf der hochmodernen AMD CDNA™ Architektur der 4. Generation und verfügen über leistungsstarke und energieeffiziente Kerne, die die Performance pro Watt maximieren und die nächste Ära der KI- und HPC-Innovation vorantreiben.

Vorteile

- Bahnbrechende KI-Beschleunigung mit großem Speicher

- Erweiterte Sicherheit für KI und HPC

- Nahtlose Bereitstellung und KI-Optimierung

- Führende KI-Unternehmen vertrauen darauf

Bahnbrechende KI-Beschleunigung mit großem Speicher

Die AMD Instinct™ MI350-Serie GPUs definieren die KI-Beschleunigung mit Unterstützung der nächsten Generation von MXFP6- und MXFP4-Datentypen neu und optimieren Effizienz, Bandbreite und Energieverbrauch für blitzschnelle KI-Inferenz und ebenso schnelles Training.

Instinct MI350 GPUs wurden entwickelt, um die Performance der anspruchsvollsten KI-Modelle zu steigern. Sie verfügen über einen riesigen 288 GB HBM3E-Speicher und eine Bandbreite von 8 TB/s und bieten damit einen enormen Performance-Sprung gegenüber vorherigen Generationen.1

Erweiterte Sicherheit für KI und HPC

AMD Instinct™ MI350-Serie GPUs sorgen für zuverlässige Firmware, überprüfen die Hardwareintegrität, ermöglichen eine sichere Multi-Tenant-GPU-Freigabe und verschlüsseln die GPU-Kommunikation. Dies trägt zur Verbesserung der Zuverlässigkeit, Skalierbarkeit und Datensicherheit für Cloud-KI und unternehmenskritische Auslastungen bei.

Nahtlose Bereitstellung und KI-Optimierung

AMD Instinct™ MI350-Serie GPUs ermöglichen eine reibungslose Akzeptanz mit Drop-in-Kompatibilität, während der AMD GPU Operator die Bereitstellung und Auslastungskonfiguration in Kubernetes vereinfacht. Dank des offenen AMD ROCm™ Software-Stacks erhalten Entwickler Day-0-Support für führende KI-Frameworks und Modelle von OpenAI, Meta, PyTorch, Hugging Face und mehr – so wird eine effiziente High-Performance-Ausführung ohne Herstellerbindung gewährleisten.

Führende KI-Unternehmen vertrauen darauf

Branchenführende Unternehmen und Innovatoren vertrauen auf AMD Instinct™ GPUs für große KI, die Modelle wie Llama 405B und GPT unterstützen. Die breite Akzeptanz der AMD Instinct GPU durch Cloud-Service-Anbieter und OEMs trägt dazu bei, KI der nächsten Generation in großem Maßstab voranzutreiben.

Serie kennenlernen

Entdecken Sie AMD Instinct MI350-Serie GPUs und AMD Instinct MI350-Serie Plattformen.

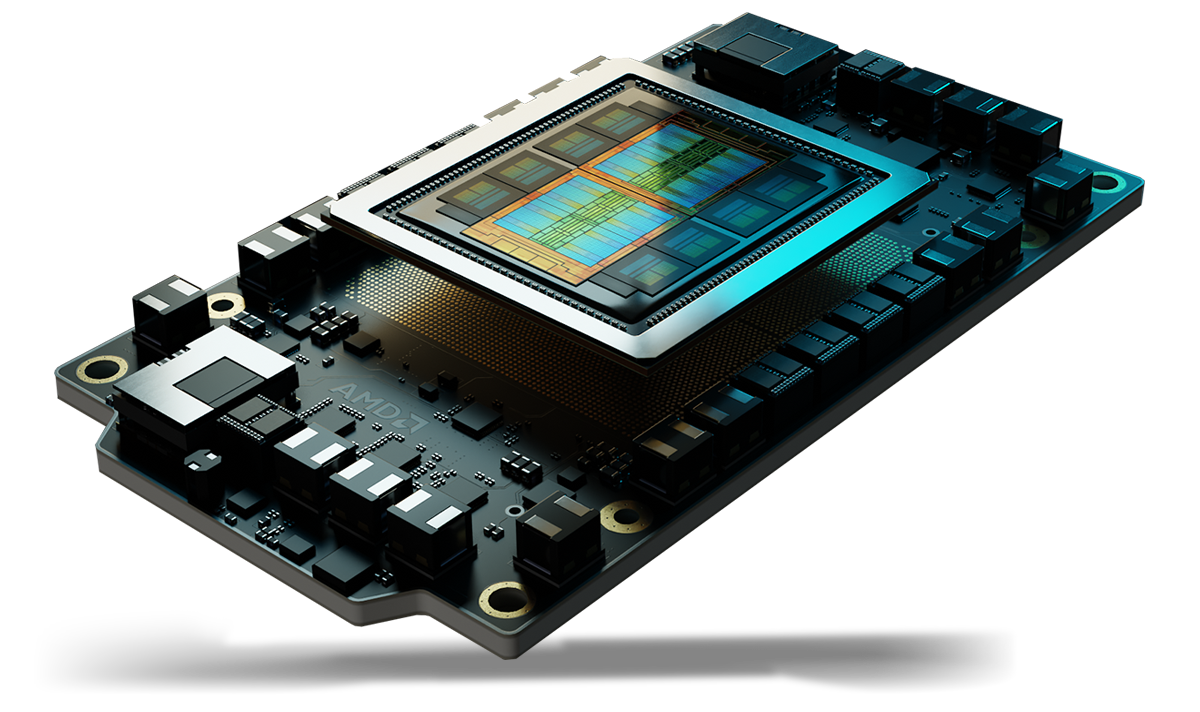

Wir stellen vor: Die AMD Instinct™ MI350-Serie GPUs

Die AMD Instinct™ MI350-Serie GPUs basieren auf der AMD CDNA™ Architektur der 4. Generation und bieten außergewöhnliche KI-Inferenz, Training und HPC-Auslastungs-Performance mit riesigem 288 GB HBM3E-Speicher, 8 TB/s Bandbreite und erweiterter Unterstützung von Datentypen wie MXFP6 und MXFP4.

256 CUs

256 GPU Recheneinheiten

288 GB

288 GB HBM3E-Speicher

8 TB/s

8 TB/s theoretische maximale Speicherbandbreite

Vergleiche der Spezifikationen

- KI-Performance

- HPC-Performance

- Speicher

KI-Performance (max. PFLOPs)

Bis zu 2,2-fache KI-Performance im Vergleich zu Beschleunigern der Konkurrenz2

FP16/BF16 Tensor / FP16/BF16 Matrix

(Sparsity)

FP8 Tensor / OCP-FP8 Matrix

(Sparsity)

FP6 Tensor / MXFP6 Matrix

B200 SXM5 180 GB

MI355X OAM 288 GB

HPC-Performance (max. TFLOPs)

Bis zu 2,1-fache HPC-Performance im Vergleich zu Beschleunigern der Konkurrenz3

B200 SXM5 180 GB

MI355X OAM 288 GB

Speicherkapazität und -bandbreite

1,6-fache Speicherkapazität im Vergleich zu Beschleunigern der Konkurrenz1

B200 SXM5 180 GB

MI355X OAM 288 GB

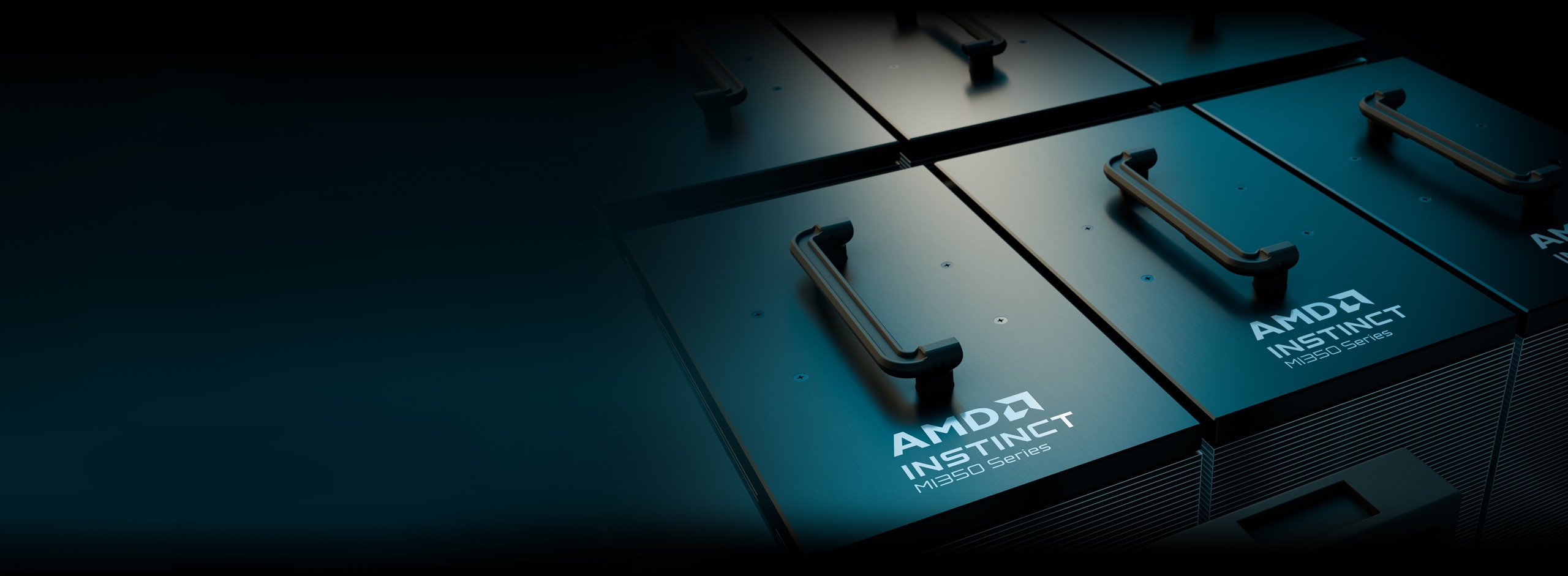

AMD Instinct Plattformen

Die AMD Instinct MI350-Serie Plattformen integrieren 8 vollständig verbundene MI355X oder MI350X GPU OAM-Module in ein OCP-Design nach Branchenstandard über AMD Infinity Fabric™ Technologie der 4. Generation mit einer branchenführenden Speicherkapazität von 2,3 TB HBM3E für KI-Verarbeitung mit hohem Durchsatz. Diese sofort einsatzbereiten Plattformen bieten jetzt Unterstützung für eine Vielzahl von Systemen, von luftgekühlten UBB-basierten Standardservern bis hin zu ultradichten DLC-Plattformen (Direct Liquid Cooled). Dies trägt dazu bei, die Markteinführungszeit zu beschleunigen und Entwicklungskosten zu senken, wenn AMD Instinct MI350-Serie GPUs in bestehende KI-Rack- und Serverinfrastrukturen integriert werden.

8 MI350-Serie GPUs

Acht (8) MI355X oder MI350X GPU OAM-Module

2,3 TB

2,3 TB HBM3E-Speicher gesamt

64 TB/s

64 TB/s theoretische maximale Speicherbandbreite (aggregiert)

AMD ROCm™ Software

AMD ROCm™ Software beinhaltet ein breites Spektrum an Programmierungsmodellen, Tools, Compilern, Bibliotheken und Laufzeiten für KI-Modelle und HPC-Auslastungen, die auf AMD Instinct GPUs ausgerichtet sind.

Fallstudien

Lösungen finden

AMD Instinct GPUs in der Cloud erleben

Unterstützen Sie Ihre KI-, HPC- und Softwareentwicklungsanforderungen mit Programmen, die von führenden Cloud-Service-Anbietern unterstützt werden.

AMD Instinct GPU Partner- und Serverlösungen

AMD arbeitet mit führenden Erstausrüstern (OEMs) und Plattformentwicklern zusammen, um ein robustes Ökosystem von auf AMD Instinct GPUs basierenden Lösungen anzubieten.

Ressourcen

Immer informiert bleiben

Melden Sie sich an und erhalten Sie alle Neuigkeiten über Rechenzentren und Server.

Fußnoten

- Berechnungen durchgeführt vom AMD Leistungslabor am 22. Mai 2025 basierend auf aktuellen Spezifikationen und/oder Schätzungen. Die AMD Instinct™ MI355X OAM Beschleuniger haben eine Speicherkapazität von 288 GB HBM3E und eine maximale theoretische GPU-Speicherbandbreite von 8 TB/s. Die höchsten veröffentlichten Ergebnisse auf dem NVIDIA Hopper H200 (141 GB) SXM GPU-Beschleuniger führten zu einer HBM3e-Speicherkapazität von 141 GB und einer GPU-Speicherbandbreite von 4,8 TB/s. https://nvdam.widen.net/s/nb5zzzsjdf/hpc-datasheet-sc23-h200-datasheet-3002446 Die höchsten veröffentlichten Ergebnisse auf dem NVIDIA Blackwell HGX B200 (180 GB) GPU-Beschleuniger führten zu einer HBM3e-Speicherkapazität von 180 GB und einer GPU-Speicherbandbreite von 7,7 TB/s. https://nvdam.widen.net/s/wwnsxrhm2w/blackwell-datasheet-3384703 Die höchsten veröffentlichten Ergebnisse auf dem NVIDIA Grace Blackwell GPU-Beschleuniger führten zu einer HBM3e-Speicherkapazität von 186 GB und einer GPU-Speicherbandbreite von 8 TB/s. https://nvdam.widen.net/s/wwnsxrhm2w/blackwell-datasheet-3384703 MI350-001

- Basierend auf Berechnungen des AMD Leistungslabors im Mai 2025 zur Ermittlung der theoretischen Spitzenpräzisions-Performance für AMD Instinct™ MI350X/MI355X GPUs beim Vergleich der Datentypen FP64, FP32, FP16, OCP-FP8, FP8, MXFP6, FP6, MXFP4, FP4, INT8 und bfloat16 mit Vektor, Matrix oder Tensor mit Sparsity, wie jeweils zutreffend, mit dem NVIDIA Blackwell B200 Beschleuniger. Serverhersteller wählen möglicherweise andere Konfigurationen, was zu anderen Ergebnissen führen kann. MI350-009A.

- Basierend auf Berechnungen des AMD Leistungslabors im Mai 2025 zur Ermittlung der theoretischen Spitzenpräzisions-Performance für AMD Instinct™ MI350X/MI355X GPUs beim Vergleich von FP64 und FP32 mit Vector, Matrix oder Tensor, wie jeweils zutreffend, mit dem NVIDIA Blackwell B200 Beschleuniger. Ergebnisse können je nach Serverkonfiguration, Datentyp und Auslastung variieren. Die Performance kann aufgrund neuester Treiber und Optimierungen variieren. MI350-019.

- Basierend auf Berechnungen von AMD vom 17. April 2025 auf den veröffentlichten Speicherspezifikationen der AMD Instinct MI350X/MI355X GPUs (288 GB) im Vergleich zu MI300X (192 GB) im Vergleich zu MI325X (256 GB). Berechnungen, die mit dem Datentyp FP16-Genauigkeit bei (2) Byte pro Parameter durchgeführt werden, um die Mindestanzahl an GPUs (basierend auf der Speichergröße) zu ermitteln, die für die Ausführung der folgenden LLMs erforderlich sind: OPT (130 Mrd. Parameter), GPT-3 (175B Mrd. Parameter), BLOOM (176 Mrd. Parameter), Gopher (280 Mrd. Parameter), PaLM 1 (340 Mrd. Parameter), Generic LM (420 Mrd., 500 Mrd., 520 Mrd., 1,047 Bio. Parameter), Megatron-LM (530 Mrd. Parameter), LLaMA (405 Mrd. Parameter) und Samba (1 Bio. Parameter). Ergebnisse basieren auf der Größe des GPU-Speichers im Vergleich zum Speicherbedarf des Modells bei definierten Parametern plus 10 % Overhead. Serverhersteller wählen möglicherweise andere Konfigurationen, was zu anderen Ergebnissen führen kann. Die Ergebnisse können je nach GPU-Speicherkonfiguration, LLM-Größe und potenzieller Abweichung beim GPU-Speicherzugriff oder der Serverbetriebsumgebung variieren. * Alle Daten basieren auf dem FP16-Datentyp. Für FP8 = X2. Für FP4 = X4. MI350-012.

- Basierend auf Berechnungen durch das AMD Leistungslabor im Mai 2025 für die AMD Instinct™ MI350X/MI355X Plattformen mit 8 GPUs zur Ermittlung der theoretischen Spitzenpräzision-Performance beim Vergleich der Datentypen FP64, FP32, FP16, OCP-FP8, FP8, MXFP6, FP6, MXFP4, FP4 und INT8 mit Matrix, Tensor, Vektor und Sparsity, wie jeweils zutreffend, mit der NVIDIA HGX Blackwell B200 Beschleunigerplattform. Ergebnisse können je nach Konfiguration, Datentyp und Auslastung variieren. MI350-010A.

- Berechnungen durchgeführt vom AMD Leistungslabor am 22. Mai 2025 basierend auf aktuellen Spezifikationen und/oder Schätzungen. Die AMD Instinct™ MI355X OAM Beschleuniger haben eine Speicherkapazität von 288 GB HBM3E und eine maximale theoretische GPU-Speicherbandbreite von 8 TB/s. Die höchsten veröffentlichten Ergebnisse auf dem NVIDIA Hopper H200 (141 GB) SXM GPU-Beschleuniger führten zu einer HBM3e-Speicherkapazität von 141 GB und einer GPU-Speicherbandbreite von 4,8 TB/s. https://nvdam.widen.net/s/nb5zzzsjdf/hpc-datasheet-sc23-h200-datasheet-3002446 Die höchsten veröffentlichten Ergebnisse auf dem NVIDIA Blackwell HGX B200 (180 GB) GPU-Beschleuniger führten zu einer HBM3e-Speicherkapazität von 180 GB und einer GPU-Speicherbandbreite von 7,7 TB/s. https://nvdam.widen.net/s/wwnsxrhm2w/blackwell-datasheet-3384703 Die höchsten veröffentlichten Ergebnisse auf dem NVIDIA Grace Blackwell GPU-Beschleuniger führten zu einer HBM3e-Speicherkapazität von 186 GB und einer GPU-Speicherbandbreite von 8 TB/s. https://nvdam.widen.net/s/wwnsxrhm2w/blackwell-datasheet-3384703 MI350-001

- Basierend auf Berechnungen des AMD Leistungslabors im Mai 2025 zur Ermittlung der theoretischen Spitzenpräzisions-Performance für AMD Instinct™ MI350X/MI355X GPUs beim Vergleich der Datentypen FP64, FP32, FP16, OCP-FP8, FP8, MXFP6, FP6, MXFP4, FP4, INT8 und bfloat16 mit Vektor, Matrix oder Tensor mit Sparsity, wie jeweils zutreffend, mit dem NVIDIA Blackwell B200 Beschleuniger. Serverhersteller wählen möglicherweise andere Konfigurationen, was zu anderen Ergebnissen führen kann. MI350-009A.

- Basierend auf Berechnungen des AMD Leistungslabors im Mai 2025 zur Ermittlung der theoretischen Spitzenpräzisions-Performance für AMD Instinct™ MI350X/MI355X GPUs beim Vergleich von FP64 und FP32 mit Vector, Matrix oder Tensor, wie jeweils zutreffend, mit dem NVIDIA Blackwell B200 Beschleuniger. Ergebnisse können je nach Serverkonfiguration, Datentyp und Auslastung variieren. Die Performance kann aufgrund neuester Treiber und Optimierungen variieren. MI350-019.

- Basierend auf Berechnungen von AMD vom 17. April 2025 auf den veröffentlichten Speicherspezifikationen der AMD Instinct MI350X/MI355X GPUs (288 GB) im Vergleich zu MI300X (192 GB) im Vergleich zu MI325X (256 GB). Berechnungen, die mit dem Datentyp FP16-Genauigkeit bei (2) Byte pro Parameter durchgeführt werden, um die Mindestanzahl an GPUs (basierend auf der Speichergröße) zu ermitteln, die für die Ausführung der folgenden LLMs erforderlich sind: OPT (130 Mrd. Parameter), GPT-3 (175B Mrd. Parameter), BLOOM (176 Mrd. Parameter), Gopher (280 Mrd. Parameter), PaLM 1 (340 Mrd. Parameter), Generic LM (420 Mrd., 500 Mrd., 520 Mrd., 1,047 Bio. Parameter), Megatron-LM (530 Mrd. Parameter), LLaMA (405 Mrd. Parameter) und Samba (1 Bio. Parameter). Ergebnisse basieren auf der Größe des GPU-Speichers im Vergleich zum Speicherbedarf des Modells bei definierten Parametern plus 10 % Overhead. Serverhersteller wählen möglicherweise andere Konfigurationen, was zu anderen Ergebnissen führen kann. Die Ergebnisse können je nach GPU-Speicherkonfiguration, LLM-Größe und potenzieller Abweichung beim GPU-Speicherzugriff oder der Serverbetriebsumgebung variieren. * Alle Daten basieren auf dem FP16-Datentyp. Für FP8 = X2. Für FP4 = X4. MI350-012.

- Basierend auf Berechnungen durch das AMD Leistungslabor im Mai 2025 für die AMD Instinct™ MI350X/MI355X Plattformen mit 8 GPUs zur Ermittlung der theoretischen Spitzenpräzision-Performance beim Vergleich der Datentypen FP64, FP32, FP16, OCP-FP8, FP8, MXFP6, FP6, MXFP4, FP4 und INT8 mit Matrix, Tensor, Vektor und Sparsity, wie jeweils zutreffend, mit der NVIDIA HGX Blackwell B200 Beschleunigerplattform. Ergebnisse können je nach Konfiguration, Datentyp und Auslastung variieren. MI350-010A.