Aceleração de IA e computação de alto desempenho com liderança no setor

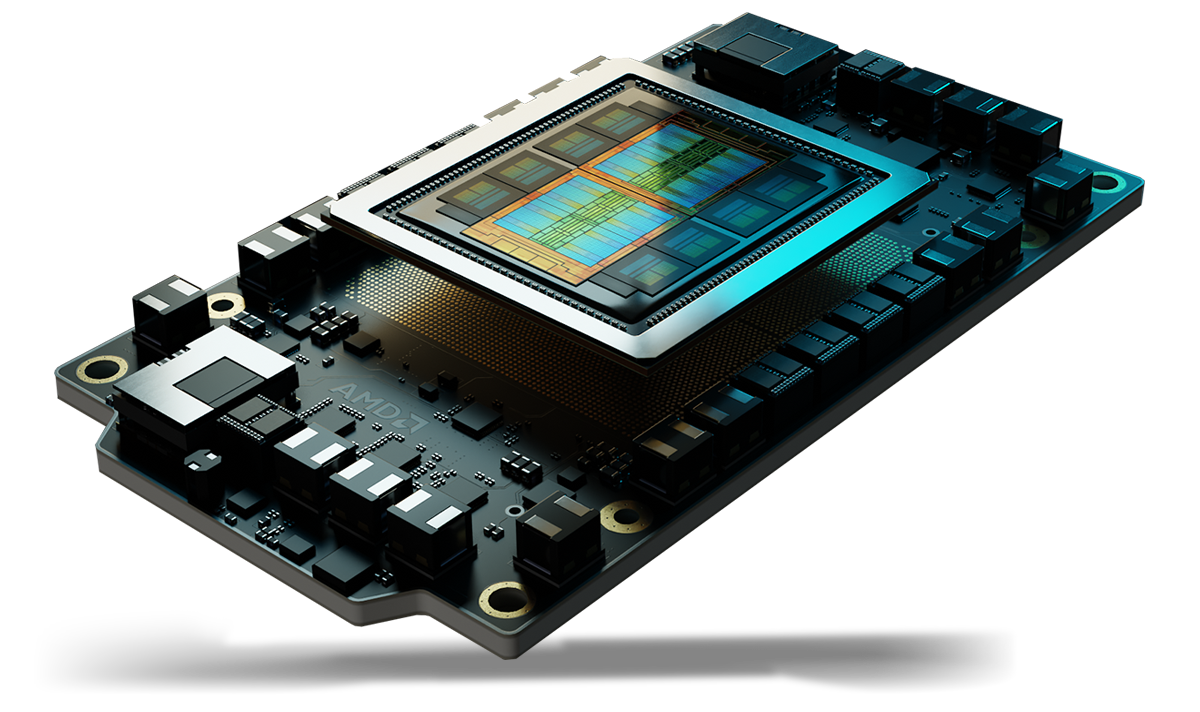

As GPUs AMD Instinct™ Série MI350 estabelecem um novo padrão para IA generativa e computação de alto desempenho (HPC) em data centers. Baseadas na nova arquitetura AMD CDNA™ de 4ª geração com tecnologia de ponta, essas GPUs oferecem eficiência e desempenho excepcionais para o treinamento de modelos de IA de larga escala, inferência em alta velocidade e cargas de trabalho de HPC complexas, como simulações científicas, processamento de dados e modelagem computacional.

Equipamento interno

O desempenho definitivo em IA e HPC

Baseadas na arquitetura com tecnologia de ponta AMD CDNA™ de 4ª geração, as GPUs AMD Instinct™ Série MI350 contam com núcleos potentes e alta eficiência em termos de energia, maximizando o desempenho por watt para impulsionar a próxima era da inovação em IA e computação de alto desempenho.

Benefícios

- Aceleração revolucionária de IA com memória massiva

- Segurança avançada para IA e HPC

- Implantação contínua e otimização de IA

- Confiança de líderes do setor

Aceleração revolucionária de IA com memória massiva

As GPUs AMD Instinct™ Série MI350 redefinem a aceleração de IA com suporte aos novos tipos de dados MXFP6 e MXFP4, otimizando a eficiência, largura de banda e o consumo de energia para inferência e treinamento de IA ultrarrápidos.

Projetadas para impulsionar o desempenho dos modelos de IA mais exigentes, as GPUs Instinct MI350 contam com 288 GB de memória HBM3E e largura de banda de 8 TB/s, oferecendo um grande salto de desempenho em relação às gerações anteriores.1

Segurança avançada para IA e HPC

As GPUs AMD Instinct™ Série MI350 ajudam a garantir firmware confiável, verificar a integridade do hardware, viabilizar o compartilhamento seguro de GPU entre múltiplos locatários e criptografar a comunicação da GPU — aumentando a confiabilidade, a escalabilidade e a segurança dos dados em cargas de trabalho de IA na nuvem e aplicações críticas.

Implantação contínua e otimização de IA

As GPUs AMD Instinct™ Série MI350 ajudam a viabilizar uma adoção sem atritos com compatibilidade imediata ("drop-in"), enquanto o AMD GPU Operator simplifica a implantação e a configuração de cargas de trabalho no Kubernetes. Equipados com pilha de software aberta AMD ROCm™, os desenvolvedores contam com suporte desde o primeiro dia para os principais frameworks e modelos de IA, como OpenAI, Meta, PyTorch, Hugging Face e outros — ajudando a garantir uma execução eficiente e de alto desempenho, sem dependência de fornecedor.

Confiança de líderes do setor

Líderes e inovadores do setor confiam nas GPUs AMD Instinct™ para IA em larga escala, estando presentes modelos como Llama 405B e GPT. A ampla adoção das GPUs AMD Instinct por CSPs e OEMs está impulsionando a próxima geração da IA em grande escala.

Conheça a série

Conheça as GPUs AMD Instinct Série MI350 e as plataformas AMD Instinct Série MI350.

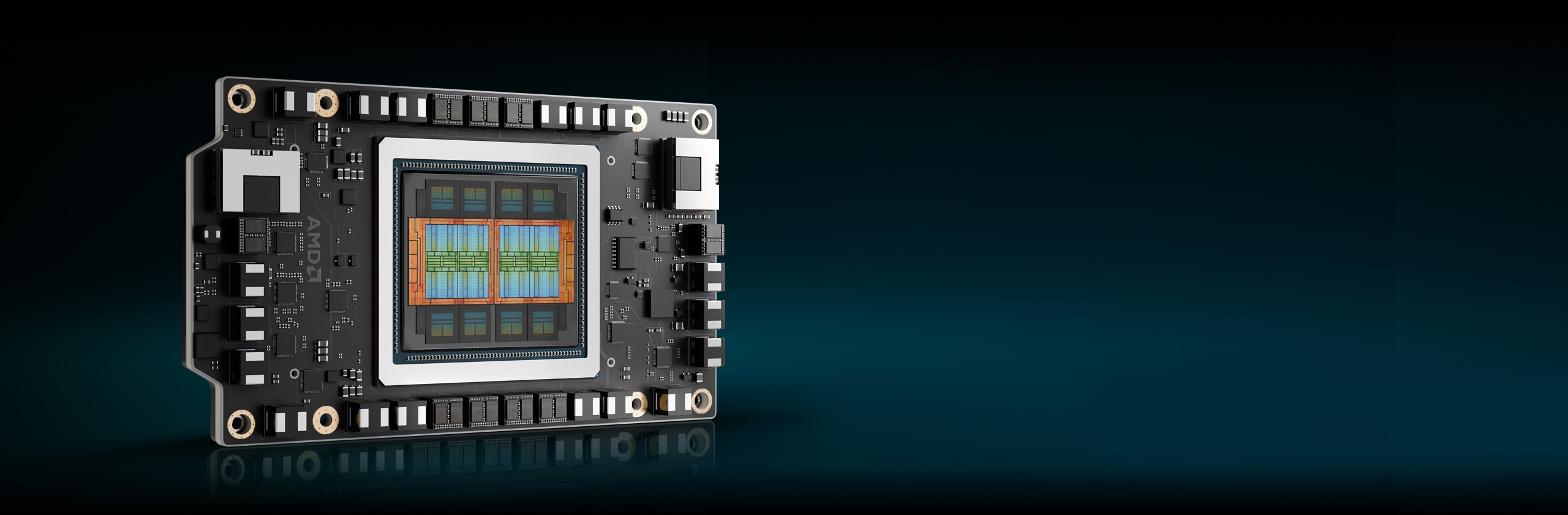

Conheça as GPUs AMD Instinct™ Série MI350

Baseadas na arquitetura AMD CDNA™ de 4ª geração, as GPUs AMD Instinct™ Série MI350 oferecem desempenho excepcional para inferência e treinamento de IA, além de cargas de trabalho de HPC, com memória HBM3E de 288 GB, largura de banda de 8 TB/s e suporte expandido para tipos de dados, incluindo MXFP6 e MXFP4.

256 CUs

256 unidades de computação da GPU

288 GB

288 GB de memória HBM3E

8 TB/s

Largura de banda de memória máxima teórica de 8 TB/s

Comparações de especificações

- Desempenho de IA

- Desempenho de HPC

- Memória

Desempenho em IA (PFLOPs máximos)

Até 2,2 vezes o desempenho em IA em comparação com aceleradores concorrentes2

Tensor FP16/BF16/Matriz FP16/BF16

(Esparsidade)

Tensor FP8/Matriz OCP-FP8

(Esparsidade)

Tensor FP6/Matriz MXFP6

B200 SXM5 180 GB

MI355X OAM 288 GB

Desempenho HPC (TFLOPs de pico)

Até 2,1 vezes o desempenho HPC em comparação com os aceleradores da concorrência3

B200 SXM5 180 GB

MI355X OAM 288 GB

Capacidade de memória e largura de banda

1,6X mais capacidade de memória em comparação com aceleradores concorrentes¹

B200 SXM5 180 GB

MI355X OAM 288 GB

Plataformas AMD Instinct

As plataformas AMD Instinct Série MI350 integram oito módulos de GPU MI355X ou MI350X OAM totalmente conectados em um design de OCP padrão do setor por meio da tecnologia AMD Infinity Fabric™ de 4ª geração, com uma liderança no setor em capacidade de memória HBM3E de 2,3 TB para processamento de IA com alta produtividade. Essas plataformas prontas para implantação agora oferecem suporte a uma variedade de sistemas — desde servidores padrão com resfriamento a ar baseados em UBB até plataformas ultradensas com resfriamento líquido direto (DLC) — ajudando a acelerar o tempo de comercialização e a reduzir os custos de desenvolvimento ao integrar GPUs AMD Instinct Série MI350 em infraestruturas de racks e servidores de IA existentes.

8 GPUs da Série MI350

Oito (8) módulos de GPU OAM MI355X ou MI350X

2,3 TB

2,3 TB de memória total HBM3E

64 TB/s

64 TB/s de largura de banda de memória teórica agregada máxima

Software AMD ROCm™

O software AMD ROCm™ inclui um amplo conjunto de modelos de programação, ferramentas, compiladores, bibliotecas e tempos de execução para modelos de IA e cargas de trabalho de HPC direcionados às GPUs AMD Instinct.

Estudos de caso

Encontre soluções

Experimente GPUs AMD Instinct na nuvem

Ofereça suporte às suas necessidades de IA, HPC e desenvolvimento de software com programas compatíveis com os principais provedores de serviços de nuvem.

Parceiros GPU AMD Instinct e soluções de servidor

A AMD colabora com os principais OEMs (Original Equipment Manufacturers, Fabricantes de equipamentos originais) e designers de plataformas para oferecer um ecossistema robusto de soluções AMD Instinct alimentadas por GPU.

Recursos

Fique por dentro

Inscreva-se para receber as últimas notícias sobre data centers e conteúdo sobre servidores.

Notas de rodapé

- Cálculos realizados pelos AMD Performance Labs em 22 de maio de 2025, com base nas especificações atuais e/ou estimativas. Os aceleradores AMD Instinct™ MI355X OAM têm capacidade de memória HBM3e de 288 GB e desempenho de largura de banda de memória teórica máxima da GPU de 8 TB/s. Os resultados mais altos publicados para o acelerador de GPU Nvidia Hopper H200 (141 GB) SXM resultaram em 141 GB de capacidade de memória HBM3e e desempenho de largura de banda de memória da GPU de 4,8 TB/s. https://nvdam.widen.net/s/nb5zzzsjdf/hpc-datasheet-sc23-h200-datasheet-3002446

Os resultados mais altos publicados para o acelerador de GPU Nvidia Blackwell HGX B200 (180 GB) resultaram em 180 GB de capacidade de memória HBM3e e desempenho de largura de banda de memória da GPU de 7,7 TB/s. https://nvdam.widen.net/s/wwnsxrhm2w/blackwell-datasheet-3384703

Os resultados mais altos publicados para o acelerador de GPU Nvidia Grace Blackwell GB200 (186 GB) resultaram em 186 GB de capacidade de memória HBM3e e desempenho de largura de banda de memória da GPU de 8 TB/s. https://nvdam.widen.net/s/wwnsxrhm2w/blackwell-datasheet-3384703 MI350-001

- Com base em cálculos realizados pelo AMD Performance Labs em maio de 2025, para determinar o desempenho teórico máximo de precisão das GPUs AMD Instinct™ MI350X/MI355X, ao comparar os tipos de dados FP64, FP32, FP16, OCP-FP8, FP8, MXFP6, FP6, MXFP4, FP4, INT8 e bfloat16 com Vector, Matrix ou Tensor com esparsidade, conforme aplicável, em comparação com o acelerador NVIDIA Blackwell B200. Os fabricantes de servidores podem variar as configurações, gerando resultados diferentes. MI350-009A

- Com base em cálculos realizados pelos AMD Performance Labs em maio de 2025 para determinar o desempenho teórico máximo de precisão das GPUs AMD Instinct™ MI350X/MI355X, ao comparar os formatos FP64 e FP32 com Vector, Matrix ou Tensor, conforme aplicável, em comparação em relação ao NVIDIA Blackwell B200. Os resultados podem variar conforme a configuração do servidor, tipo de dado e carga de trabalho. O desempenho pode variar com base no uso dos drivers e otimizações mais recentes. MI350-019

- Com base em cálculos da AMD em 17 de abril de 2025 usando as especificações de memória publicadas das GPUs AMD Instinct MI350X/MI355X (288 GB) vs. MI300X (192 GB) vs. MI325X (256 GB). Cálculos realizados com o tipo de dado FP16, considerando (2) bytes por parâmetro, para determinar o número mínimo de GPUs (com base na capacidade de memória) necessárias para executar os seguintes LLMs: OPT (130 bilhões de parâmetros), GPT-3 (175 bilhões de parâmetros), BLOOM (176 bilhões de parâmetros), Gopher (280 bilhões de parâmetros), PaLM 1 (340 bilhões de parâmetros), LM genérico (420 bilhões, 500 bilhões, 520 bilhões, 1,047 trilhão de parâmetros), Megatron-LM (530 bilhões de parâmetros), LLaMA (405 bilhões de parâmetros) e Samba (1 trilhão de parâmetros). Resultados com base no tamanho da memória da GPU em comparação com a memória exigida pelo modelo nos parâmetros definidos mais 10% de sobrecarga. Os fabricantes de servidores podem variar as configurações, gerando resultados diferentes. Os resultados podem variar de acordo com a configuração de memória da GPU, o tamanho do LLM e eventuais variações no acesso à memória da GPU ou no ambiente operacional do servidor. *Todos os dados baseados no tipo de dado FP16. Para FP8 = X2. Para FP4 = X4. MI350-012

- Segundo cálculos do AMD Performance Labs em maio de 2025, para as plataformas com 8 GPUs AMD Instinct™ MI350X/MI355X para determinar o desempenho teórico máximo de precisão ao comparar os tipos de dados FP64, FP32, FP16, OCP-FP8, FP8, MXFP6, FP6, MXFP4, FP4 e INT8 com operações de matriz, tensor, vetor e esparsidade (quando aplicável) vs. a plataforma de aceleradores NVIDIA HGX Blackwell B200. Os resultados podem variar conforme a configuração, o tipo de dado e a carga de trabalho. MI350-010A

- Cálculos realizados pelos AMD Performance Labs em 22 de maio de 2025, com base nas especificações atuais e/ou estimativas. Os aceleradores AMD Instinct™ MI355X OAM têm capacidade de memória HBM3e de 288 GB e desempenho de largura de banda de memória teórica máxima da GPU de 8 TB/s. Os resultados mais altos publicados para o acelerador de GPU Nvidia Hopper H200 (141 GB) SXM resultaram em 141 GB de capacidade de memória HBM3e e desempenho de largura de banda de memória da GPU de 4,8 TB/s. https://nvdam.widen.net/s/nb5zzzsjdf/hpc-datasheet-sc23-h200-datasheet-3002446 Os resultados mais altos publicados para o acelerador de GPU Nvidia Blackwell HGX B200 (180 GB) resultaram em 180 GB de capacidade de memória HBM3e e desempenho de largura de banda de memória da GPU de 7,7 TB/s. https://nvdam.widen.net/s/wwnsxrhm2w/blackwell-datasheet-3384703 Os resultados mais altos publicados para o acelerador de GPU Nvidia Grace Blackwell GB200 (186 GB) resultaram em 186 GB de capacidade de memória HBM3e e desempenho de largura de banda de memória da GPU de 8 TB/s. https://nvdam.widen.net/s/wwnsxrhm2w/blackwell-datasheet-3384703 MI350-001

- Com base em cálculos realizados pelo AMD Performance Labs em maio de 2025, para determinar o desempenho teórico máximo de precisão das GPUs AMD Instinct™ MI350X/MI355X, ao comparar os tipos de dados FP64, FP32, FP16, OCP-FP8, FP8, MXFP6, FP6, MXFP4, FP4, INT8 e bfloat16 com Vector, Matrix ou Tensor com esparsidade, conforme aplicável, em comparação com o acelerador NVIDIA Blackwell B200. Os fabricantes de servidores podem variar as configurações, gerando resultados diferentes. MI350-009A

- Com base em cálculos realizados pelos AMD Performance Labs em maio de 2025 para determinar o desempenho teórico máximo de precisão das GPUs AMD Instinct™ MI350X/MI355X, ao comparar os formatos FP64 e FP32 com Vector, Matrix ou Tensor, conforme aplicável, em comparação em relação ao NVIDIA Blackwell B200. Os resultados podem variar conforme a configuração do servidor, tipo de dado e carga de trabalho. O desempenho pode variar com base no uso dos drivers e otimizações mais recentes. MI350-019

- Com base em cálculos da AMD em 17 de abril de 2025 usando as especificações de memória publicadas das GPUs AMD Instinct MI350X/MI355X (288 GB) vs. MI300X (192 GB) vs. MI325X (256 GB). Cálculos realizados com o tipo de dado FP16, considerando (2) bytes por parâmetro, para determinar o número mínimo de GPUs (com base na capacidade de memória) necessárias para executar os seguintes LLMs: OPT (130 bilhões de parâmetros), GPT-3 (175 bilhões de parâmetros), BLOOM (176 bilhões de parâmetros), Gopher (280 bilhões de parâmetros), PaLM 1 (340 bilhões de parâmetros), LM genérico (420 bilhões, 500 bilhões, 520 bilhões, 1,047 trilhão de parâmetros), Megatron-LM (530 bilhões de parâmetros), LLaMA (405 bilhões de parâmetros) e Samba (1 trilhão de parâmetros). Resultados com base no tamanho da memória da GPU em comparação com a memória exigida pelo modelo nos parâmetros definidos mais 10% de sobrecarga. Os fabricantes de servidores podem variar as configurações, gerando resultados diferentes. Os resultados podem variar de acordo com a configuração de memória da GPU, o tamanho do LLM e eventuais variações no acesso à memória da GPU ou no ambiente operacional do servidor. *Todos os dados baseados no tipo de dado FP16. Para FP8 = X2. Para FP4 = X4. MI350-012

- Segundo cálculos do AMD Performance Labs em maio de 2025, para as plataformas com 8 GPUs AMD Instinct™ MI350X/MI355X para determinar o desempenho teórico máximo de precisão ao comparar os tipos de dados FP64, FP32, FP16, OCP-FP8, FP8, MXFP6, FP6, MXFP4, FP4 e INT8 com operações de matriz, tensor, vetor e esparsidade (quando aplicável) vs. a plataforma de aceleradores NVIDIA HGX Blackwell B200. Os resultados podem variar conforme a configuração, o tipo de dado e a carga de trabalho. MI350-010A