리더십 AI 및 HPC 가속기

AMD Instinct™ MI350 시리즈 GPU는 데이터 센터의 생성형 AI 및 고성능 컴퓨팅(HPC)에 대한 새로운 표준을 제시합니다. 새로운 최첨단 4세대 AMD CDNA™ 아키텍처를 기반으로 구축된 이 GPU는 대규모 AI 모델, 고속 추론 및 과학 시뮬레이션, 데이터 처리, 컴퓨팅 모델링과 같은 복잡한 HPC 워크로드를 학습시키는 데 탁월한 효율성과 성능을 제공합니다.

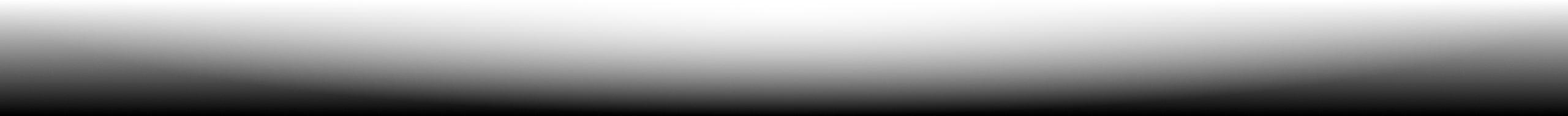

후드 밑

궁극의 AI 및 HPC 성능

최첨단 4세대 AMD CDNA™ 아키텍처를 기반으로 구축된 AMD Instinct™ MI350 시리즈 GPU는 강력하고 에너지 효율적인 코어로 와트당 성능을 극대화하여 AI 및 HPC 혁신의 차세대 시대를 주도합니다.

혜택

- 대용량 메모리를 활용한 혁신적인 AI 가속화

- AI 및 HPC를 위한 고급 보안

- 원활한 배포 및 AI 최적화

- AI 리더들의 신뢰

대용량 메모리를 활용한 혁신적인 AI 가속화

AMD Instinct™ MI350 시리즈 GPU는 차세대 MXFP6 및 MXFP4 데이터 유형을 지원하여 AI 가속을 새롭게 정의하고 효율성, 대역폭, 에너지 사용을 최적화하여 초고속 AI 추론 및 학습을 실현합니다.

가장 까다로운 AI 모델의 성능을 향상시킬 수 있도록 설계된 Instinct MI350 GPU는 288GB의 대용량 HBM3E 메모리와 8TB/s의 대역폭을 자랑하며 이전 세대에 비해 월등히 높은 성능을 제공합니다.1

AI 및 HPC를 위한 고급 보안

AMD Instinct™ MI350 시리즈 GPU는 신뢰할 수 있는 펌웨어를 보장하고, 하드웨어 무결성을 검증하고, 안전한 멀티 테넌트 GPU 공유를 지원하고, GPU 통신을 암호화하여 클라우드 AI 및 미션 크리티컬 워크로드의 안정성, 확장성 및 데이터 보안을 향상시킵니다.

원활한 배포 및 AI 최적화

AMD Instinct™ MI350 시리즈 GPU는 드롭인 호환성을 통해 원활하게 도입할 수 있으며, AMD GPU Operator는 Kubernetes의 배포 및 워크로드 구성을 단순화합니다. 개방형 AMD ROCm™ 소프트웨어 스택을 기반으로 개발자는 OpenAI, Meta, PyTorch, Hugging Face 등의 주요 AI 프레임워크 및 모델에 대한 Day 0 지원을 받을 수 있으므로 벤더 종속 없이 효율적으로 뛰어난 성능을 발휘하며 실행할 수 있습니다.

AI 리더들의 신뢰

업계 리더와 혁신가들은 Llama 405B 및 GPT와 같은 모델을 지원하는 대규모 AI용 AMD Instinct™ GPU를 신뢰합니다. CSP 및 OEM의 광범위한 AMD Instinct GPU 채택은 차세대 AI를 대규모로 추진하는 데 도움이 됩니다.

시리즈 살펴보기

AMD Instinct MI350 시리즈 GPU 및 AMD Instinct MI350 시리즈 플랫폼을 살펴보세요.

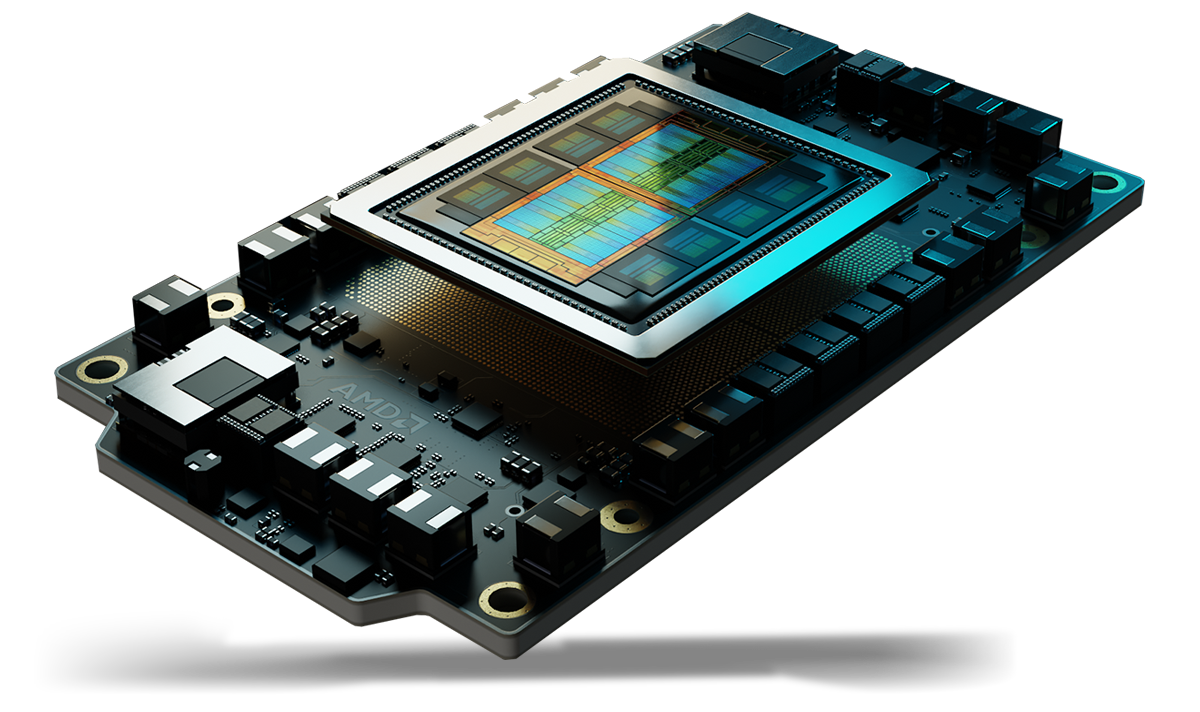

AMD Instinct™ MI350 시리즈 GPU 만나보기

4세대 AMD CDNA™ 아키텍처를 기반으로 구축된 AMD Instinct™ MI350 시리즈 GPU는 288GB의 대용량 HBM3E 메모리, 8TB/s 대역폭 및 MXFP6, MXFP4를 포함한 확장된 데이터 유형 지원을 통해 탁월한 AI 추론, 학습, HPC 워크로드 성능을 제공합니다.

CU 256개

GPU 컴퓨팅 유닛 256개

288GB

288GB HBM3E 메모리

8TB/s

8TB/s 피크 이론상 메모리 대역폭

스펙 비교

- AI 성능

- HPC 성능

- 메모리

AI 성능(피크 PFLOPS)

경쟁사 가속기 대비 최대 2.2배의 AI 성능2

FP16/BF16 Tensor/FP16/BF16 Matrix

(Sparsity)

FP8 Tensor/OCP-FP8 Matrix

(Sparsity)

FP6 Tensor/MXFP6 Matrix

B200 SXM5 180GB

MI355X OAM 288GB

HPC 성능(피크 TFLOPS)

경쟁사 가속기 대비 최대 2.1배의 HPC 성능3

B200 SXM5 180GB

MI355X OAM 288GB

메모리 용량 및 대역폭

경쟁사 가속기 대비 1.6배의 메모리 용량1

B200 SXM5 180GB

MI355X OAM 288GB

AMD Instinct 플랫폼

AMD Instinct MI350 시리즈 플랫폼은 4세대 AMD Infinity Fabric™ 기술을 통해 8개의 MI355X 또는 MI350X GPU OAM 모듈을 완전 연결 방식으로 통합하며, 업계 최고 수준인 2.3TB의 HBM3E 메모리 용량을 제공하여 고처리량 AI 작업을 지원합니다. 즉시 배포할 수 있는 이 플랫폼은 이제 표준 공랭식 UBB 기반 서버부터 초고밀도 DLC(Direct Liquid Cooled) 플랫폼에 이르기까지 다양한 시스템을 지원하므로 AMD Instinct MI350 시리즈 GPU를 기존 AI 랙 및 서버 인프라에 추가하면 출시 기간을 단축하고 개발 비용을 절감할 수 있습니다.

MI350 시리즈 GPU 8대

MI355X 또는 MI350X GPU OAM 모듈 8개

2.3TB

총 2.3TB의 HBM3E 메모리

64TB/s

64TB/s 피크 이론상 총 메모리 대역폭

AMD ROCm™ 소프트웨어

AMD ROCm™ 소프트웨어에는 AMD Instinct GPU를 대상으로 하는 AI 모델 및 HPC 워크로드를 위한 광범위한 프로그래밍 모델, 도구, 컴파일러, 라이브러리, 런타임 세트가 포함되어 있습니다.

사례 연구

솔루션 찾기

클라우드에서 경험하는 AMD Instinct GPU

선도적인 클라우드 서비스 공급업체가 지원하는 프로그램을 통해 AI, HPC, 소프트웨어 개발 요구를 뒷받침하세요.

AMD Instinct GPU 파트너 및 서버 솔루션

AMD는 선도적인 OEM(주문자 상표 부착 생산업체) 및 플랫폼 설계자와 협력하여 AMD Instinct GPU 기반 솔루션의 강력한 에코시스템을 제공합니다.

리소스

새로운 정보를 놓치지 마세요

최신 데이터 센터 소식과 서버 관련 콘텐츠를 받으려면 등록하세요.

각주

- 2025년 5월 22일 현재 AMD 퍼포먼스 랩에서 현재 사양 및/또는 추정치를 기준으로 수행한 계산입니다. AMD Instinct™ MI355X OAM 가속기는 288GB HBM3e 메모리 용량과 8TB/s GPU의 이론상 최대 메모리 대역폭 성능을 제공합니다. NVIDIA Hopper H200(141GB) SXM GPU 가속기에 대해 게시된 최고 결과는 141GB의 HBM3e 메모리 용량 및 4.8TB/s의 GPU 메모리 대역폭 성능입니다. https://nvdam.widen.net/s/nb5zzzsjdf/hpc-datasheet-sc23-h200-datasheet-3002446 NVidia Blackwell HGX B200(180GB) GPU 가속기에 대해 게시된 최고 결과는 180GB의 HBM3e 메모리 용량 및 7.7TB/s의 GPU 메모리 대역폭 성능입니다. https://nvdam.widen.net/s/wwnsxrhm2w/blackwell-datasheet-3384703 NVidia Grace Blackwell GB200(186GB) GPU 가속기에 대해 게시된 최고 결과는 186GB의 HBM3e 메모리 용량 및 8TB/s의 GPU 메모리 대역폭 성능입니다. https://nvdam.widen.net/s/wwnsxrhm2w/blackwell-datasheet-3384703 MI350-001

- 2025년 5월 AMD 퍼포먼스 랩의 계산을 토대로 Vector, Matrix, Tensor, Sparsity(해당하는 경우)와 FP64, FP32, FP16, OCP-FP8, FP8, MXFP6, FP6, MXFP4, FP4, INT8, bfloat16 데이터 유형을 비교했을 때 NVIDIA Blackwell B200 가속기 대비 AMD Instinct™ MI350X/MI355X GPU의 최대 이론상 정도 성능을 확인했습니다. 서버 제조업체별 구성에 따라 다른 결과가 나올 수 있습니다. MI350-009A

- 2025년 5월 AMD 퍼포먼스 랩의 계산을 토대로 FP64 및 FP32를 Vector, Matrix 또는 Tensor(해당하는 경우)와 비교했을 때 NVIDIA Blackwell B200 가속기 대비 AMD Instinct™ MI350X / MI355X GPU의 이론상 최고 정밀도 성능을 확인했습니다. 결과는 서버 구성, 데이터 유형, 워크로드에 따라 다를 수 있습니다. 최신 드라이버의 사용 여부 및 최적화에 따라 성능이 달라질 수 있습니다. MI350-019

- 2025년 4월 17일 현재 AMD의 계산을 토대로 MI350X/MI355X GPU(288GB) vs MI300X(192GB) vs MI325X(256GB)의 공개된 메모리 사양을 기준으로 합니다. 다음 LLM을 실행하는 데 필요한 최소 GPU 수(메모리 크기 기준)를 결정하기 위해 파라미터당 (2)바이트의 FP16 정밀도 데이터 형식으로 계산을 수행했습니다. OPT(1,300억 개 파라미터), GPT-3(1,750억 개 파라미터), BLOOM(1,760억 개 파라미터), Gopher(2,800억 개 파라미터), PaLM 1(3,400억 개 파라미터), Generic Lm(4,200억 개, 5,000억 개, 5,200억 개, 1조 470억 개 파라미터), Megatron-LM(5,300억 개 파라미터), LLaMA(4,050억 개 파라미터), Samba(10억 개 파라미터). 정의된 파라미터에 10% 오버헤드를 더한 모델에서 필요한 메모리 대비 GPU 메모리 크기를 기준으로 한 결과입니다. 서버 제조업체별 구성에 따라 다른 결과가 나올 수 있습니다. 결과는 GPU 메모리 구성, LLM 크기 및 GPU 메모리 액세스의 잠재적 변동 또는 서버 운영 환경에 따라 달라질 수 있습니다. *모든 데이터는 FP16 데이터 유형을 기반으로 합니다. FP8 = X2의 경우. FP4 = X4의 경우. MI350-012

- AMD 퍼포먼스 랩에 의해 FP64, FP32, FP16, OCP-FP8, FP8, MXFP6, FP6, MXFP4, FP4, INT8 데이터 유형을 Matrix, Tensor, Vector, Sparsity(적용 가능한 경우)와 비교하여 NVIDIA HGX Blackwell B200 가속기 플랫폼 대비 최대 이론상 정도 성능을 결정하기 위해 8 GPU AMD Instinct™ MI350X/MI355X 플랫폼에 대해 2025년 5월 수행된 계산에 기초했습니다. 결과는 구성, 데이터 유형, 워크로드에 따라 다를 수 있습니다. MI350-010A

- 2025년 5월 22일 현재 AMD 퍼포먼스 랩에서 현재 사양 및/또는 추정치를 기준으로 수행한 계산입니다. AMD Instinct™ MI355X OAM 가속기는 288GB HBM3e 메모리 용량과 8TB/s GPU의 이론상 최대 메모리 대역폭 성능을 제공합니다. NVIDIA Hopper H200(141GB) SXM GPU 가속기에 대해 게시된 최고 결과는 141GB의 HBM3e 메모리 용량 및 4.8TB/s의 GPU 메모리 대역폭 성능입니다. https://nvdam.widen.net/s/nb5zzzsjdf/hpc-datasheet-sc23-h200-datasheet-3002446 NVidia Blackwell HGX B200(180GB) GPU 가속기에 대해 게시된 최고 결과는 180GB의 HBM3e 메모리 용량 및 7.7TB/s의 GPU 메모리 대역폭 성능입니다. https://nvdam.widen.net/s/wwnsxrhm2w/blackwell-datasheet-3384703 NVidia Grace Blackwell GB200(186GB) GPU 가속기에 대해 게시된 최고 결과는 186GB의 HBM3e 메모리 용량 및 8TB/s의 GPU 메모리 대역폭 성능입니다. https://nvdam.widen.net/s/wwnsxrhm2w/blackwell-datasheet-3384703 MI350-001

- 2025년 5월 AMD 퍼포먼스 랩의 계산을 토대로 Vector, Matrix, Tensor, Sparsity(해당하는 경우)와 FP64, FP32, FP16, OCP-FP8, FP8, MXFP6, FP6, MXFP4, FP4, INT8, bfloat16 데이터 유형을 비교했을 때 NVIDIA Blackwell B200 가속기 대비 AMD Instinct™ MI350X/MI355X GPU의 최대 이론상 정도 성능을 확인했습니다. 서버 제조업체별 구성에 따라 다른 결과가 나올 수 있습니다. MI350-009A

- 2025년 5월 AMD 퍼포먼스 랩의 계산을 토대로 FP64 및 FP32를 Vector, Matrix 또는 Tensor(해당하는 경우)와 비교했을 때 NVIDIA Blackwell B200 가속기 대비 AMD Instinct™ MI350X / MI355X GPU의 이론상 최고 정밀도 성능을 확인했습니다. 결과는 서버 구성, 데이터 유형, 워크로드에 따라 다를 수 있습니다. 최신 드라이버의 사용 여부 및 최적화에 따라 성능이 달라질 수 있습니다. MI350-019

- 2025년 4월 17일 현재 AMD의 계산을 토대로 MI350X/MI355X GPU(288GB) vs MI300X(192GB) vs MI325X(256GB)의 공개된 메모리 사양을 기준으로 합니다. 다음 LLM을 실행하는 데 필요한 최소 GPU 수(메모리 크기 기준)를 결정하기 위해 파라미터당 (2)바이트의 FP16 정밀도 데이터 형식으로 계산을 수행했습니다. OPT(1,300억 개 파라미터), GPT-3(1,750억 개 파라미터), BLOOM(1,760억 개 파라미터), Gopher(2,800억 개 파라미터), PaLM 1(3,400억 개 파라미터), Generic Lm(4,200억 개, 5,000억 개, 5,200억 개, 1조 470억 개 파라미터), Megatron-LM(5,300억 개 파라미터), LLaMA(4,050억 개 파라미터), Samba(10억 개 파라미터). 정의된 파라미터에 10% 오버헤드를 더한 모델에서 필요한 메모리 대비 GPU 메모리 크기를 기준으로 한 결과입니다. 서버 제조업체별 구성에 따라 다른 결과가 나올 수 있습니다. 결과는 GPU 메모리 구성, LLM 크기 및 GPU 메모리 액세스의 잠재적 변동 또는 서버 운영 환경에 따라 달라질 수 있습니다. *모든 데이터는 FP16 데이터 유형을 기반으로 합니다. FP8 = X2의 경우. FP4 = X4의 경우. MI350-012

- AMD 퍼포먼스 랩에 의해 FP64, FP32, FP16, OCP-FP8, FP8, MXFP6, FP6, MXFP4, FP4, INT8 데이터 유형을 Matrix, Tensor, Vector, Sparsity(적용 가능한 경우)와 비교하여 NVIDIA HGX Blackwell B200 가속기 플랫폼 대비 최대 이론상 정도 성능을 결정하기 위해 8 GPU AMD Instinct™ MI350X/MI355X 플랫폼에 대해 2025년 5월 수행된 계산에 기초했습니다. 결과는 구성, 데이터 유형, 워크로드에 따라 다를 수 있습니다. MI350-010A