accélération de pointe de l'IA et du HPC

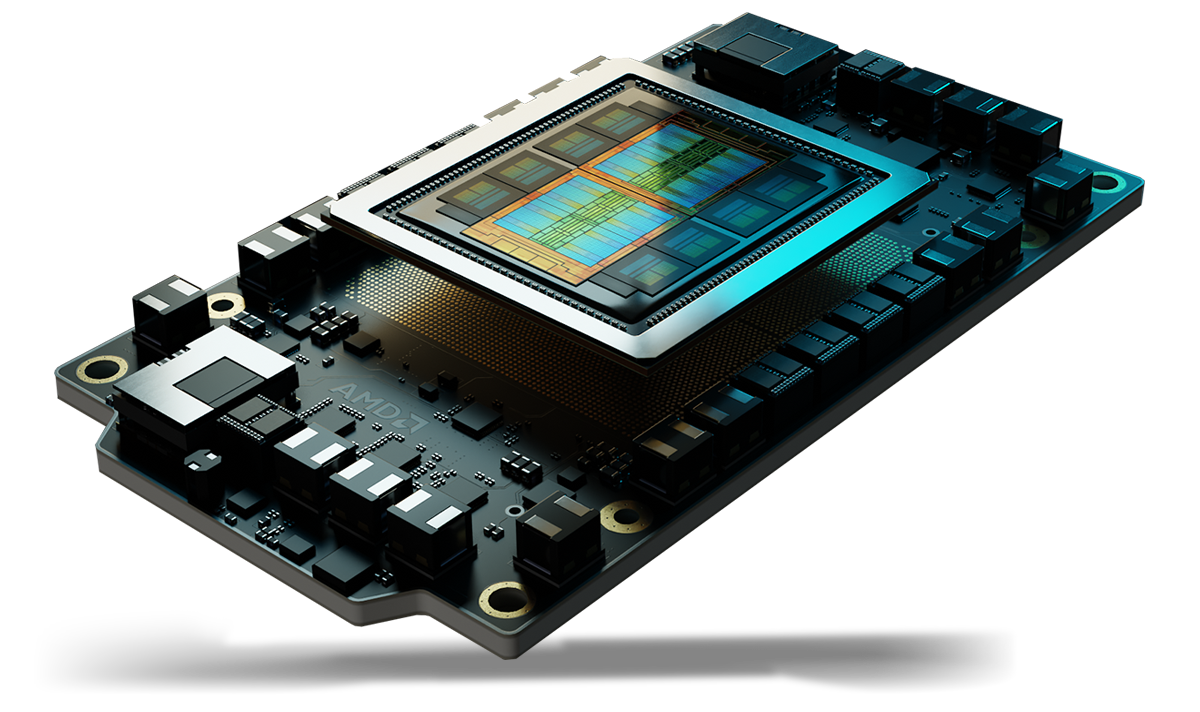

Les GPU AMD Instinct™ Série MI350 établissent une nouvelle norme pour l'IA générative et les calculs hautes performances (HPC) dans les centres de données. Basés sur la nouvelle architecture de pointe AMD CDNA™ de 4e génération, ces GPU offrent une efficacité et des performances exceptionnelles pour l'entraînement de modèles d'IA massifs, l'inférence haute vitesse, ainsi que les charges de travail HPC complexes telles que les simulations scientifiques, le traitement de données et la modélisation en matière de calcul.

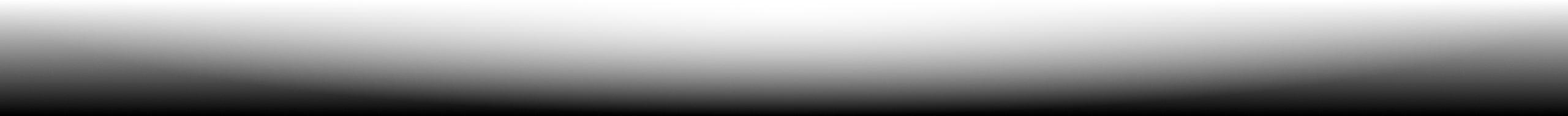

Qu'est-ce qui se cache sous le capot ?

Des performances optimales pour l'IA et le HPC

Basés sur l'architecture de pointe AMD CDNA™ de 4e génération, les GPU AMD Instinct™ Série MI350 intègrent des cœurs puissants et économes en énergie qui optimisent les performances par watt pour ouvrir une nouvelle ère d'innovation en matière d'IA et de HPC.

Avantages

- Accélération révolutionnaire de l'IA avec une mémoire considérable

- Sécurité avancée pour l'IA et le HPC

- Déploiement fluide et optimisation de l'IA

- Approuvés par les leaders de l'IA

Accélération révolutionnaire de l'IA avec une mémoire considérable

Les GPU AMD Instinct™ Série MI350 redéfinissent l'accélération de l'IA avec la prise en charge des types de données MXFP6 et MXFP4 de nouvelle génération. Ils optimisent l'efficacité, la bande passante et la consommation d'énergie pour une inférence et un entraînement d'IA ultra-rapides.

Conçus pour booster les performances des modèles d'IA les plus exigeants, les GPU Instinct MI350 disposent d'une mémoire HBM3E de 288 Go et d'une bande passante de 8 To/s. Ils représentent ainsi un énorme bond en avant par rapport aux performances des générations précédentes1.

Sécurité avancée pour l'IA et le HPC

Les GPU AMD Instinct™ Série MI350 aident à garantir l'utilisation d'un micrologiciel approuvé, à vérifier l'intégrité du hardware, à assurer le partage sécurisé des GPU multi-tenant et à crypter les communications GPU. Ils améliorent ainsi la fiabilité, l'évolutivité et la sécurité des données pour l'IA dans le cloud et les charges de travail stratégiques.

Déploiement fluide et optimisation de l'IA

Les GPU AMD Instinct™ Série MI350 facilitent l'adoption grâce à une compatibilité directe, tandis qu'AMD GPU Operator simplifie le déploiement et la configuration des charges de travail dans Kubernetes. Comme ces GPU sont basés sur la pile software ouverte AMD ROCm™, les développeurs bénéficient d'une prise en charge immédiate pour les principaux modèles et structures d'IA OpenAI, Meta, PyTorch, Hugging Face, etc. Ils peuvent ainsi assurer une exécution efficace et hautes performances sans dépendre d'un fournisseur.

Approuvés par les leaders de l'IA

Les leaders et innovateurs du secteur font confiance aux GPU AMD Instinct™ pour les grands modèles d'IA tels que Llama 405B et GPT. L'adoption généralisée des GPU AMD Instinct par les fournisseurs de services cloud et les OEM contribue à développer l'IA nouvelle génération à grande échelle.

Découvrez la série

Explorez les GPU AMD Instinct Série MI350 et les plateformes AMD Instinct Série MI350.

Découvrez les GPU AMD Instinct™ Série MI350

Basés sur l'architecture AMD CDNA™ de 4e génération, les GPU AMD Instinct™ Série MI350 fournissent des performances exceptionnelles en matière d'inférence IA, d'entraînement et de charge de travail HPC. Ils offrent une mémoire HBM3E massive de 288 Go, une bande passante de 8 To/s et une prise en charge étendue des types de données, notamment MXFP6 et MXFP4.

256 UC

256 unités de calcul GPU

288 Go

288 Go de mémoire HBM3E

8 To/s

Pic théorique de bande passante mémoire de 8 To/s

Comparaisons de spécifications

- Performances d'IA

- Performances HPC

- Mémoire

Performances d'IA (Pic de PFLOPS)

Jusqu'à 2,2x plus de performances d'IA par rapport aux accélérateurs concurrents2

Tensor FP16/BF16 / Matrice FP16/BF16

(Parcimonie)

Tensor FP8 / Matrice OCP-FP8

(Parcimonie)

Tensor FP6 / Matrice MXFP6

B200 SXM5 180 Go

MI355X OAM 288 Go

Performances HPC (pic de TFLOPS)

Jusqu'à 2,1x plus de performances HPC par rapport aux accélérateurs concurrents3

B200 SXM5 180 Go

MI355X OAM 288 Go

Capacité de mémoire et bande passante

Jusqu'à 1,6x plus de capacité de mémoire par rapport aux accélérateurs concurrents1

B200 SXM5 180 Go

MI355X OAM 288 Go

Plateformes AMD Instinct

Les plateformes AMD Instinct Série MI350 intègrent 8 modules OAM GPU MI355X ou MI350X entièrement connectés dans une conception OCP standard, via la technologie AMD Infinity Fabric™ 4e génération, offrant une capacité de mémoire HBM3E exceptionnelle de 2,3 To pour le traitement IA à haut débit. Ces plateformes prêtes à déployer prennent désormais en charge une grande variété de systèmes, des serveurs standard basés sur UBB à refroidissement par air aux plateformes ultra-denses à refroidissement liquide direct (DLC). Ainsi, la mise sur le marché est plus rapide et les coûts de développement sont réduits lors de l'ajout de GPU AMD Instinct Série MI350 à des infrastructures de rack et de serveur d'IA existantes.

8 GPU Série MI350

Huit (8) modules OAM GPU MI355X ou MI350X

2,3 To

2,3 To de mémoire HBM3E totale

64 To/s

Pic théorique de bande passante mémoire cumulée de 64 To/s

Software AMD ROCm™

Le software AMD ROCm™ inclut un large éventail de modèles de programmation, d'outils, de compilateurs, de bibliothèques et d'exécutions pour les GPU AMD Instinct dédiés aux charges de travail d'IA et de HPC.

Études de cas

Trouver des solutions

Utilisez les GPU AMD Instinct dans le cloud.

Répondez à vos besoins en matière d'IA, de HPC et de développement software grâce à des programmes proposés par les principaux fournisseurs de services cloud.

Partenaires et solutions serveur GPU AMD Instinct

AMD collabore avec les principaux fabricants d'équipements d'origine (OEM) ainsi que des concepteurs de plateformes pour un écosystème robuste de solutions basées sur les GPU AMD Instinct.

Ressources

Tenez-vous au courant

Abonnez-vous pour recevoir les actualités et contenus les plus récents sur les centres de données et les serveurs.

Notes de bas de page

- Calculs effectués par AMD Performance Labs le 22 mai 2025, sur la base des spécifications et/ou estimations actuelles. Les accélérateurs OAM AMD Instinct™ MI355X offrent une capacité de mémoire HBM3e de 288 Go et un pic de performance théorique de bande passante mémoire du GPU de 8 To/s. Les résultats publiés les plus élevés sur l'accélérateur GPU NVIDIA Hopper H200 SXM (141 Go) ont indiqué une capacité de mémoire HBM3e de 141 Go et des performances de bande passante mémoire du GPU de 4,8 To/s. https://nvdam.widen.net/s/nb5zzzsjdf/hpc-datasheet-sc23-h200-datasheet-3002446 Les résultats publiés les plus élevés sur l'accélérateur GPU NVIDIA Blackwell HGX B200 (180 Go) ont indiqué une capacité de mémoire HBM3e de 180 Go et des performances de bande passante mémoire du GPU de 7,7 To/s. https://nvdam.widen.net/s/wwnsxrhm2w/blackwell-datasheet-3384703 Les résultats publiés les plus élevés sur l'accélérateur GPU NVIDIA Grace Blackwell GB200 (186 Go) ont indiqué une capacité de mémoire HBM3e de 186 Go et des performances de bande passante mémoire du GPU de 8 To/s. https://nvdam.widen.net/s/wwnsxrhm2w/blackwell-datasheet-3384703 MI350-001

- Sur la base des calculs réalisés par AMD Performance Labs en mai 2025, afin de déterminer le pic de performance théorique en précision des GPU AMD Instinct™ MI350X/MI355X en comparant les types de données FP64, FP32, FP16, OCP-FP8, FP8, MXFP6, FP6, MXFP4, FP4, INT8 et bfloat16 en matière de vecteur, de matrice ou de tenseur parcimonieux, selon le cas, par rapport à l'accélérateur NVIDIA Blackwell B200. Les résultats peuvent varier en fonction des configurations créées par les fabricants de serveurs. MI350-009A

- Sur la base des calculs réalisés par AMD Performance Labs en mai 2025, afin de déterminer le pic de performance théorique en précision des GPU AMD Instinct™ MI350X/MI355X en comparant les types de données FP64 et FP32 en matière de vecteur, de matrice ou de tenseur, selon le cas, par rapport à l'accélérateur NVIDIA Blackwell B200. Les résultats peuvent varier en fonction de la configuration du serveur, du type de données et de la charge de travail. Les performances peuvent varier en fonction de l'utilisation de pilotes plus récents et des optimisations. MI350-019

- Sur la base des calculs réalisés par AMD le 17 avril 2025, selon les spécifications de mémoire publiées du GPU AMD Instinct MI350X/MI355X (288 Go), par rapport aux GPU MI300X (192 Go) et MI325X (256 Go). Calculs effectués avec un type de données en précision FP16 à 2 octets par paramètre, afin de déterminer le nombre minimum de GPU (en fonction de la taille de la mémoire) requis pour exécuter les LLM suivants : OPT (130 milliards de paramètres), GPT-3 (175 milliards de paramètres), BLOOM (176 milliards de paramètres), Gopher (280 milliards de paramètres), PaLM 1 (340 milliards de paramètres), Generic LM (420 milliards, 500 milliards, 520 milliards et 1,047 billions de paramètres), Megatron LM (530 milliards de paramètres), Llama (405 milliards de paramètres) et Samba (1 billion de paramètres). Résultats basés sur la taille de la mémoire du GPU par rapport à la mémoire requise par le modèle, aux paramètres définis plus 10 % de charge supplémentaire. Les résultats peuvent varier en fonction des configurations créées par les fabricants de serveurs. Les résultats peuvent varier en fonction de la configuration de la mémoire du GPU, de la taille du LLM et de la variation potentielle de l'accès à la mémoire du GPU ou de l'environnement d'exploitation du serveur. *Toutes les données sont basées sur le type de données FP16. Pour FP8 = X2. Pour FP4 = X4. MI350-012

- Sur la base des calculs réalisés par AMD Performance Labs en mai 2025, pour les plateformes à 8 GPU AMD Instinct™ MI350X/MI355X, afin de déterminer le pic de performance théorique en précision en comparant les types de données FP64, FP32, FP16, OCP-FP8, FP8, MXFP6, FP6, MXFP4, FP4 et INT8 en matière de matrice, de tenseur, de vecteur et de parcimonie, selon le cas, par rapport à la plateforme d'accélérateur NVIDIA HGX Blackwell B200. Les résultats peuvent varier en fonction de la configuration, du type de données et de la charge de travail. MI350-010A

- Calculs effectués par AMD Performance Labs le 22 mai 2025, sur la base des spécifications et/ou estimations actuelles. Les accélérateurs OAM AMD Instinct™ MI355X offrent une capacité de mémoire HBM3e de 288 Go et un pic de performance théorique de bande passante mémoire du GPU de 8 To/s. Les résultats publiés les plus élevés sur l'accélérateur GPU NVIDIA Hopper H200 SXM (141 Go) ont indiqué une capacité de mémoire HBM3e de 141 Go et des performances de bande passante mémoire du GPU de 4,8 To/s. https://nvdam.widen.net/s/nb5zzzsjdf/hpc-datasheet-sc23-h200-datasheet-3002446 Les résultats publiés les plus élevés sur l'accélérateur GPU NVIDIA Blackwell HGX B200 (180 Go) ont indiqué une capacité de mémoire HBM3e de 180 Go et des performances de bande passante mémoire du GPU de 7,7 To/s. https://nvdam.widen.net/s/wwnsxrhm2w/blackwell-datasheet-3384703 Les résultats publiés les plus élevés sur l'accélérateur GPU NVIDIA Grace Blackwell GB200 (186 Go) ont indiqué une capacité de mémoire HBM3e de 186 Go et des performances de bande passante mémoire du GPU de 8 To/s. https://nvdam.widen.net/s/wwnsxrhm2w/blackwell-datasheet-3384703 MI350-001

- Sur la base des calculs réalisés par AMD Performance Labs en mai 2025, afin de déterminer le pic de performance théorique en précision des GPU AMD Instinct™ MI350X/MI355X en comparant les types de données FP64, FP32, FP16, OCP-FP8, FP8, MXFP6, FP6, MXFP4, FP4, INT8 et bfloat16 en matière de vecteur, de matrice ou de tenseur parcimonieux, selon le cas, par rapport à l'accélérateur NVIDIA Blackwell B200. Les résultats peuvent varier en fonction des configurations créées par les fabricants de serveurs. MI350-009A

- Sur la base des calculs réalisés par AMD Performance Labs en mai 2025, afin de déterminer le pic de performance théorique en précision des GPU AMD Instinct™ MI350X/MI355X en comparant les types de données FP64 et FP32 en matière de vecteur, de matrice ou de tenseur, selon le cas, par rapport à l'accélérateur NVIDIA Blackwell B200. Les résultats peuvent varier en fonction de la configuration du serveur, du type de données et de la charge de travail. Les performances peuvent varier en fonction de l'utilisation de pilotes plus récents et des optimisations. MI350-019

- Sur la base des calculs réalisés par AMD le 17 avril 2025, selon les spécifications de mémoire publiées du GPU AMD Instinct MI350X/MI355X (288 Go), par rapport aux GPU MI300X (192 Go) et MI325X (256 Go). Calculs effectués avec un type de données en précision FP16 à 2 octets par paramètre, afin de déterminer le nombre minimum de GPU (en fonction de la taille de la mémoire) requis pour exécuter les LLM suivants : OPT (130 milliards de paramètres), GPT-3 (175 milliards de paramètres), BLOOM (176 milliards de paramètres), Gopher (280 milliards de paramètres), PaLM 1 (340 milliards de paramètres), Generic LM (420 milliards, 500 milliards, 520 milliards et 1,047 billions de paramètres), Megatron LM (530 milliards de paramètres), Llama (405 milliards de paramètres) et Samba (1 billion de paramètres). Résultats basés sur la taille de la mémoire du GPU par rapport à la mémoire requise par le modèle, aux paramètres définis plus 10 % de charge supplémentaire. Les résultats peuvent varier en fonction des configurations créées par les fabricants de serveurs. Les résultats peuvent varier en fonction de la configuration de la mémoire du GPU, de la taille du LLM et de la variation potentielle de l'accès à la mémoire du GPU ou de l'environnement d'exploitation du serveur. *Toutes les données sont basées sur le type de données FP16. Pour FP8 = X2. Pour FP4 = X4. MI350-012

- Sur la base des calculs réalisés par AMD Performance Labs en mai 2025, pour les plateformes à 8 GPU AMD Instinct™ MI350X/MI355X, afin de déterminer le pic de performance théorique en précision en comparant les types de données FP64, FP32, FP16, OCP-FP8, FP8, MXFP6, FP6, MXFP4, FP4 et INT8 en matière de matrice, de tenseur, de vecteur et de parcimonie, selon le cas, par rapport à la plateforme d'accélérateur NVIDIA HGX Blackwell B200. Les résultats peuvent varier en fonction de la configuration, du type de données et de la charge de travail. MI350-010A