領先業界的 AI 與 HPC 加速

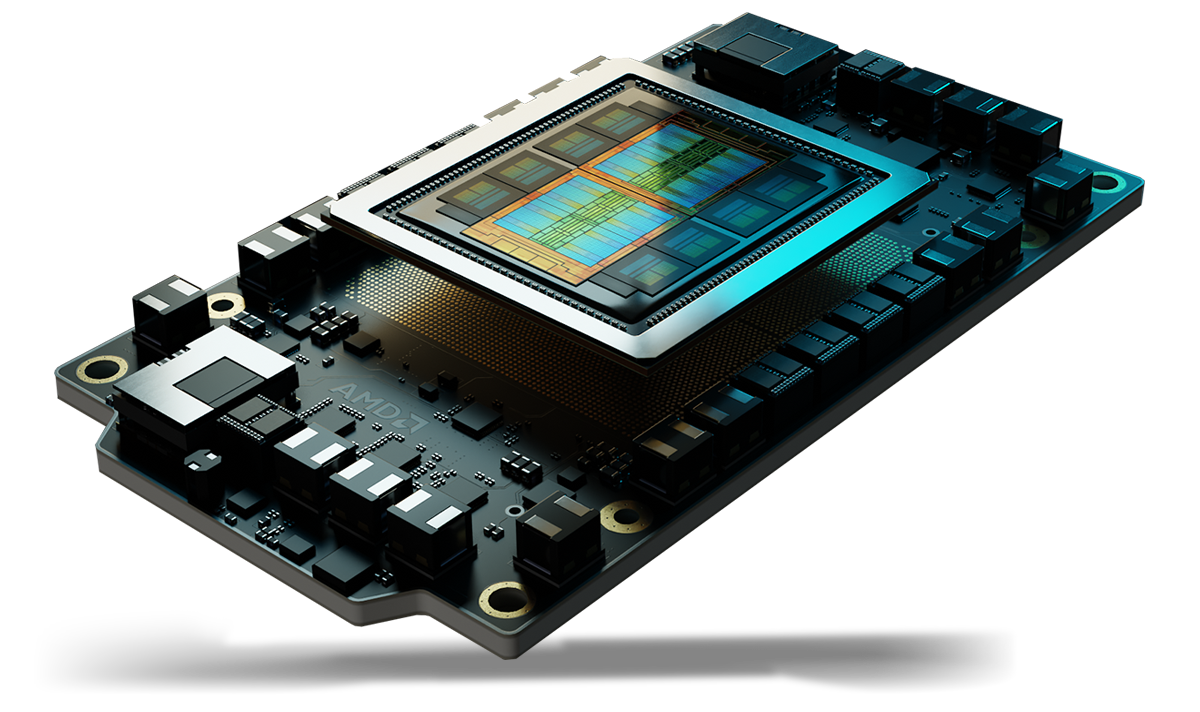

AMD Instinct™ MI350 系列顯示卡為資料中心的生成式 AI 與高效能運算 (HPC) 樹立了新標準。這些顯示卡是以全新的第 4 代 AMD CDNA™ 架構為基礎,能為大規模 AI 模型訓練、高速推論,以及科學模擬、資料處理和運算模型等複雜的 HPC 工作負載,提供卓越的效率和效能。

背後的秘密

極致的 AI 與 HPC 效能

AMD Instinct™ MI350 系列顯示卡採用最先進的第 4 代 AMD CDNA™ 架構,搭載強大且節能的核心,最大化每瓦效能,推動新一代的 AI 與 HPC 創新。

優勢

- 用龐大的記憶體突破 AI 加速原有框架

- AI 和 HPC 的進階安全性

- 順暢部署與 AI 最佳化

- 深受 AI 領導者信賴

用龐大的記憶體突破 AI 加速原有框架

AMD Instinct™ MI350 系列顯示卡運用新一代 MXFP6 和 MXFP4 資料類型支援重新定義 AI 加速,透過效率、頻寬和用電最佳化,實現快如閃電的 AI 推論和訓練。

Instinct MI350 顯示卡專為高效推進最嚴苛的 AI 模型而設計,擁有高達 288 GB 的龐大 HBM3E 記憶體和 8TB/s 頻寬,與前幾代相比,效能大幅躍進。1

AI 和 HPC 的進階安全性

AMD Instinct™ MI350 系列顯示卡可協助確認受信任的韌體、驗證硬體完整性、實現安全的多租戶顯示卡共用,並加密顯示卡通訊,有助於提升雲端 AI 和關鍵任務工作負載的可靠性、擴充性和資料安全性。

順暢部署與 AI 最佳化

AMD Instinct™ MI350 系列顯示卡提供了直接相容性,而有助於實現流暢的布建程序,而 AMD GPU Operator 則簡化了 Kubernetes 中的部署與工作負載設定。採用開放式 AMD ROCm™ 軟體堆疊,開發人員可獲得頂尖主流 AI 架構和模型的無延遲支援,包括 OpenAI、Meta、PyTorch、Hugging Face 等,有助於在不受限於單一廠商的情況下,確保有效率、高效能的執行。

深受 AI 領導者信賴

業界領先大廠與創新先驅都信賴 AMD Instinct™ 顯示卡能處理大規模 AI,驅動 Llama 405B 及 GPT 等模型。在各家 CSP 和 OEM 的廣泛採用之下,AMD Instinct 顯示卡成為了大規模推動新一代 AI 的幕後功臣。

認識此系列

探索 AMD Instinct MI350 系列顯示卡與 AMD Instinct MI350 系列平台。

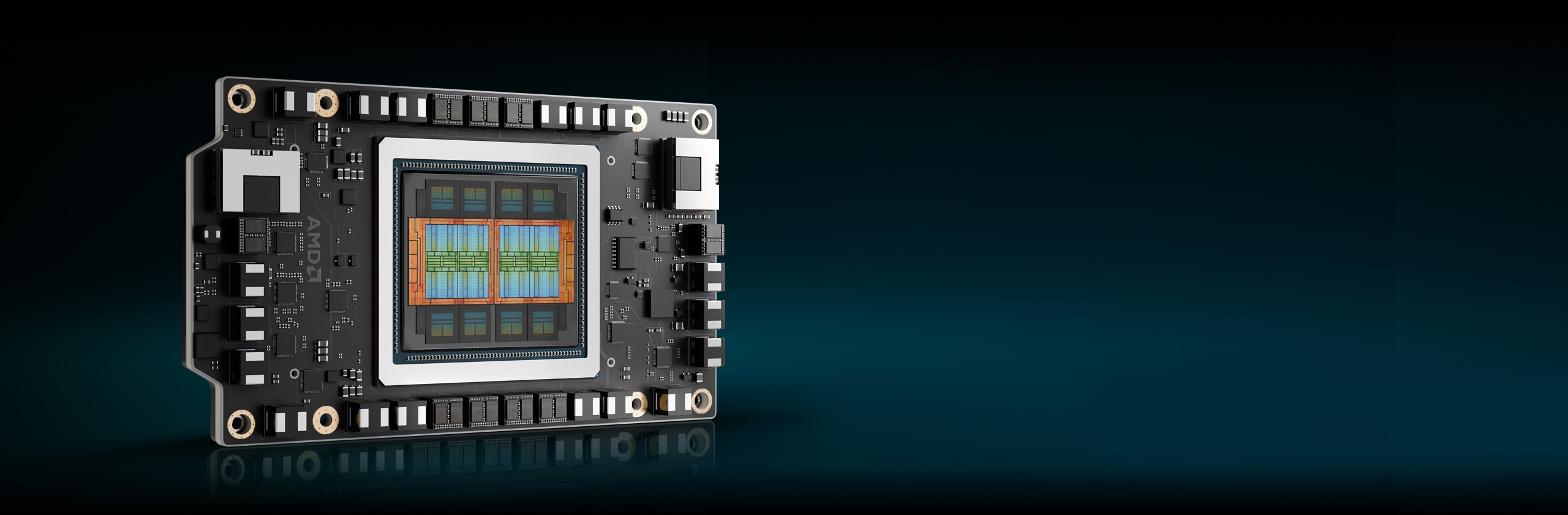

AMD Instinct™ MI350 系列顯示卡

以第 4 代 AMD CDNA™ 架構為基礎的 AMD Instinct™ MI350 系列顯示卡,透過 288 GB 的龐大 HBM3E 記憶體、8TB/s 頻寬,以及對於 MXFP6 和 MXFP4 資料類型的擴大支援,提供優異的 AI 推論、訓練和 HPC 工作負載效能。

256 個 CU

256 個顯示卡運算單元

288 GB

288 GB HBM3E 記憶體

8 TB/s

8 TB/s 峰值理論記憶體頻寬

規格比較

- AI 效能

- HPC 效能

- 記憶體

AI 效能(峰值 PFLOPS)

AI 效能最高達競品加速器的 2.2 倍2

FP16/BF16 Tensor/FP16/BF16 矩陣

(稀疏性)

FP8 Tensor/OCP-FP8 矩陣

(稀疏性)

FP6 Tensor/MXFP6 矩陣

B200 SXM5 180 GB

MI355X OAM 288 GB

HPC 效能(峰值 TFLOPs)

與競爭的加速器相較,HPC 效能提升高達 2.1 倍3

B200 SXM5 180 GB

MI355X OAM 288 GB

記憶體容量與頻寬

記憶體容量達競品加速器的 1.6 倍1

B200 SXM5 180 GB

MI355X OAM 288 GB

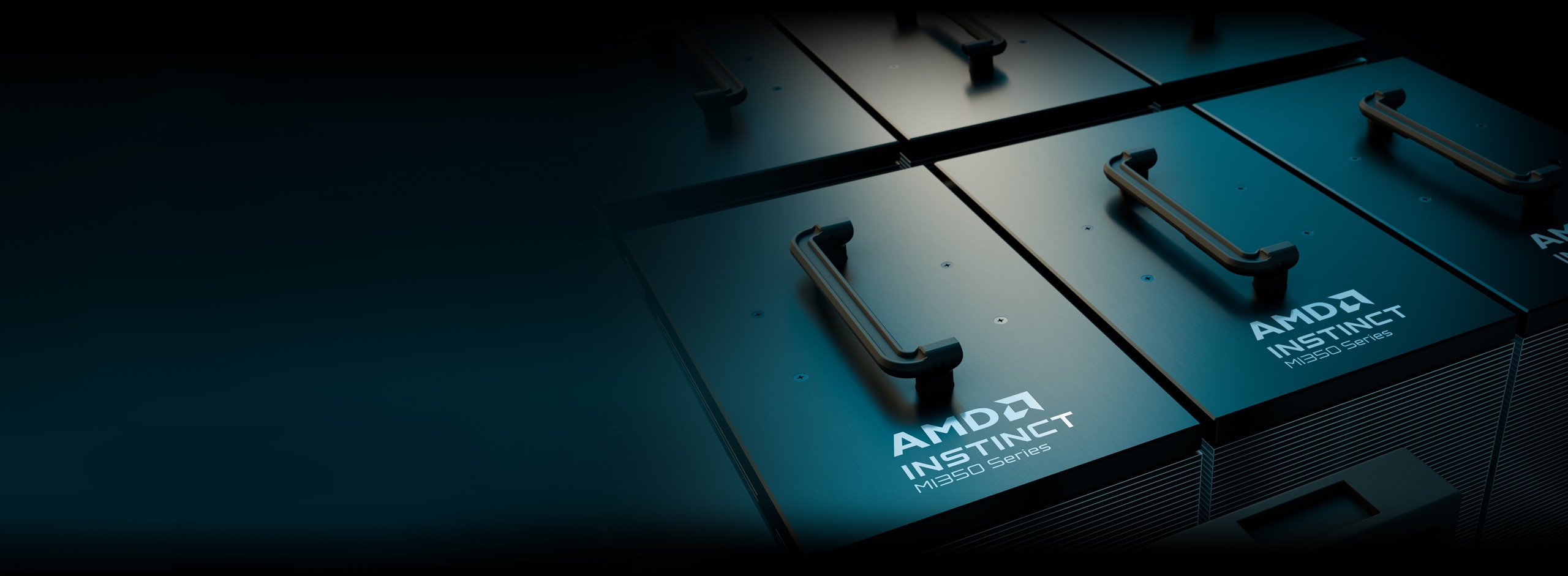

AMD Instinct 平台

AMD Instinct MI350 系列平台透過第 4 代 AMD Infinity Fabric™ 技術,將 8 個完全連線的 MI355X 或 MI350X 顯示卡 OAM 模組整合到業界標準的 OCP 設計上,提供領先業界的 2.3 TB HBM3E 記憶體容量,實現高輸送量的 AI 處理。從標準氣冷式 UBB 型伺服器,到超密集直接液體冷卻式 (DLC) 平台,這些可隨時部署的平台現在支援各式各樣的系統,而有助於縮短上市時間,在將 AMD Instinct MI350 系列顯示卡添加到現有的 AI 機架和伺服器基礎架構時,還能夠降低開發成本。

8 張 MI350 系列顯示卡

八 (8) 個 MI355X 或 MI350X 顯示卡 OAM 模組

2.3 TB

2.3 TB HBM3E 總記憶體

64 TB/s

64 TB/s 峰值理論總合記憶體頻寬

AMD ROCm™ 軟體

AMD ROCm™ 軟體包含豐富的程式設計模型、工具、編譯器、程式庫及執行階段,適用於針對 AMD Instinct 顯示卡所設計的 AI 模型和 HPC 工作負載。

案例研究

尋找解決方案

在雲端體驗 AMD Instinct 顯示卡

透過由一流雲端服務供應商支持協助的計畫,支援您的 AI、HPC 和軟體開發需求。

AMD Instinct 顯示卡合作夥伴與伺服器解決方案

AMD 與領先業界的原始設備製造商 (OEM) 和平台設計商合作提供採用 AMD Instinct 顯示卡技術的解決方案,打造出健全而強大的生態系統。

資源

掌握最新動態

註冊以收到最新的資料中心消息和伺服器內容。

尾註

- AMD 效能實驗室於 2025 年 5 月 22 日根據當下的規格和/或評估進行的計算。AMD Instinct™ MI355X OAM 加速器擁有 288 GB HBM3e 記憶體容量和 8 TB/s 顯示卡峰值理論記憶體頻寬效能。NVIDIA Hopper H200 (141 GB) SXM 顯示卡加速器的最高已公佈結果為 141 GB HBM3e 記憶體容量和 4.8 TB/s 顯示卡記憶體頻寬效能:https://nvdam.widen.net/s/nb5zzzsjdf/hpc-datasheet-sc23-h200-datasheet-3002446。NVIDIA Blackwell HGX B200 (180 GB) 顯示卡加速器的最高已公佈結果為 180 GB HBM3e 記憶體容量和 7.7 TB/s 顯示卡記憶體頻寬效能:https://nvdam.widen.net/s/wwnsxrhm2w/blackwell-datasheet-3384703。NVIDIA Grace Blackwell GB200 (186 GB) 顯示卡加速器的最高已公佈結果為 186 GB HBM3e 記憶體容量和 8 TB/s 顯示卡記憶體頻寬效能:https://nvdam.widen.net/s/wwnsxrhm2w/blackwell-datasheet-3384703 MI350-001

- 根據 AMD 效能實驗室於 2025 年 5 月所執行的計算,此計算以 NVIDIA Blackwell B200 加速器作為對比,目的在於判斷使用向量、矩陣或 Tensor(若適用即採稀疏性)來比較 FP64、FP32、FP16、OCP-FP8、FP8、MXFP6、FP6、MXFP4、FP4、INT8 和 bfloat16 資料類型時,AMD Instinct™ MI350X/MI355X 顯示卡的峰值理論精度效能。伺服器製造商可能會改變配置,而得到不同的結果。MI350-009A

- 根據 AMD 效能實驗室於 2025 年 5 月所執行的計算,此計算以 NVIDIA Blackwell B200 加速器作為對比,目的在於判斷使用向量、矩陣或 Tensor(若適用)來比較 FP64 和 FP32 時,AMD Instinct™ MI350X / MI355X 顯示卡的峰值理論精度效能。結果可能會因伺服器組態、資料類型和工作負載而有不同。效能可能會因使用了最新驅動程式及最佳化而不同。MI350-019

- 根據 AMD 於 2025 年 4 月 17 日的計算,計算時所採用的記憶體規格,是根據當時 AMD Instinct MI350X/MI355X 顯示卡 (288 GB),以及比較對象 MI300X (192 GB) 和 MI325X (256 GB) 的已公佈資料。 計算之執行條件為,採用 F16 精度資料類型,每個參數 (2) 個位元組;計算之目標,是要確定執行下列 LLM 所需要的最少顯示卡數量(根據記憶體大小):OPT(1300 億個參數)、GPT-3(1750 億個參數)、BLOOM(1760 億個參數)、Gopher(2800 億個參數)、PaLM 1(3400 億個參數)、Generic LM(4200 億、5000 億、5200 億、1 兆 470 億個參數)、Megatron-LM(5300 億個參數)、LLaMA(4050 億個參數)和 Samba(1 兆個參數)。計算之結果,係在前述參數定義下,將顯示卡記憶大小與模型所需記憶體大小兩相比較後得出,此結果已另外納入了 10% 冗餘。伺服器製造商可能會改變配置,而得到不同的結果。結果可能會因顯示卡記憶體組態、LLM 大小,以及顯示卡記憶體存取或伺服器作業環境的潛在差異而有不同。*所有資料均基於 FP16 資料類型。換算倍率:FP8 = X2; 適FP4 = X4。MI350-012

- 根據 AMD 效能實驗室於 2025 年 5 月為 8 顯示卡 AMD Instinct™ MI350X/MI355X 平台所執行的計算,此計算以 NVIDIA HGX Blackwell B200 加速器平台作為對比,目的在於判斷使用 Matrix、Tensor、Vector 和 Sparsity(若適用)來比較 FP64、FP32、FP16、OCP-FP8、FP8、MXFP6、FP6、MXFP4、FP4 和 INT8 資料類型時的峰值理論精度效能。結果可能會因組態、資料類型和工作負載而有不同。MI350-010A

- AMD 效能實驗室於 2025 年 5 月 22 日根據當下的規格和/或評估進行的計算。AMD Instinct™ MI355X OAM 加速器擁有 288 GB HBM3e 記憶體容量和 8 TB/s 顯示卡峰值理論記憶體頻寬效能。NVIDIA Hopper H200 (141 GB) SXM 顯示卡加速器的最高已公佈結果為 141 GB HBM3e 記憶體容量和 4.8 TB/s 顯示卡記憶體頻寬效能:https://nvdam.widen.net/s/nb5zzzsjdf/hpc-datasheet-sc23-h200-datasheet-3002446。NVIDIA Blackwell HGX B200 (180 GB) 顯示卡加速器的最高已公佈結果為 180 GB HBM3e 記憶體容量和 7.7 TB/s 顯示卡記憶體頻寬效能:https://nvdam.widen.net/s/wwnsxrhm2w/blackwell-datasheet-3384703。NVIDIA Grace Blackwell GB200 (186 GB) 顯示卡加速器的最高已公佈結果為 186 GB HBM3e 記憶體容量和 8 TB/s 顯示卡記憶體頻寬效能:https://nvdam.widen.net/s/wwnsxrhm2w/blackwell-datasheet-3384703 MI350-001

- 根據 AMD 效能實驗室於 2025 年 5 月所執行的計算,此計算以 NVIDIA Blackwell B200 加速器作為對比,目的在於判斷使用向量、矩陣或 Tensor(若適用即採稀疏性)來比較 FP64、FP32、FP16、OCP-FP8、FP8、MXFP6、FP6、MXFP4、FP4、INT8 和 bfloat16 資料類型時,AMD Instinct™ MI350X/MI355X 顯示卡的峰值理論精度效能。伺服器製造商可能會改變配置,而得到不同的結果。MI350-009A

- 根據 AMD 效能實驗室於 2025 年 5 月所執行的計算,此計算以 NVIDIA Blackwell B200 加速器作為對比,目的在於判斷使用向量、矩陣或 Tensor(若適用)來比較 FP64 和 FP32 時,AMD Instinct™ MI350X / MI355X 顯示卡的峰值理論精度效能。結果可能會因伺服器組態、資料類型和工作負載而有不同。效能可能會因使用了最新驅動程式及最佳化而不同。MI350-019

- 根據 AMD 於 2025 年 4 月 17 日的計算,計算時所採用的記憶體規格,是根據當時 AMD Instinct MI350X/MI355X 顯示卡 (288 GB),以及比較對象 MI300X (192 GB) 和 MI325X (256 GB) 的已公佈資料。 計算之執行條件為,採用 F16 精度資料類型,每個參數 (2) 個位元組;計算之目標,是要確定執行下列 LLM 所需要的最少顯示卡數量(根據記憶體大小):OPT(1300 億個參數)、GPT-3(1750 億個參數)、BLOOM(1760 億個參數)、Gopher(2800 億個參數)、PaLM 1(3400 億個參數)、Generic LM(4200 億、5000 億、5200 億、1 兆 470 億個參數)、Megatron-LM(5300 億個參數)、LLaMA(4050 億個參數)和 Samba(1 兆個參數)。計算之結果,係在前述參數定義下,將顯示卡記憶大小與模型所需記憶體大小兩相比較後得出,此結果已另外納入了 10% 冗餘。伺服器製造商可能會改變配置,而得到不同的結果。結果可能會因顯示卡記憶體組態、LLM 大小,以及顯示卡記憶體存取或伺服器作業環境的潛在差異而有不同。*所有資料均基於 FP16 資料類型。換算倍率:FP8 = X2; 適FP4 = X4。MI350-012

- 根據 AMD 效能實驗室於 2025 年 5 月為 8 顯示卡 AMD Instinct™ MI350X/MI355X 平台所執行的計算,此計算以 NVIDIA HGX Blackwell B200 加速器平台作為對比,目的在於判斷使用 Matrix、Tensor、Vector 和 Sparsity(若適用)來比較 FP64、FP32、FP16、OCP-FP8、FP8、MXFP6、FP6、MXFP4、FP4 和 INT8 資料類型時的峰值理論精度效能。結果可能會因組態、資料類型和工作負載而有不同。MI350-010A