Aceleración líder de IA y HPC

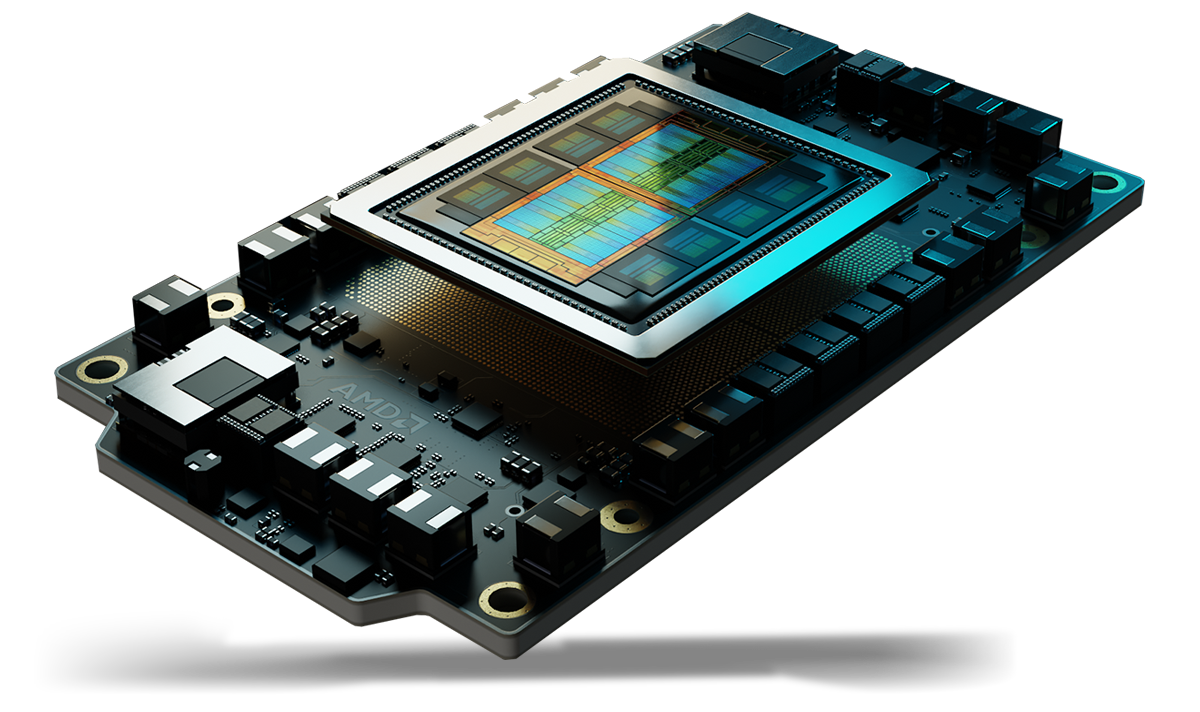

Las GPU AMD Instinct™ Serie MI350 establecen un nuevo estándar para la IA generativa y la HPC (high performance computing, computación de alto rendimiento) en los centros de datos. Desarrolladas con la nueva arquitectura avanzada AMD CDNA™ de 4.ª generación, estas GPU ofrecen una eficiencia y un rendimiento excepcionales para entrenamiento de modelos grandes de IA, inferencia de alta velocidad y cargas de trabajo complejas de HPC, como simulaciones científicas, procesamiento de datos y modelado computacional.

En segundo plano

El rendimiento definitivo de IA y HPC

Desarrolladas con la arquitectura avanzada AMD CDNA™ de 4.ª generación, las GPU AMD Instinct™ Serie MI350 cuentan con núcleos potentes y de bajo consumo energético, lo que maximiza el rendimiento por watt para impulsar la próxima era de innovación en IA y HPC.

Beneficios

- Aceleración de IA innovadora con memoria de gran capacidad

- Seguridad avanzada para IA y HPC

- Implementación y optimización de IA sin interrupciones

- Con la confianza de los líderes en IA

Aceleración de IA innovadora con memoria de gran capacidad

Las GPU AMD Instinct™ Serie MI350 redefinen la aceleración de la IA con compatibilidad con tipos de datos MXFP6 y MXFP4 de última generación, lo que optimiza la eficiencia, el ancho de banda y el consumo de energía para brindar una inferencia y un entrenamiento de la IA ultrarrápidos.

Diseñadas para impulsar el rendimiento de los modelos de IA más exigentes, las GPU Instinct MI350 cuentan con una gran capacidad de 288 GB de memoria HBM3E y un ancho de banda de 8 TB/s, lo que ofrece un gran salto en rendimiento respecto a las generaciones anteriores1.

Seguridad avanzada para IA y HPC

Las GPU AMD Instinct™ Serie MI350 garantizan un firmware confiable, verifican la integridad del hardware, permiten el uso compartido seguro de GPU de varios usuarios y cifrar la comunicación de GPU, lo que ayuda a mejorar la confiabilidad, la escalabilidad y la seguridad de los datos para la IA en la nube y las cargas de trabajo fundamentales.

Implementación y optimización de IA sin interrupciones

Las GPU AMD Instinct™ Serie MI350 permiten una adopción fluida con compatibilidad inmediata, mientras que el operador de GPU AMD simplifica la implementación y la configuración de cargas de trabajo en Kubernetes. Con tecnología de software abierto AMD ROCm™, los desarrolladores obtienen soporte desde el primer día para marcos y modelos de IA líderes de OpenAI, Meta, PyTorch, Hugging Face y más, lo que ayuda a garantizar una ejecución eficiente y de alto rendimiento sin dependencia del proveedor.

Con la confianza de los líderes en IA

Los líderes e innovadores de la industria confían en las GPU AMD Instinct™ para la IA a gran escala, las cuales potencian modelos como Llama 405B y GPT. La amplia adopción de GPU AMD Instinct por parte de CSP y OEM impulsa la IA de última generación a escala.

Conoce la Serie

Explora las GPU AMD Instinct Serie MI350 y las plataformas AMD Instinct Serie MI350.

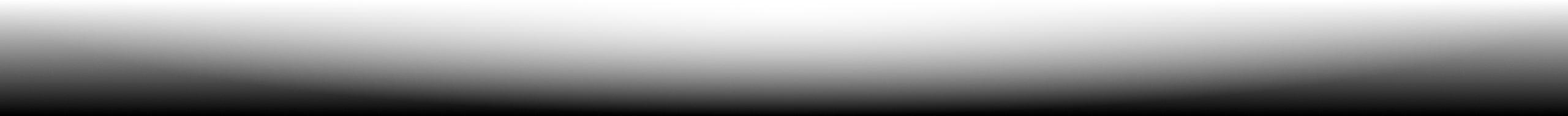

Conoce las GPU AMD Instinct™ Serie MI350

Desarrolladas con la arquitectura AMD CDNA™ de 4.ª generación, las GPU AMD Instinct™ Serie MI350 ofrecen una inferencia de IA, un entrenamiento y un rendimiento de carga de trabajo de HPC excepcionales con una memoria HBM3E de gran capacidad de 288 GB, un ancho de banda de 8 TB/s y compatibilidad con tipos de datos ampliados, incluidos MXFP6 y MXFP4.

256 CU

256 unidades de procesamiento de GPU

288 GB

Memoria HBM3E de 288 GB

8 TB/s

Ancho de banda de memoria teórico máximo de 8 TB/s

Comparaciones de especificaciones

- Rendimiento de AI

- Rendimiento HPC

- Memoria

Rendimiento de IA (PFLOPS máximos)

Hasta 2,2 veces el rendimiento de IA frente a los aceleradores de la competencia2

Tensor FP16/BF16, Matriz FP16/BF16

(Sparsity)

Tensor FP8, Matriz OCP-FP8

(Sparsity)

Tensor FP6, Matriz MXFP6

B200 SXM5 180 GB

MI355X OAM 288 GB

Rendimiento HPC (TFLOPS máximos)

Hasta 2,1 veces el rendimiento HPC frente a los aceleradores de la competencia3

B200 SXM5 180 GB

MI355X OAM 288 GB

Capacidad de memoria y ancho de banda

1,6 veces la capacidad de memoria frente a los aceleradores de la competencia1

B200 SXM5 180 GB

MI355X OAM 288 GB

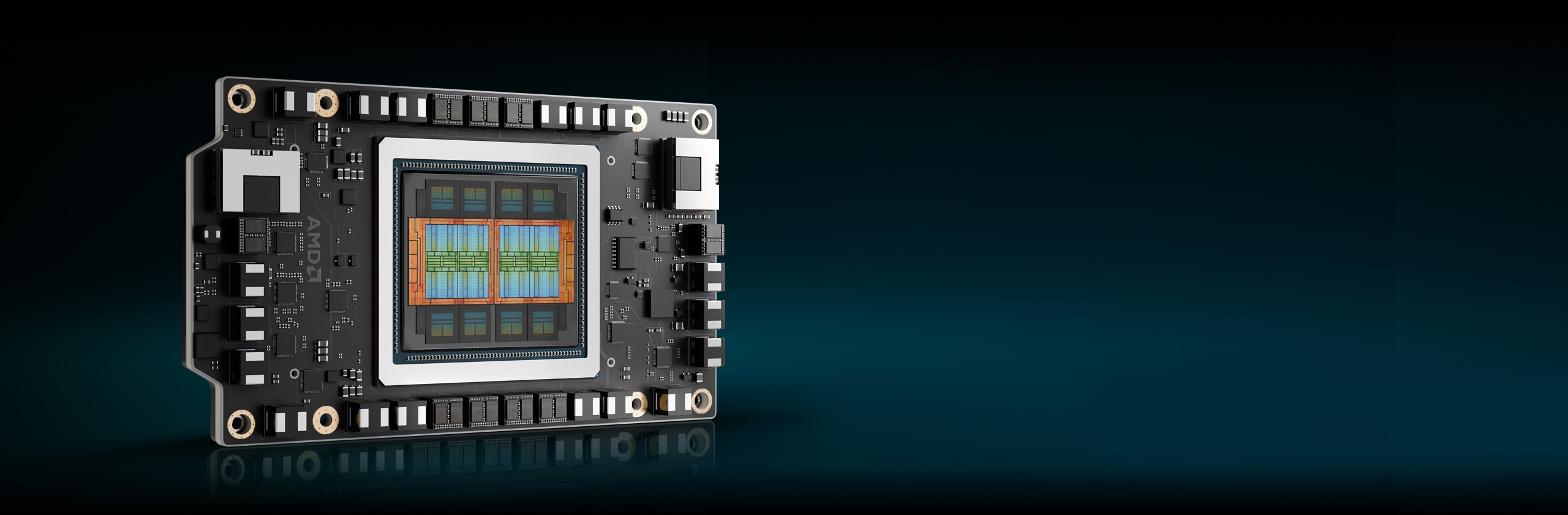

Plataformas AMD Instinct

Las plataformas AMD Instinct Serie MI350 integran 8 módulos OAM de GPU MI355X o MI350X completamente conectados en un diseño OCP estándar de la industria a través de la tecnología AMD Infinity Fabric™ de 4.ª generación, lo que proporciona una capacidad de memoria HBM3E de 2,3 TB líder en la industria para el procesamiento de IA de alto rendimiento. Estas plataformas listas para implementar ahora ofrecen compatibilidad con una variedad de sistemas, desde servidores basados en UBB con refrigeración por aire estándar hasta plataformas de DLC (direct liquid cooled, refrigeración líquida directa) ultradensa, lo que ayuda a acelerar el tiempo de comercialización y reducir los costos de desarrollo cuando se agregan GPU AMD Instinct Serie MI350 a las infraestructuras de servidores y rack de IA existentes.

8 GPU Serie MI350

Ocho (8) módulos OAM de GPU MI355X o MI350X

2,3 TB

2,3 TB totales de memoria HBM3E

64 TB/s

Ancho de banda de memoria de agregado teórico máximo de 64 TB/s

Software AMD ROCm™

El software AMD ROCm™ incluye un amplio conjunto de modelos de programación, herramientas, compiladores, bibliotecas y tiempos de ejecución para modelos de IA y cargas de trabajo de HPC dirigidos a GPU AMD Instinct.

Casos de Estudio

Encontrar soluciones

Experimenta las GPU AMD Instinct en la nube

Satisface tus necesidades de IA, HPC y desarrollo de software con programas respaldados por los principales proveedores de servicios en la nube.

Soluciones de servidores y socios de GPU AMD Instinct

AMD colabora con OEM (Original Equipment Manufacturer, fabricante de equipo original) y diseñadores de plataformas líderes para ofrecer un sólido ecosistema de soluciones con tecnología de GPU de AMD Instinct.

Recursos

Mantente informado

Regístrate para recibir las últimas novedades sobre centros de datos y contenido de servidores

Notas al pie

- Cálculos realizados por los laboratorios de rendimiento de AMD al 22 de mayo del 2025, con base en las especificaciones o estimaciones actuales. Los aceleradores AMD Instinct™ MI355X OAM tendrán una capacidad de 288 GB de memoria HBM3e y un rendimiento teórico máximo del ancho de banda de memoria de GPU de 8 TB/s. Los resultados más altos publicados sobre el acelerador de GPU Nvidia Hopper H200 (141 GB) SXM arrojaron como resultado 141 GB de capacidad de memoria HBM3e y 4,8 TB/s de rendimiento de ancho de banda de memoria de GPU. https://nvdam.widen.net/s/nb5zzzsjdf/hpc-datasheet-sc23-h200-datasheet-3002446. Los resultados más altos publicados sobre el acelerador de GPU Nvidia Blackwell HGX B200 (180 GB) arrojaron como resultado 180 GB de capacidad de memoria HBM3e y 7,7 TB/s de rendimiento de ancho de banda de memoria de GPU. https://nvdam.widen.net/s/wwnsxrhm2w/blackwell-datasheet-3384703. Los resultados más altos publicados sobre el acelerador de GPU Nvidia Grace Blackwell GB200 (186 GB) arrojaron como resultado 186 GB de capacidad de memoria HBM3e y 8 TB/s de rendimiento de ancho de banda de memoria de GPU. https://nvdam.widen.net/s/wwnsxrhm2w/blackwell-datasheet-3384703 MI350-001

- Basado en cálculos realizados por los laboratorios de rendimiento de AMD al mes de mayo del 2025 a fin de determinar el rendimiento de precisión teórica máxima para las GPU AMD Instinct™ MI350X/MI355X al comparar tipos de datos FP64, FP32, FP16, OCP-FP8, FP8, MXFP6, FP6, MXFP4, FP4, INT8 y bfloat16 con Vector, Matriz o Tensor con sparsity, según corresponda, frente al acelerador NVIDIA Blackwell B200. Los fabricantes de servidores pueden variar las configuraciones, lo que arroja resultados diferentes. MI350-009A

- Basado en cálculos realizados por los laboratorios de rendimiento de AMD al mes de mayo del 2025 a fin de determinar el rendimiento de precisión teórica máxima para las GPU AMD Instinct™ MI350X/MI355X al comparar FP64 y FP32 con Vector, Matriz o Tensor, según corresponda, frente al acelerador NVIDIA Blackwell B200. Los resultados pueden cambiar según la configuración del servidor, el tipo de datos y la carga de trabajo. El rendimiento puede cambiar según el uso de los controladores más recientes y las optimizaciones. MI350-019

- Basado en cálculos realizados por AMD al 17 de abril del 2025 utilizando las especificaciones de memoria publicadas de las GPU AMD Instinct MI350X/MI355X (288 GB) frente a MI300X (192 GB) frente a MI325X (256 GB). Cálculos realizados con el tipo de datos de precisión FP16 a (2) bytes por parámetro a fin de determinar la cantidad mínima de GPU (basado en el tamaño de la memoria) necesaria para ejecutar los siguientes LLM: OPT (130 000 millones de parámetros), GPT-3 (175 000 millones de parámetros), BLOOM (176 000 millones de parámetros), Gopher (280 000 millones de parámetros), PaLM 1 (340 000 millones de parámetros), ML genérico (420 000 millones, 500 000 millones, 520 000 millones, 1,047 billones de parámetros), Megatron-LM (530 000 millones de parámetros), LLaMA (405 000 millones de parámetros) y SAMBA (1 billón de parámetros). Resultados basados el tamaño de la memoria de GPU en comparación con la memoria requerida por el modelo en parámetros definidos más un 10 % de sobrecarga. Los fabricantes de servidores pueden variar las configuraciones, lo que arroja resultados diferentes. Los resultados pueden variar según la configuración de la memoria de la GPU, el tamaño del LLM y la variación potencial en el acceso a la memoria de la GPU o el entorno operativo del servidor. * Todos los datos se basan en el tipo de datos FP16. En el caso de FP8 = X2. En el caso de FP4 = X4. MI350-012

- Basado en cálculos realizados por los laboratorios de rendimiento de AMD el mes de mayo del 2025 para las 8 plataformas de GPU AMD Instinct™ MI350X/MI355X a fin de determinar el rendimiento de precisión teórica máxima al comparar tipos de datos FP64, FP32, FP16, OCP-FP8, FP8, MXFP6, FP6, MXFP4, FP4 y INT8 con Matriz, Tensor, Vector y sparsity, según corresponda frente a la plataforma del acelerador NVIDIA HGX Blackwell B200. Los resultados pueden cambiar según la configuración, el tipo de datos y la carga de trabajo. MI350-010A

- Cálculos realizados por los laboratorios de rendimiento de AMD al 22 de mayo del 2025, con base en las especificaciones o estimaciones actuales. Los aceleradores AMD Instinct™ MI355X OAM tendrán una capacidad de 288 GB de memoria HBM3e y un rendimiento teórico máximo del ancho de banda de memoria de GPU de 8 TB/s. Los resultados más altos publicados sobre el acelerador de GPU Nvidia Hopper H200 (141 GB) SXM arrojaron como resultado 141 GB de capacidad de memoria HBM3e y 4,8 TB/s de rendimiento de ancho de banda de memoria de GPU. https://nvdam.widen.net/s/nb5zzzsjdf/hpc-datasheet-sc23-h200-datasheet-3002446. Los resultados más altos publicados sobre el acelerador de GPU Nvidia Blackwell HGX B200 (180 GB) arrojaron como resultado 180 GB de capacidad de memoria HBM3e y 7,7 TB/s de rendimiento de ancho de banda de memoria de GPU. https://nvdam.widen.net/s/wwnsxrhm2w/blackwell-datasheet-3384703. Los resultados más altos publicados sobre el acelerador de GPU Nvidia Grace Blackwell GB200 (186 GB) arrojaron como resultado 186 GB de capacidad de memoria HBM3e y 8 TB/s de rendimiento de ancho de banda de memoria de GPU. https://nvdam.widen.net/s/wwnsxrhm2w/blackwell-datasheet-3384703 MI350-001

- Basado en cálculos realizados por los laboratorios de rendimiento de AMD al mes de mayo del 2025 a fin de determinar el rendimiento de precisión teórica máxima para las GPU AMD Instinct™ MI350X/MI355X al comparar tipos de datos FP64, FP32, FP16, OCP-FP8, FP8, MXFP6, FP6, MXFP4, FP4, INT8 y bfloat16 con Vector, Matriz o Tensor con sparsity, según corresponda, frente al acelerador NVIDIA Blackwell B200. Los fabricantes de servidores pueden variar las configuraciones, lo que arroja resultados diferentes. MI350-009A

- Basado en cálculos realizados por los laboratorios de rendimiento de AMD al mes de mayo del 2025 a fin de determinar el rendimiento de precisión teórica máxima para las GPU AMD Instinct™ MI350X/MI355X al comparar FP64 y FP32 con Vector, Matriz o Tensor, según corresponda, frente al acelerador NVIDIA Blackwell B200. Los resultados pueden cambiar según la configuración del servidor, el tipo de datos y la carga de trabajo. El rendimiento puede cambiar según el uso de los controladores más recientes y las optimizaciones. MI350-019

- Basado en cálculos realizados por AMD al 17 de abril del 2025 utilizando las especificaciones de memoria publicadas de las GPU AMD Instinct MI350X/MI355X (288 GB) frente a MI300X (192 GB) frente a MI325X (256 GB). Cálculos realizados con el tipo de datos de precisión FP16 a (2) bytes por parámetro a fin de determinar la cantidad mínima de GPU (basado en el tamaño de la memoria) necesaria para ejecutar los siguientes LLM: OPT (130 000 millones de parámetros), GPT-3 (175 000 millones de parámetros), BLOOM (176 000 millones de parámetros), Gopher (280 000 millones de parámetros), PaLM 1 (340 000 millones de parámetros), ML genérico (420 000 millones, 500 000 millones, 520 000 millones, 1,047 billones de parámetros), Megatron-LM (530 000 millones de parámetros), LLaMA (405 000 millones de parámetros) y SAMBA (1 billón de parámetros). Resultados basados el tamaño de la memoria de GPU en comparación con la memoria requerida por el modelo en parámetros definidos más un 10 % de sobrecarga. Los fabricantes de servidores pueden variar las configuraciones, lo que arroja resultados diferentes. Los resultados pueden variar según la configuración de la memoria de la GPU, el tamaño del LLM y la variación potencial en el acceso a la memoria de la GPU o el entorno operativo del servidor. * Todos los datos se basan en el tipo de datos FP16. En el caso de FP8 = X2. En el caso de FP4 = X4. MI350-012

- Basado en cálculos realizados por los laboratorios de rendimiento de AMD el mes de mayo del 2025 para las 8 plataformas de GPU AMD Instinct™ MI350X/MI355X a fin de determinar el rendimiento de precisión teórica máxima al comparar tipos de datos FP64, FP32, FP16, OCP-FP8, FP8, MXFP6, FP6, MXFP4, FP4 y INT8 con Matriz, Tensor, Vector y sparsity, según corresponda frente a la plataforma del acelerador NVIDIA HGX Blackwell B200. Los resultados pueden cambiar según la configuración, el tipo de datos y la carga de trabajo. MI350-010A