A pilha de software de IA mais avançada da AMD

Últimos algoritmos e modelos

Raciocínio avançado, algoritmos de atenção e MoE esparso para maior eficiência

Suporte à AMD Instinct™ Série MI350

Arquitetura AMD CDNA 4 com suporte a novos tipos de dados e HBM avançado

Recursos avançados para dimensionar a IA em escala

Inferência distribuída contínua, treinamento MoE e aprendizado por reforço em escala

Ferramentas de IA prontas para empresas

Implante e gerencie a IA entre clusters com orquestração e suporte para endpoints

IA no endpoint

Do Ryzen™ AI às placas de vídeo Radeon™: obtenha um processador de IA de endpoint para qualquer aplicação

Salto geracional em desempenho

ROCm 7 vs. ROCm 6

Inferência¹

Treinamento²

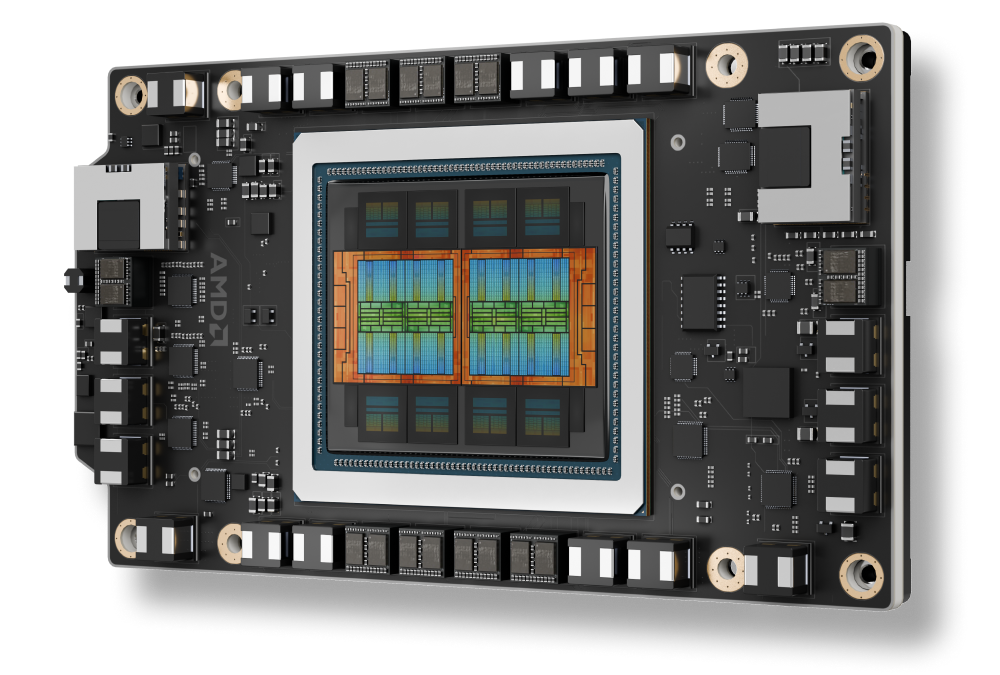

Suporte à AMD Instinct™ Série MI350

Alimentando as GPUs AMD Instinct™ Série MI350

Integração otimizada com plataformas AMD Instinct MI350X, com infraestrutura de rack aberto para implantação rápida e desempenho otimizado de IA em escala.

Dimensionando a IA empresarial em escala

Inferência distribuída com ecossistema aberto

Com vLLM-d, DeepEP, SGLang e acesso direto à GPU, a plataforma ROCm proporciona a maior taxa de produtividade em escala de rack em lotes, nós e modelos.

ROCm para o ciclo de vida da IA

O software ROCm integra-se a estruturas de IA empresarial para oferecer um fluxo de trabalho totalmente aberto e completo para IA de produção, abrangendo o gerenciamento de cluster ROCm Enterprise AI e ROCm para facilitar a implantação e a escalabilidade contínuas.

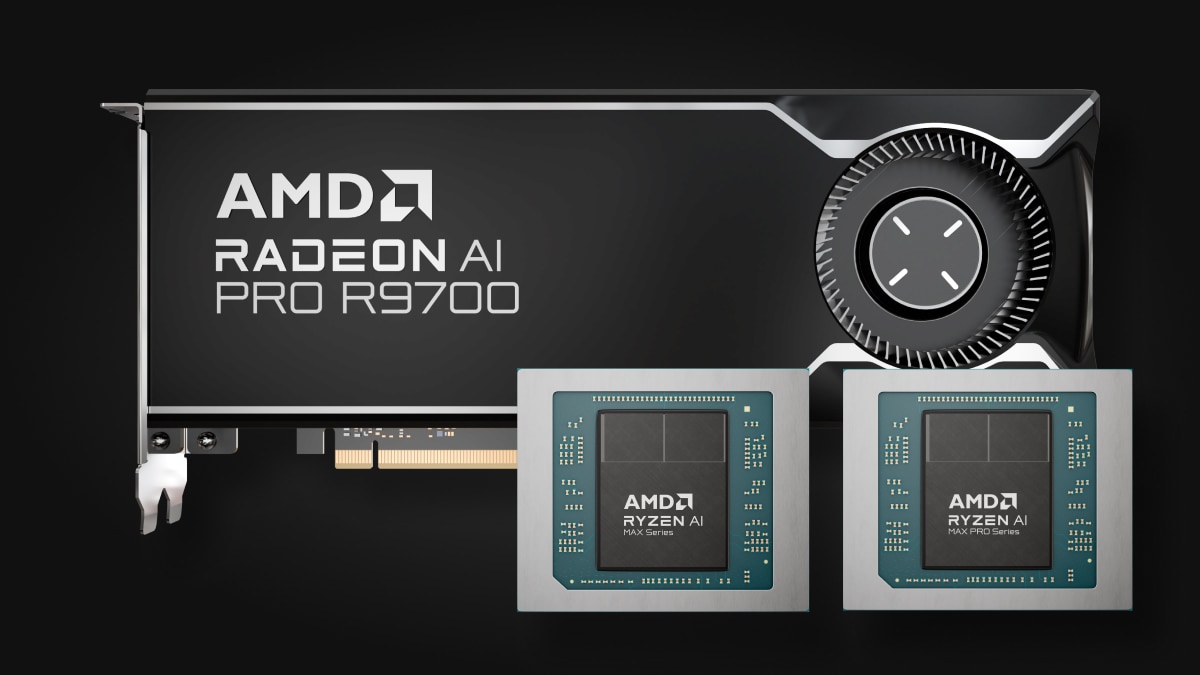

IA no endpoint

Expansão do ecossistema ROCm no processador AMD Ryzen™ AI e na placa de vídeo AMD Radeon™

O ecossistema de IA de endpoint ROCm é alimentado pela eficiente plataforma de criação TheROCK de código aberto, com lançamentos noturnos de ROCm e PyTorch. Oferecendo compatibilidade para ambas as plataformas Linux e Windows, esse sistema atende aos mais recentes produtos Radeon RX 9000 e Ryzen AI Max, oferecendo uma base sólida para o desenvolvimento e a implantação de IA de forma ininterrupta.

Uma prévia do PyTorch agora está disponível: Compatibilidade com Linux para AMD Ryzen™ AI Série 300* e Ryzen AI Série Max, e compatibilidade com Windows para AMD Ryzen™ AI Série 300*, Ryzen AI Série Max e todas as AMD Radeon™ RX 7000 e Radeon Série W7000 (e mais recentes).

*Para obter uma lista completa dos produtos compatíveis, acesse a nossa página de matriz de compatibilidade.

Comece hoje mesmo

Acelere suas tarefas de IA/ML, computação de alto desempenho e análise de dados com o AMD Developer Cloud.

Fique por dentro

Fique por dentro das últimas novidades do ROCm.

Notas de rodapé

- MI300-080 – Testes realizados pelo AMD Performance Labs em 15 de maio de 2025, medindo o desempenho de inferência em tokens por segundo (TPS) do software AMD ROCm 6.x, vLLM 0.3.3 vs. versão de teste do software AMD ROCm 7.0, vLLM 0.8.5 em um sistema com (8) GPUs AMD Instinct MI300X executando os modelos Llama 3.1-70B (TP2), Qwen 72B (TP2) e Deepseek-R1 (FP16) com tamanhos de lote de 1-256 e comprimentos de sequência de 128-204. A melhoria do desempenho declarado é expresso como a média de TPS nos (3) LLMs testados.

Configuração de hardwareServidor de CPU AMD EPYC ™ 9534 1P com 8 GPUs AMD Instinct™ MI300X (192 GB, 750 W), Supermicro AS-8125GS-TNMR2, NPS1 (1 NUMA por soquete), 1,5 TiB (24 DIMMs, 4800 mts de memória, 64 GiB/DIMM), 4x 3,49 TB de armazenamento micron 7450, versão de BIOS: 1,8

Configurações de software

Ubuntu 22.04 LTS com kernel Linux 5.15.0‑119‑generic

Qwen 72B e Llama 3.1‑70B -

Software AMD ROCm 7.0 (versão de teste)

PyTorch 2.7.0. DeepSeek R-1 – ROCm 7.0 versão de teste, SGLang 0.4.6, PyTorch 2.6.0

em comparação com

Qwen 72 e Llama 3.1‑70B – Software ROCm 6.x (GA)

PyTorch 2.7.0 e 2.1.1, respectivamente,

DeepSeek R‑1: ROCm 6.x (GA) SW

SGLang 0.4.1, PyTorch 2.5.0

Os fabricantes de servidores podem variar as configurações, gerando resultados diferentes. O desempenho pode variar conforme a configuração, o software, a versão do vLLM e o uso dos drivers e otimizações mais recentes.

- MI300‑081 – Teste conduzido pelos AMD Performance Labs em 15 de maio de 2025 para medir o desempenho de treinamento (TFLOPS) da versão de teste do software ROCm 7.0, com Megatron‑LM, em (8) GPUs AMD Instinct MI300X, executando os modelos Llama 2‑70B (4K), Qwen1.5‑14B e Llama 3.1‑8B em um contêiner Docker personalizado, comparado a um sistema similar com o software AMD ROCm 6.0.

Configuração de hardware

CPU 1P AMD EPYC™ 9454, 8 GPUs AMD Instinct MI300X (192 GB, 750 W), versão do BIOS do American Megatrends International LLC: Versão 1.8, BIOS 1.8.

Configuração de software

Ubuntu 22.04 LTS com kernel Linux 5.15.0‑70‑generic

ROCm 7.0, Megatron‑LM, PyTorch 2.7.0

em comparação com

Lançamento público do ROCm 6.0 com suporte de software, incluindo Megatron‑LM com os seguintes branches de código: hanl/disable_te_llama2 para o modelo Llama 2‑7B, guihong_dev para o modelo Llama 2‑70B, renwuli/disable_te_qwen1.5 para o modelo Qwen1.5‑14B, PyTorch 2.2.

Os fabricantes de servidores podem variar as configurações, gerando resultados diferentes. O desempenho pode variar conforme a configuração, o software, a versão do vLLM e o uso dos drivers e otimizações mais recentes.

- MI300-080 – Testes realizados pelo AMD Performance Labs em 15 de maio de 2025, medindo o desempenho de inferência em tokens por segundo (TPS) do software AMD ROCm 6.x, vLLM 0.3.3 vs. versão de teste do software AMD ROCm 7.0, vLLM 0.8.5 em um sistema com (8) GPUs AMD Instinct MI300X executando os modelos Llama 3.1-70B (TP2), Qwen 72B (TP2) e Deepseek-R1 (FP16) com tamanhos de lote de 1-256 e comprimentos de sequência de 128-204. A melhoria do desempenho declarado é expresso como a média de TPS nos (3) LLMs testados.

Configuração de hardwareServidor de CPU AMD EPYC ™ 9534 1P com 8 GPUs AMD Instinct™ MI300X (192 GB, 750 W), Supermicro AS-8125GS-TNMR2, NPS1 (1 NUMA por soquete), 1,5 TiB (24 DIMMs, 4800 mts de memória, 64 GiB/DIMM), 4x 3,49 TB de armazenamento micron 7450, versão de BIOS: 1,8

Configurações de software

Ubuntu 22.04 LTS com kernel Linux 5.15.0‑119‑generic

Qwen 72B e Llama 3.1‑70B -

Software AMD ROCm 7.0 (versão de teste)

PyTorch 2.7.0. DeepSeek R-1 – ROCm 7.0 versão de teste, SGLang 0.4.6, PyTorch 2.6.0

em comparação com

Qwen 72 e Llama 3.1‑70B – Software ROCm 6.x (GA)

PyTorch 2.7.0 e 2.1.1, respectivamente,

DeepSeek R‑1: ROCm 6.x (GA) SW

SGLang 0.4.1, PyTorch 2.5.0

Os fabricantes de servidores podem variar as configurações, gerando resultados diferentes. O desempenho pode variar conforme a configuração, o software, a versão do vLLM e o uso dos drivers e otimizações mais recentes.

- MI300‑081 – Teste conduzido pelos AMD Performance Labs em 15 de maio de 2025 para medir o desempenho de treinamento (TFLOPS) da versão de teste do software ROCm 7.0, com Megatron‑LM, em (8) GPUs AMD Instinct MI300X, executando os modelos Llama 2‑70B (4K), Qwen1.5‑14B e Llama 3.1‑8B em um contêiner Docker personalizado, comparado a um sistema similar com o software AMD ROCm 6.0.

Configuração de hardware

CPU 1P AMD EPYC™ 9454, 8 GPUs AMD Instinct MI300X (192 GB, 750 W), versão do BIOS do American Megatrends International LLC: Versão 1.8, BIOS 1.8.

Configuração de software

Ubuntu 22.04 LTS com kernel Linux 5.15.0‑70‑generic

ROCm 7.0, Megatron‑LM, PyTorch 2.7.0

em comparação com

Lançamento público do ROCm 6.0 com suporte de software, incluindo Megatron‑LM com os seguintes branches de código: hanl/disable_te_llama2 para o modelo Llama 2‑7B, guihong_dev para o modelo Llama 2‑70B, renwuli/disable_te_qwen1.5 para o modelo Qwen1.5‑14B, PyTorch 2.2.

Os fabricantes de servidores podem variar as configurações, gerando resultados diferentes. O desempenho pode variar conforme a configuração, o software, a versão do vLLM e o uso dos drivers e otimizações mais recentes.