가장 진보된 AMD AI 소프트웨어 스택

최신 알고리즘 및 모델

추론 향상, 주의 알고리즘, 희소 MOE를 통한 효율성 개선

AMD Instinct™ MI350 시리즈 지원

AMD CDNA 4 아키텍처, 고급 HBM으로 새로운 데이터 유형 지원

AI 확장을 위한 고급 기능

원활한 분산 추론, MoE 학습, 대규모 강화 학습

엔터프라이즈급 AI 도구

오케스트레이션 및 엔드포인트 지원을 통해 클러스터 전반에서 AI 배포 및 관리

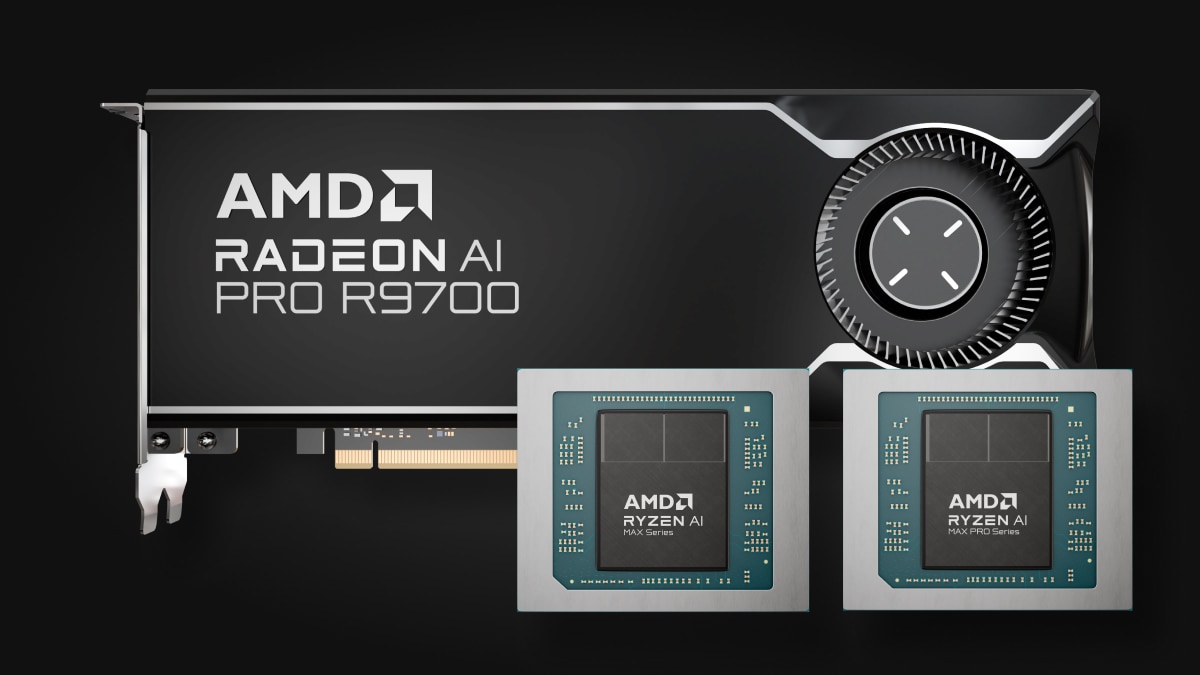

엔드포인트의 AI

Ryzen™ AI에서 Radeon™ 그래픽에 이르기까지 모든 분야를 위한 다목적 엔드포인트 AI 프로세서

세대 간 성능 도약

ROCm 7 및 ROCm 6 비교

추론¹

학습²

AMD Instinct™ MI350 시리즈 지원

AMD Instinct™ MI350 시리즈 GPU 강화

AMD Instinct MI350X 플랫폼과 오픈 랙 인프라의 원활한 통합을 강화하여 신속한 배포와 대규모 AI 성능 최적화를 지원합니다.

엔터프라이즈 AI 확장

개방형 생태계를 통한 분산 추론

ROCm 소프트웨어 플랫폼은 vLLM-d, DeepEP, SGLang, GPU 직접 액세스를 통해 배치, 노드, 모델 전반에 걸쳐 랙 스케일에서 최고의 처리량을 제공합니다.

AI 수명 주기를 위한 ROCm

ROCm 소프트웨어는 엔터프라이즈 AI 프레임워크와 통합되어 ROCm 엔터프라이즈 AI 및 ROCm 클러스터 관리를 포함하는 프로덕션 AI를 위한 포괄적인 완전 오픈 소스 워크플로를 제공함으로써 원활한 배포와 확장성을 지원합니다.

엔드포인트의 AI

AMD Ryzen™ AI 프로세서 및 AMD Radeon™ 그래픽 전반에 걸친 ROCm 생태계 확장

ROCm 엔드포인트 AI 생태계는 효율적인 오픈 소스 TheROCK 빌드 플랫폼으로 구동되며, ROCm과 PyTorch의 야간 릴리스를 지원합니다. 이제 Linux와 Windows를 모두 지원하는 이 시스템은 최신 Radeon RX 9000 시리즈와 선도적인 Ryzen AI Max 제품을 지원하여 원활한 AI 개발 및 배포를 위한 견고한 기반을 제공합니다.

PyTorch 프리뷰 사용 가능: AMD Ryzen™ AI 300 시리즈* 및 Ryzen AI Max 시리즈에 대한 Linux 지원, AMD Ryzen AI 300 시리즈*, Ryzen AI Max 시리즈, 모든 AMD Radeon™ RX 7000 및 Radeon W7000 시리즈(이상)에 대한 Windows 지원.

*지원되는 제품의 전체 목록은 호환성 매트릭스 페이지를 참조하세요.

지금 시작하기

AMD 개발자 클라우드를 통해 AI/ML, 고성능 컴퓨팅, 데이터 분석 작업을 가속화하세요.

새로운 정보를 놓치지 마세요

최신 ROCm 소식으로 새로운 정보를 놓치지 마세요.

각주

- MI300-080 -테스트는 2025년 5월 15일 AMD 퍼포먼스 랩이 시스템(Llama 3.1-70B(TP2)를 실행하는 AMD Instinct MI300X GPU 8대, Qwen 72B(TP2), Deepseek-R1(FP16) 모델)에서 배치 크기 1~256, 시퀀스 길이 128~204에 걸쳐 AMD ROCm 6.x 소프트웨어, vLLM 0.3.3 및 AMD ROCm 7.0 프리뷰 버전 SW, vLLM 0.8.5의 초당 토큰(TPS) 추론 성능을 비교 측정하여 수행되었습니다. 명시된 성능 향상은 테스트된 3개의 LLM에 대한 평균 TPS로 표시됩니다.

하드웨어 구성8x AMD Instinct™ MI300X(192GB, 750W) GPU가 탑재된 1P AMD EPYC™ 9534 CPU 서버, Supermicro AS-8125GS-TNMR2, NPS1(소켓당 1 NUMA), 1.5 TiB(24 DIMMs, 4800mts 메모리, 64GiB/DIMM), 4x 3.49TB Micron 7450 스토리지, BIOS 버전: 1.8

소프트웨어 구성

Ubuntu 22.04 LTS, Linux 커널 5.15.0-119-generic

Qwen 72B 및 Llama 3.1-70B -

ROCm 7.0 프리뷰 버전 SW

PyTorch 2.7.0. Deepseek R-1 - ROCm 7.0 프리뷰 버전, SGLang 0.4.6, PyTorch 2.6.0

vs.

Qwen 72 및 Llama 3.1-70B - ROCm 6.x GA SW

PyTorch 2.7.0 및 2.1.1(각각),

Deepseek R-1: ROCm 6.x GA SW

SGLang 0.4.1, PyTorch 2.5.0

서버 제조업체별 구성에 따라 다른 결과가 나올 수 있습니다. 성능은 구성, 소프트웨어, vLLM 버전, 최신 드라이버 및 최적화 사용 여부에 따라 달라질 수 있습니다.

- MI300-081 - 테스트는 2025년 5월 15일 AMD 퍼포먼스 랩에서 ROCm 7.0 프리뷰 버전 소프트웨어, Megatron-LM의 학습 성능(TFLOPS)을 측정하기 위해 Llama 2-70B (4K), Qwen1.5-14B, Llama3.1-8B 모델을 실행하는 8대의 AMD Instinct MI300X GPU와 맞춤형 도커 컨테이너를 사용하여 유사하게 구성된 AMD ROCm 6.0 소프트웨어 탑재 시스템과 비교했습니다.

하드웨어 구성

1P AMD EPYC™ 9454 CPU, 8대의 AMD Instinct MI300X(192GB, 750W) GPU, American Megatrends International LLC BIOS 버전: 1.8, BIOS 1.8.

소프트웨어 구성

Ubuntu 22.04 LTS, Linux 커널 5.15.0-70-generic

ROCm 7.0., Megatron-LM, PyTorch 2.7.0

vs.

ROCm 6.0 공개 릴리스 SW, Megatron-LM code branches hanl/disable_te_llama2 for Llama 2-7B, guihong_dev for LLama 2-70B, renwuli/disable_te_qwen1.5 for Qwen1.5-14B, PyTorch 2.2.

서버 제조업체별 구성에 따라 다른 결과가 나올 수 있습니다. 성능은 구성, 소프트웨어, vLLM 버전, 최신 드라이버 및 최적화 사용 여부에 따라 달라질 수 있습니다.

- MI300-080 -테스트는 2025년 5월 15일 AMD 퍼포먼스 랩이 시스템(Llama 3.1-70B(TP2)를 실행하는 AMD Instinct MI300X GPU 8대, Qwen 72B(TP2), Deepseek-R1(FP16) 모델)에서 배치 크기 1~256, 시퀀스 길이 128~204에 걸쳐 AMD ROCm 6.x 소프트웨어, vLLM 0.3.3 및 AMD ROCm 7.0 프리뷰 버전 SW, vLLM 0.8.5의 초당 토큰(TPS) 추론 성능을 비교 측정하여 수행되었습니다. 명시된 성능 향상은 테스트된 3개의 LLM에 대한 평균 TPS로 표시됩니다.

하드웨어 구성8x AMD Instinct™ MI300X(192GB, 750W) GPU가 탑재된 1P AMD EPYC™ 9534 CPU 서버, Supermicro AS-8125GS-TNMR2, NPS1(소켓당 1 NUMA), 1.5 TiB(24 DIMMs, 4800mts 메모리, 64GiB/DIMM), 4x 3.49TB Micron 7450 스토리지, BIOS 버전: 1.8

소프트웨어 구성

Ubuntu 22.04 LTS, Linux 커널 5.15.0-119-generic

Qwen 72B 및 Llama 3.1-70B -

ROCm 7.0 프리뷰 버전 SW

PyTorch 2.7.0. Deepseek R-1 - ROCm 7.0 프리뷰 버전, SGLang 0.4.6, PyTorch 2.6.0

vs.

Qwen 72 및 Llama 3.1-70B - ROCm 6.x GA SW

PyTorch 2.7.0 및 2.1.1(각각),

Deepseek R-1: ROCm 6.x GA SW

SGLang 0.4.1, PyTorch 2.5.0

서버 제조업체별 구성에 따라 다른 결과가 나올 수 있습니다. 성능은 구성, 소프트웨어, vLLM 버전, 최신 드라이버 및 최적화 사용 여부에 따라 달라질 수 있습니다.

- MI300-081 - 테스트는 2025년 5월 15일 AMD 퍼포먼스 랩에서 ROCm 7.0 프리뷰 버전 소프트웨어, Megatron-LM의 학습 성능(TFLOPS)을 측정하기 위해 Llama 2-70B (4K), Qwen1.5-14B, Llama3.1-8B 모델을 실행하는 8대의 AMD Instinct MI300X GPU와 맞춤형 도커 컨테이너를 사용하여 유사하게 구성된 AMD ROCm 6.0 소프트웨어 탑재 시스템과 비교했습니다.

하드웨어 구성

1P AMD EPYC™ 9454 CPU, 8대의 AMD Instinct MI300X(192GB, 750W) GPU, American Megatrends International LLC BIOS 버전: 1.8, BIOS 1.8.

소프트웨어 구성

Ubuntu 22.04 LTS, Linux 커널 5.15.0-70-generic

ROCm 7.0., Megatron-LM, PyTorch 2.7.0

vs.

ROCm 6.0 공개 릴리스 SW, Megatron-LM code branches hanl/disable_te_llama2 for Llama 2-7B, guihong_dev for LLama 2-70B, renwuli/disable_te_qwen1.5 for Qwen1.5-14B, PyTorch 2.2.

서버 제조업체별 구성에 따라 다른 결과가 나올 수 있습니다. 성능은 구성, 소프트웨어, vLLM 버전, 최신 드라이버 및 최적화 사용 여부에 따라 달라질 수 있습니다.