最先進的 AMD AI 軟體堆疊

最新的演算法和模型

增強推理、注意力演算法和稀疏 MoE 以提升效率

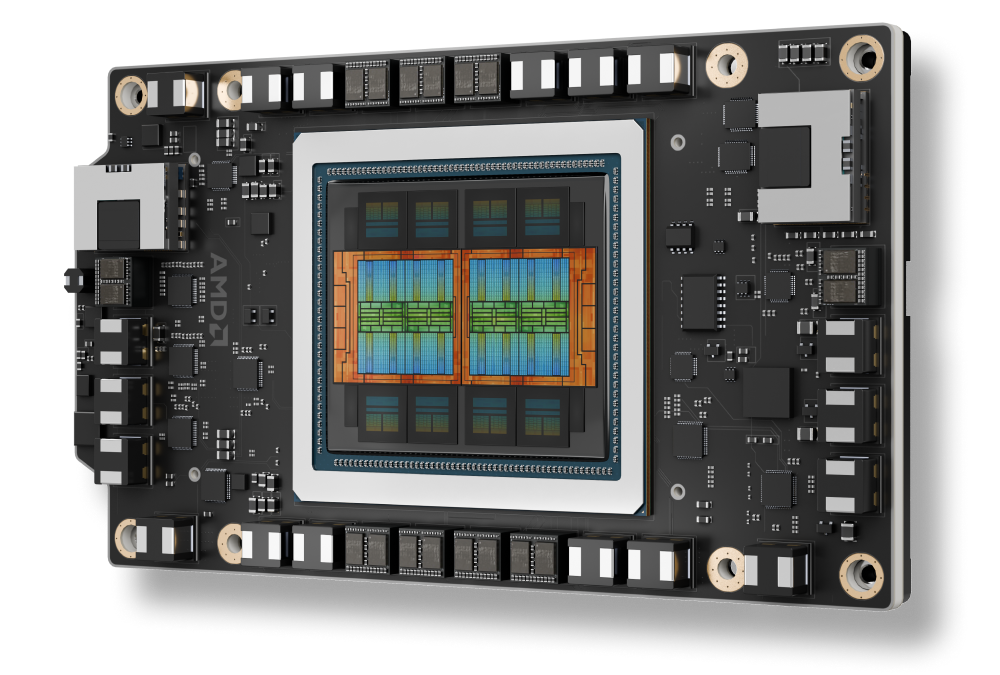

AMD Instinct™ MI350 系列支援

AMD CDNA 4 架構,以先進 HBM 支援新資料類型

促進 AI 擴充的先進功能

流暢且大規模地推動分散式推論、MoE 訓練、強化學習等

企業級 AI 工具

透過協調調度和端點支援,在各個叢集中部署和管理 AI

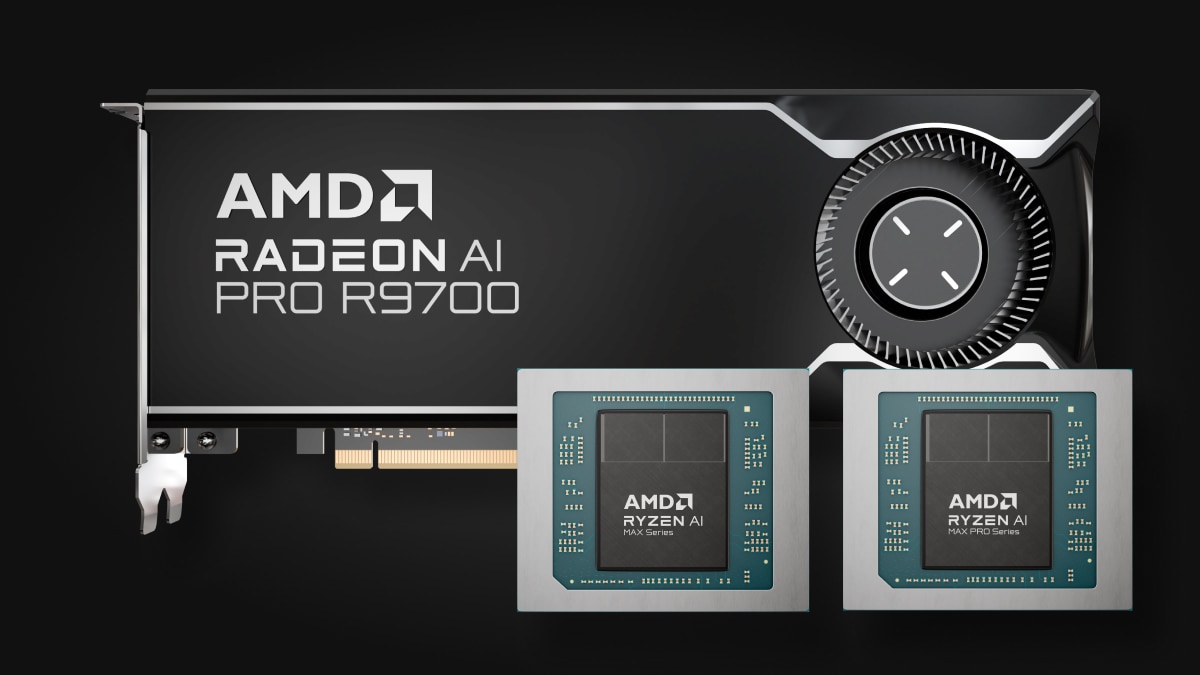

端點 AI

從 Ryzen™ AI 到 Radeon™ 顯示卡 — 適用於任何應用的多功能端點 AI 處理器

效能的世代躍進

ROCm 7 對比 ROCm 6

推論¹

訓練²

AMD Instinct™ MI350 系列支援

支援 AMD Instinct™ MI350 系列顯示卡

透過開放式機架基礎架構,增強 AMD Instinct MI350X 平台的緊密整合,實現大規模的快速部署與最佳化 AI 效能。

擴充企業 AI

採用開放式生態系統的分散式推論

藉由 vLLM-d、DeepEP、SGLang 和顯示卡直接存取,ROCm 軟體平台能跨越批次、節點與型號的藩籬,以機架規模實現最高的傳輸量。

為全 AI 生命週期打造的 ROCm

ROCm 軟體與企業 AI 架構整合,為投產級 AI 提供端對端的完全開放原始碼工作流程,包括有助於流暢部署與擴充的 ROCm Enterprise AI 和 ROCm 叢集管理。

端點處的 AI

將 ROCm 生態系統擴大至 AMD Ryzen™ AI 處理器與 AMD Radeon™ 顯示卡

ROCm 端點 AI 生態系統採用高效率的開放原始碼 TheROCK 建置平台,每晚推出新的 ROCm 和 PyTorch 版本。這套系統現在同時支援 Linux 和 Windows,可配合最新的 Radeon RX 9000 系列和領先的 Ryzen AI Max 產品,為順暢的 AI 開發和部署提供穩健的基礎。

歡迎搶先體驗 PyTorch 預覽版:Linux 平台方面,支援 AMD Ryzen™ AI 300 系列* 及 Ryzen AI Max 系列;Windows 平台方面,支援 AMD Ryzen AI 300 系列*、Ryzen AI Max 系列,以及 AMD Radeon™ RX 7000 和 Radeon W7000 系列(以及更新系列)所有型號。

*如需完整的產品支援清單,請造訪我們的相容性對照表頁面。

立即開始使用

透過 AMD Developer Cloud,加速您的 AI/機器學習、高效能運算和資料分析工作。

掌握最新動態

掌握 ROCm 的最新消息。

尾註

- MI300-080 - 根據 AMD 效能實驗室於 2025 年 5 月 15 日所做的測試,以每秒符元數 (TPS) 測量並比較 AMD ROCm 6.x 軟體採用 vLLM 0.3.3,以及 AMD ROCm 7.0 預覽版軟體採用 vLLM 0.8.5 的推論效能,平台系統搭載了八 (8) 個 AMD Instinct MI300X 顯示卡,執行了 Llama 3.1-70B (TP2)、Qwen 72B (TP2) 與 DeepSeek-R1 (FP16) 模型,批次大小為 1-256,序列長度為 128-204。正文所述效能提升倍率是採計平均值,也就是這三 (3) 組 LLM 測試各自的平均 TPS 結果。

硬體配置單路 AMD EPYC™ 9534 處理器伺服器,搭載 8x AMD Instinct™ MI300X (192GB, 750W) 顯示卡、Supermicro AS-8125GS-TNMR2、NPS1(每插槽 1 個 NUMA)、1.5 TiB 記憶體(24 DIMM,4800 mts,64 GiB/DIMM)、4x 3.49TB Micron 7450 儲存裝置、BIOS 版本:1.8

軟體配置

Ubuntu 22.04 LTS,搭配 Linux 內核 5.15.0-119-generic 版

Qwen 72B 和 Llama 3.1-70B -

ROCm 7.0 預覽版軟體

PyTorch 2.7.0。DeepSeek R-1 - ROCm 7.0 預覽版、SGLang 0.4.6、PyTorch 2.6.0

對比

Qwen 72 與 Llama 3.1-70B - ROCm 6.x GA 軟體

分別為 PyTorch 2.7.0 和 2.1.1

DeepSeek R-1:ROCm 6.x GA 軟體

SGLang 0.4.1、PyTorch 2.5.0

伺服器製造商可能會改變配置,而得到不同的結果。效能可能會因配置、軟體、vLLM 版本,以及使用最新驅動程式和最佳化功能而異。

- MI300-081 - 根據 AMD 效能實驗室於 2025 年 5 月 15 日進行的測試,測量 ROCm 7.0 預覽版軟體採用 Megatron-LM 的訓練效能 (TFLOPS),測試平台搭載了八 (8) 個 AMD Instinct MI300X 顯示卡,執行了 Llama 2-70B (4K)、Qwen1.5-14B 與 Llama3.1-8B 模型,並且採用了自訂的 Docker 容器,對比使用 AMD ROCm 6.0 軟體的相似配置系統。

硬體配置

單路 AMD EPYC™ 9454 處理器、8x AMD Instinct MI300X(192 GB,750 W)顯示卡、American Megatrends International LLC BIOS 版本:1.8,BIOS 1.8。

軟體配置

Ubuntu 22.04 LTS,搭配 Linux 內核 5.15.0-70-generic 版

ROCm 7.0.、Megatron-LM、PyTorch 2.7.0

對比

ROCm 6.0 公開版軟體,Megatron-LM 程式碼分支包含 Llama 2-7B 的 hanl/disable_te_llama2、LLama 2-70B 的 guihong_dev、Qwen1.5-14B 的 renwuli/disable_te_qwen1.5,以及 PyTorch 2.2。

伺服器製造商可能會改變配置,而得到不同的結果。效能可能會因配置、軟體、vLLM 版本,以及使用最新驅動程式和最佳化功能而異。

- MI300-080 - 根據 AMD 效能實驗室於 2025 年 5 月 15 日所做的測試,以每秒符元數 (TPS) 測量並比較 AMD ROCm 6.x 軟體採用 vLLM 0.3.3,以及 AMD ROCm 7.0 預覽版軟體採用 vLLM 0.8.5 的推論效能,平台系統搭載了八 (8) 個 AMD Instinct MI300X 顯示卡,執行了 Llama 3.1-70B (TP2)、Qwen 72B (TP2) 與 DeepSeek-R1 (FP16) 模型,批次大小為 1-256,序列長度為 128-204。正文所述效能提升倍率是採計平均值,也就是這三 (3) 組 LLM 測試各自的平均 TPS 結果。

硬體配置單路 AMD EPYC™ 9534 處理器伺服器,搭載 8x AMD Instinct™ MI300X (192GB, 750W) 顯示卡、Supermicro AS-8125GS-TNMR2、NPS1(每插槽 1 個 NUMA)、1.5 TiB 記憶體(24 DIMM,4800 mts,64 GiB/DIMM)、4x 3.49TB Micron 7450 儲存裝置、BIOS 版本:1.8

軟體配置

Ubuntu 22.04 LTS,搭配 Linux 內核 5.15.0-119-generic 版

Qwen 72B 和 Llama 3.1-70B -

ROCm 7.0 預覽版軟體

PyTorch 2.7.0。DeepSeek R-1 - ROCm 7.0 預覽版、SGLang 0.4.6、PyTorch 2.6.0

對比

Qwen 72 與 Llama 3.1-70B - ROCm 6.x GA 軟體

分別為 PyTorch 2.7.0 和 2.1.1

DeepSeek R-1:ROCm 6.x GA 軟體

SGLang 0.4.1、PyTorch 2.5.0

伺服器製造商可能會改變配置,而得到不同的結果。效能可能會因配置、軟體、vLLM 版本,以及使用最新驅動程式和最佳化功能而異。

- MI300-081 - 根據 AMD 效能實驗室於 2025 年 5 月 15 日進行的測試,測量 ROCm 7.0 預覽版軟體採用 Megatron-LM 的訓練效能 (TFLOPS),測試平台搭載了八 (8) 個 AMD Instinct MI300X 顯示卡,執行了 Llama 2-70B (4K)、Qwen1.5-14B 與 Llama3.1-8B 模型,並且採用了自訂的 Docker 容器,對比使用 AMD ROCm 6.0 軟體的相似配置系統。

硬體配置

單路 AMD EPYC™ 9454 處理器、8x AMD Instinct MI300X(192 GB,750 W)顯示卡、American Megatrends International LLC BIOS 版本:1.8,BIOS 1.8。

軟體配置

Ubuntu 22.04 LTS,搭配 Linux 內核 5.15.0-70-generic 版

ROCm 7.0.、Megatron-LM、PyTorch 2.7.0

對比

ROCm 6.0 公開版軟體,Megatron-LM 程式碼分支包含 Llama 2-7B 的 hanl/disable_te_llama2、LLama 2-70B 的 guihong_dev、Qwen1.5-14B 的 renwuli/disable_te_qwen1.5,以及 PyTorch 2.2。

伺服器製造商可能會改變配置,而得到不同的結果。效能可能會因配置、軟體、vLLM 版本,以及使用最新驅動程式和最佳化功能而異。