La pile software d'IA AMD la plus avancée

Derniers algorithmes et modèles

Raisonnement amélioré, algorithmes d'attention et MoE parcimonieux pour une meilleure efficacité

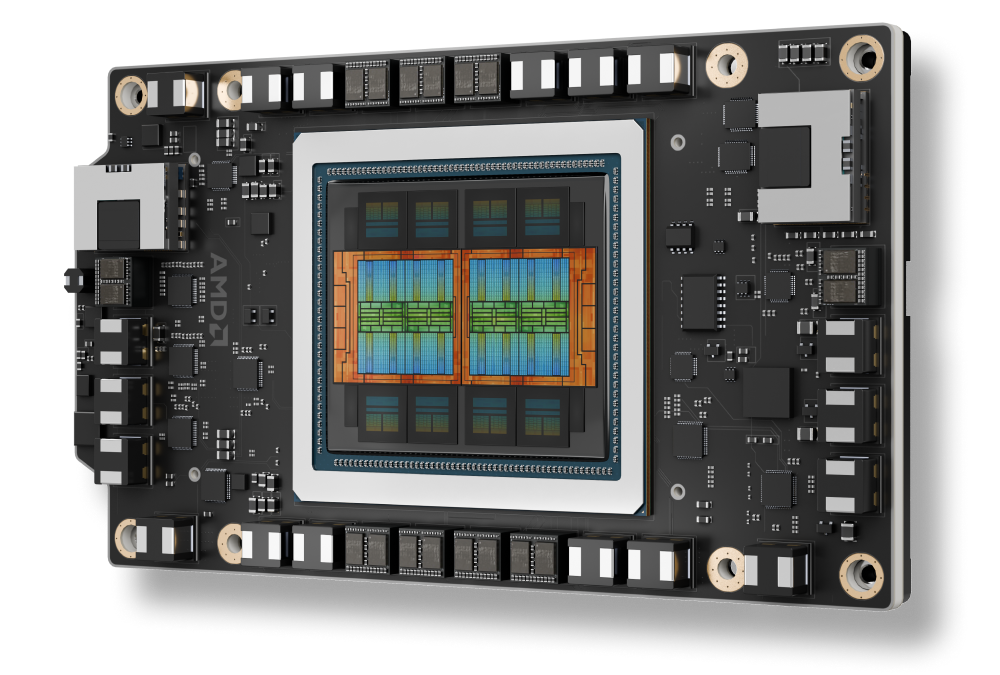

Prise en charge d'AMD Instinct™ Série MI350

Architecture AMD CDNA 4, prenant en charge de nouveaux types de données avec une mémoire HBM avancée

Fonctionnalités avancées pour faire évoluer l'IA

Inférence distribuée fluide, entraînement des MoE, apprentissage par renforcement à grande échelle

Outils d'IA conçus pour les entreprises

Déployez et gérez l'IA sur plusieurs clusters grâce à l'orchestration et à la prise en charge des terminaux

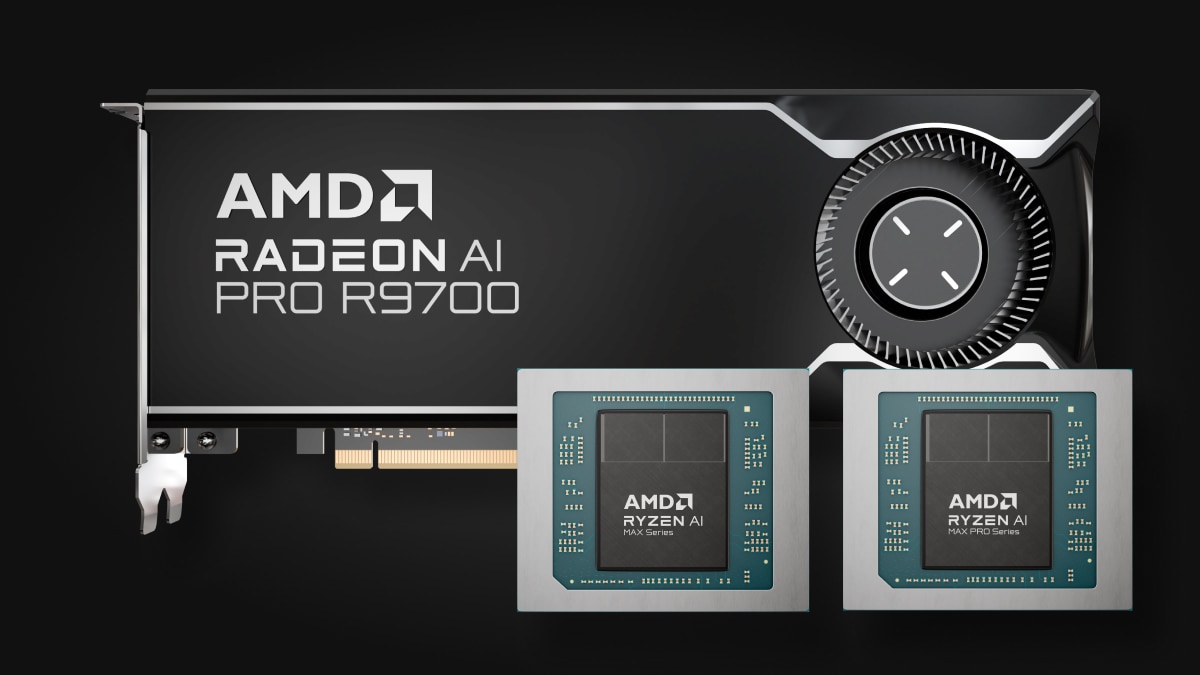

IA intégrée au terminal

De Ryzen™ AI aux solutions graphiques Radeon™ : un processeur d'IA polyvalent sur votre terminal, pour toutes les applications

Un véritable bond en avant des performances d'une génération à l'autre

ROCm 7 par rapport à ROCm 6

Inférence¹

Entraînement²

Prise en charge d'AMD Instinct™ Série MI350

Alimentation des GPU AMD Instinct™ Série MI350

Amélioration de l’intégration transparente des plateformes AMD Instinct MI350X avec une infrastructure rack ouverte, permettant un déploiement rapide et des performances d'IA optimisées à grande échelle.

Faire évoluer l'IA d'entreprise

Inférence distribuée avec un écosystème ouvert

Avec vLLM-d, DeepEP, SGLang et l’accès direct au GPU, la plateforme software ROCm offre le débit le plus élevé à l’échelle du rack sur l'ensemble des lots, des nœuds et des modèles.

ROCm pour le cycle de vie de l'IA

Le software ROCm s'intègre aux structures d'IA d'entreprise afin de fournir un flux de travail de bout en bout entièrement open source pour l'IA de production, englobant l'IA d'entreprise ROCm et la gestion des clusters ROCm pour fluidifier les déploiements et l'évolutivité.

IA intégrée au terminal

Extension de l'écosystème ROCm aux processeurs AMD Ryzen™ AI et aux solutions graphiques AMD Radeon™

L'écosystème d'IA ROCm pour les terminaux est basé sur la plateforme de conception ouverte de pointe TheROCK, qui propose des mises à jour de ROCm et PyTorch tous les soirs. Maintenant compatible avec Linux et Windows, ce système prend en charge les cœurs Radeon RX Série 9000 les plus récents et les principaux produits Ryzen AI Max, offrant une base solide pour le développement et le déploiement fluides de l'IA.

Un aperçu de PyTorch est désormais disponible : prise en charge de Linux pour AMD Ryzen™ AI Série 300* et Ryzen AI Série Max, et prise en charge de Windows pour AMD Ryzen AI Série 300*, Ryzen AI Série Max et tous les modèles AMD Radeon™ RX 7000 et Radeon Série W7000 (et versions ultérieures).

*Pour obtenir la liste complète des produits pris en charge, consultez notre matrice de compatibilité.

Commencez dès aujourd'hui

Accélérez vos tâches d'IA/ML, d'informatique hautes performances et d'analyse de données avec AMD Developer Cloud.

Tenez-vous au courant

Restez informés de l'actualité concernant ROCm.

Notes de bas de page

- MI300-080 - Tests effectués par AMD Performance Labs le 15/05/2025, mesurant les performances d’inférence en jetons par seconde (TPS) du software AMD ROCm 6.x avec vLLM 0.3.3, comparé à la version de prévisualisation du software AMD ROCm 7.0 avec vLLM 0.8.5, sur un système équipé de huit (8) GPU AMD Instinct MI300X, exécutant les modèles Llama 3.1-70B (TP2), Qwen 72B (TP2) et Deepseek-R1 (FP16), avec des tailles de lot allant de 1 à 256 et des longueurs de séquence de 128 à 204. Le gain de performances déclaré est exprimé en TPS moyens par rapport aux trois (3) LLM testés.

Configuration hardwareServeur de CPU 1P AMD EPYC™ 9534 avec 8 GPU AMD Instinct™ MI300X (192 Go, 750 W), Supermicro AS-8125GS-TNMR2, NPS1 (1 NUMA par socket), 1,5 Tio (24 DIMM, 4 800 mts mémoire, 64 Gio/DIMM), 4 x 3,49 To de stockage Micron 7450, version du BIOS : 1,8

Configuration(s) software

Ubuntu 22.04 LTS avec noyau Linux 5.15.0-119-generic

Qwen 72B et Llama 3.1-70B -

Version de prévisualisation du software ROCm 7.0

PyTorch 2.7.0. Deepseek R-1 - version de prévisualisation ROCm 7.0, SGLang 0.4.6, PyTorch 2.6.0

vs

Qwen 72 et Llama 3.1-70B - Software ROCm 6.x GA

PyTorch 2.7.0 et 2.1.1, respectivement,

Deepseek R-1 : Software ROCm 6.x GA

SGLang 0.4.1, PyTorch 2.5.0

Les résultats peuvent varier en fonction des configurations créées par les fabricants de serveurs. Les performances peuvent varier en fonction de la configuration, du software, de la version de vLLM et de l'utilisation des derniers pilotes et optimisations.

- MI300-081 - Tests réalisés par AMD Performance Labs en date du 15 mai 2025, pour mesurer les performances d'entraînement (en TFLOP) de la version de prévisualisation du software ROCm 7.0, avec Megatron-LM, sur huit GPU AMD Instinct MI300X, exécutant les modèles Llama 2-70B (4K), Qwen1.5-14B et Llama3.1-8B, dans un conteneur Docker personnalisé, comparé à un système configuré de manière similaire utilisant le software AMD ROCm 6.0.

Configuration hardware

CPU 1P AMD EPYC™ 9454, 8 GPU AMD Instinct MI300X (192 Go, 750 W), version du BIOS American Megatrends International LLC : 1.8, BIOS 1.8.

Configuration software

Ubuntu 22.04 LTS avec noyau Linux 5.15.0-70-generic

ROCm 7.0., Megatron-LM, PyTorch 2.7.0

vs

Version publique du software ROCm 6.0, branches de code Megatron-LM hanl/disable_te_llama2 pour Llama 2-7B, guihong_dev pour Llama 2-70B, renwuli/disable_te_qwen1.5 pour Qwen1.5-14B, PyTorch 2.2.

Les résultats peuvent varier en fonction des configurations créées par les fabricants de serveurs. Les performances peuvent varier en fonction de la configuration, du software, de la version de vLLM et de l'utilisation des derniers pilotes et optimisations.

- MI300-080 - Tests effectués par AMD Performance Labs le 15/05/2025, mesurant les performances d’inférence en jetons par seconde (TPS) du software AMD ROCm 6.x avec vLLM 0.3.3, comparé à la version de prévisualisation du software AMD ROCm 7.0 avec vLLM 0.8.5, sur un système équipé de huit (8) GPU AMD Instinct MI300X, exécutant les modèles Llama 3.1-70B (TP2), Qwen 72B (TP2) et Deepseek-R1 (FP16), avec des tailles de lot allant de 1 à 256 et des longueurs de séquence de 128 à 204. Le gain de performances déclaré est exprimé en TPS moyens par rapport aux trois (3) LLM testés.

Configuration hardwareServeur de CPU 1P AMD EPYC™ 9534 avec 8 GPU AMD Instinct™ MI300X (192 Go, 750 W), Supermicro AS-8125GS-TNMR2, NPS1 (1 NUMA par socket), 1,5 Tio (24 DIMM, 4 800 mts mémoire, 64 Gio/DIMM), 4 x 3,49 To de stockage Micron 7450, version du BIOS : 1,8

Configuration(s) software

Ubuntu 22.04 LTS avec noyau Linux 5.15.0-119-generic

Qwen 72B et Llama 3.1-70B -

Version de prévisualisation du software ROCm 7.0

PyTorch 2.7.0. Deepseek R-1 - version de prévisualisation ROCm 7.0, SGLang 0.4.6, PyTorch 2.6.0

vs

Qwen 72 et Llama 3.1-70B - Software ROCm 6.x GA

PyTorch 2.7.0 et 2.1.1, respectivement,

Deepseek R-1 : Software ROCm 6.x GA

SGLang 0.4.1, PyTorch 2.5.0

Les résultats peuvent varier en fonction des configurations créées par les fabricants de serveurs. Les performances peuvent varier en fonction de la configuration, du software, de la version de vLLM et de l'utilisation des derniers pilotes et optimisations.

- MI300-081 - Tests réalisés par AMD Performance Labs en date du 15 mai 2025, pour mesurer les performances d'entraînement (en TFLOP) de la version de prévisualisation du software ROCm 7.0, avec Megatron-LM, sur huit GPU AMD Instinct MI300X, exécutant les modèles Llama 2-70B (4K), Qwen1.5-14B et Llama3.1-8B, dans un conteneur Docker personnalisé, comparé à un système configuré de manière similaire utilisant le software AMD ROCm 6.0.

Configuration hardware

CPU 1P AMD EPYC™ 9454, 8 GPU AMD Instinct MI300X (192 Go, 750 W), version du BIOS American Megatrends International LLC : 1.8, BIOS 1.8.

Configuration software

Ubuntu 22.04 LTS avec noyau Linux 5.15.0-70-generic

ROCm 7.0., Megatron-LM, PyTorch 2.7.0

vs

Version publique du software ROCm 6.0, branches de code Megatron-LM hanl/disable_te_llama2 pour Llama 2-7B, guihong_dev pour Llama 2-70B, renwuli/disable_te_qwen1.5 pour Qwen1.5-14B, PyTorch 2.2.

Les résultats peuvent varier en fonction des configurations créées par les fabricants de serveurs. Les performances peuvent varier en fonction de la configuration, du software, de la version de vLLM et de l'utilisation des derniers pilotes et optimisations.