Emirates NBD

“Descobrimos que as CPUs AMD EPYC™ eram, em média, 42% mais rápidas do que uma alternativa.”

Otimize o desempenho com menos servidores e ajude a reduzir o consumo de energia.

Os processadores AMD EPYC™ são as melhores CPUs de data center do mundo. Eles oferecem o desempenho de computação do data center que as empresas precisam para atender às demandas dos clientes, podem reduzir o espaço ocupado pelo rack, oferecem desempenho eficiente em termos de energia e podem implementar cargas de trabalho de IA em escala.

As empresas estão implementando a tecnologia de IA para se manterem competitivas, mas isso pode ser um desafio para os líderes de TI. Adicionar aplicativos de IA à empresa pode sobrecarregar a capacidade da infraestrutura de data center existente. É por isso que a modernização é fundamental. Por exemplo, ao atualizar do Intel Xeon Gold 6143 para o AMD EPYC 9334 de 4ª geração, as organizações podem usar até 73% menos servidores, 70% menos racks e 65% menos energia para atingir uma pontuação SPECrate® Integer de pelo menos 80.000.1

Selecionar o processador para data center correto para sua próxima implementação de servidor pode ajudar sua organização de TI a obter mais desempenho e densidade e, ao mesmo tempo, manter ou reduzir o espaço ocupado pelo data center.

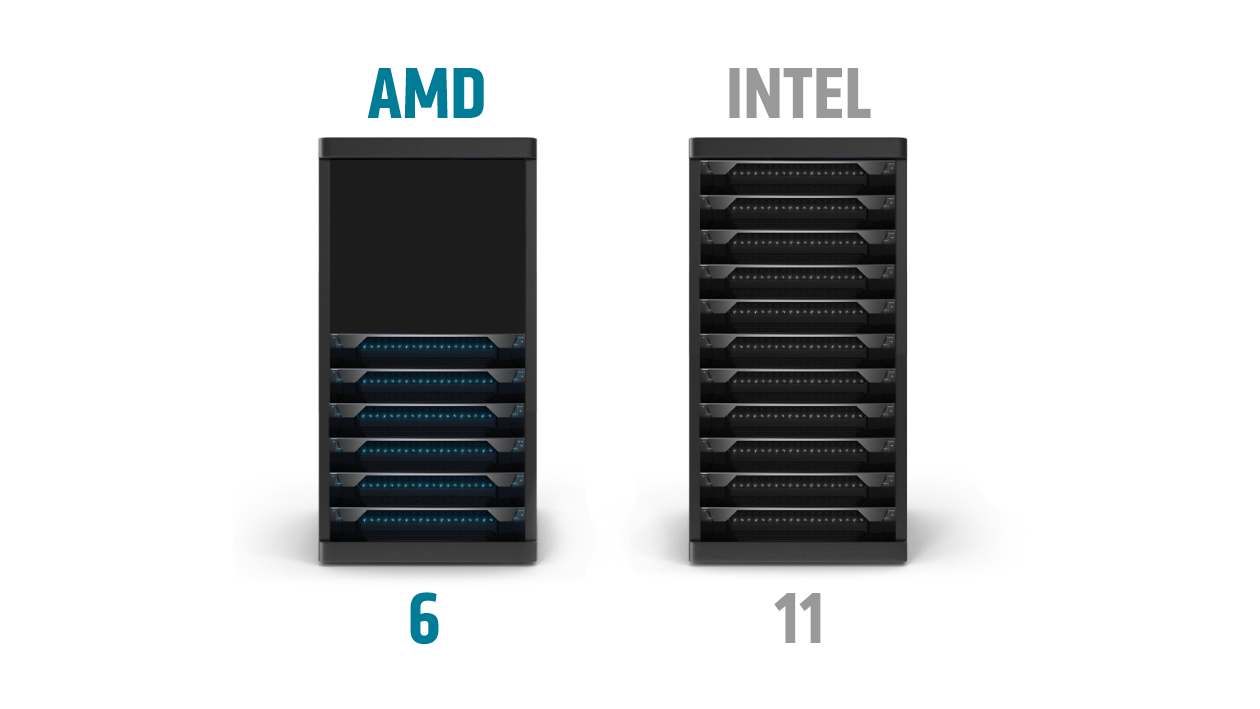

Por exemplo, para atingir uma pontuação SPECrate® Integer de pelo menos 10.000, seriam necessários 11 dos mais recentes servidores Intel Xeon Platinum 8490H de soquete duplo, mas apenas 6 servidores com tecnologia AMD EPYC 9654 de soquete duplo.2

Os servidores equipados com processadores AMD EPYC de 4ª geração podem ajudar você a:

Quando se trata de cargas de trabalho de IA, os requisitos são diversos e continuam evoluindo. Tanto as CPUs quanto as GPUs podem se destacar na execução de cargas de trabalho de inferência de IA, com diferentes características e cenários de implantação. A AMD oferece liderança em desempenho e eficiência de IA para CPUs e aceleradores de GPU para implantações de data center.

Os processadores AMD EPYC de 4ª geração ajudam as empresas a obter insights mais rápidos para acelerar os negócios. A inferência de IA é melhor implementada nas CPUs EPYC quando os tamanhos dos modelos são menores e quando a IA é uma porcentagem menor da combinação geral de cargas de trabalho do servidor.

A carga de computação de IA é um dos muitos fatores que afetam o desempenho geral de um servidor quando implantado na empresa. Para ter uma noção melhor dos recursos gerais de um servidor, é importante examinar o pipeline de ponta a ponta. Quando comparados a servidores com 2x processadores Xeon de 64 núcleos de 5ª geração topo de linha, servidores implantados com 2x processadores EPYC de 96 núcleos de 4ª geração oferecem um desempenho de 1,65x por servidor executando o benchmark TPCx-AI SF30.³

Os aceleradores AMD Instinct™ oferecem desempenho líder para as cargas de trabalho de IA e HPC mais exigentes, com o MI300X proporcionando um desempenho de até 1,3 vezes em precisões de IA em comparação com os aceleradores Nvidia H100 SXM (80 GB)⁴. Além do treinamento de modelos de IA, as GPUs AMD Instinct são ideais para inferência em implementações de IA dedicadas, em que a IA compreende uma parte maior da combinação geral de cargas de trabalho do servidor ou quando a resposta de inferência em tempo real é essencial para a aplicação.

A AMD trabalha com uma variedade de parceiros para projetar e desenvolver soluções otimizadas que utilizam a 4ª geração do AMD EPYC.

Os processadores AMD EPYC da 4ª geração foram projetados para oferecer resultados de negócios acelerados, consolidando a infraestrutura e ajudando a reduzir o CAPEX e o OPEX.

Saiba como você pode adicionar mais desempenho e eficiência ao seu data center, ajudando a reduzir os custos, o consumo de energia e o espaço do servidor.

No local ou na nuvem, descubra como outras empresas implantaram com sucesso os processadores AMD EPYC.