AMD を選択してデータセンターの変革とビジネスの進化を実現

AMD EPYC™ プロセッサは、世界最高のデータセンター CPU です。顧客の要求に応えるために企業が必要とするデータセンターの演算性能を提供するとともに、ラックのフットプリントを削減し、電力効率に優れたパフォーマンスを発揮し、AI ワークロードを大規模に導入できます。

モダナイズと統合で AI イニシアチブに備える

各企業は競争力を保つために AI テクノロジを導入していますが、IT リーダーにとっては大きな課題にもなり得ます。企業に AI アプリケーションを追加すると、既存のデータセンター インフラストラクチャの機能に負荷がかかる可能性があります。だからこそ、モダナイズが重要となります。たとえば、Intel Xeon Gold 6143 から第 4 世代 AMD EPYC 9334 にアップグレードすると、最大でサーバーの台数を 73%、ラックの台数を 70%、電力消費量を 65% 削減し、SPECrate® Integer で 80,000 以上のスコアを達成できます。1

AMD EPYC™ を選択する理由

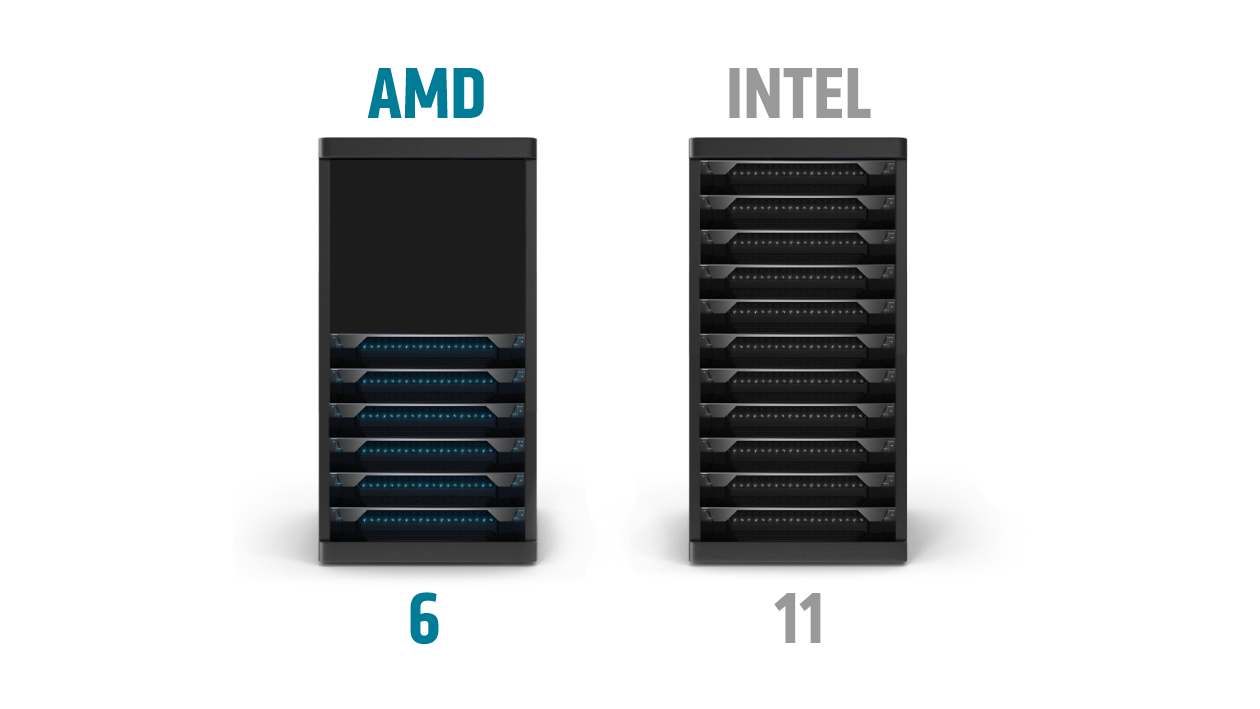

次のサーバー展開時に適切なデータセンター プロセッサを選択することで、IT 組織はデータセンターのフットプリントを維持または削減しながら、パフォーマンスと密度を改善できます。

たとえば、SPECrate® Integer で 10,000 以上のスコアを達成するには、11 台の最新デュアル ソケット Intel Xeon Platinum 8490H ベースのサーバーが必要ですが、デュアル ソケット AMD EPYC 9654 搭載サーバーなら 6 台で済みます。2

第 4 世代 AMD EPYC プロセッサ搭載サーバーは次のことを促進できます。

- より少ないサーバー台数で同じ量のワークロードを実行

- 運用コストと電力コストを削減

- 貴重なデータセンター スペースと電力を解放し、これを新たなワークロードやサービスに充当

データセンターへの AI 展開には AMD を

AI ワークロードの要件は多彩で、進化し続けています。AI 推論ワークロードの実行において、CPU と GPU はどちらも優れたパフォーマンスを発揮しますが、特性や展開シナリオに違いがあります。データセンターでの運用に関して、AMD の CPU と GPU のアクセラレータはどちらも、AI のパフォーマンスと効率性で業界をリードしています。

世界最高のデータセンター CPU

第 4 世代 AMD EPYC プロセッサにより、企業はより迅速に洞察を得て、ビジネスを加速できます。モデル サイズが小規模の場合や、AI がサーバーの混合ワークロード全体に占める割合が小さい場合は、AI 推論を EPYC CPU に展開するのが最善です。

企業で展開された場合、AI 演算負荷は、サーバーの全体的なパフォーマンスに影響する数多くの要因の 1 つです。サーバーの全体的な機能をより的確に把握するには、エンドツーエンドのパイプライン処理に目を向けることが重要です。最上位モデルである 64 コアの第 5 世代 Xeon を 2 個搭載したサーバーと比較して、96 コアの第 4 世代 EPYC プロセッサを 2 個搭載したサーバーは、TPCx-AI SF30 ベンチマークを実行するサーバーあたり 1.65 倍のパフォーマンスを実現します。³

世界最高パフォーマンスのデータセンター GPU アクセラレータ

AMD Instinct™ アクセラレータは、要求のきわめて厳しい AI および HPC のワークロードで業界をリードするパフォーマンスを発揮し、MI300X は Nvidia H100 SXM (80 GB) アクセラレータとの比較で、AI 精度で最大 1.3 倍のパフォーマンスを提供します⁴。AMD Instinct GPU は、AI モデルのトレーニングのほかにも、サーバーの混合ワークロード全体で AI の占める割合が大きい場合や、アプリケーションにとってリアルタイムの推論応答が重要な場合など、AI 専用環境での推論に最適です。

ソリューション

AMD はさまざまなパートナーと協力を図りながら、第 4 世代 AMD EPYC を生かして最適化されたソリューションを設計および開発しています。

AMD EPYC により、一段と優れた成果を実現

第 4 世代 AMD EPYC プロセッサは、インフラストラクチャの統合と、設備投資と運用コストの削減により、さらに迅速にビジネス成果を達成できるように設計されています。

このプロセッサを活用することで、データセンターのパフォーマンスと効率の向上を図り、コスト、電力消費量、サーバー フットプリントの削減を促進できます。詳細をご覧ください。

数千に上る企業からの高い信頼

多くの企業が、オンプレミスやクラウドに AMD EPYC プロセッサを導入しています。その成功事例をご覧ください。

サインアップすると、データセンターとサーバー コンテンツに関する最新情報を受け取ることができます。

脚注

- SP5TCO-055: このシナリオには多くの仮定と推定が含まれており、AMD の内部調査と最良近似に基づいています。このシナリオ中に示される数値は、情報提供のみを目的とした例であり、実際のテストに対する意思決定の基礎としては使用しないでください。ベアメタル サーバー温室効果ガス排出量 TCO (総所有コスト) 評価ツール (バージョン 9.37 Pro Refresh) では、2023 年 6 月 1 日時点における公開スコアに基づき、80,000 ユニットの整数演算性能の TOTAL_PERFORMANCE を実現するために必要となる特定の AMD EPYC™ と Intel® Xeon® CPU ベースのサーバー ソリューションを比較しています。 この推定値は、PUE を 1.7、米国の電力コストを $0.128/kWh とし、3 年間使用したと仮定したときの数値です。 この分析では、SPECrate®2017_int_base のスコアが 725 の 2P AMD 32 コア EPYC 9334 CPU 搭載サーバー (https://spec.org/cpu2017/results/res2023q1/cpu2017-20230102-33282.pdf) と SPECrate®2017_int_base のスコアが 197 の 2P Intel Xeon 16 コア Gold_6143 ベースのサーバー (https://spec.org/cpu2017/results/res2017q4/cpu2017-20171114-00863.pdf) を比較しています。不動産や管理のコストは多岐にわたるため、この分析ではそれらのコストは TCO に含まれません。新しい AMD 搭載サーバーの運用コストは電力のみで構成されています。 Intel CPU 搭載サーバーのレガシ インストール ベースの運用コストは、電力と延長保証コストで構成されています。サーバーの保証サポートを延長するためのコストは、1 年あたり初期購入価格の 20% として計算されます。この計算には 2023 年のコストが使用されています。 これと電力コストを使用すると、AMD ソリューションの 3 年間の TCO は 250 万ドル以上削減 (62% 削減) され、年間の運用コストは 120 万ドルまたは 93% 削減されることになります。環境負荷への試算は、このデータを活用し、「2020 Grid Electricity Emissions Factors v1.4 – 2020 年 9 月」の国/地域特定の電気要因、および米国環境保護庁「Greenhouse Gas Equivalencies Calculator」を使用しています。その他の詳細については、https://www.amd.com/en/claims/epyc4#SP5TCO-055 をご覧ください。

- SP5TCO-032: このシナリオには多くの仮定と推定が含まれており、AMD の内部調査と最良近似に基づいています。このシナリオ中に示される数値は、情報提供のみを目的とした例であり、実際のテストに対する意思決定の基礎としては使用しないでください。ベアメタル サーバー温室効果ガス排出量 TCO (総所有コスト) 評価ツール (バージョン 6.80) では、2023 年 1 月 10 日時点における公開スコアに基づき、10,000 ユニットの整数演算性能の TOTAL_PERFORMANCE を実現するために必要となる特定の AMD EPYC™ と Intel® Xeon® CPU ベースのサーバー ソリューションを比較しています。この推定値は、PUE を 1.7、米国の電力コストを $0.16/kWh とし、3 年間使用したと仮定したときの数値です。この分析では、SPECrate2017_int_base のスコアが 1790 の 2P AMD 96 コア AMD EPYC_9654 搭載サーバー (https://spec.org/cpu2017/results/res2022q4/cpu2017-20221024-32607.pdf) と SPECrate2017_int_base のスコアが 991 の 2P Intel Xeon 60 コア Platinum_8490H ベースのサーバー (https://spec.org/cpu2017/results/res2023q1/cpu2017-20221206-33039.pdf) を比較しています。環境負荷への試算は、このデータを活用し、「2020 Grid Electricity Emissions Factors v1.4 – 2020 年 9 月」の国/地域特定の電気要因、および米国環境保護庁「Greenhouse Gas Equivalencies Calculator」を使用しています。その他の詳細については、https://www.amd.com/en/claims/epyc4#SP5TCO-032 をご覧ください。

- SP5-051A: TPCx-AI SF30 デリバティブ ワークロード比較テストは、2024 年 4 月 13 日に複数の VM インスタンスを実行した AMD 社内テストの結果に基づいています。集約エンドツーエンド AI スループット試験は、TPCx-AI ベンチマークから派生したものであるため、公開されている TPCx-AI の結果とは比較できません。エンドツーエンド AI スループット試験結果は TPCx-AI 仕様を順守していないためです。AMD システム構成: プロセッサ: 2 x AMD EPYC 9654、周波数: 2.4 GHz | 3.7 GHz、コア数: ソケットあたり 96 個のコア (ソケットあたり 1 NUMA ドメイン)、L3 キャッシュ: 384 MB/ソケット (合計 768 MB)、メモリ: 1.5 TB (24) デュアルランク DDR5-5600 64 GB DIMM、1DPC (プラットフォームは最大 4800 MHz に対応)、NIC: 2 x 100 GbE Mellanox CX-5 (MT28800)、ストレージ: 3.2 TB Samsung MO003200KYDNC U.3 NVMe、BIOS: 1.56、BIOS 設定: SMT=ON、Determinism=Power、NPS=1、PPL=400W、Turbo Boost=Enabled、OS: Ubuntu® 22.04.3 LTS、試験構成: 6 インスタンス、64 vCPUs/インスタンス、2663 集約 AI ユース ケース/分。比較対象の Intel システム構成: プロセッサ: 2 x Intel® Xeon® Platinum 8592 +、周波数: 1.9 GHz | 3.9 GHz、コア数: ソケットあたり 64 個のコア (ソケットあたり 1 NUMA ドメイン)、L3 キャッシュ: 320 MB/ソケット (合計 640 MB)、メモリ: 1 TB (16) デュアルランク DDR5-5600 64 GB DIMM、1DPC、NIC: 4 x 1 GbE Broadcom NetXtreme BCM5719 Gigabit Ethernet PCIe、ストレージ: 3.84 TB KIOXIA KCMYXRUG3T84 NVMe、BIOS: ESE124B-3.11、BIOS 設定: Hyperthreading=Enabled、Turbo boost=Enabled、SNC=Disabled、OS: Ubuntu® 22.04.3 LTS、試験構成: 4 インスタンス、64 vCPU/インスタンス、1607 集約 AI ユース ケース/分。実際の結果は、システムの構成、ソフトウェアのバージョン、BIOS の設定などの要因によって異なります。 TPC、TPC Benchmark、および TPC-C は、Transaction Processing Performance Council の商標です。

- MI300-17: AMD パフォーマンス ラボが 2023 年 11 月 11 日に AMD CDNA™ 3 5 nm | 6 nm FinFET プロセス テクノロジを使用して設計した AMD Instinct™ MI300X (750 W) GPU で測定した結果、2,100 MHz のピーク ブースト エンジン クロックで 653.7 TFLOPS ピーク理論 TensorFloat-32 (TF32)、1307.4 TFLOPS ピーク理論半精度 (FP16)、1307.4 TFLOPS ピーク理論 Bfloat16 フォーマット精度 (BF16)、2614.9 TFLOPS ピーク理論 8 ビット精度 (FP8)、2614.9 TOPs INT8 浮動小数点の演算能力が得られました。MI300X は、微細な構造のスパース性を活用できるため、演算効率が推定で 2 倍向上し、その結果、1,307.4 TFLOPS ピーク理論 TensorFloat-32 (TF32)、2,614.9 TFLOPS ピーク理論半精度 (FP16)、2,614.9 TFLOPS ピーク理論 Bfloat16 フォーマット精度 (BF16)、5,229.8 TFLOPS ピーク理論 8 ビット精度 (FP8)、5,229.8 TOPs INT8 スパース浮動小数点演算パフォーマンスが得られると予想されます。NVIDIA H100 SXM (80GB) 700W GPU での公表結果では、スパース性を持つ TensorFloat-32 (TF32) のピーク値が 989.4 TFLOPS、スパース性を持つ理論半精度 (FP16) のピーク値が 1,978.9 TFLOPS、スパース性を含む理論 Bfloat16 フォーマット精度 (BF16) のピーク値が 1,978.9 TFLOPS、スパース性を持つ 8 ビット精度 (FP8) のピーク理論が 3,957.8 TFLOPS、スパース性を持つ INT8 浮動小数点性能のピーク理論が 3,957.8 TOPs。NVIDIA H100 ソース: https://resources.nvidia.com/en-us-tensor-core.MI300-17

- SP5TCO-055: このシナリオには多くの仮定と推定が含まれており、AMD の内部調査と最良近似に基づいています。このシナリオ中に示される数値は、情報提供のみを目的とした例であり、実際のテストに対する意思決定の基礎としては使用しないでください。ベアメタル サーバー温室効果ガス排出量 TCO (総所有コスト) 評価ツール (バージョン 9.37 Pro Refresh) では、2023 年 6 月 1 日時点における公開スコアに基づき、80,000 ユニットの整数演算性能の TOTAL_PERFORMANCE を実現するために必要となる特定の AMD EPYC™ と Intel® Xeon® CPU ベースのサーバー ソリューションを比較しています。 この推定値は、PUE を 1.7、米国の電力コストを $0.128/kWh とし、3 年間使用したと仮定したときの数値です。 この分析では、SPECrate®2017_int_base のスコアが 725 の 2P AMD 32 コア EPYC 9334 CPU 搭載サーバー (https://spec.org/cpu2017/results/res2023q1/cpu2017-20230102-33282.pdf) と SPECrate®2017_int_base のスコアが 197 の 2P Intel Xeon 16 コア Gold_6143 ベースのサーバー (https://spec.org/cpu2017/results/res2017q4/cpu2017-20171114-00863.pdf) を比較しています。不動産や管理のコストは多岐にわたるため、この分析ではそれらのコストは TCO に含まれません。新しい AMD 搭載サーバーの運用コストは電力のみで構成されています。 Intel CPU 搭載サーバーのレガシ インストール ベースの運用コストは、電力と延長保証コストで構成されています。サーバーの保証サポートを延長するためのコストは、1 年あたり初期購入価格の 20% として計算されます。この計算には 2023 年のコストが使用されています。 これと電力コストを使用すると、AMD ソリューションの 3 年間の TCO は 250 万ドル以上削減 (62% 削減) され、年間の運用コストは 120 万ドルまたは 93% 削減されることになります。環境負荷への試算は、このデータを活用し、「2020 Grid Electricity Emissions Factors v1.4 – 2020 年 9 月」の国/地域特定の電気要因、および米国環境保護庁「Greenhouse Gas Equivalencies Calculator」を使用しています。その他の詳細については、https://www.amd.com/en/claims/epyc4#SP5TCO-055 をご覧ください。

- SP5TCO-032: このシナリオには多くの仮定と推定が含まれており、AMD の内部調査と最良近似に基づいています。このシナリオ中に示される数値は、情報提供のみを目的とした例であり、実際のテストに対する意思決定の基礎としては使用しないでください。ベアメタル サーバー温室効果ガス排出量 TCO (総所有コスト) 評価ツール (バージョン 6.80) では、2023 年 1 月 10 日時点における公開スコアに基づき、10,000 ユニットの整数演算性能の TOTAL_PERFORMANCE を実現するために必要となる特定の AMD EPYC™ と Intel® Xeon® CPU ベースのサーバー ソリューションを比較しています。この推定値は、PUE を 1.7、米国の電力コストを $0.16/kWh とし、3 年間使用したと仮定したときの数値です。この分析では、SPECrate2017_int_base のスコアが 1790 の 2P AMD 96 コア AMD EPYC_9654 搭載サーバー (https://spec.org/cpu2017/results/res2022q4/cpu2017-20221024-32607.pdf) と SPECrate2017_int_base のスコアが 991 の 2P Intel Xeon 60 コア Platinum_8490H ベースのサーバー (https://spec.org/cpu2017/results/res2023q1/cpu2017-20221206-33039.pdf) を比較しています。環境負荷への試算は、このデータを活用し、「2020 Grid Electricity Emissions Factors v1.4 – 2020 年 9 月」の国/地域特定の電気要因、および米国環境保護庁「Greenhouse Gas Equivalencies Calculator」を使用しています。その他の詳細については、https://www.amd.com/en/claims/epyc4#SP5TCO-032 をご覧ください。

- SP5-051A: TPCx-AI SF30 デリバティブ ワークロード比較テストは、2024 年 4 月 13 日に複数の VM インスタンスを実行した AMD 社内テストの結果に基づいています。集約エンドツーエンド AI スループット試験は、TPCx-AI ベンチマークから派生したものであるため、公開されている TPCx-AI の結果とは比較できません。エンドツーエンド AI スループット試験結果は TPCx-AI 仕様を順守していないためです。AMD システム構成: プロセッサ: 2 x AMD EPYC 9654、周波数: 2.4 GHz | 3.7 GHz、コア数: ソケットあたり 96 個のコア (ソケットあたり 1 NUMA ドメイン)、L3 キャッシュ: 384 MB/ソケット (合計 768 MB)、メモリ: 1.5 TB (24) デュアルランク DDR5-5600 64 GB DIMM、1DPC (プラットフォームは最大 4800 MHz に対応)、NIC: 2 x 100 GbE Mellanox CX-5 (MT28800)、ストレージ: 3.2 TB Samsung MO003200KYDNC U.3 NVMe、BIOS: 1.56、BIOS 設定: SMT=ON、Determinism=Power、NPS=1、PPL=400W、Turbo Boost=Enabled、OS: Ubuntu® 22.04.3 LTS、試験構成: 6 インスタンス、64 vCPUs/インスタンス、2663 集約 AI ユース ケース/分。比較対象の Intel システム構成: プロセッサ: 2 x Intel® Xeon® Platinum 8592 +、周波数: 1.9 GHz | 3.9 GHz、コア数: ソケットあたり 64 個のコア (ソケットあたり 1 NUMA ドメイン)、L3 キャッシュ: 320 MB/ソケット (合計 640 MB)、メモリ: 1 TB (16) デュアルランク DDR5-5600 64 GB DIMM、1DPC、NIC: 4 x 1 GbE Broadcom NetXtreme BCM5719 Gigabit Ethernet PCIe、ストレージ: 3.84 TB KIOXIA KCMYXRUG3T84 NVMe、BIOS: ESE124B-3.11、BIOS 設定: Hyperthreading=Enabled、Turbo boost=Enabled、SNC=Disabled、OS: Ubuntu® 22.04.3 LTS、試験構成: 4 インスタンス、64 vCPU/インスタンス、1607 集約 AI ユース ケース/分。実際の結果は、システムの構成、ソフトウェアのバージョン、BIOS の設定などの要因によって異なります。 TPC、TPC Benchmark、および TPC-C は、Transaction Processing Performance Council の商標です。

- MI300-17: AMD パフォーマンス ラボが 2023 年 11 月 11 日に AMD CDNA™ 3 5 nm | 6 nm FinFET プロセス テクノロジを使用して設計した AMD Instinct™ MI300X (750 W) GPU で測定した結果、2,100 MHz のピーク ブースト エンジン クロックで 653.7 TFLOPS ピーク理論 TensorFloat-32 (TF32)、1307.4 TFLOPS ピーク理論半精度 (FP16)、1307.4 TFLOPS ピーク理論 Bfloat16 フォーマット精度 (BF16)、2614.9 TFLOPS ピーク理論 8 ビット精度 (FP8)、2614.9 TOPs INT8 浮動小数点の演算能力が得られました。MI300X は、微細な構造のスパース性を活用できるため、演算効率が推定で 2 倍向上し、その結果、1,307.4 TFLOPS ピーク理論 TensorFloat-32 (TF32)、2,614.9 TFLOPS ピーク理論半精度 (FP16)、2,614.9 TFLOPS ピーク理論 Bfloat16 フォーマット精度 (BF16)、5,229.8 TFLOPS ピーク理論 8 ビット精度 (FP8)、5,229.8 TOPs INT8 スパース浮動小数点演算パフォーマンスが得られると予想されます。NVIDIA H100 SXM (80GB) 700W GPU での公表結果では、スパース性を持つ TensorFloat-32 (TF32) のピーク値が 989.4 TFLOPS、スパース性を持つ理論半精度 (FP16) のピーク値が 1,978.9 TFLOPS、スパース性を含む理論 Bfloat16 フォーマット精度 (BF16) のピーク値が 1,978.9 TFLOPS、スパース性を持つ 8 ビット精度 (FP8) のピーク理論が 3,957.8 TFLOPS、スパース性を持つ INT8 浮動小数点性能のピーク理論が 3,957.8 TOPs。NVIDIA H100 ソース: https://resources.nvidia.com/en-us-tensor-core.MI300-17