Emirates NBD

„Wir haben festgestellt, dass AMD EPYC™ CPUs im Durchschnitt 42 % schneller sind als eine Alternative.“

Die Performance mit weniger Servern optimieren und den Energieverbrauch senken.

AMD EPYC™ Prozessoren sind die weltbesten CPUs für Rechenzentren. Sie bieten die Computing-Performance für Rechenzentren, die Unternehmen benötigen, um Kundenanforderungen zu erfüllen, können den Platzbedarf im Rack reduzieren, energieeffiziente Performance bieten und KI-Workloads skalierbar bereitstellen.

Unternehmen implementieren KI-Technologie, um wettbewerbsfähig zu bleiben, aber sie kann für IT-Führungskräfte eine Herausforderung darstellen. Das Hinzufügen von KI-Anwendungen zum Unternehmen kann die Leistungsfähigkeit der vorhandenen Rechenzentrumsinfrastruktur beeinträchtigen. Deshalb ist Modernisierung von entscheidender Bedeutung. Unternehmen benötigen zum Beispiel bei einem Upgrade von Intel Xeon Gold 6143 auf AMD EPYC 9334 der 4. Generation bis zu 73 % weniger Server, 70 % weniger Rack-Fläche und 65 % weniger Strom, um eine SPECrate®-Ganzzahlwertung von mindestens 80.000 zu erreichen.1

Die Wahl des richtigen Rechenzentrumsprozessors kann Ihrer IT-Abteilung dabei helfen, mehr Performance und Dichte zu erzielen und gleichzeitig den Platzbedarf ihres Rechenzentrums beizubehalten oder zu reduzieren.

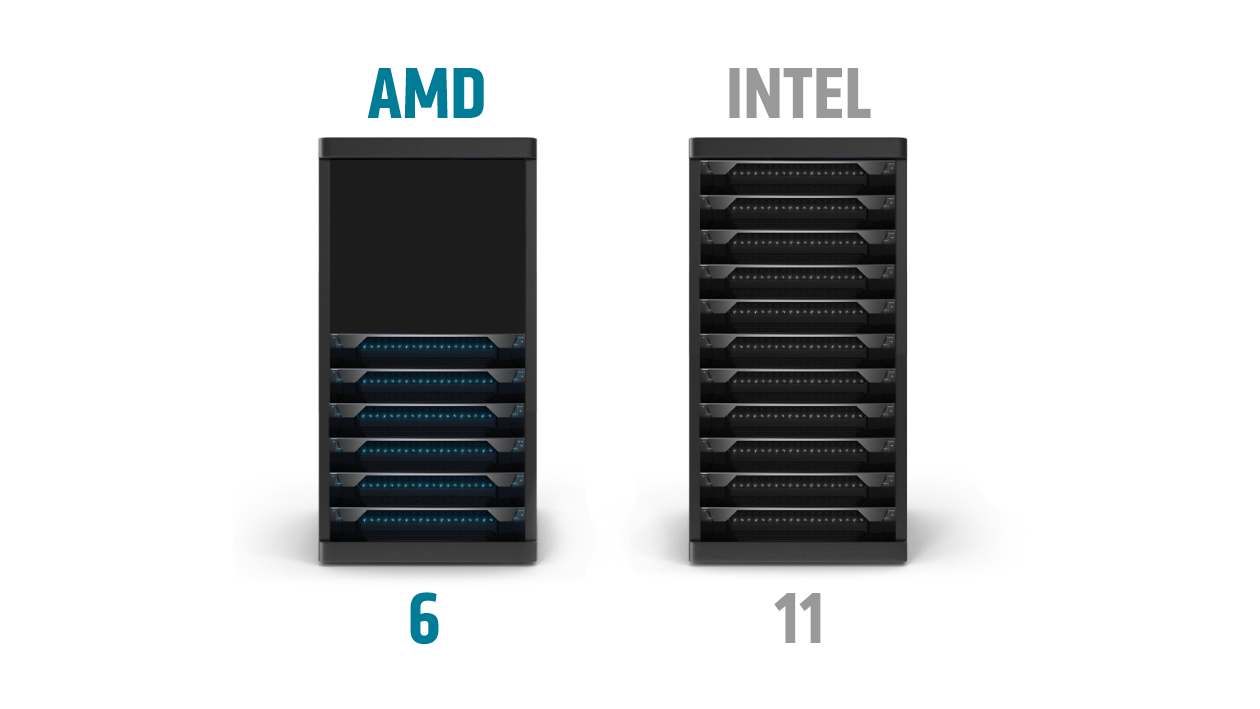

Um beispielsweise eine SPECrate®-Ganzzahlwertung von mindestens 10.000 zu erreichen, wären 11 der neuesten Intel Xeon Platinum 8490H Doppelsockel-Server erforderlich, aber nur 6 AMD EPYC 9654 Dual-Socket-Server.2

Server mit AMD EPYC Prozessoren der 4. Generation können Ihnen dabei helfen:

Bei KI-Workloads sind die Anforderungen vielfältig und entwickeln sich ständig weiter. Sowohl CPUs als auch GPUs können für die Ausführung von KI-Inferenz-Workloads mit unterschiedlichen Eigenschaften und Bereitstellungsszenarien hervorragend geeignet sein. AMD bietet führende KI-Performance und -Effizienz für CPUs und GPU-Beschleuniger für Bereitstellungen im Rechenzentrum.

AMD EPYC Prozessoren der 4. Generation helfen Unternehmen dabei, schneller zu Erkenntnissen zu gelangen – und damit ihre Geschäftsprozesse zu beschleunigen. KI-Inferenz wird am besten auf EPYC-CPUs bereitgestellt, wenn die Modellgrößen kleiner sind und wenn KI einen geringeren Prozentsatz des gesamten Server-Workload-Mix darstellt.

Die KI-Rechenlast ist einer von vielen Faktoren, die sich auf die Gesamtleistung eines Servers bei der Bereitstellung im Unternehmen auswirken. Um ein besseres Bild von den allgemeinen Funktionen eines Servers zu erhalten, ist es wichtig, die End-to-End-Pipeline zu betrachten. Im Vergleich zu Servern mit 2x Xeon Prozessoren der 5. Generation mit 64 Kernen bieten Server mit 2x EPYC Prozessoren der 4. Generation mit 96 Kernen eine 1,65-fache Performance pro Server mit dem TPCx-AI SF30 Benchmark.³

AMD Instinct™ Beschleuniger bieten führende Performance für die anspruchsvollsten KI- und HPC-Workloads. Dabei bieten MI300X Beschleuniger im Vergleich zu Nvidia H100 SXM Beschleunigern (80 GB) eine bis zu 1,3-fache Performance bei KI-Anwendungen.⁴ Zusätzlich zu den Schulungen zu KI-Modellen eignen sich AMD Instinct GPUs ideal für Inferenz von dedizierten KI-Bereitstellungen, bei denen KI einen größeren Teil des gesamten Server-Workload-Mixes ausmacht oder für den Fall, dass die Reaktion auf Inferenz in Echtzeit für die Anwendung entscheidend ist.

AMD arbeitet mit einer Vielzahl von Partnern zusammen, um mit AMD EPYC Prozessoren der 4. Generation optimierte Lösungen zu entwickeln.

AMD EPYC Prozessoren der 4. Generation wurden entwickelt, um durch die Konsolidierung der Infrastruktur und die Reduzierung von CAPEX und OPEX schnellere Geschäftsergebnisse zu erzielen.

Erfahren Sie, wie Sie Ihr Rechenzentrum leistungsfähiger und effizienter machen können, um Kosten, Energieverbrauch und Platzbedarf der Server zu reduzieren.

Ob vor Ort oder in der Cloud, entdecken Sie, wie andere Unternehmen AMD EPYC Prozessoren erfolgreich eingesetzt haben.