엔터프라이즈 AI를 위한 비용 효율적인 추론

업계가 학습 모델에서 운영 모델로 전환하면서 CPU는 AI와 범용 워크로드를 나란히 실행하는 두 가지 역할을 수행할 수 있는 위력을 갖추게 되었습니다.

온프레미스 또는 클라우드의 AMD EPYC™ 9005 서버 CPU에 소규모 및 중규모 모델을 배포하고 컴퓨팅 투자의 가치를 극대화할 수 있도록 지원하세요.

과도한 프로비저닝을 피하고 AI 투자 수익을 극대화하려면 모델 크기 및 지연율 요구 사항에 맞는 적합한 하드웨어를 선택해야 합니다. 최신 세대의 AMD EPYC 서버 CPU는 범용 워크로드 외에도 다양한 AI 작업을 처리할 수 있습니다. 모델 크기가 증가하고 볼륨이 늘어나며 낮은 지연 시간이 중요해짐에 따라, GPU의 효율성과 비용 효율성은 더욱 높아집니다.

| AI 추론 워크로드 | 적합한 하드웨어 |

||

CPU |

CPU + PCIe 기반 GPU |

GPU 클러스터 |

|

문서 처리 및 분류 |

✓ |

|

|

데이터 마이닝 및 분석 |

✓ |

|

✓ |

과학 시뮬레이션 |

✓ |

|

|

번역 |

✓ |

|

|

색인 생성 |

✓ |

|

|

콘텐츠 조정 |

✓ |

|

|

예측형 유지관리 |

✓ |

|

✓ |

가상 어시스턴트 |

✓ |

✓ |

|

챗봇 |

✓ |

✓ |

|

전문 에이전트 |

✓ |

✓ |

|

동영상 자막 제작 |

✓ |

✓ |

|

사기 탐지 |

|

✓ |

✓ |

의사 결정 |

|

✓ |

✓ |

동적 가격 설정 |

|

✓ |

✓ |

오디오 및 동영상 필터링 |

|

✓ |

✓ |

금융 거래 |

|

|

✓ |

통신 및 네트워킹 |

|

|

✓ |

자율 시스템 |

|

|

✓ |

워크로드 요구 사항에 따라 코어 수 CPU만 사용하거나 CPU와 GPU를 함께 사용하면 추론을 더욱 효과적으로 수행할 수 있습니다. 모델 크기 및 지연율 요구에 맞는 인프라에 대해 자세히 알아보세요.

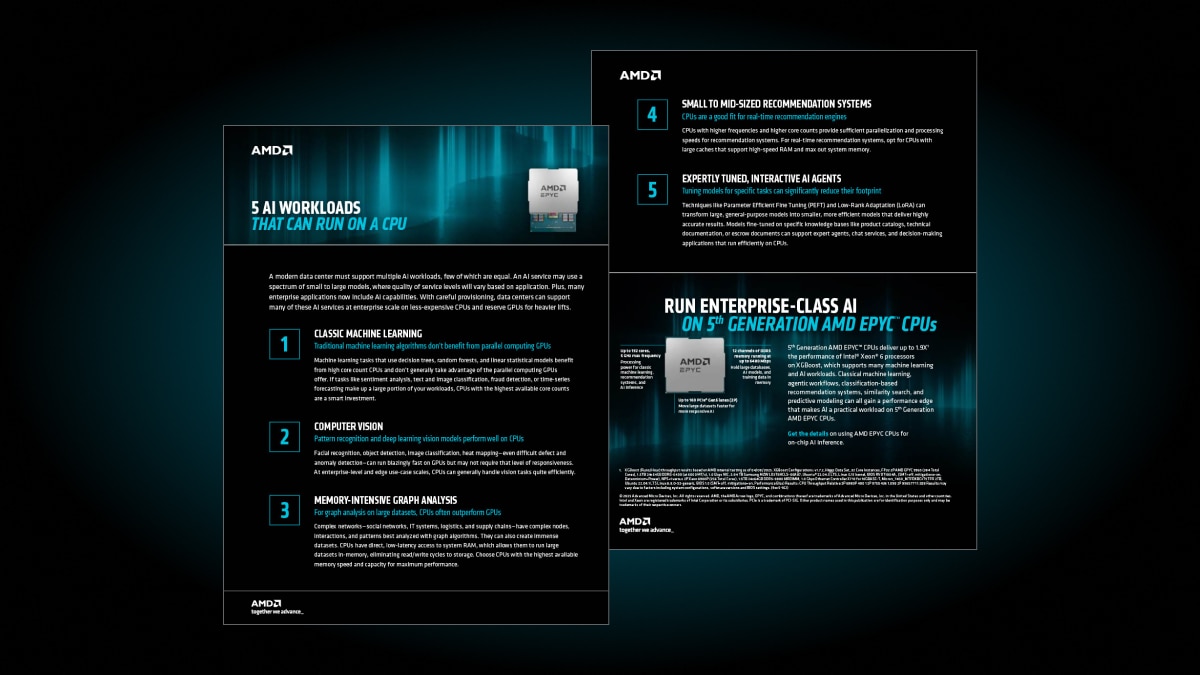

최신 AMD EPYC 서버 CPU는 기존 머신 러닝, 컴퓨터 비전, AI 에이전트 등 다양한 AI 워크로드의 성능 요구 사항을 충족할 수 있습니다. CPU에서 원활하게 처리할 수 있는 다섯 가지 인기 있는 워크로드에 대해 알아보세요.

AMD EPYC 서버 CPU는 CPU 전용 서버로만 배포하든 대형 모델을 실행하는 GPU의 호스트로 사용하든 엔터프라이즈 AI 추론 워크로드를 가속화하는 최신 개방형 표준 기술로 설계되었습니다.

5세대 AMD EPYC 9965 서버 CPU와 인텔 제온 6980P를 비교합니다.

5세대 AMD EPYC 9965

인텔 제온 6980P

5세대 AMD EPYC 9965

인텔 제온 6980P

5세대 AMD EPYC 9965

인텔 제온 6980P

5세대 AMD EPYC 9965

인텔 제온 6980P

5세대 AMD EPYC 9965

인텔 제온 6980P

먼저 성능 요구 사항을 확인하세요. 분, 초, 밀리초 단위 중 어느 정도의 응답 속도가 필요한가요? 실행 중인 모델의 크기는 매개변수 기준으로 어느 정도인가요? 5세대 AMD EPYC CPU로 업그레이드하면 성능 요구 사항을 충족하고 GPU 하드웨어 비용을 절감할 수 있습니다.

실시간으로 응답이 필요하지 않은 경우 일괄 추론은 캠페인 성과 분석 또는 예측 유지 관리와 같은 대규모 및 장기 분석에 비용 효율적입니다. 금융 거래 및 자율 시스템과 같은 대화형 사용 사례를 지원하는 실시간 추론에는 GPU 가속기가 필요할 수 있습니다. CPU만 사용하면 배치 추론에서만 높은 성능을 발휘하지만 GPU는 실시간 추론에 최적화되어 있습니다.

CPU만으로도 최대 20억 개의 매개변수 모델과 중간 지연율 응답 시간(초~분)으로 추론할 수 있는 충분한 성능이 제공됩니다. 이는 많은 AI 어시스턴트, 챗봇, 에이전트에 충분합니다. 모델이 크거나 응답 시간이 이보다 빨라야 하는 경우 GPU 가속기를 추가하는 것이 좋습니다.

간단하게 말하자면 상황에 따라 다릅니다. 워크로드의 최대 성능을 이끌어낼 수 있는지 여부는 워크로드와 전문 지식에 따라 다릅니다. 이러한 점을 고려하면 일부 5세대 AMD EPYC 서버 CPU는 대규모 언어 모델(DeepSeek-R1 671B)3, 중규모 언어 모델(Lama 3.1 8B4, GPT-J 6B6), 소규모 언어 모델(Llama 3.2 1B5)을 비롯한 여러 인기 AI 워크로드에서 인텔 제온 6를 능가합니다.

AMD EPYC 서버 CPU에는 실리콘에 기반한 보안 기능을 제공하는 AMD Infinity Guard가 포함되어 있습니다.7 AMD Infinity Guard에는 널리 도입된 컨피덴셜 컴퓨팅 솔루션인 AMD 보안 암호 가상화(SEV)가 포함되어 있으며, 여기에는 데이터, AI 모델과 런타임 시 워크로드를 보호하는 데 도움이 되는 컨피덴셜 가상 머신(VM)이 사용됩니다.

AI 목표와 부합하도록 인프라 요구 사항을 설정하세요. AMD는 가장 광범위한 AI 포트폴리오, 개방형 표준 기반 플랫폼, 강력한 생태계를 갖추고 있으며, 이 모든 것이 성능 리더십에 기초하고 있습니다.

개발자는 AMD ZenDNN 및 AMD ROCm™ 소프트웨어를 통해 원하는 프레임워크를 사용하여 애플리케이션 성능을 최적화할 수 있습니다.