完整堆疊企業級 AI

AMD Enterprise AI Suite 將關鍵的開放原始碼 AI 架構和生成式 AI 模型,與企業級 Kubernetes 平台連接,讓企業在數分鐘內就能從裸機運算進展到生產級 AI 部署,將從 AI 實驗到在 AMD 運算平台上大規模實際運用的時間降到最低。

加速從試驗到投產期間的企業 AI

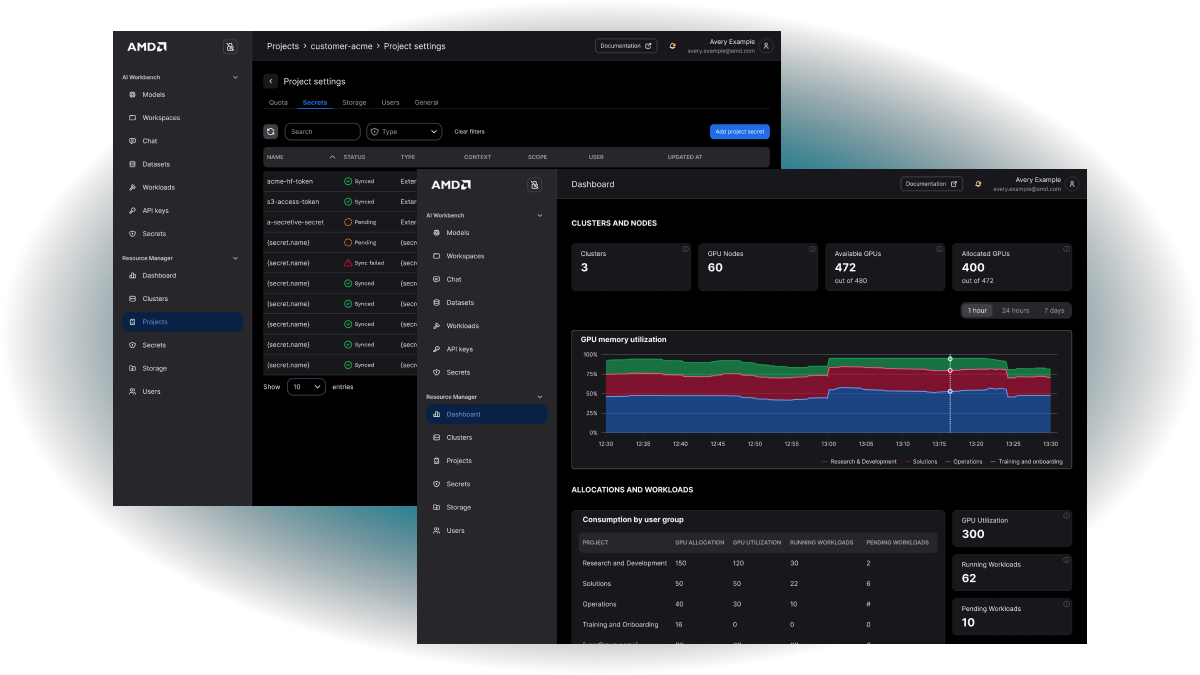

最佳化的運算使用率

採用 AMD Enterprise AI Suite 後,AI 運算資源便可在使用者群組、專案和使用案例之間進行高效率的分配。

更快的價值實現速度

從裸機或雲端到實際執行工作負載,成為幾分鐘的事情。

高效率 AI 作業

將基礎架構自動化,專注在 AI 真正的價值。

無與倫比的 TCO

符合成本效益的高效能硬體搭配經過精簡和最佳化的軟體。

開源模組化架構

完全開源的平台可確保您避免受限於單一廠商,並從全球 AI 社群中獲得最大效益。

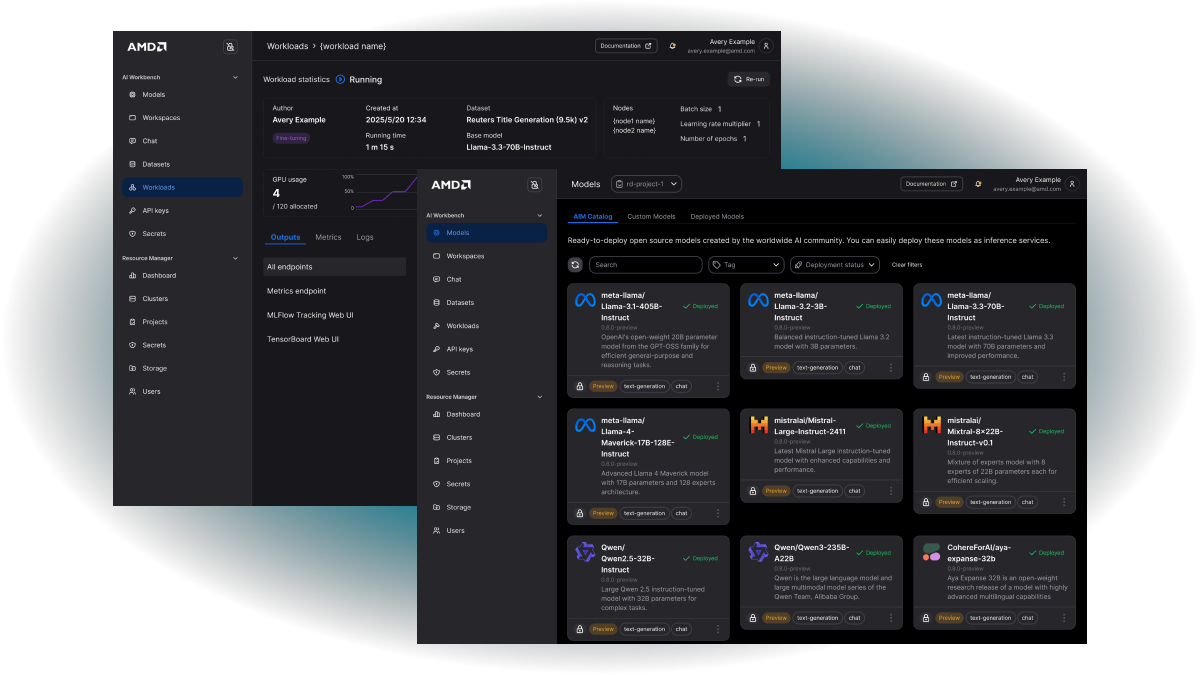

大規模部署、管理和加速 AI 工作負載

專為採用 AMD 資料中心技術的企業規模所打造,直覺式的介面可讓組織快速開始進行 AI 開發,並且在整個組織中高效率地利用運算資源。

AMD Inference Microservices

為 AMD 硬體統合模型、引擎和最佳化組態的預先建置推論容器。支援 OpenAI 相容 API 和開放權重模型,實現無須重新設計的快速部署。硬體感知調整可最佳化精度、Tensor 平行處理和輸送量,以提供最佳效能。

大規模推論

智慧型推論路由與排程、模型快取處理,以及根據實際使用率的即時自動規模調整,再加上產業標準 API。

最佳化的 AIM 容器與作業系統執行時間

針對 AMD 硬體選項及具體使用案例專屬 KPI 最佳化的模型設定檔。

企業級安全性與控管

透過即時監測儀表板的可檢視性與模型管理,以及模型與金鑰的生命週期管理。

資源