フル スタックのエンタープライズ対応 AI

AMD エンタープライズ AI スイートは、主要なオープンソース AI フレームワークと生成 AI モデルをエンタープライズ対応の Kubernetes プラットフォームに接続することで、ベアメタル コンピューティングから本番運用レベルの AI に数分で移行できるようにします。これにより、AI の実験から AMD 演算プラットフォームでの大規模な本番運用までの時間を最小限に抑えることができます。

エンタープライズ AI をパイロットから本番運用へ加速

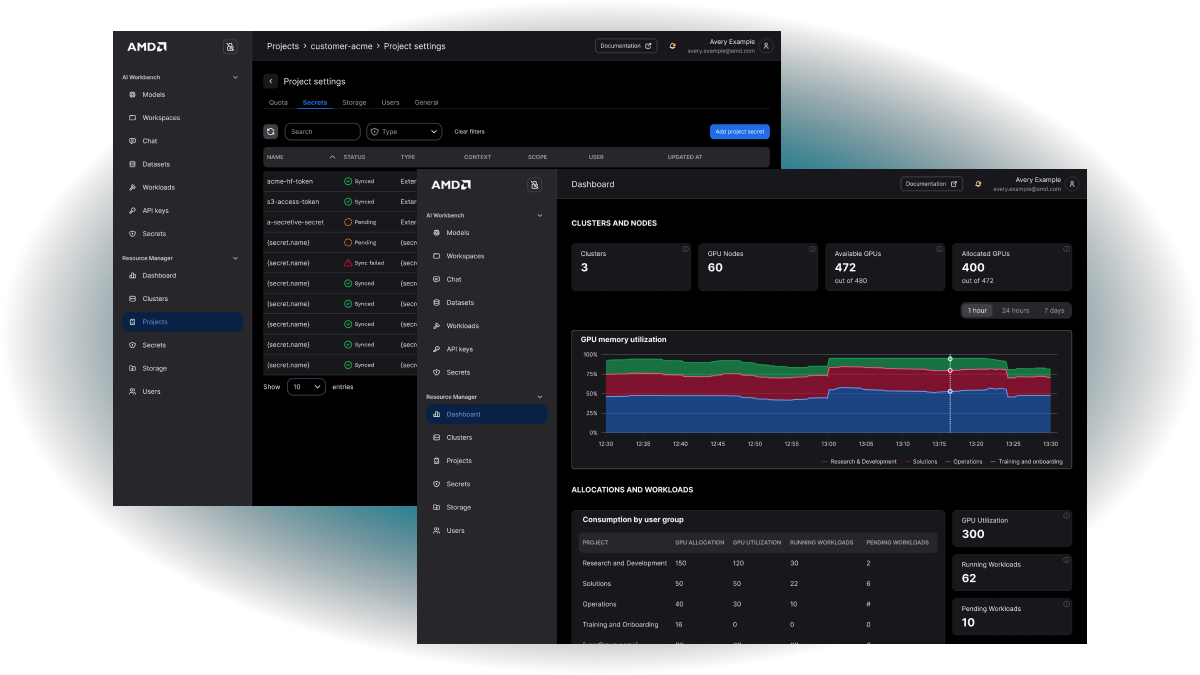

演算使用率を最適化

AMD エンタープライズ AI スイートでは、AI コンピューティングをユーザー グループ、プロジェクト、ユース ケースの垣根を超えて効率的に活用できます。

タイムトゥバリュー (導入から価値実現までの時間) を短縮

ベアメタルやクラウドから本番運用ワークロードの実行まで、わずか数分です。

効率的な AI 運用

インフラストラクチャを自動化することで、AI 本来の価値に注力できます。

比類なき TCO

コスト効率に優れた高性能ハードウェアと、合理化と最適化の行き届いたソフトウェアが融合しています。

オープンソースのモジュラー アーキテクチャ

完全オープンソースのプラットフォームにより、ベンダー ロックインを回避し、グローバルな AI コミュニティの恩恵を最大限に受けられます。

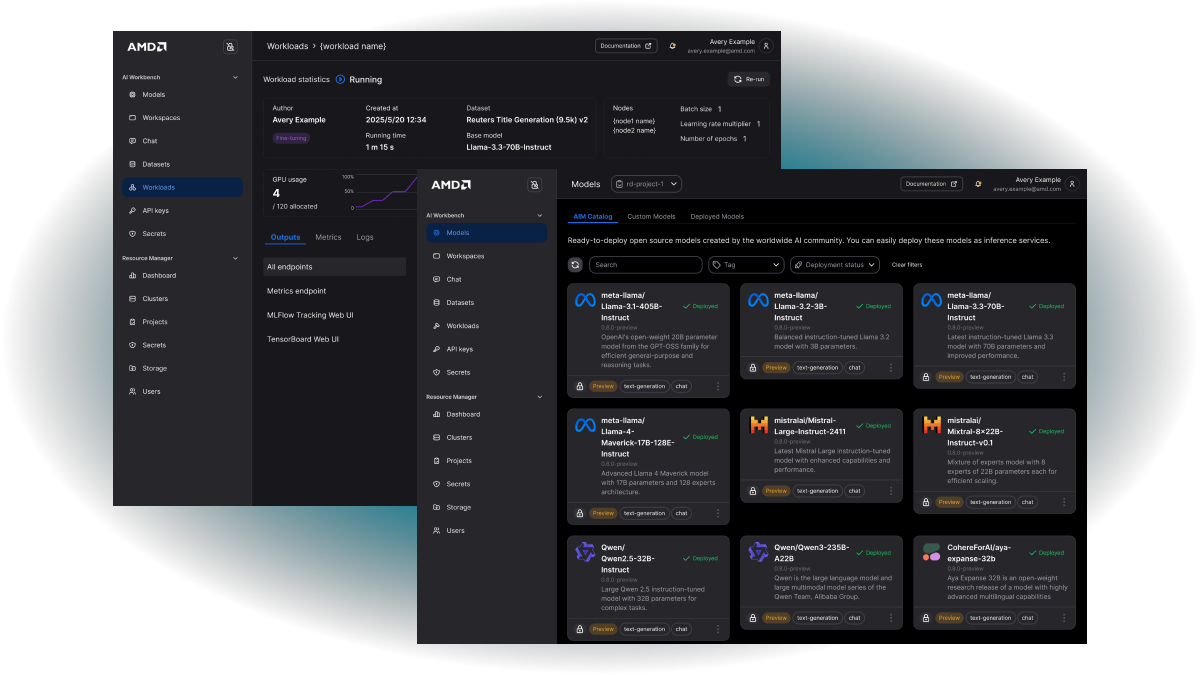

AI ワークロードの大規模な導入、管理、高速化

AMD データセンター テクノロジを基盤にエンタープライズ規模向けに構築されており、直感的なインターフェイスを使用して、AI 開発を迅速にスタートさせ、コンピューティング リソースを組織全体で効率的に活用できます。

AMD Inference Microservices

モデルとエンジン、そして AMD ハードウェアに最適化された構成をバンドルした、構築済み推論コンテナーです。OpenAI 互換の API とオープン ウェイト モデルをサポートしており、再エンジニアリングなしで迅速に導入できます。ハードウェアを意識したチューニングにより、精度、テンソル並列、スループットが最適化され、最大限のパフォーマンスが引き出されます。

大規模な推論

推論のインテリジェントなルーティングとスケジューリング、モデル キャッシング、実使用率に基づくリアルタイムの自動スケーリングを、業界標準の API と組み合わせています。

AIM コンテナーと OS 実行時間を最適化

AMD のハードウェア オプションとユース ケース固有の KPI に合わせて、モデルのプロファイルを最適化します。

エンタープライズ対応のセキュリティとガバナンス

リアルタイムのモニター ダッシュボードと、モデルやキーのライフサイクル管理を通じて、可観測性とモデル管理を実現します。

AIM の導入と管理

AIM 環境を導入、操作、モニターするための直感的なインターフェイスです。

開発者ワークスペース

ノート PC、一般的な IDE、または柔軟な SSH レベルのアクセスに基づく仮想化開発環境です。

コミュニティ開発者ツール

実験トラッキングやパイプライン処理からベンチマークやプロファイリングまで、開発者が利用できる一般的な AI 開発ツールが揃っています。

インテリジェントなリソース スケジューリング

事前に定義されたポリシーや優先順位に基づき、インテリジェントなワークロード スケジューリングでリソースを柔軟に割り当て、GPU のアイドル時間を削減します。

ジョブ キュー管理

スマートなクォータ割り当てとダイナミック スケーリングにより、チーム間やワークロード間で演算が適正に配分されます。

メトリクスと分析

ユーザー グループやワークロード全体の演算使用率を追跡およびモニターします。リソースの割り当てを、実環境からのフィードバックに基づき最適化します。

リソース