Performance-Übersichten und technische Dokumente

Finden Sie technische Ressourcen, um Ihre Infrastruktur mit AMD EPYC 9005 Server-CPUs aufzubauen.

KI-, Cloud- und Unternehmens-Computing weiterentwickeln

AMD EPYC™ 9005 Server-CPUs bieten durchgängige KI-Performance.

AMD EPYC™ 9005 CPUs können die Integer Performance alter Hardware mit bis zu 88 % weniger Racks2 abdecken. So wird der physische Platzbedarf, der Stromverbrauch und die Anzahl der erforderlichen Softwarelizenzen enorm reduziert und Platz geschaffen für neue oder erweiterte KI-Auslastungen.

Viele KI-Auslastungen, LLMs mit 13 Milliarden Parametern und darunter, Bild- und Betrugsanalysen oder Empfehlungssysteme werden effizient auf reinen CPU-Servern mit AMD EPYC™ 9005 CPUs ausgeführt. Server, die mit zwei AMD EPYC 9965 CPUs der 5. Generation ausgestattet sind, bieten einen bis zu 2-fachen Inferenzdurchsatz im Vergleich zu Angeboten der vorherigen Generation.3

Die AMD EPYC™ 9005 Familie beinhaltet Optionen, die für Host-CPUs für GPU-fähige Systeme optimiert sind, um die Performance auf ausgewählten KI-Auslastungen zu erhöhen und den ROI für jeden GPU-Server zu verbessern. In Inferenz-Performancetests zum geometrischen Mittel für 8 Modelle und 4 Anwendungsfälle bietet beispielsweise ein Hochfrequenz-Server mit AMD EPYC 9575F CPU und 8 GPUs eine bis zu 13 % kürzere Zeit bis zum ersten Token und einen um 6,6 % höheren Gesamt-Inferenzdurchsatz als ein gleichwertiger Server mit 8 GPUs und Intel Xeon 6960P CPUs.4,5,6

Erfahren Sie, wie AMD EPYC Prozessoren der 5. Generation dazu beitragen, die Effizienz und Performance von KI im gesamten Rechenzentrum zu steigern. Von der Schaffung von Platz und Energie in Ihrem Rechenzentrum über Inferenz direkt auf der CPU bis hin zur Verbesserung der Performance auf GPUs – AMD EPYC Prozessoren ermöglichen neue Dimensionen für KI im Unternehmen.

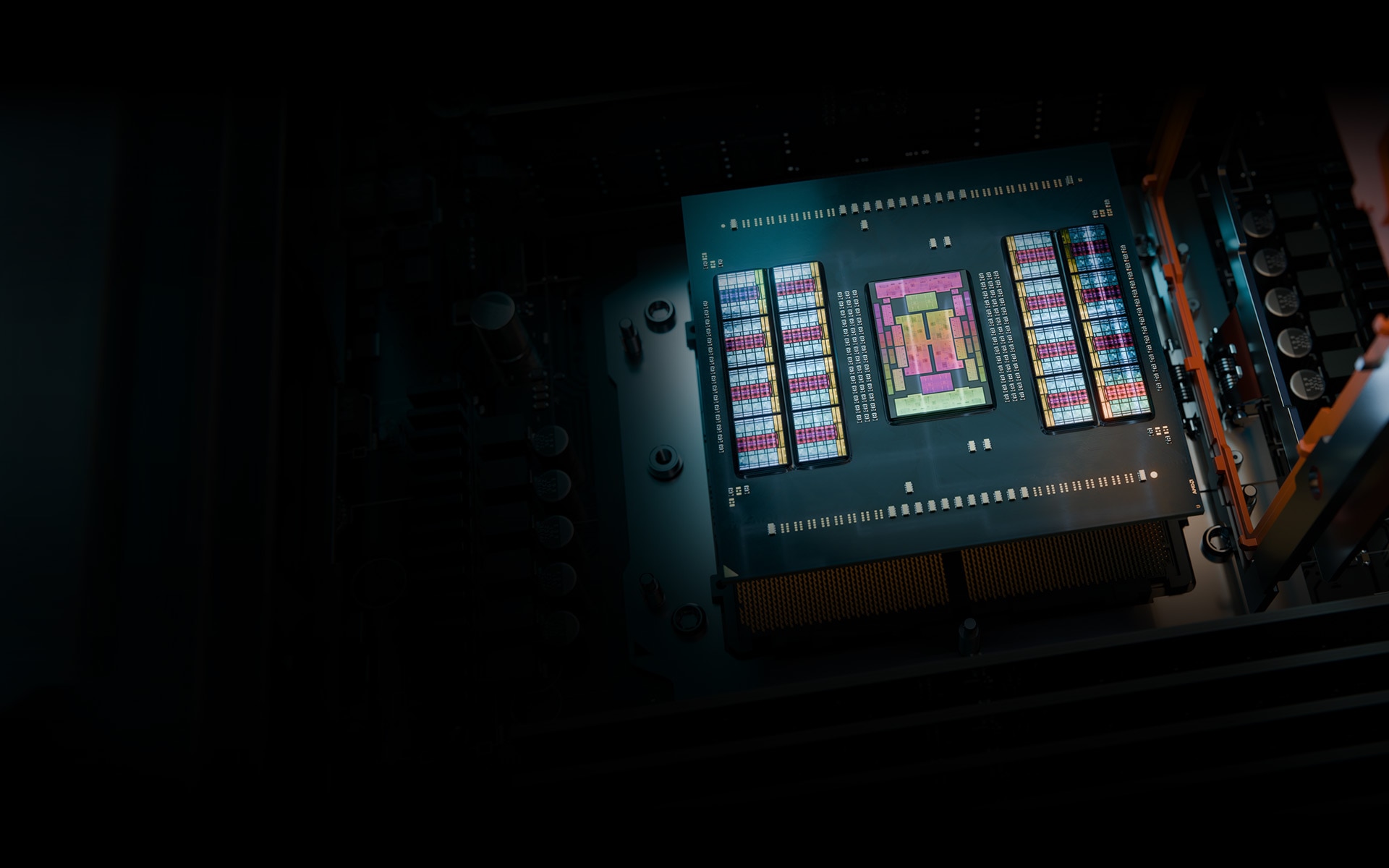

AMD EPYC 9005 Server-CPUs liefern herausragende Performance und bieten dabei führende Energieeffizienz und niedrige Gesamtbetriebskosten zur Unterstützung wichtiger Unternehmensziele.

Server mit AMD EPYC 9005 CPU nutzen die neuen „Zen 5“ Kerne, um überzeugende Mainstream-Performance-Metriken zu bieten, einschließlich einer 2,3-fachen Integer Performance im Vergleich zu führenden Angeboten der Konkurrenz.5

AMD EPYC™ 9005 Server-CPUs bieten Dichte und Performance für Cloud-Auslastungen. Mit 192 Kernen unterstützt der AMD EPYC 9965 Top-of-Stack-Prozessor 33 % mehr virtuelle CPUs (vCPUs) als der führende Intel® Xeon 6E „Sierra Forest“ Prozessor mit 144 Kernen (1 Kern pro vCPU).

Rechenzentren erfordern mehr Strom als je zuvor. AMD EPYC™ 9005 Server-CPUs bieten auch weiterhin die Vorteile der vorherigen AMD EPYC Generationen in Sachen Energieeffizienz und Gesamtbetriebskosten.

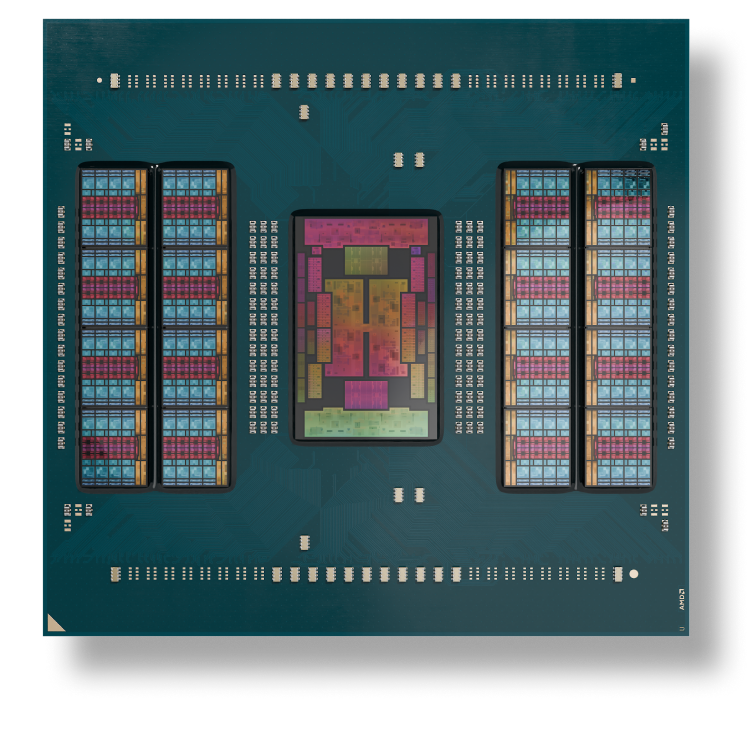

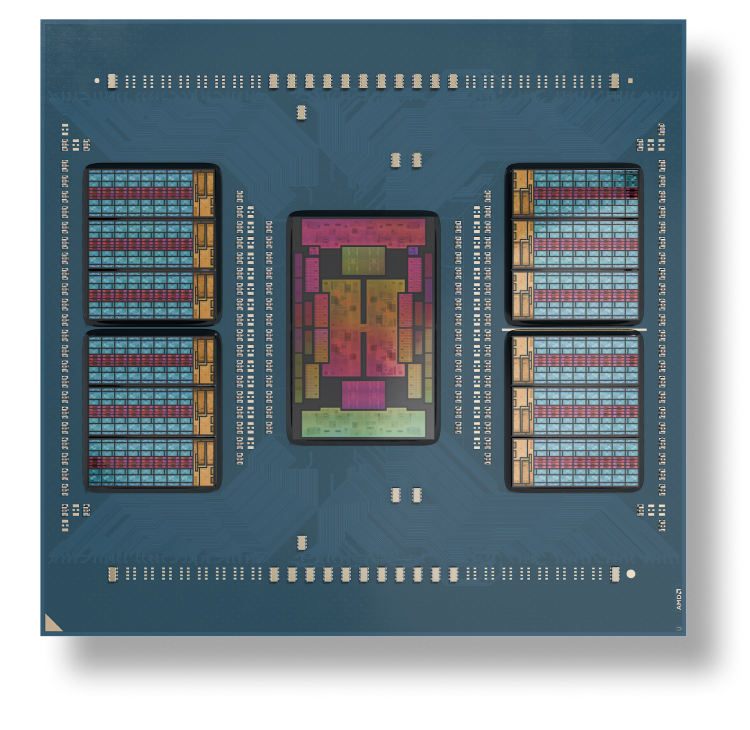

AMD EPYC 9005-Serie Server-CPUs enthalten bis zu 192 „Zen 5“ oder „Zen 5c“ Kerne mit einzigartiger Speicherbandbreite und -kapazität. Die innovative AMD-Chiplet-Architektur ermöglicht energieeffiziente High-Performance-Lösungen, die für die unterschiedlichsten Computing-Anforderungen optimiert sind.