— ハイパフォーマンス コンピューティングと生成 AI 向けのAMDハードウェアを Dell Technologies、Hewlett Packard Enterprise、Lenovo、Meta、Microsoft、Oracle、Supermicro などが紹介—

—ROCm 6 オープン ソフトウェア エコシステムは、次世代ハードウェアとソフトウェアを組み合わせることで約 8 倍の性能向上を実現し、生成 AI の進化を促進し、シンプルな AMD AI ソリューションの導入を実現—

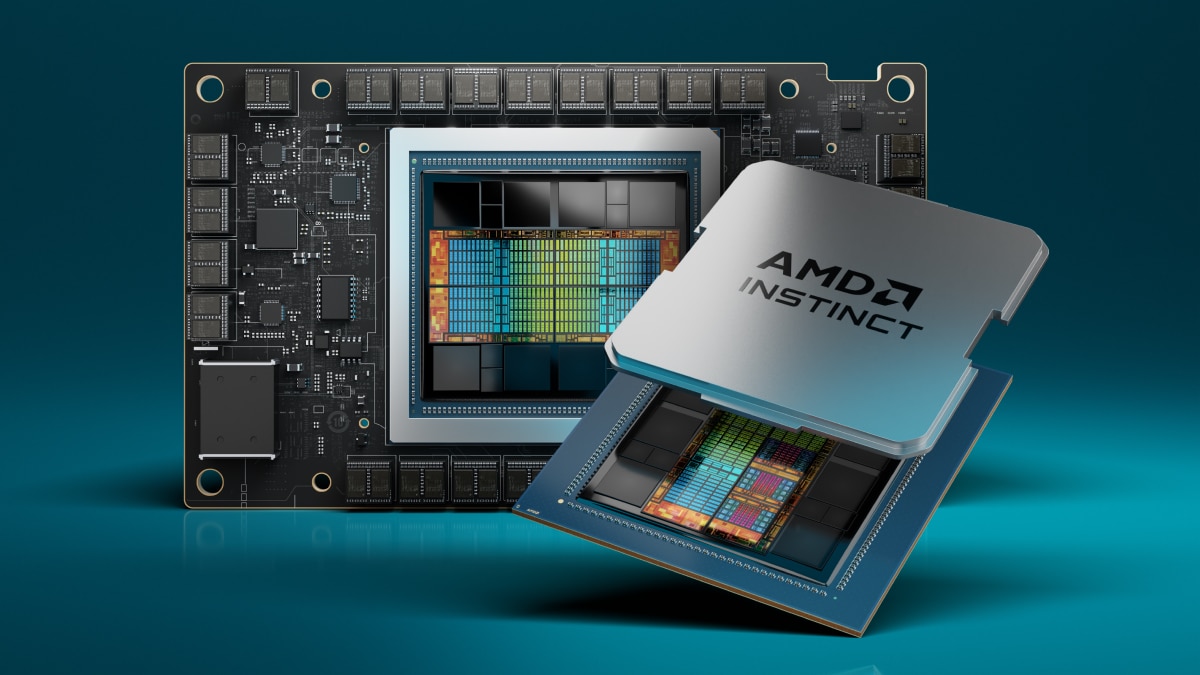

2023 年 12 月 6 日、カリフォルニア州サンタクララ発— AMD (NASDAQ: AMD) は、生成 AI 向けに業界をリードするメモリー帯域幅と業界トップクラスのパフォーマンスを備える大規模言語モデル (LLM) トレーニングおよび推論向けの「AMD Instinct™ MI300X」アクセラレータと、最新の AMD CDNA™ 3 アーキテクチャと「Zen 4」CPU を組み合わせ、HPC およびAIワークロード向けに画期的なパフォーマンスを提供する「AMD Instinct™ MI300A」アクセラレーテッド プロセッシング ユニット (APU) の提供を発表しました。

AMD プレジデントの Victor Peng は次の通り述べています。「AMD Instinct MI300 シリーズ アクセラレータは、当社の最先端技術で設計され、トップクラスのパフォーマンスを提供し、大規模なクラウドおよびエンタープライズに展開がおこなわれます。AMD のハードウェア、ソフトウェア、オープン エコシステムのアプローチを活用することで、クラウドプロバイダー、OEM および ODM は、企業が AI を活用したソリューションを採用し、展開できるようにするテクノロジを市場に提供しています」

最新の AMD Instinct アクセラレータのポートフォリオを活用しているお客様の中には Microsoft も含まれており、最近、AI ワークロード向けに最適化され、AMD Instinct MI300X アクセラレータを搭載した新しい Azure ND MI300x v5 Virtual Machine (VM) シリーズを発表しました。さらに、AMD Instinct MI300A APU を搭載し、ローレンス リバモア国立研究所 (Lawrence Livermore National Laboratory) に設置されているスーパーコンピューター「El Capitan」は、AMD を搭載する2番目のエクサスケール級スーパーコンピューターとなる見込みで、フル稼働されれば、2 エクサフロップス以上の倍精度性能を実現することを期待しています。Oracle Cloud Infrastructure は、AMD Instinct MI300X をベースとしたベアメタル インスタンスを、同社の AI 向け高性能アクセラレーテッド コンピューティング インスタンスに追加し、MI300X ベースのインスタンスは、超高速 RDMA ネットワーキングを備えた OCI Supercluster をサポートする計画です。

また、AMD Advancing AI イベントに合わせて、複数の大手 OEM が各社のアクセラレーテッド コンピューティング システムを披露しました。Dell は、AMD Instinct MI300 シリーズ アクセラレータを 8 基搭載した Dell PowerEdge XE9680 サーバーと、AMD ROCm を搭載した AI フレームワークを備えた新しい Dell Validated Design for Generative AI を公開しました。HPE は最近、AMD Instinct MI300A APU を搭載した初のスーパーコンピューティング アクセラレータ ブレードである HPE Cray Supercomputing EX255a を発表しました。Lenovo は、新しい AMD Instinct MI300 シリーズ アクセラレータのデザインのサポートを発表し、2024 年前半に提供開始を予定しています。Supermicro は、第 4 世代 AMD EPYC™ CPU と AMD Instinct MI300 シリーズ アクセラレータを搭載した H13 世代のアクセラレーテッド サーバーに新たな製品を追加すると発表しました。

AMD Instinct MI300X

AMD Instinct MI300X アクセラレータは、新しい AMD CDNA 3 アーキテクチャを搭載しています。前世代の AMD Instinct MI250X アクセラレータと比較すると、MI300X はコンピュート ユニットが約40%増加し、メモリー容量が 1.5 倍、理論ピークメモリー帯域幅が 1.7 倍になり、さらに生成 AI や HPC ワークロードに適した FP8 データセットやスパース性などをサポートします。

今日の LLM はサイズと複雑さが増し続け、大量のメモリーとコンピューティングを必要とします。AMD Instinct MI300X アクセラレータは、クラス最高の 192GB の HBM3 メモリー容量と 5.3TB/秒のピークメモリー帯域幅を備え、ますます要求が厳しくなる AI ワークロードに必要なパフォーマンスを提供します。AMD Instinct Platform は、業界をリードする 1.5TB の HBM3 メモリー容量を提供する 8 基の MI300X アクセラレータを搭載し、業界標準な OCP デザインに基づいて構築されたリーダーシップ ジェネレーティブ AI プラットフォームです。AMD Instinct Platform の業界標準設計により、OEM パートナーは、既存の AI 製品に MI300X アクセラレータの対応を可能にし、AMD Instinct アクセラレータをベースとしたサーバーの導入、普及を加速することができます。

AMD Instinct Platform は、NVIDIA HGX H100 と比較して、BLOOM 176B のような LLM で推論を実行する場合、最大 1.6 倍のスループットを提供することができ、Llama2 のような 70B パラメータモデルの推論を 1 台の MI300X アクセラレータで実行できる市場で唯一のオプションであり、エンタープライズクラスの LLM 導入を簡素化し、優れた TCO を実現します。

AMD Instinct MI300A

世界初の HPC および AI 向けデータセンター APU である AMD Instinct MI300A APU は、3D パッケージングと第 4 世代 AMD Infinityアーキテクチャを活用し、HPC と AI のコンバージェンスに位置する重要なワークロードでリーダーシップを発揮するパフォーマンスを実現します。MI300A APU は、高性能な AMD CDNA™ 3 GPU コア、最新の AMD「Zen 4」x86 ベース CPU コア、128GB の次世代 HBM3 メモリーを組み合わせ、FP32 HPC および AI ワークロードにおいて、前世代の AMD Instinct MI250X と比較して、ワットあたり約 1.9 倍のパフォーマンスを実現します。

エネルギー効率は、HPC および AI コミュニティにとって最も重要ですが、これらのワークロードは極めてデータおよびリソースに依存しています。AMD Instinct MI300A APU は、CPU コアと GPU コアを1つのパッケージに統合することで、高効率なプラットフォームを実現すると同時に、最新の AI モデルのトレーニングを加速させる演算性能を提供します。AMD は、2020 年から 2025 年までの期間に、AI トレーニングおよび HPC 向けのサーバー プロセッサーおよびアクセラレータのエネルギー効率を 30 倍向上させることを目指す目標「30x25」を掲げ、革新的なエネルギー効率を高めていく目標日程を定めています。

AMD Instinct MI300A APU は、ユニファイドメモリーとキャッシュメモリーリソースを持ち、お客様が容易にプログラミング可能な GPU プラットフォームであり、高性能な計算能力、高速な AI トレーニング、そして最も要求の高い HPC および AI ワークロードを優れたエネルギー効率で行うことができます。

ROCm ソフトウェアとエコシステムにおけるパートナー

AMD は、最新の AMD ROCm™ 6 オープン ソフトウェア プラットフォームと、オープンソースコミュニティへの最先端ライブラリの貢献へのコミットメントを発表し、オープンソースな AI ソフトウェア開発という同社のビジョンをさらに推進します。ROCm 6 ソフトウェアは、AMD ソフトウェア ツールの著しい進歩を示しており、Llama 2 テキスト世代で MI300 シリーズ アクセラレータ上で実行した場合、AI アクセラレーション性能が前世代のハードウェアおよびソフトウェアと比較して約 8 倍向上します。さらに、ROCm 6 は、FlashAttention、HIPGraph、vLLM など、ジェネレーティブ AI のためのいくつかの新しい主要機能をサポートしています。このように、AMD は、Hugging Face、PyTorch、TensorFlow など、最も広く使用されているオープンソースの AI ソフトウェア モデル、アルゴリズム、フレームワークを活用することで、イノベーションを促進し、AMD AI ソリューションの展開を簡素化し、ジェネレーティブ AI の真の可能性を引き出すことができる独自の立場にあります。

AMD はさらに、Nod.AI と Mipsology の買収や、企業顧客向けに LLM を実行する Lamini、AMD インスティンクト アクセラレータ上でコード変更ゼロのまま LLM のトレーニングを可能にする AMD ROCm を活用するMosaicML などの戦略的エコシステム パートナーシップを通じて、ソフトウェア機能への投資を続けています。

製品仕様

AMD Instinct™ |

Architecture |

GPU CUs |

CPU Cores |

Memory |

Memory Bandwidth |

Process Node |

3D Packaging w/ 4th Gen AMD Infinity Architecture |

MI300A |

AMD CDNA™ 3 |

228 |

24 “Zen 4” |

128GB HBM3 |

5.3 TB/s |

5nm / 6nm |

搭載あり |

MI300X |

AMD CDNA™ 3 |

304 |

N/A |

192GB HBM3 |

5.3 TB/s |

5nm / 6nm |

搭載あり |

Platform |

AMD CDNA™ 3 |

2,432 |

N/A |

1.5 TB HMB3 |

5.3 TB/s per OAM |

5nm / 6nm |

搭載あり |

参考情報

- AMD Advancing AI の基調講演の詳細

- AMD Instinct アクセラレータの詳細

- Facebook で AMD をフォロー

- X で AMD をフォロー

- 本プレスリリースは、2023 年 12 月 6 日(現地時間)に米国本社で発表されたプレスリリースの抄訳版です。リリース全文は原文(英語)をご参照ください。

AMD について

AMD は、ハイパフォーマンス コンピューティング、グラフィックスと視覚化技術において 50 年以上にわたり革新をもたらしてきました。世界中の何十億人もの消費者、フォーチュン 500 企業、最先端の科学研究機関が、日常の生活、仕事、遊びを向上させるために、AMD のテクノロジを支持しています。AMD 社員は、可能性の限界を押し上げる高性能で適応性の高い製品開発に注力しています。日本 AMD 株式会社は、 AMD の日本法人です。AMD のさらなる詳細は、AMD のウェブサイト、Facebook または X をご覧ください。

メディア ライブラリー

最新の AMD の企業ロゴや製品ロゴ、画像、B ロール映像をダウンロードできます。