新たな業界標準を打ち立てる

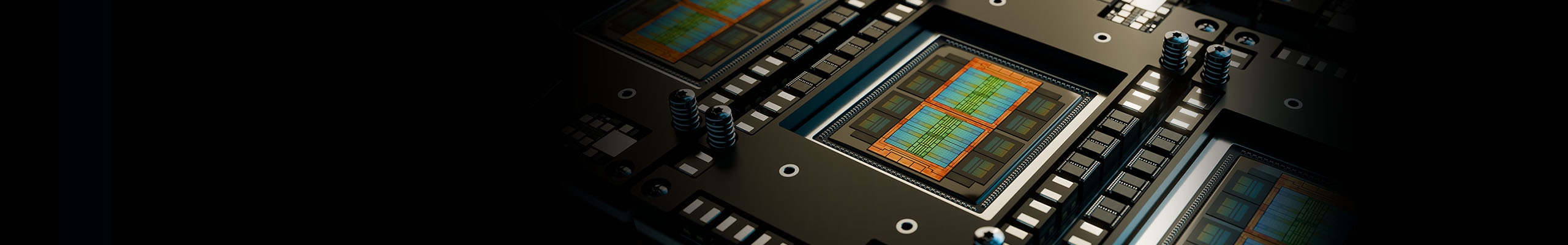

AMD Instinct™ アクセラレータは、登場以来、データセンターのお客様や、AI の可能性を積極的に活用しようとするユーザーに向けて、優れた性能、効率性、スケーラビリティを提供してきました。各世代が新たな標準を築き、業界をリードする仕様を実現し、パフォーマンスの最適化と TCO の削減に貢献してきたのです。1

そして今回、AMD は先日開催した Advancing AI イベントで発表した AMD Instinct™ MI350 シリーズ GPU により、再び期待の水準を引き上げようとしています。

AI に特化し、HPC に最適化された、業界をリードするパフォーマンス

AMD Instinct™ MI350X GPU および AMD Instinct™ MI355X GPU は、それぞれの新プラットフォームとともに提供が開始されました。お客様の要件に応じてご紹介いただけます。これらは最先端の第 4 世代 AMD CDNA™ アーキテクチャに基づいて設計されており、最大 288 GB の HBM3E メモリ容量と 8 TB/秒の帯域幅を備えています。大規模な AI モデルのトレーニングや高速な推論処理、さらには複雑な HPC ワークロードまでをカバーするよう設計された AMD Instinct MI350X GPU は、NVIDIA B200 プラットフォームと比べて最大 2.05 倍の FP6 性能2 を実現します。また、AMD Instinct MI355X GPU は GB200 に対して 2 倍の FP6 性能3 を誇り、演算密度、効率、スループットのあらゆる面で新たな基準を打ち立てます。

お客様の要求やインフラストラクチャへの需要が高まる中、AMD はそれらの要求のペースに対応できるようにアクセラレータを設計しています。この新しい空冷 GPU は、前世代の AMD Instinct™ MI300X および MI325X インフラストラクチャとシームレスに統合されるため、高密度コンピューティングが不可欠なほぼあらゆるシナリオにおいて、手間をかけずにコスト効率の高いアップグレードを実現します。

どちらの AMD Instinct GPU も、FP16 および FP8 の処理サポートを強化しつつ、FP6 および FP4 データ型にも新たに対応しています。これにより、電力効率を最大限に高めながら、演算スループットとメモリ帯域幅の活用を妥協なく実現します。さらに、AMD Instinct MI350 シリーズ GPU は、FP8 で動作する AMD Instinct MI300X GPU と比較して、FP4 実行時に最大 4 倍4 の性能を発揮します。これにより、生成 AI の高度なモデルにおいて驚異的なパフォーマンスを実現し、この分野の限界をさらに押し広げる存在となっています。

仕様 |

AMD Instinct™ MI350X GPU |

AMD Instinct™ MI350X プラットフォーム |

AMD Instinct™ MI355X GPU |

AMD Instinct™ MI355X プラットフォーム |

GPU |

AMD Instinct MI350X OAM |

8 x AMD Instinct MI350X OAM |

AMD Instinct MI355X OAM |

8 x AMD Instinct MI355X OAM |

GPU アーキテクチャ |

AMD CDNA™ 4 |

AMD CDNA™ 4 |

AMD CDNA™ 4 |

AMD CDNA™ 4 |

専用メモリ サイズ |

288 GB HBM3E |

2.3 TB HBM3E |

288 GB HBM3E |

2.3 TB HBM3E |

メモリ帯域幅 |

8 TB/秒 |

OAM あたり 8 TB/秒 |

8 TB/秒 |

OAM あたり 8 TB/秒 |

ピーク時半精度 (FP16) パフォーマンス* |

4.6 PFLOPS |

36.8 PFLOPS |

4.6 PFLOPS |

36.8 PFLOPS |

8 ビット精度 (FP8) ピーク性能 |

9.228 PFLOPS |

72 PFLOPS |

9.228 PFLOPS |

72 PFLOPS |

6 ビット精度 (FP6) ピーク性能* |

18.45 PFLOPS |

148 PFLOPS |

18.45 PFLOPS |

148 PFLOPS |

4 ビット精度 (FP4) ピーク性能* |

18.45 PFLOPS |

148 PFLOPS |

18.45 PFLOPS |

148 PFLOPS |

冷却 |

空冷 |

空冷 |

直接液冷 (DLC) |

直接液冷 (DLC) |

標準ボード電力 |

最大消費電力 1000 W |

OAM あたり最大消費電力 1000 W |

最大消費電力 1400 W |

OAM あたり最大消費電力 1400 W |

*構造的スパース性を利用した場合

次世代 AMD ROCm™ ソフトウェアとの統合

オープンソースによるイノベーションに対する AMD の継続的な取り組みに基づき、AMD Instinct MI350 シリーズ GPU は、AI および HPC ワークロード向けの業界屈指のオープンな選択肢である、次世代 AMD ROCm™ ソフトウェア スタックと統合されています。

これらの新しいアクセラレータの投入と同時に、最新の AMD ROCm ソフトウェアの強化も発表されており、AI ワークロードが次のレベルへと引き上げられ、AI 推論やトレーニング、フレームワーク互換性のさらなる最適化が実現しています。自然言語処理 (NLP) やコンピューター ビジョンなど、要求の厳しいワークロードにおいても、高スループットかつ低レイテンシな結果を提供します。

ROCm ソフトウェアは、OpenAI、Meta、PyTorch、Hugging Face、xAI、DeepSeek などの業界をリードする企業が提供する AI プラットフォームやモデルに対し、Day-0 サポートを実現しています。これは、戦略的かつ深いパートナーシップに基づく連携の成果です。こうした取り組みにより、AMD Instinct GPU は最新の AI モデルやフレームワークに対応した最適な実行環境を提供し、リリース直後から活用可能です。これにより、開発者も企業も AI の業務統合を加速できます。

Microsoft や Meta のような業界のリーダー企業が、Llama 405B や GPT などの大規模 AI モデルの運用基盤として AMD Instinct GPU を採用しているのには、確かな理由があります。詳しくは、お近くの AMD 担当者までお問い合わせいただくか、AMD.com をご覧ください。AMD Instinct アクセラレータのパワーを活用し、お客様の AI 導入をサポートしましょう。

AMD アリーナ

AMD Ryzen™ PRO、AMD EPYC™、AMD Instinct™ などに関するトレーニングで、AMD 製品の知識を深めることができます。

登録

AMD の最新製品、トレーニング リソース、"エキスパートに訊く" ウェビナーに関する情報を毎月お届けします。

関連記事

脚注

- MI325-001A - 計算は、2024 年 9 月 26 日時点での仕様および/または推定に基づいて AMD パフォーマンス ラボにより実行されたものです。AMD Instinct™ MI325X OAM アクセラレータは、256 GB の HBM3E メモリ容量と 6 TB/秒の GPU ピーク理論メモリ帯域幅パフォーマンスを備えています。製品版の半導体によって、実際の結果は異なる場合があります。

NVidia Hopper H200 (141 GB) SXM GPU アクセラレータの公開結果で最高の値は次のようになっています。HBM3E メモリ容量は 141 GB、GPU メモリの帯域幅パフォーマンスは 4.8 TB/秒。 https://nvdam.widen.net/s/nb5zzzsjdf/hpc-datasheet-sc23-h200-datasheet-3002446

NVidia Blackwell HGX B100 (192 GB) 700 W GPU アクセラレータの公開結果で最高の値は次のようになっています。HBM3E メモリ容量は 192 GB、GPU メモリ帯域幅パフォーマンスは 8 TB/秒。

NVIDIA Blackwell HGX B200 (192 GB) GPU アクセラレータの公開結果で最高の値は次のようになっています。HBM3E メモリ容量は 192 GB、GPU メモリ帯域幅パフォーマンスは 8 TB/秒。

Nvidia Blackwell の仕様については、https://resources.nvidia.com/en-us-blackwell-architecture?_gl=1*1r4pme7*_gcl_aw*R0NMLjE3MTM5NjQ3NTAuQ2p3S0NBancyNkt4QmhCREVpd0F1NktYdDlweXY1dlUtaHNKNmhPdHM4UVdPSlM3dFdQaE40WkI4THZBaW をご覧ください。

- 2025 年 5 月に AMD パフォーマンス ラボで、8 基の AMD Instinct™ MI350X/MI355X GPU を搭載したプラットフォームにおける、FP64、FP32、TF32、FP16、FP8、FP6、FP4、INT8 の各データ型の理論上のピーク演算性能 (必要に応じてマトリックス、テンソル、ベクトル演算およびスパース性を適用) を算出し、NVIDIA の HGX Blackwell B200 アクセラレータ プラットフォームと比較しました。実際の結果は、システムの構成、データ型、ワークロードなどによって異なります。MI350-010

- 2025 年 5 月に AMD パフォーマンス ラボで、8 基の AMD Instinct™ MI355X GPU を搭載したプラットフォームにおける FP64、FP32、TF32、FP16、FP8、FP6、FP4、INT8 の各データ型の理論上のピーク演算性能 (必要に応じてマトリックス、テンソル、ベクトル演算およびスパース性を適用) を算出し、NVIDIA Grace Blackwell GB200 NVL72 (8 GPU プラットフォーム) と比較しました。サーバー メーカーの構成によって、異なる結果が生じる場合があります。実際の結果は、最新のドライバーおよび最適化の使用状況によって異なる場合があります。MI350-018

- 2025 年 5 月に AMD パフォーマンス ラボで実施した計算に基づき、AMD Instinct™ MI355X および MI350X GPU (プラットフォーム) 8 個、および AMD Instinct MI325X、MI300X、MI250X、MI100 GPU (プラットフォーム) 8 個を使用し、Matrix を用いて FP16、FP8、FP6、FP4 データ型で計算した場合の理論上のピーク精度性能を算出しました。サーバー メーカーの構成によって、異なる結果が生じる場合があります。最新のドライバーや最適化の使用状況によっても結果は異なる場合があります。MI350-004

- MI325-001A - 計算は、2024 年 9 月 26 日時点での仕様および/または推定に基づいて AMD パフォーマンス ラボにより実行されたものです。AMD Instinct™ MI325X OAM アクセラレータは、256 GB の HBM3E メモリ容量と 6 TB/秒の GPU ピーク理論メモリ帯域幅パフォーマンスを備えています。製品版の半導体によって、実際の結果は異なる場合があります。

NVidia Hopper H200 (141 GB) SXM GPU アクセラレータの公開結果で最高の値は次のようになっています。HBM3E メモリ容量は 141 GB、GPU メモリの帯域幅パフォーマンスは 4.8 TB/秒。 https://nvdam.widen.net/s/nb5zzzsjdf/hpc-datasheet-sc23-h200-datasheet-3002446

NVidia Blackwell HGX B100 (192 GB) 700 W GPU アクセラレータの公開結果で最高の値は次のようになっています。HBM3E メモリ容量は 192 GB、GPU メモリ帯域幅パフォーマンスは 8 TB/秒。

NVIDIA Blackwell HGX B200 (192 GB) GPU アクセラレータの公開結果で最高の値は次のようになっています。HBM3E メモリ容量は 192 GB、GPU メモリ帯域幅パフォーマンスは 8 TB/秒。

Nvidia Blackwell の仕様については、https://resources.nvidia.com/en-us-blackwell-architecture?_gl=1*1r4pme7*_gcl_aw*R0NMLjE3MTM5NjQ3NTAuQ2p3S0NBancyNkt4QmhCREVpd0F1NktYdDlweXY1dlUtaHNKNmhPdHM4UVdPSlM3dFdQaE40WkI4THZBaW をご覧ください。 - 2025 年 5 月に AMD パフォーマンス ラボで、8 基の AMD Instinct™ MI350X/MI355X GPU を搭載したプラットフォームにおける、FP64、FP32、TF32、FP16、FP8、FP6、FP4、INT8 の各データ型の理論上のピーク演算性能 (必要に応じてマトリックス、テンソル、ベクトル演算およびスパース性を適用) を算出し、NVIDIA の HGX Blackwell B200 アクセラレータ プラットフォームと比較しました。実際の結果は、システムの構成、データ型、ワークロードなどによって異なります。MI350-010

- 2025 年 5 月に AMD パフォーマンス ラボで、8 基の AMD Instinct™ MI355X GPU を搭載したプラットフォームにおける FP64、FP32、TF32、FP16、FP8、FP6、FP4、INT8 の各データ型の理論上のピーク演算性能 (必要に応じてマトリックス、テンソル、ベクトル演算およびスパース性を適用) を算出し、NVIDIA Grace Blackwell GB200 NVL72 (8 GPU プラットフォーム) と比較しました。サーバー メーカーの構成によって、異なる結果が生じる場合があります。実際の結果は、最新のドライバーおよび最適化の使用状況によって異なる場合があります。MI350-018

- 2025 年 5 月に AMD パフォーマンス ラボで実施した計算に基づき、AMD Instinct™ MI355X および MI350X GPU (プラットフォーム) 8 個、および AMD Instinct MI325X、MI300X、MI250X、MI100 GPU (プラットフォーム) 8 個を使用し、Matrix を用いて FP16、FP8、FP6、FP4 データ型で計算した場合の理論上のピーク精度性能を算出しました。サーバー メーカーの構成によって、異なる結果が生じる場合があります。最新のドライバーや最適化の使用状況によっても結果は異なる場合があります。MI350-004